spark 作业一直卡在accepted

问题现象

通过yarn-cluster模式提交spark作业,客户端日志一直卡在submit app,没有运行

问题排查

1.查看yarn app日志

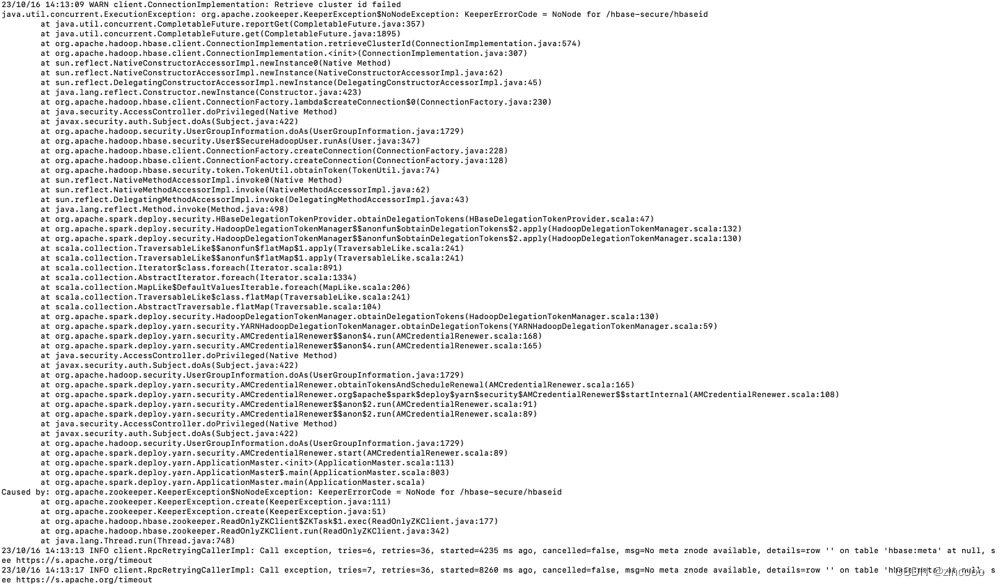

appid已生成,通过yarn查看app状态为等待am运行。具体查看am日志发现其一直在尝试访问hbase,尝试了36次后失败(集群hbase服务已正常停止)

问题:作业逻辑中不含hbase的相关内容,为什么会去访问hbase?

2.问题分析与原因

分析:

通过上面截图的堆栈信息查看从obtainDeletionTokens方法到HBaseDelegationTokenProvider的obtainDeletionTokens方法,说明这里是去尝试获取hbase的安全令牌。

(hbase的token获取的用户需要具有hbase:meta表的exec权限)

原因:

spark 官方文档

- 在官网的文档描述:kerberos环境中,spark app在认证的时候,可能会获取hdfs、hive、hbase等服务的安全令牌。

- 获取hbase的条件:hbase位于集群classpath,同时集群hbase开启了kerberos认证。

- 所以 我们想跳过这个过程,需要提交作业时传入spark.yarn.security.credentials.hbase.enabled=false

用户在YARN-cluster模式下提交Spark作业时遇到卡顿,原因在于作业试图获取HBase的安全令牌,尽管作业逻辑并未涉及HBase。Spark在Kerberos环境中会自动获取相关服务令牌,解决办法是提交作业时禁用HBase令牌获取。

用户在YARN-cluster模式下提交Spark作业时遇到卡顿,原因在于作业试图获取HBase的安全令牌,尽管作业逻辑并未涉及HBase。Spark在Kerberos环境中会自动获取相关服务令牌,解决办法是提交作业时禁用HBase令牌获取。

1549

1549

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?