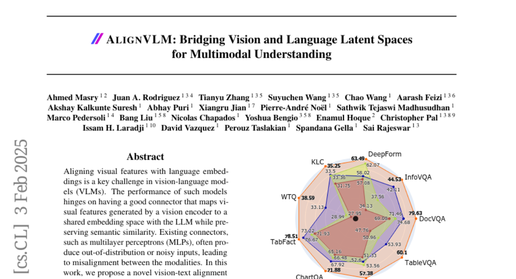

这项由ServiceNow、约克大学和Mila等多个知名研究机构联合开展的创新研究发表于2025年2月3日,题为《ALIGNVLM: Bridging Vision and Language Latent Spaces for Multimodal Understanding》。有兴趣深入了解技术细节的读者可以通过arXiv:2502.01341v1访问完整论文。这次研究的核心团队包括来自ServiceNow的Ahmed Masry、来自约克大学的Enamul Hoque,以及来自蒙特利尔大学和Mila研究所的多位顶尖研究者。

当你拿起手机拍摄一张包含文字的图片时,你是否曾经想过让计算机不仅能"看到"这张图片,还能理解其中的文字含义?这听起来像是科幻电影中的情节,但实际上,这正是当前人工智能领域面临的一个重大挑战。研究团队发现,现有的视觉-语言模型就像是一个能看见但理解困难的翻译员,它们虽然能处理图像和文本,但在将视觉信息准确转换为语言理解时经常出现"翻译错误"。

考虑这样一个场景:当你把一张发票的照片交给AI处理时,AI需要同时理解图像中的表格结构、文字内容和它们的语义关系。这就好比让一个只会中文的人和一个只会英文的人进行合作,他们需要一个精通双语的翻译员来搭建沟通桥梁。在AI的世界里,视觉编码器负责"看"图像,语言模型负责"理解"文字,而连接这两者的"翻译员"就是关键所在。

研究团队发现,传统的连接方法就像使用一个不太靠谱的翻译软件,经常会产生理解偏差或者完全错误的信息传递。这种问题在处理文档图像时尤其严重,因为文档中的信息密度高、结构复杂,需要极其精确的理解能力。为了解决这个问题,他们提出了一个名为ALIGN的创新解决方案,这个方案的核心思想是让视觉信息的转换过程变得更加可靠和精确。

ALIGN的工作原理可以用调色师调配颜料来理解。传统方法就像随意混合颜料,结果往往不可预测。而ALIGN则像是一位经验丰富的调色师,它不是创造全新的颜色,而是通过精确调配已有的基础颜料来获得想要的色彩。在技术层面,ALIGN将视觉特征映射为语言模型已有词汇的加权组合,这确保了转换结果始终在语言模型能够理解的范围内。

一、传统方法的困境与ALIGN的创新突破

要理解ALIGN的创新性,我们需要先了解传统视觉-语言模型面临的挑战。当前的方法主要分为两大类:深度融合和浅层融合。深度融合方法就像对一台精密机器进行大改造,在原有结构中添加大量新的部件。虽然这种方法效果不错,但就像改装一辆汽车需要大量额外零件一样,它显著增加了系统的复杂度和计算成本。

浅层融合方法则相对简单,它使用多层感知机或注意力机制等"翻译器"将视觉特征直接投射到语言空间。这就像使用一个通用转换器将一种插头转换为另一种插头。然而,这种直接转换缺乏约束机制,经常产生语言模型难以理解的"异常输入",就像插头转换器有时会产生不稳定的电流一样。

ALIGN的创新之处在于采用了一种全新的思路。它不是直接进行特征转换,而是将视觉特征转换为语言模型词汇的概率分布,然后通过加权平均得到最终的表示。这个过程可以比作一位厨师调配汤品:不是随意添加调料,而是根据既定的配方,按照特定比例混合各种基础调料。这种方法确保最终的"汤品"(视觉表示)总是由已知的"调料"(语言词汇)组成,因此语言模型能够完美理解。

更具体来说,ALIGN首先使用一个线性层将视觉特征投射到语言模型的词汇空间,然后通过另一个线性层(从语言模型的输出头初始化)计算每个词汇的概率。接着,它使用softmax函数确保这些概率构成一个有效的概率分布。最后,通过将这个概率分布与语言模型的词嵌入矩阵相乘,得到视觉特征的最终表示。

这种设计的巧妙之处在于,它充分利用了语言模型在预训练过程中学习到的语言先验知识。每个视觉特征都被约束在语言模型词汇的凸包内,这意味着它们总是语言模型熟悉的"语言"。这就像确保所有的翻译结果都是目标语言的标准表达,而不是生硬的直译或错误的表述。

研究团队还发现,将第二个线性层初始化为语言模型的语言模型头是一个重要的设计选择。这相当于给翻译器提供了一个优秀的起始词典,让它从一开始就知道如何将视觉概念映射到语言概念。这种初始化方法体现了研究团队对于循环利用语言模型语义信息的深刻理解。

二、ALIGNVLM模型架构的巧妙设计

ALIGNVLM的整体架构就像一条精心设计的生产线,每个环节都经过仔细优化以确保最终产品的质量。整个系统包含三个主要组件:视觉编码器、ALIGN模块和大语言模型,它们协同工作来实现高效的多模态理解。

视觉编码器负责处理输入图像,特别是高分辨率的文档图像。为了应对不同尺寸和宽高比的图像,系统采用了一种巧妙的图像分割策略。就像拼图游戏一样,系统将大图像切割成多个小块(tiles),每个小块的宽高比都是预定义的标准比例。这种方法就像将一幅大壁画分成若干小画板来分别绘制,既保持了细节的清晰度,又便于后续处理。

每个图像块被进一步分割成14×14的小补丁,这些补丁通过SigLip-400M视觉编码器进行处理。这个过程就像将每

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

212

212

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?