0.Abstract :

说明本篇文章的主要工作 : 一是提出了一个用于人体解析的大数据集 Look into Person (LIP), 这个数据集相比之前的数据集更大,覆盖情景更多,更复杂,作者还在这个数据集上详细分析了之前的各种人体解析方法的优劣 。二是提出了一种 self-supervised structure-sensitive approaches 去结合 high-level 的人体关节特征去改进人体解析方法,达到了 state-of-the-art.

1.Introduction :

介绍了目前人体解析任务以及现状。

提出了存在的问题 :

- 没有大规模数据集,并且当前数据集过于简单且没有评价机制来防止潜在的过拟合,导致目前的 CNN 不能达到一个好的效果。

- 缺乏 high-level 的监督去捕捉人体结构的信息,比如人体姿态 (身体的节点)。

写出了本文的贡献:

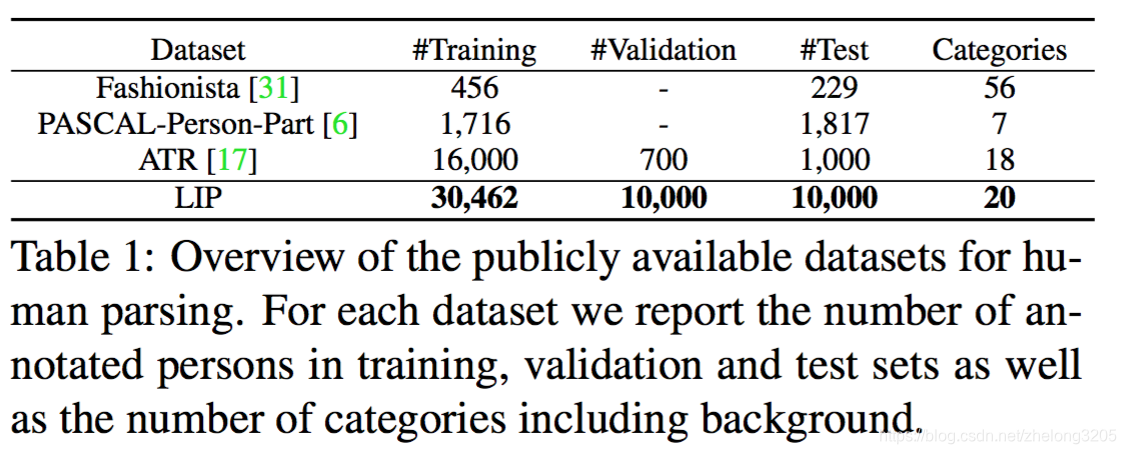

- 建立了一个大的用于人体解析的数据集,它有 50462 张带标记的图片,分为20类 ,19类人体部件标签,1类背景,其中有 30462 张图片作为训练集,10000 张图片作为验证集,还有 10000 张图片作为测试集,并且提供了专门的测试服务

- 在这个基准数据集上详细的分析了之前的人体解析的方法的成功与失败之处。

- 提出了一种 self-supervised structure-sensitive 架构去保证人体结构和人体解析结果的一致性,达到改进当前的深度学习方法的目的。

2.Related work

介绍了当前领域的情况,包括数据集情况和深度学习方法在

本文介绍了Look into Person(LIP)数据集,这是一个针对人体解析的大规模复杂数据集,分析了现有方法的优缺点。同时,提出了自监督结构敏感学习方法,利用人体关节信息提升解析准确性。实验表明,该方法在遮挡、不同视角等挑战下表现出色。

本文介绍了Look into Person(LIP)数据集,这是一个针对人体解析的大规模复杂数据集,分析了现有方法的优缺点。同时,提出了自监督结构敏感学习方法,利用人体关节信息提升解析准确性。实验表明,该方法在遮挡、不同视角等挑战下表现出色。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

4253

4253

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?