配置yum源

[k8s]

name=k8s

baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64/

gpgcheck=0

安装时可以指定版本

yum install kubelet-1.15.0

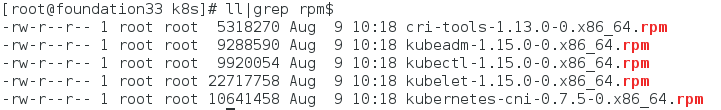

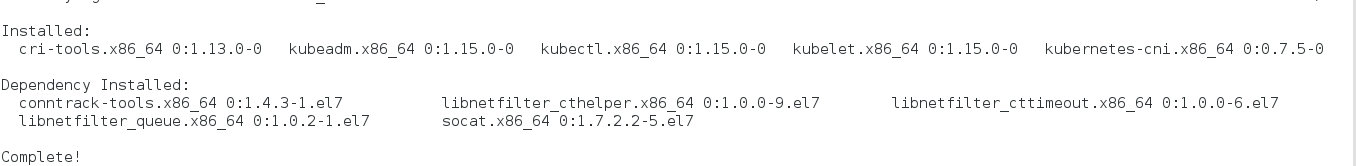

下载软件,安装(注意软件版本的一致性,所有节点都进行安装)

安装结果

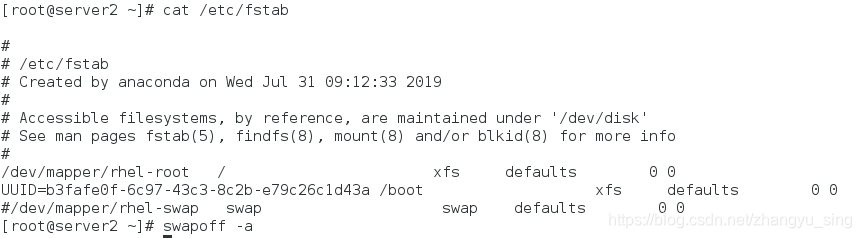

关闭所有结点的交换分区

注释

#/dev/mapper/rhel-swap swap swap defaults 0 0

命令

swapoff -a

所有节点进行网络配置,同时设置服务启动服务

cat /etc/sysctl.d/k8s.conf

net.bridge.bridge-nf-call-ip6tables = 1

net.bridge.bridge-nf-call-iptables = 1

sysctl --system

设置服务开机子启动

systemctl start kubelet.service

systemctl enable kubelet.service

systemctl start docker.service

systemctl enable docker.service

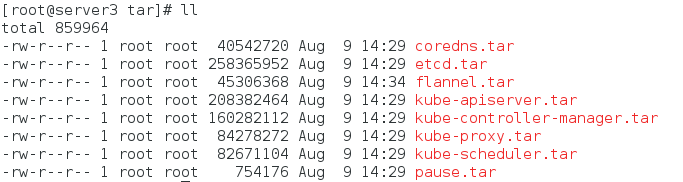

所有节点加载镜像

配置kubelet

kubeadm init --pod-network-cidr=10.244.0.0/16 --apiserver-advertise-address=172.25.33.1

添加用户

创建kubeadm用户

useradd kubeadm

vim /etc/sudoers

文件编辑内容如下:

kubeadm ALL=(ALL) NOPASSWD: ALL

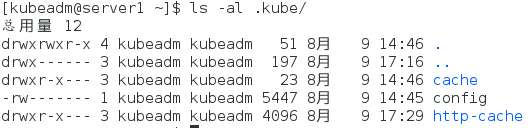

在kubeadm用户下配置kubectl

su - kubeadm

mkdir -p $HOME/.kube

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

sudo chown kubeadm:kubeadm $HOME/.kube/config

下载安装网络插件,运行其配置文件

kubectl apply -f kube-flannel.yml

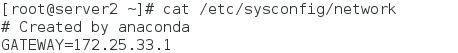

node节点配置网关为master的IP

node节点加入集群

kubeadm join 172.25.33.1:6443 --token dctbt9.j8ef3ddnbc0kcr35 --discovery-token-ca-cert-hash sha256:571ee7a9dd40eab82c90de65233c68ef075e0fc634bfeda1c053570ab311d9f3

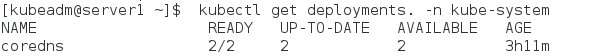

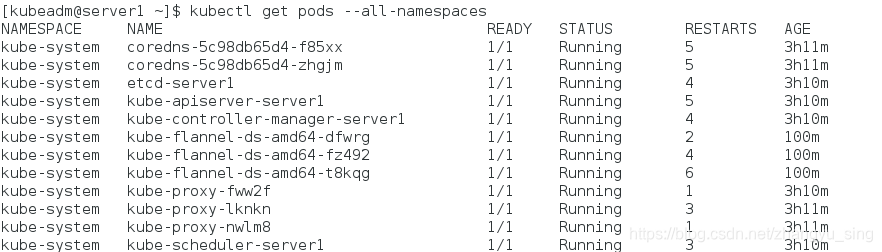

查看结果

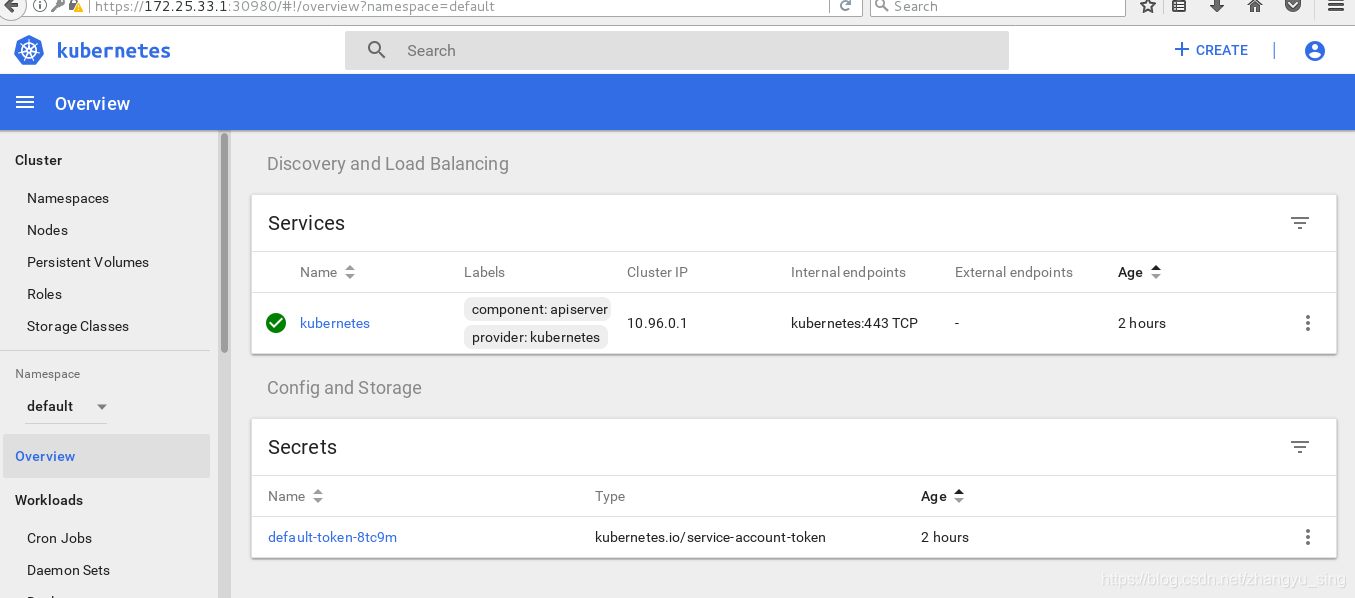

加入dashboard界面,拉取镜像(所有节点)

运行配置文件

kubectl apply -f kubernetes-dashboard.yaml

可以使用delete以及create命令更新

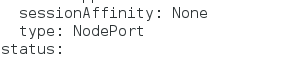

修改节点类型

kubectl edit service kubernetes-dashboard -n kube-system

添加管理员

kubectl apply -f dashboard-admin.yaml

apiVersion: v1

kind: ServiceAccount

metadata:

name: admin-user

namespace: kube-system

---

apiVersion: rbac.authorization.k8s.io/v1

kind: ClusterRoleBinding

metadata:

name: admin-user

roleRef:

apiGroup: rbac.authorization.k8s.io

kind: ClusterRole

name: cluster-admin

subjects:

- kind: ServiceAccount

name: admin-user

namespace: kube-system

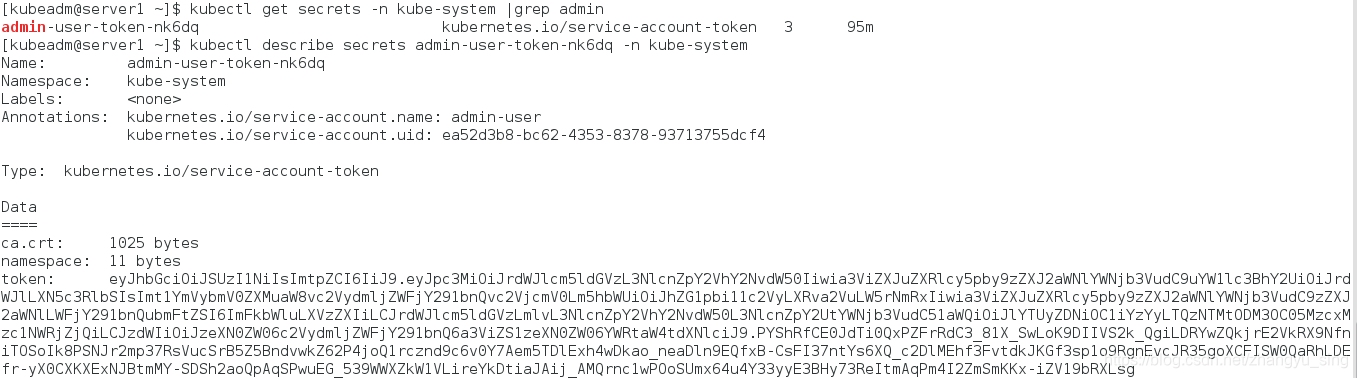

获取管理员令牌

kubectl get secrets -n kube-system |grep admin

kubectl describe secrets admin-user-token-nk6dq -n kube-system

登录

3045

3045

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?