Latex写CV的一点记录

- 字体加粗:

{\textbf{content}} - 两行之间设置距离:

\setlength{\smallskip}

In tabular environment:\noalign{\smallskip} - 句首空格:

\setlength{\leftskip}

In tabular environment:\hspace{distance} In tabularx设置alignment,右对齐格式:

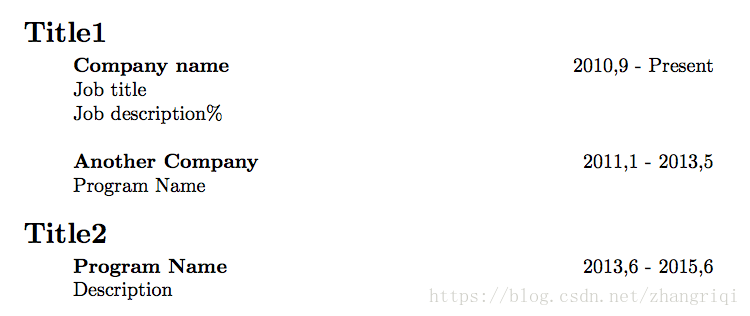

{\linewidth}{@{}p{0.8\linewidth}@{}r@{}}具体代码和效果

\usepackage{array}

\usepackage{tabularx}

\noindent \begin{tabularx}

{\linewidth}{@{}p{0.8\linewidth}@{}r@{}}

\Large{\textbf{Title1}} \\

\noalign{\smallskip}

\hspace{5ex} \textbf{Company name} & 2010,9 - Present \\

\hspace{5ex} Job title \\

\hspace{5ex} Job description\% \\

& \\

\hspace{5ex} \textbf{Another Company} & 2011,1 - 2013,5\\

\hspace{5ex} Program Name \\

& \\

\Large{\textbf{Title2}} \\

\noalign{\smallskip}

\hspace{5ex} \textbf{Program Name} & 2013,6 - 2015,6 \\

\hspace{5ex} Description \\

& \\

\end{tabularx}>

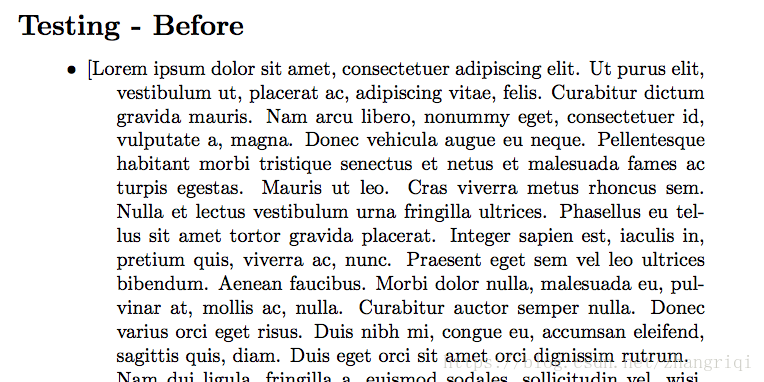

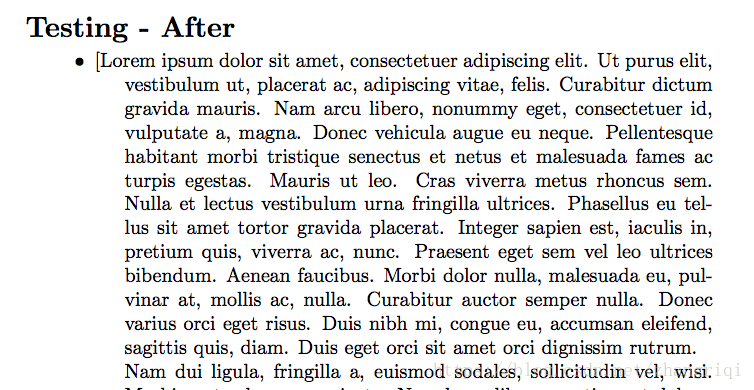

In description: 设置item与前一行的距离

[topsep = 3pt] or \vspace{-1mm}具体代码和效果如下:

\usepackage{lipsum}

\usepackage{enumitem}

...

\noindent\Large{\textbf{Testing - Before}}

\setlength{\parskip}{0pt}

\begin{description}

%\vspace{-1mm}%

\setlength{\parskip}{0ex}

\setlength{\leftskip}{4ex} \normalsize

\item[$\bullet$] [\lipsum1]

\end{description}

\noindent\Large{\textbf{Testing - After}}

\setlength{\parskip}{0pt}

\begin{description} [topsep = 3pt]

%\vspace{-1mm}%

\setlength{\parskip}{0ex}

\setlength{\leftskip}{4ex} \normalsize

\item[$\bullet$] [\lipsum1]

这篇博客记录了使用LaTeX编写简历时的一些实用技巧,包括字体加粗、调整行距、在表格环境中的操作以及在description环境中设置item间距的方法,帮助提升简历的排版质量。

这篇博客记录了使用LaTeX编写简历时的一些实用技巧,包括字体加粗、调整行距、在表格环境中的操作以及在description环境中设置item间距的方法,帮助提升简历的排版质量。

901

901

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?