文章目录

- @[toc]

- 环境准备

- 注意事项 [#](http://www.plumelog.com/zh-cn/docs/FASTSTART.html#使用前注意事项)

- 一、服务端安装配置 [#](http://www.plumelog.com/zh-cn/docs/FASTSTART.html#一、服务端安装配置)

-

- 二、客户端使用 [#](http://www.plumelog.com/zh-cn/docs/FASTSTART.html#二、客户端使用)

- (1)注意事项 [#](http://www.plumelog.com/zh-cn/docs/FASTSTART.html#(1)注意事项)

- (2)客户端配置 [#](http://www.plumelog.com/zh-cn/docs/FASTSTART.html#(2)客户端配置)

- 1.log4j [#](http://www.plumelog.com/zh-cn/docs/FASTSTART.html#1.log4j)

- 2.logback [#](http://www.plumelog.com/zh-cn/docs/FASTSTART.html#2.logback)

- 3.logback整合配置中心案例,推荐使用,不知道怎么配置的拷贝全部 [#](http://www.plumelog.com/zh-cn/docs/FASTSTART.html#3.logback整合配置中心案例,推荐使用,不知道怎么配置的拷贝全部)

- 4.log4j2 [#](http://www.plumelog.com/zh-cn/docs/FASTSTART.html#4.log4j2)

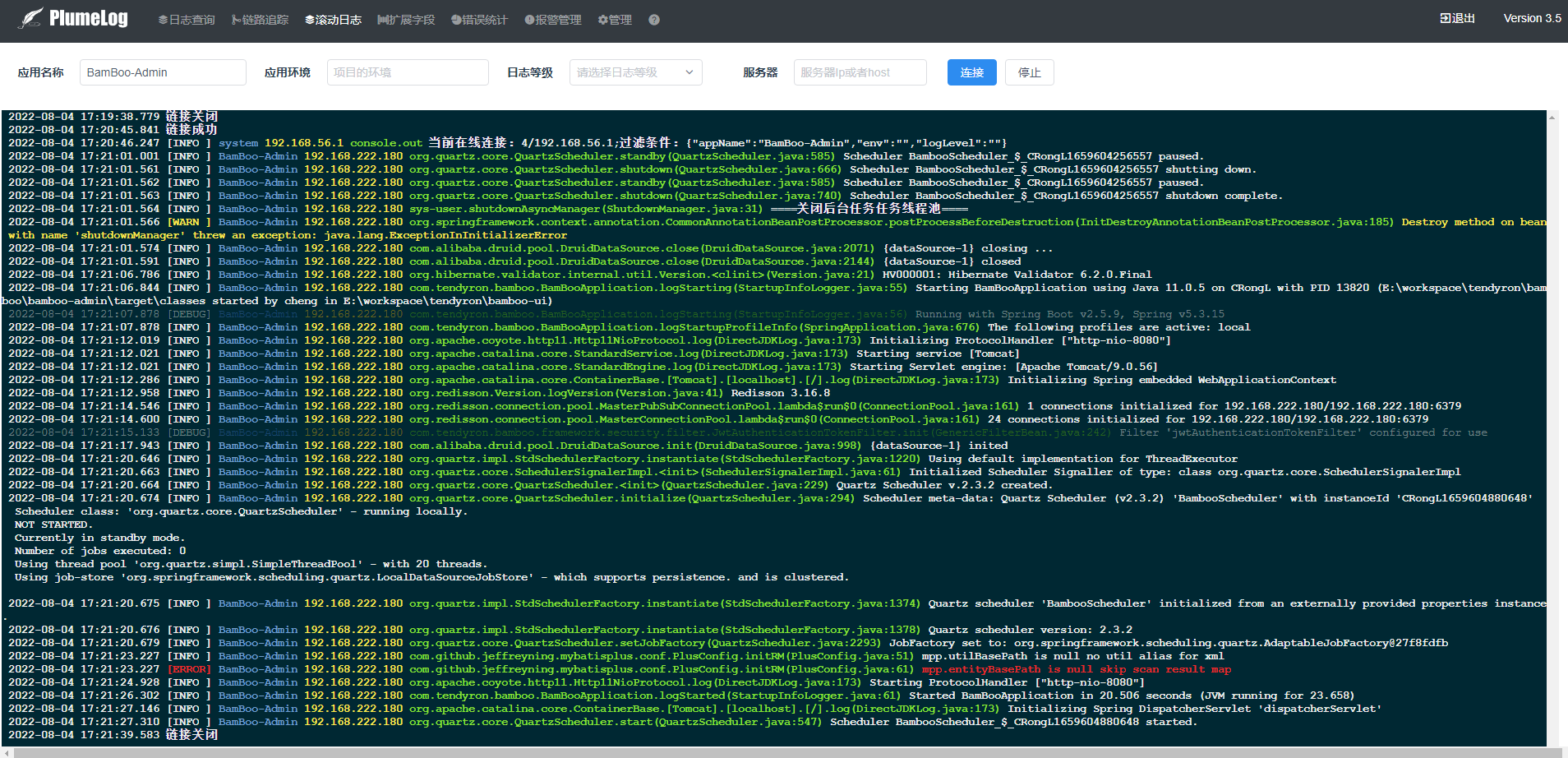

- 三、系统截图

- 四、常见问题整理

- 其他

文章目录

- @[toc]

- 环境准备

- 注意事项 [#](http://www.plumelog.com/zh-cn/docs/FASTSTART.html#使用前注意事项)

- 一、服务端安装配置 [#](http://www.plumelog.com/zh-cn/docs/FASTSTART.html#一、服务端安装配置)

- 二、客户端使用 [#](http://www.plumelog.com/zh-cn/docs/FASTSTART.html#二、客户端使用)

- (1)注意事项 [#](http://www.plumelog.com/zh-cn/docs/FASTSTART.html#(1)注意事项)

- (2)客户端配置 [#](http://www.plumelog.com/zh-cn/docs/FASTSTART.html#(2)客户端配置)

- 1.log4j [#](http://www.plumelog.com/zh-cn/docs/FASTSTART.html#1.log4j)

- 2.logback [#](http://www.plumelog.com/zh-cn/docs/FASTSTART.html#2.logback)

- 3.logback整合配置中心案例,推荐使用,不知道怎么配置的拷贝全部 [#](http://www.plumelog.com/zh-cn/docs/FASTSTART.html#3.logback整合配置中心案例,推荐使用,不知道怎么配置的拷贝全部)

- 4.log4j2 [#](http://www.plumelog.com/zh-cn/docs/FASTSTART.html#4.log4j2)

- 三、系统截图

- 四、常见问题整理

- 其他

环境准备

- 使用前请耐心的按照步骤把文档看完,需要对logback,log4j两大日志框架基本配置有一定了解

注意事项 #

- plumelog分三种启动模式,分别为redis,kafka,lite,外加嵌入式版本plumelog-lite,大家根据自己的需求使用部署

- lite模式也就是单机版,不依赖任何外部中间件直接启动使用,部署极其方便,但是性能有限,一天10个G以内可以应付,最好是SSD硬盘,适合管理系统类的小玩家,一个公司有很多小系统需要日志集中管理

- redis,kafka模式可以集群分布式部署,适合大型玩家,互联网公司,具体是用redis还是kafka,看每个公司运维情况

- plumelog-lite plumelog的嵌入式集成版本,直接pom引用,嵌入在项目中,自带查询界面,适合单个独立小项目使用,外包软件的最佳伴侣

一、服务端安装配置 #

(1)服务端安装 #

第一步:安装 redis 或者 kafka(一般公司redis足够) redis 官网:https://redis.io kafka:http://kafka.apache.org

第二步:安装 elasticsearch 官网下载地址:https://www.elastic.co/cn/downloads/past-releases

第三步:下载安装包,plumelog-server 下载地址:https://gitee.com/plumeorg/plumelog/releases

第四步:配置plumelog-server,并启动,redis和kafka作为队列模式下可以部署多个plumelog-server达到高可用,配置一样即可

第五步:后台查询语法详见plumelog使用指南

(2)服务端配置 #

- 文件 plumelog-server/application.properties 详解:

#值为4种 redis,kafka,rest,restServer,lite

#redis 表示用redis当队列

#kafka 表示用kafka当队列

#rest 表示从rest接口取日志

#restServer 表示作为rest接口服务器启动

#ui 表示单独作为ui启动

#lite 简易模式启动不需要配置redis,es等

plumelog.model=redis

#lite模式下日志存储路径

#plumelog.lite.log.path=/lucene

#如果使用kafka,启用下面配置

#plumelog.kafka.kafkaHosts=172.16.247.143:9092,172.16.247.60:9092,172.16.247.64:9092

#plumelog.kafka.kafkaGroupName=logConsumer

#队列redis地址,model配置redis集群模式,哨兵模式用逗号隔开,队列redis不支持集群模式,lite模式可以全部注释掉下面配置

#当redis队列性能不够的时候,可以不同的项目单独配置单独的redis队列,用单独的plumelog-server去采集,公用一个管理redis

plumelog.queue.redis.redisHost=127.0.0.1:6379

#如果使用redis有密码,启用下面配置

#plumelog.queue.redis.redisPassWord=123456

#如果要切换db,redis必须要配置密码

#plumelog.queue.redis.redisDb=0

#哨兵模式需要配置的

#plumelog.queue.redis.sentinel.masterName=myMaster

#redis解压缩模式,开启后不消费非压缩的队列

#plumelog.redis.compressor=true

#管理端redis地址 ,集群用逗号隔开,不配置将和队列公用,lite模式可以全部注释掉下面配置,管理redis单独使用的时候支持集群模式

#plumelog.redis.redisHost=127.0.0.1:6379

#如果使用redis有密码,启用下面配置

#plumelog.redis.redisPassWord=123456

#plumelog.redis.redisDb=0

#哨兵模式需要配置的

#plumelog.redis.sentinel.masterName=myMaster

#如果使用rest,启用下面配置

#plumelog.rest.restUrl=http://127.0.0.1:8891/getlog

#plumelog.rest.restUserName=plumelog

#plumelog.rest.restPassWord=123456

#elasticsearch相关配置,Hosts支持携带协议,如:http、https,集群逗号隔开,lite模式可以全部注释掉下面配置

plumelog.es.esHosts=127.0.0.1:9200

plumelog.es.shards=5

plumelog.es.replicas=1

plumelog.es.refresh.interval=30s

#日志索引建立方式day表示按天、hour表示按照小时

plumelog.es.indexType.model=day

#hour模式下需要配置这个

#plumelog.es.maxShards=100000

#ES设置密码,启用下面配置

#plumelog.es.userName=elastic

#plumelog.es.passWord=elastic

#是否信任自签证书

#plumelog.es.trustSelfSigned=true

#是否hostname验证

#plumelog.es.hostnameVerification=false

#以下配置不管什么模式都要配置

#单次拉取日志条数

plumelog.maxSendSize=100

#拉取时间间隔,kafka不生效

plumelog.interval=100

#plumelog-ui的地址 如果不配置,报警信息里不可以点连接

plumelog.ui.url=http://demo.plumelog.com

#管理密码,手动删除日志的时候需要输入的密码

admin.password=123456

#日志保留天数,配置0或者不配置默认永久保留

admin.log.keepDays=30

#链路保留天数,配置0或者不配置默认永久保留

admin.log.trace.keepDays=30

#登录配置,配置后会有登录界面

#login.username=admin

#login.password=admin

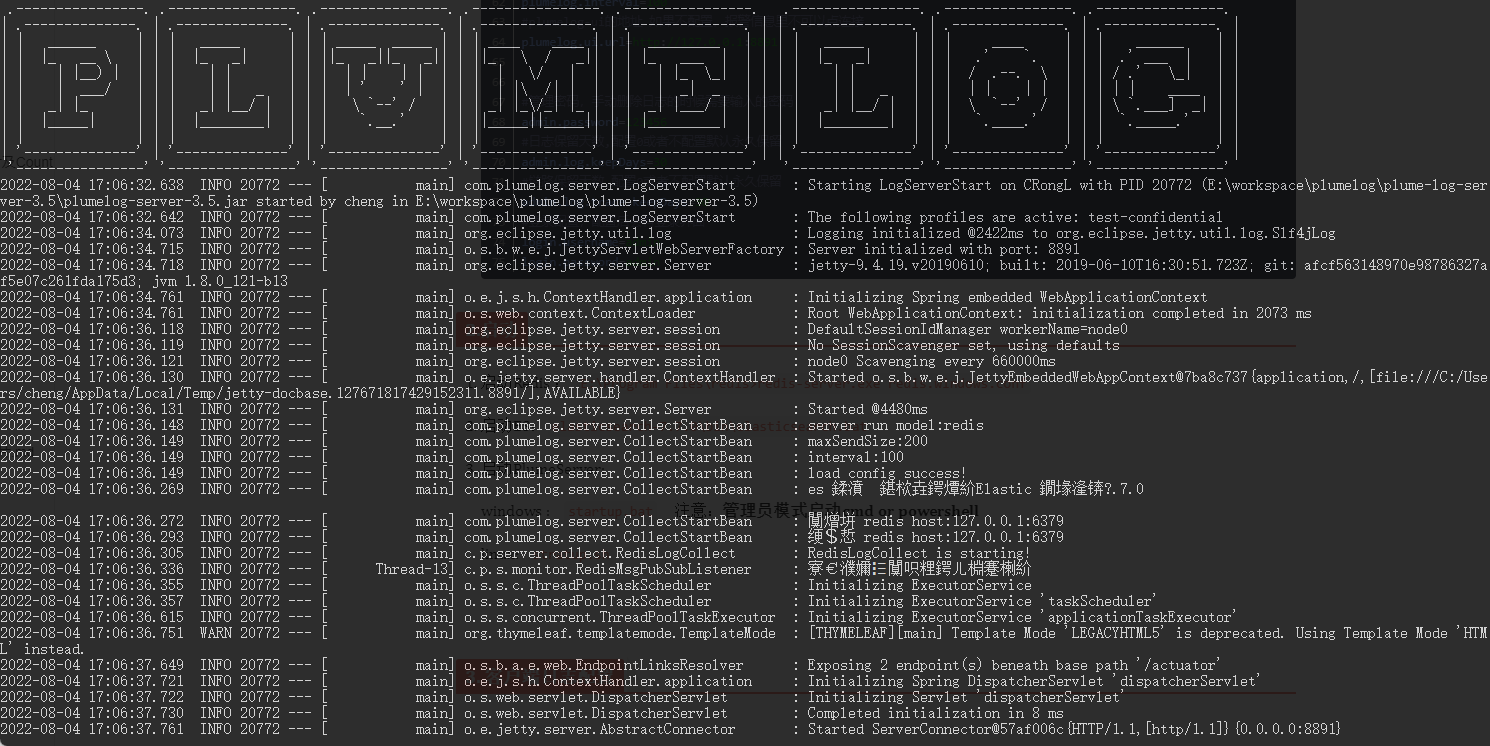

(3)启动 PlumeServer

windows : startup.bat 注意:管理员模式启动 cmd or powershell

linux: stratup.sh

二、客户端使用 #

(1)注意事项 #

-

1.客户端在项目使用,非maven项目下载依赖包( https://gitee.com/frankchenlong/plumelog/releases )放在自己的lib下面直接使用,去除重复的包即可使用,然后配置log4j就可以搜集日志了

-

2.推荐使用logback,特别是springboot,springcloud项目;注意:3.2版本logback有bug,请使用3.2.1修复版本或者以上版本

-

3.示例中仅仅是基本配置,更多配置请看文章下面配置详解

-

4.示例中plumelog相关版本号为示例,实际使用建议取最新的版本,最新的版如下

(2)客户端配置 #

1.log4j #

- 引入

<dependency>

<groupId>com.plumelog</groupId>

<artifactId>plumelog-log4j</artifactId>

<version>3.5.2</version>

</dependency>

- 配置log4j配置文件,增加下面这个Appender,示例如下:

#三选一加入到root

log4j.rootLogger=INFO,stdout,L

log4j.appender.stdout=org.apache.log4j.ConsoleAppender

log4j.appender.stdout.Target=System.out

log4j.appender.stdout.layout=org.apache.log4j.PatternLayout

log4j.appender.stdout.layout.ConversionPattern=[%-5p] %d{yyyy-MM-dd HH:mm:ss,SSS} [%c.%t]%n%m%n

#kafka做为中间件

log4j.appender.L=com.plumelog.log4j.appender.KafkaAppender

#appName系统的名称(自己定义就好)

log4j.appender.L.appName=plumelog

log4j.appender.L.env=${spring.profiles.active}

log4j.appender.L.kafkaHosts=172.16.247.143:9092,172.16.247.60:9092,172.16.247.64:9092

#redis做为中间件

log4j.appender.L=com.plumelog.log4j.appender.RedisAppender

log4j.appender.L.appName=plumelog

log4j.appender.L.env=${spring.profiles.active}

log4j.appender.L.redisHost=172.16.249.72:6379

#redis没有密码这一项为空或者不需要

#log4j.appender.L.redisAuth=123456

#lite模式

log4j.appender.L=com.plumelog.log4j.appender.LiteAppender

log4j.appender.L.appName=plumelog

log4j.appender.L.env=${spring.profiles.active}

log4j.appender.L.plumelogHost=localhost:8891

同理如果使用logback,和log4j2配置如下,示例如下:

2.logback #

- 引入

<dependency>

<groupId>com.plumelog</groupId>

<artifactId>plumelog-logback</artifactId>

<version>3.5.2</version>

</dependency>

- 配置

<appenders>

<!--使用redis启用下面配置-->

<appender name="plumelog" class="com.plumelog.logback.appender.RedisAppender">

<appName>plumelog</appName>

<redisHost>172.16.249.72:6379</redisHost>

<redisAuth>123456</redisAuth>

</appender>

<!-- 使用kafka启用下面配置 -->

<appender name="plumelog" class="com.plumelog.logback.appender.KafkaAppender">

<appName>plumelog</appName>

<kafkaHosts>172.16.247.143:9092,172.16.247.60:9092,172.16.247.64:9092</kafkaHosts>

</appender>

<!-- 使用lite模式启用下面配置 -->

<appender name="plumelog" class="com.plumelog.logback.appender.LiteAppender">

<appName>worker</appName>

<plumelogHost>localhost:8891</plumelogHost>

</appender>

</appenders>

<!--使用上面三个三选一加入到root下面-->

<root level="INFO">

<appender-ref ref="plumelog"/>

</root>

3.logback整合配置中心案例,推荐使用,不知道怎么配置的拷贝全部 #

- application.properties中添加

plumelog.appName=plumelog_demo

plumelog.redisHost=127.0.0.1:6379

plumelog.redisAuth=plumelogredis

spring.profiles.active=dev

- logback-spring.xml 不知道怎么配置的拷贝全部

<?xml version="1.0" encoding="UTF-8"?>

<configuration debug="false">

<conversionRule conversionWord="clr" converterClass="org.springframework.boot.logging.logback.ColorConverter"/>

<conversionRule conversionWord="wex"

converterClass="org.springframework.boot.logging.logback.WhitespaceThrowableProxyConverter"/>

<conversionRule conversionWord="wEx"

converterClass="org.springframework.boot.logging.logback.ExtendedWhitespaceThrowableProxyConverter"/>

<!-- 彩色日志格式 -->

<property name="CONSOLE_LOG_PATTERN"

value="${CONSOLE_LOG_PATTERN:-%clr(%d{yyyy-MM-dd HH:mm:ss.SSS}){faint} %clr(${LOG_LEVEL_PATTERN:-%5p}) %clr(${PID:- }){magenta} %clr(---){faint} %clr([%15.15t]){faint} %clr(%-40.40logger{39}){cyan} %clr(:){faint} %m%n${LOG_EXCEPTION_CONVERSION_WORD:-%wEx}}"/>

<!--输出到控制台-->

<appender name="CONSOLE" class="ch.qos.logback.core.ConsoleAppender">

<!--过滤trace日志到控制台-->

<filter class="com.plumelog.logback.util.FilterSyncLogger">

<level></level>

</filter>

<encoder>

<Pattern>${CONSOLE_LOG_PATTERN}</Pattern>

<!-- 设置字符集 -->

<charset>UTF-8</charset>

</encoder>

</appender>

<!-- 输出到文件 -->

<appender name="file" class="ch.qos.logback.core.rolling.RollingFileAppender">

<rollingPolicy class="ch.qos.logback.core.rolling.TimeBasedRollingPolicy">

<FileNamePattern>logs/plumelog-demo.log.%d{yyyy-MM-dd}.log</FileNamePattern>

<MaxHistory>3</MaxHistory>

</rollingPolicy>

<encoder>

<Pattern>${CONSOLE_LOG_PATTERN}</Pattern>

<!-- 设置字符集 -->

<charset>UTF-8</charset>

</encoder>

</appender>

<!-- 环境配置 -->

<springProperty scope="context" name="plumelog.appName" source="plumelog.appName"/>

<springProperty scope="context" name="plumelog.redisHost" source="plumelog.redisHost"/>

<springProperty scope="context" name="plumelog.redisPort" source="plumelog.redisPort"/>

<springProperty scope="context" name="plumelog.redisAuth" source="plumelog.redisAuth"/>

<springProperty scope="context" name="plumelog.redisDb" source="plumelog.redisDb"/>

<springProperty scope="context" name="plumelog.env" source="spring.profiles.active"/>

<!-- 输出plumelog -->

<appender name="plumelog" class="com.plumelog.logback.appender.RedisAppender">

<appName>${plumelog.appName}</appName>

<redisHost>${plumelog.redisHost}</redisHost>

<redisAuth>${plumelog.redisAuth}</redisAuth>

<redisDb>${plumelog.redisDb}</redisDb>

<env>${plumelog.env}</env>

</appender>

<!-- 配置日志输出,只输出info,只保留控制台和plumelog输出-->

<!-- 正常开发环境本地,只输出到控制台,测试环境只输出到plumelog,生产环境输出到本地文件plumelog,因为有plumelog加持本地文件就保留3天即可-->

<!-- 这些都可以根据环境配置不同加载不同的ref->

<root level="info">

<!--输出到控制台-->

<appender-ref ref="CONSOLE"/>

<!-- 输出到文件 -->

<appender-ref ref="file"/>

<!-- 输出plumelog -->

<appender-ref ref="plumelog"/>

</root>

</configuration>

- 结合环境配置案例

<springProfile name="dev">

<root level="INFO">

<appender-ref ref="CONSOLE" />

</root>

</springProfile>

<springProfile name="test">

<root level="INFO">

<appender-ref ref="FILE" />

</root>

</springProfile>

<springProfile name="prod">

<root level="INFO">

<appender-ref ref="FILE" />

</root>

</springProfile>

-

小提示:为什么Spring Boot推荐使用logback-spring.xml来替代logback.xml来配置logback日志的问题分析

即,logback.xml加载早于application.properties,所以如果你在logback.xml使用了变量时,而恰好这个变量是写在application.properties时,那么就会获取不到,只要改成logback-spring.xml就可以解决。

这就是为什么有些人用了nacos等配置中心,不能加载远程配置的原因,是因为加载优先级的问题

4.log4j2 #

- 引入

<dependency>

<groupId>com.plumelog</groupId>

<artifactId>plumelog-log4j2</artifactId>

<version>3.5.2</version>

</dependency>

- 配置,示例如下:

<appenders>

<!-- 使用kafka启用下面配置 -->

<KafkaAppender name="kafkaAppender" appName="plumelog"

kafkaHosts="172.16.247.143:9092,172.16.247.60:9092,172.16.247.64:9092">

</KafkaAppender>

<!--使用redis启用下面配置-->

<RedisAppender name="redisAppender" appName="plumelog" redisHost="172.16.249.72:6379" redisAuth="123456">

</RedisAppender>

<!--使用lite启用下面配置-->

<LiteAppender name="liteAppender" appName="plumelog" plumelogHost="localhost:8891">

</LiteAppender>

</appenders>

<loggers>

<root level="INFO">

<!--使用上面三个三选一加入到root下面-->

<appender-ref ref="redisAppender"/>

</root>

</loggers>

三、系统截图

四、常见问题整理

-

redis在项目中充当什么角色?

redis在项目中两个角色,第一是在redis模式下充当消息队列,第二是项目本身的元数据存储和报警管理

-

为什么我查看redis中有数据,但是后台却查不到呢?

这种情况大概率是server中 plumelog.queue.redis.redisHost 没有配置正确,redis只是充当队列的作用,如果里面能看到数据说明没有server没有消费,正常情况应该是redis是不会积压的

-

为什么我配置了,之后后台无法查到日志?

排查方法:第一步:停止server,启动日志采集项目,观察redis中有没有数据,如果有说明从项目进入队列是通的,如果没有检查项目端redis配置是否正确;第二步:如果在redis有数据情况,启动server,如果server日志里有ElasticSearch commit! success;表示链路成功

很多小伙伴,配置了客户端,但是logback.xml或者log4j2.xml压根没生效,所以这时候需要停止plumelog-server,把第一步到Redis调通,到Redis调通了,启动plumelog-server看到日志在被消费掉说明成功了

-

为什么我链路追踪里看不到数据?

链路追踪模块产生的日志量比较大,考虑到低需求玩家,默认不集成,需要单独配置,详细查看文档:链路追踪配置

如果配置下来还是没有链路数据,第一检查是否有traceID,第二你的AOP生效了吗?

-

plumelog客户端配置能结合配置文件中心使用吗?

肯定是可以的,plumelog配置是配置在三大日志框架的配置文件里面的,可以使用springProperty进行管理配置,具体怎么操作看每个项目自己的情况

-

plumelog目前生产环境已知的已经有多大体量

根据用户反馈,目前搜集到最大的用户每日日志量已经到达3TB,并稳定运行

-

为什么我的项目继承了plumelog就启动就报错?

如果提示redis连接失败,那么说明redis配置错误,如果是其他错误,比如提示类找不到什么情况,应该数据日志配置文件错了,建议先熟练掌握log4j,logback配制文件里面的标签含义

-

plumelog会影响原来的日志配置么?

不会,plumelog只是增加了一种输出,不影响原来的配置

-

plumelog会影响项目性能么?

几乎不会,plumelog-lite在查询的时候可能会,必定是内嵌的

-

应用名称下拉框展开无数据?怎么回事?

下拉框展开为了保证性能,只有也没首次加载的时候会加载,当天如果有日志但是就是展开没有值可能是索引创建的时候出错了,怎么验证呢?

进入管理页面,点开运行数据表格中当天日志前面的箭头展开,如果里面有数据,说明索引没问题,此时只要关闭浏览器重新进入即可

如果展开什么都没有说明索引创建的时候分组信息丢失,选中点击重置索引,关闭浏览器重新进入即可

-

为啥使用统一配置中心nacos之类的,不能加载参数?

Spring Boot推荐使用logback-spring.xml来替代logback.xml来配置logback日志的问题分析

即,logback.xml加载早于application.properties,所以如果你在logback.xml使用了变量时,而恰好这个变量是写在application.properties时,那么就会获取不到,只要改成logback-spring.xml就可以解决。

这就是为什么有些人用了nacos等配置中心,不能加载远程配置的原因,是因为加载优先级的问题

-

plumelog挂了日志丢失怎么办?

plumelog的设计定位就是日志查询工具类系统,不可能去为了日志高幂等性去牺牲性能,甚至影响客户端,所以如果你担心plumelog挂了查不到日志,那你可以在本地再配置一个滚动日志保留三天作为补充

其他

参考:http://www.plumelog.com/zh-cn/docs/FASTSTART.html

https://my.oschina.net/u/3245438/blog/5562226

1391

1391

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?