- 数据增强

- 卷积神经网络定义的写法

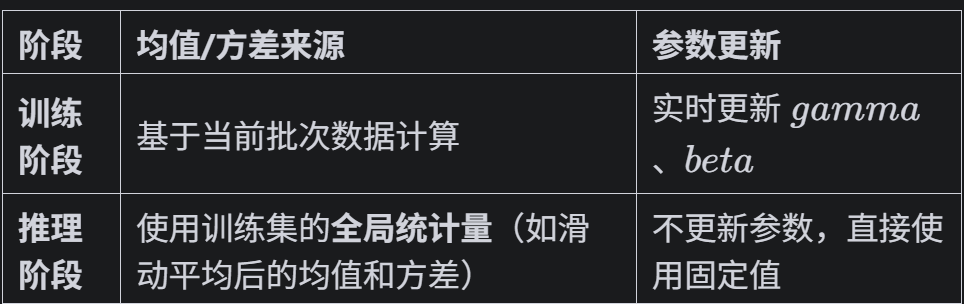

- batch归一化:调整一个批次的分布,常用与图像数据

- 特征图:只有卷积操作输出的才叫特征图

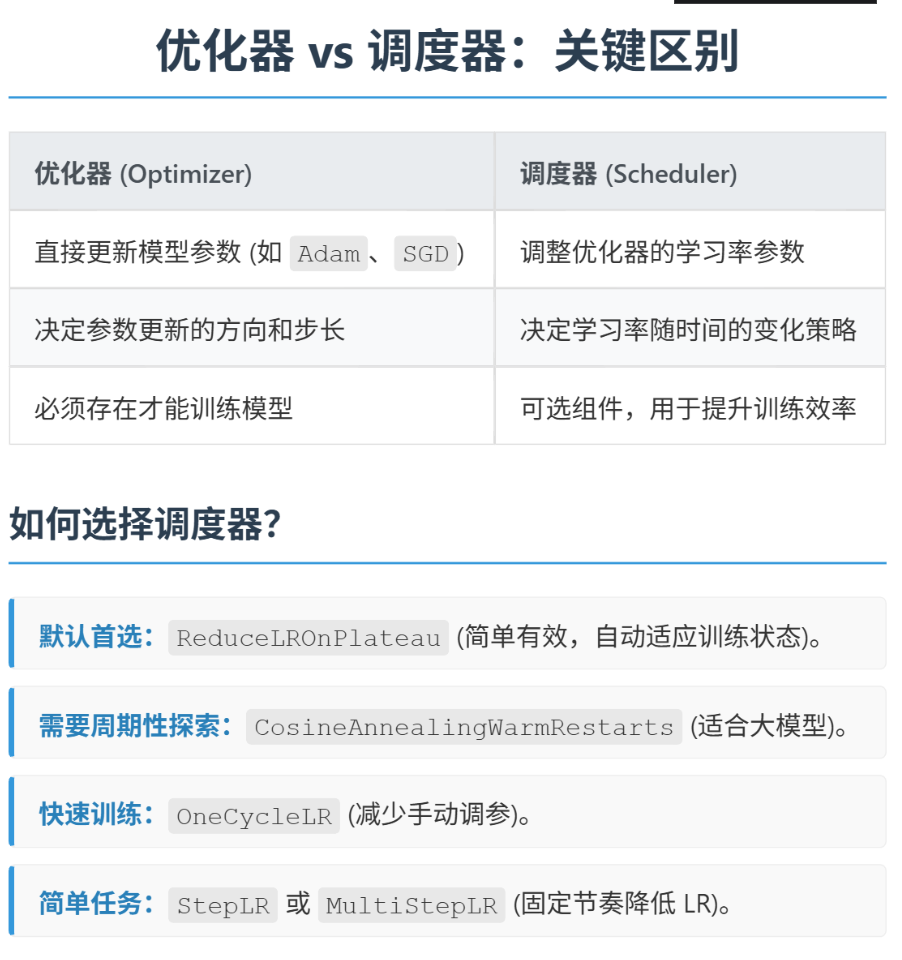

- 调度器:直接修改基础学习率

卷积操作常见流程如下:

输入 → 卷积层 → Batch归一化层(可选) → 池化层 → 激活函数 → 下一层

Flatten -> Dense (with Dropout,可选) -> Dense (Output)

在学习后面的知识之前要明确,卷积层是特征提取器、池化层是特征压缩器,这二者都是在进行下采样操作

一、数据增强

在图像数据预处理环节,为了提升数据多样性,科研采用数据增强策略。

不改变单次训练的的样本总数,通过对现有图像进行以下变化,拓宽模型训练的样本空间多样性。

1.几何变换,包括:旋转、缩放、平移、剪裁、翻转等

2.像素变换,包括:修改颜色、亮度、对比度、饱和度、色相、通过高斯模糊来模拟对焦失败、增强噪声、马赛克

3.语义增强(暂时不用),mixup图像混合、对图像进行结构性改造、cutout随机遮挡等

在数据极少的场景中,常常使用生成模型来扩充数据集,如GAN、VAE等

注意:数据增强一般是不改变每个批次的数据量,是对原始数据修改后替换原始数据。其中该数据集事先知道其均值和标准差,如果不知道,需要提前计算下。

二、CNN模型

卷积的本质:通过卷积核在输入通道上的滑动乘积,提取跨通道的空间特征。所以只需要定义几个参数即可

1. 卷积核大小:卷积核的大小,如3x3、5x5、7x7等。

2. 输入通道数:输入图片的通道数,如1(单通道图片)、3(RGB图片)、4(RGBA图片)等。

3. 输出通道数:卷积核的个数,即输出的通道数。如本模型中通过 32→64→128 逐步增加特征复杂度

4. 步长(stride):卷积核的滑动步长,默认为1。

# 4. 定义CNN模型的定义(替代原MLP)

class CNN(nn.Module):

def __init__(self):

super(CNN, self).__init__() # 继承父类初始化

# ---------------------- 第一个卷积块 ----------------------

# 卷积层1:输入3通道(RGB),输出32个特征图,卷积核3x3,边缘填充1像素

self.conv1 = nn.Conv2d(

in_channels=3, # 输入通道数(图像的RGB通道)

out_channels=32, # 输出通道数(生成32个新特征图)

kernel_size=3, # 卷积核尺寸(3x3像素)

padding=1 # 边缘填充1像素,保持输出尺寸与输入相同

)

# 批量归一化层:对32个输出通道进行归一化,加速训练

self.bn1 = nn.BatchNorm2d(num_features=32)

# ReLU激活函数:引入非线性,公式:max(0, x)

self.relu1 = nn.ReLU()

# 最大池化层:窗口2x2,步长2,特征图尺寸减半(32x32→16x16)

self.pool1 = nn.MaxPool2d(kernel_size=2, stride=2) # stride默认等于kernel_size

# ---------------------- 第二个卷积块 ----------------------

# 卷积层2:输入32通道(来自conv1的输出),输出64通道

self.conv2 = nn.Conv2d(

in_channels=32, # 输入通道数(前一层的输出通道数)

out_channels=64, # 输出通道数(特征图数量翻倍)

kernel_size=3, # 卷积核尺寸不变

padding=1 # 保持尺寸:16x16→16x16(卷积后)→8x8(池化后)

)

self.bn2 = nn.BatchNorm2d(num_features=64)

self.relu2 = nn.ReLU()

self.pool2 = nn.MaxPool2d(kernel_size=2) # 尺寸减半:16x16→8x8

# ---------------------- 第三个卷积块 ----------------------

# 卷积层3:输入64通道,输出128通道

self.conv3 = nn.Conv2d(

in_channels=64, # 输入通道数(前一层的输出通道数)

out_channels=128, # 输出通道数(特征图数量再次翻倍)

kernel_size=3,

padding=1 # 保持尺寸:8x8→8x8(卷积后)→4x4(池化后)

)

self.bn3 = nn.BatchNorm2d(num_features=128)

self.relu3 = nn.ReLU() # 复用激活函数对象(节省内存)

self.pool3 = nn.MaxPool2d(kernel_size=2) # 尺寸减半:8x8→4x4

# ---------------------- 全连接层(分类器) ----------------------

# 计算展平后的特征维度:128通道 × 4x4尺寸 = 128×16=2048维

self.fc1 = nn.Linear(

in_features=128 * 4 * 4, # 输入维度(卷积层输出的特征数)

out_features=512 # 输出维度(隐藏层神经元数)

)

# Dropout层:训练时随机丢弃50%神经元,防止过拟合

self.dropout = nn.Dropout(p=0.5)

# 输出层:将512维特征映射到10个类别(CIFAR-10的类别数)

self.fc2 = nn.Linear(in_features=512, out_features=10)

def forward(self, x):

# 输入尺寸:[batch_size, 3, 32, 32](batch_size=批量大小,3=通道数,32x32=图像尺寸)

# ---------- 卷积块1处理 ----------

x = self.conv1(x) # 卷积后尺寸:[batch_size, 32, 32, 32](padding=1保持尺寸)

x = self.bn1(x) # 批量归一化,不改变尺寸

x = self.relu1(x) # 激活函数,不改变尺寸

x = self.pool1(x) # 池化后尺寸:[batch_size, 32, 16, 16](32→16是因为池化窗口2x2)

# ---------- 卷积块2处理 ----------

x = self.conv2(x) # 卷积后尺寸:[batch_size, 64, 16, 16](padding=1保持尺寸)

x = self.bn2(x)

x = self.relu2(x)

x = self.pool2(x) # 池化后尺寸:[batch_size, 64, 8, 8]

# ---------- 卷积块3处理 ----------

x = self.conv3(x) # 卷积后尺寸:[batch_size, 128, 8, 8](padding=1保持尺寸)

x = self.bn3(x)

x = self.relu3(x)

x = self.pool3(x) # 池化后尺寸:[batch_size, 128, 4, 4]

# ---------- 展平与全连接层 ----------

# 将多维特征图展平为一维向量:[batch_size, 128*4*4] = [batch_size, 2048]

x = x.view(-1, 128 * 4 * 4) # -1自动计算批量维度,保持批量大小不变

x = self.fc1(x) # 全连接层:2048→512,尺寸变为[batch_size, 512]

x = self.relu3(x) # 激活函数(复用relu3,与卷积块3共用)

x = self.dropout(x) # Dropout随机丢弃神经元,不改变尺寸

x = self.fc2(x) # 全连接层:512→10,尺寸变为[batch_size, 10](未激活,直接输出logits)

return x # 输出未经过Softmax的logits,适用于交叉熵损失函数

# 初始化模型

model = CNN()

model = model.to(device) # 将模型移至GPU(如果可用)

上述定义CNN模型中:

1. 使用三层卷积+池化结构提取图像特征

2. 每层卷积后添加BatchNorm加速训练并提高稳定性

3. 使用Dropout减少过拟合

可以把全连接层前面的不理解为神经网络的一部分,单纯理解为特征提取器,他们的存在就是帮助模型进行特征提取的。

三、batch归一化

batch归一化是深度学习中常用的一种归一化技术,加速模型收敛并提升泛化能力,通常位于卷积层后。

卷积操作常见流程:

输入——卷积层——batch归一化——池化层——激活函数——下一层

Flatten——Dense(with Dropout)——Dense(Output)

batchnorm 应该在池化前对空间维度的特征完成归一化,确保归一化的统计量基于足够多的样本,避免池化导致的统计量偏差。

可以解决内部变量偏移问题:

在深度神经网络训练中,深层网络随着前层参数的更新,后层输入分布会发生变化,导致模型需要不断适应新分布,训练难度增加,这就是内部协变量偏移问题。

标准化的作用:

使各层输入分布稳定,让数据处于激活函数比较合适的位置,缓解梯度消失、爆炸问题

数据分布稳定后可以使用更大的学习率,提升训练效率。

深度学习的归一化有2类:

1. Batch Normalization:一般用于图像数据,因为图像数据通常是批量处理,有相对固定的 Batch Size ,能利用 Batch 内数据计算稳定的统计量(均值、方差 )来做归一化。

2. Layer Normalization:一般用于文本数据,本数据的序列长度往往不同,像不同句子长短不一,很难像图像那样固定 Batch Size 。如果用 Batch 归一化,不同批次的统计量波动大,效果不好。层归一化是对单个样本的所有隐藏单元进行归一化,不依赖批次。

ps:这个操作在结构化数据中其实是叫做标准化,但是在深度学习领域,习惯把这类对网络中间层数据进行调整分布的操作都叫做归一化 。

四、特征图

卷积层输出的叫做特征图、通过输入尺寸和卷积核的尺寸、步长可以计算出输出尺寸。

通过可视化中间层的特征图,理解cnn如何从底层特征(如边缘)逐步提取高层语义特征(如物体部件、整体结构)。mlp是不输出特征图的,因为他输出的一维向量无法保留空间维度

特征图代表着在之前的特征提取器上提取到的特征,可以通过Grad-CAM方法来查看模型在失败图像时,特征图所对应的权重是多少,这是深度学习的可解释性

五、调度器

criterion = nn.CrossEntropyLoss() # 交叉熵损失函数

optimizer = optim.Adam(model.parameters(), lr=0.001) # Adam优化器

# 引入学习率调度器,在训练过程中动态调整学习率--训练初期使用较大的 LR 快速降低损失,训练后期使用较小的 LR 更精细地逼近全局最优解。

# 在每个 epoch 结束后,需要手动调用调度器来更新学习率,可以在训练过程中调用 scheduler.step()

scheduler = optim.lr_scheduler.ReduceLROnPlateau(

optimizer, # 指定要控制的优化器(这里是Adam)

mode='min', # 监测的指标是"最小化"(如损失函数)

patience=3, # 如果连续3个epoch指标没有改善,才降低LR

factor=0.5 # 降低LR的比例(新LR = 旧LR × 0.5)

)

学习率调度器,在训练过程中动态调整学习率,可以在快速逼近局部最优

educeLROnPlateau调度器适用于当监测的指标(如验证损失)停滞时降低学习率。是大多数任务的首选调度器,尤其适合验证集波动较大的情况

这种学习率调度器的方法相较于之前只有单纯的优化器,是一种超参数的优化方法,它通过调整学习率来优化模型。

常见的优化器有 adam、SGD、RMSprop 等,而除此之外学习率调度器有 lr_scheduler.StepLR、lr_scheduler.ExponentialLR、lr_scheduler.CosineAnnealingLR 等。

优化器如adam虽然也在调整学习率,但是他的调整是相对值,计算步长后根据基础学习率来调整。但是调度器是直接调整基础学习率。

175

175

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?