GELU的全称是GAUSSIAN ERROR LINEAR UNIT

与Sigmoids相比,像ReLU,ELU和PReLU这样的激活可以使神经网络更快更好地收敛。

此外,Dropout通过将一些激活数乘以0来规范化模型。

以上两种方法共同决定了神经元的输出。但是,两者彼此独立工作。GELU旨在将它们结合起来。

另外,称为Zoneout的新RNN正则化器将输入随机乘以1。

我们希望通过将输入乘以0或1并确定性地获得(激活函数的)输出值来合并所有3个功能。

我们选择这种分布是因为神经元的输入遵循正态分布,尤其是在批归一化之后。

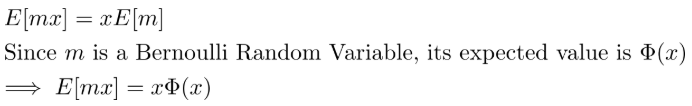

但是任何激活函数的输出都应该是确定性的,而不是随机的。因此,我们找到了转换的期望值。

由于Φ(x)是高斯分布的累积分布,并且通常使用误差函数进行计算,因此我们将高斯误差线性单位(GELU)定义为:

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?