无法使用appenToFile

一 初始

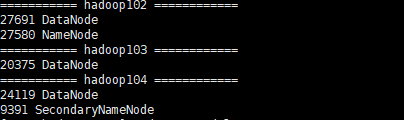

群起hdfs 集群-start-hdfs.sh

hadoop fs -appendToFile 3 /2

20/07/15 09:29:18 INFO hdfs.DFSClient: Exception in createBlockOutputStream

java.io.IOException: Got error, status message , ack with firstBadLink as 172.21.0.7:50010

at org.apache.hadoop.hdfs.protocol.datatransfer.DataTransferProtoUtil.checkBlockOpStatus(DataTransferProtoUtil.java:140)

at org.apache.hadoop.hdfs.DFSOutputStream$DataStreamer.createBlockOutputStream(DFSOutputStream.java:1363)

at org.apache.hadoop.hdfs.DFSOutputStream$DataStreamer.setupPipelineForAppendOrRecovery(DFSOutputStream.java:1188)

at org.apache.hadoop.hdfs.DFSOutputStream$DataStreamer.run(DFSOutputStream.java:455)

20/07/15 09:29:18 WARN hdfs.DFSClient: Error Recovery for block BP-31621113-127.0.0.1-1594741021462:blk_1073741841_1021 in pipeline DatanodeInfoWithStorage[106.55.63.155:50010,DS-37f9b2de-2d

本文介绍了在三台服务器上搭建Hadoop HDFS集群时遇到的fs appendToFile错误,以及如何通过修改hdfs-site.xml配置解决此问题。错误源于节点替换策略,调整相关参数后重启集群。另外,当追加文件失败时,尝试创建新文件上传并追加成功,可能与网络配置有关。

本文介绍了在三台服务器上搭建Hadoop HDFS集群时遇到的fs appendToFile错误,以及如何通过修改hdfs-site.xml配置解决此问题。错误源于节点替换策略,调整相关参数后重启集群。另外,当追加文件失败时,尝试创建新文件上传并追加成功,可能与网络配置有关。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

8526

8526

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?