1. 安装环境

1.1 tensorflow-gpu 对应关系对应关联链接

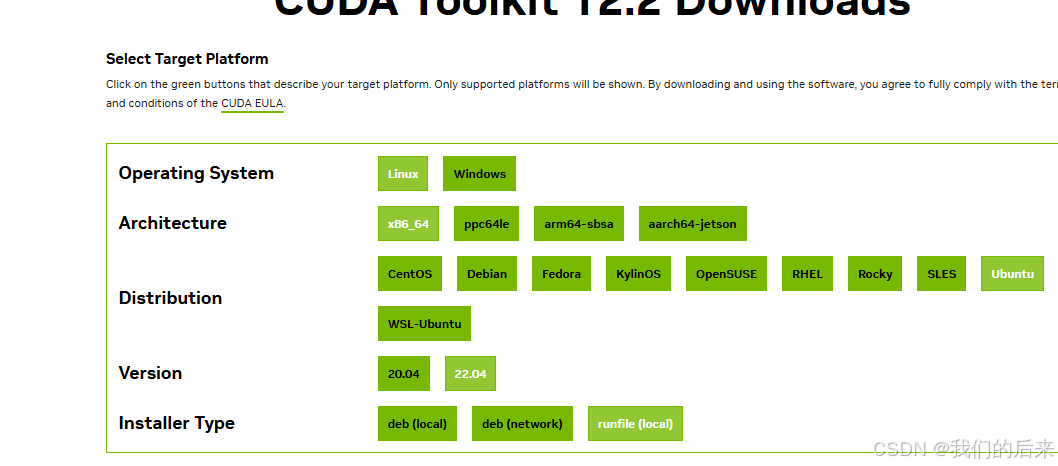

1.2 CUDA 11.8 安装

cuda 下载链接: cuda11.8 下载地址

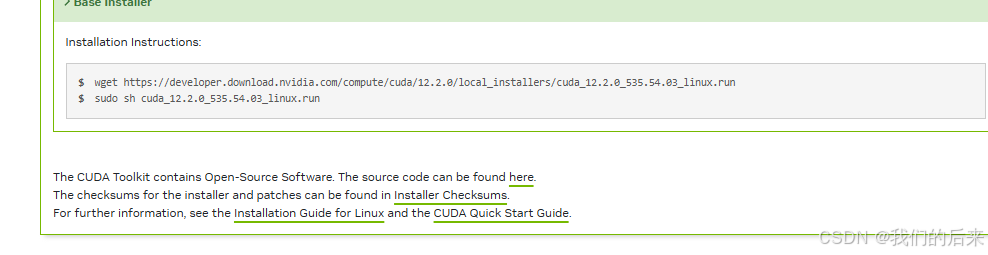

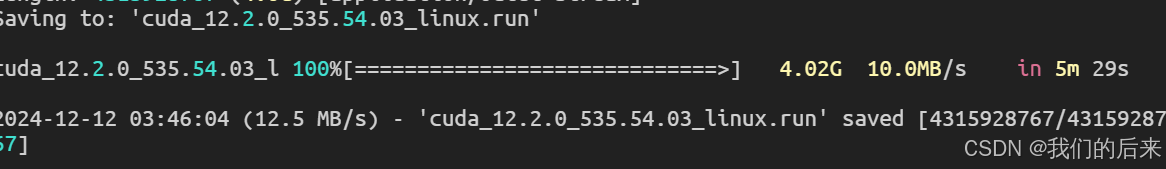

使用官方安装命令即可:

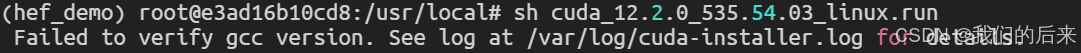

安装报错gcc 版本问题,对比当前版本和 CUDA 的要求。CUDA 11.8 通常需要 GCC 版本在 7.x - 12.x 之间,具体要求请查看 CUDA 安装文档。

安装合适的 GCC 版本,在基于 Debian/Ubuntu 的系统上:

sudo apt update sudo apt install gcc-9 g++-9切换默认 GCC 版本,使用 update-alternatives 工具

sudo update-alternatives --install /usr/bin/gcc gcc /usr/bin/gcc-9 10

sudo update-alternatives --install /usr/bin/g++ g++ /usr/bin/g++-9 10

sudo update-alternatives --config gcc sudo update-alternatives --config g++选择正确的版本后,重新验证:

gcc --version配置完成后,重新运行安装命令:

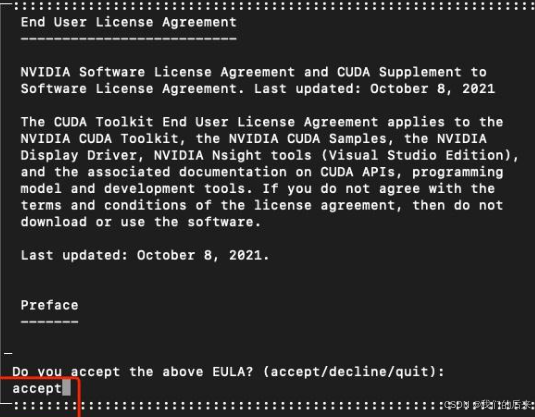

sh cuda_11.8.0_535.54.03_linux.run --override输入 accept

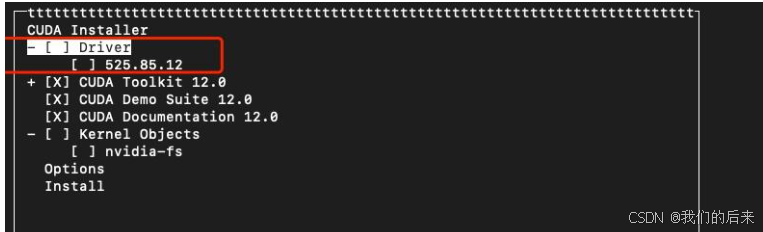

驱动安装过,就取消勾选,直接install 即可。

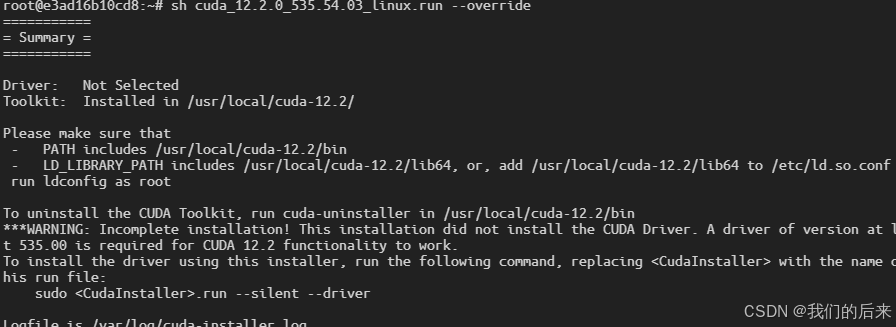

安装成功:

配置变量:

sudo vim ~/.bashrc

在文件末尾添加:

export PATH=/usr/local/cuda-12.0/bin${PATH:+:${PATH}}

export LD_LIBRARY_PATH=/usr/local/cuda-12.0/lib64${LD_LIBRARY_PATH:+:${LD_LIBRARY_PATH}}

export CUDA_HOME=/usr/local/cuda-12.0更新系统环境:

source ~/.bashrc

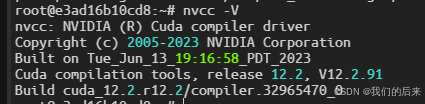

sudo ldconfig验证 输入nvcc -V

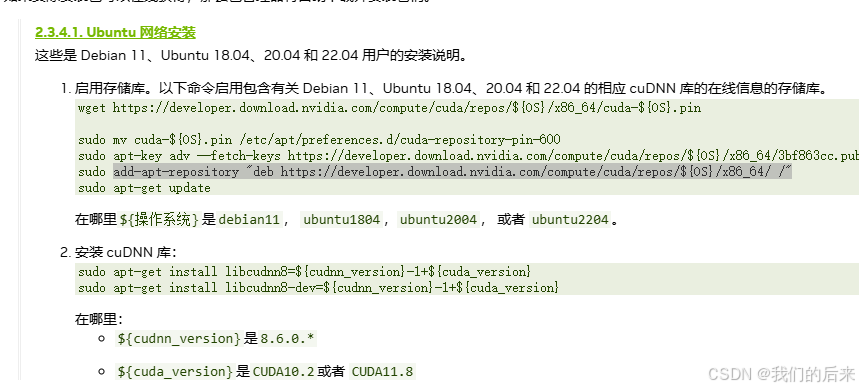

1.3 CUDNN安装

1.3.1 安装链接cudnn 8.6

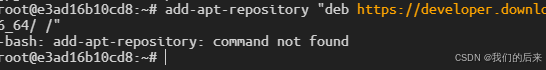

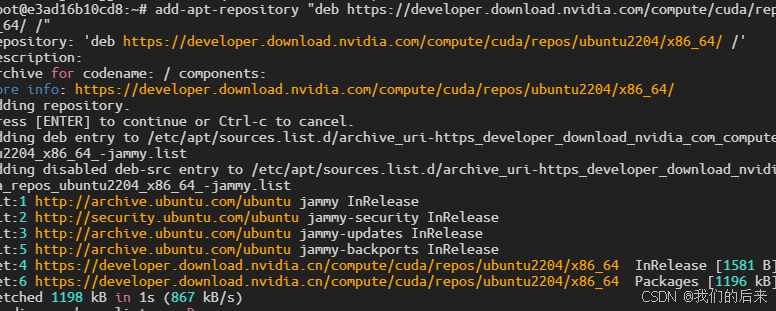

1.3.2 提示add-apt not find

运行以下命令安装 software-properties-common 包

sudo apt-get update sudo apt-get install -y software-properties-common再次安装即可:

2. 安装hailo_dataflow_compiler

执行之前pyhon 创建虚拟环境 python -m venv hef_demo

激活虚拟环境: source her_demo/bin/activate

一下均在hef_demo 环境下运行

pip 换源: 换源链接

pip config set global.index-url https://pypi.tuna.tsinghua.edu.cn/simple2.1 下载链接:hailo_dataflow_compiler

执行安装hailo 编译环境

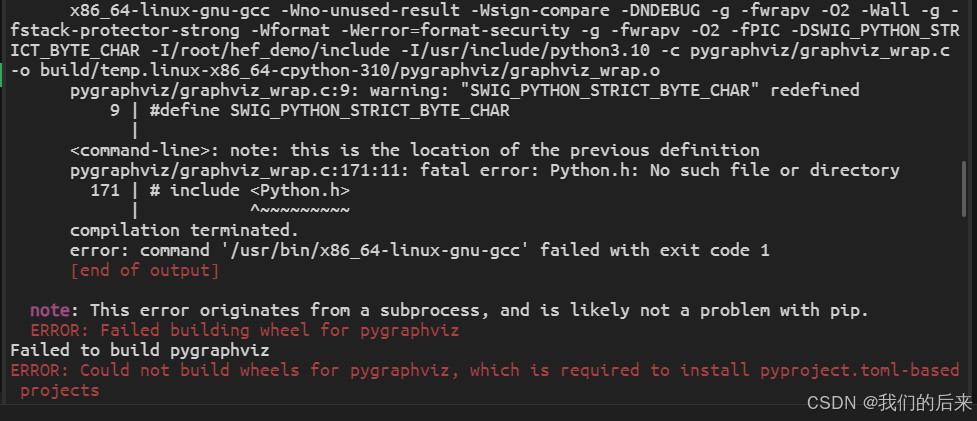

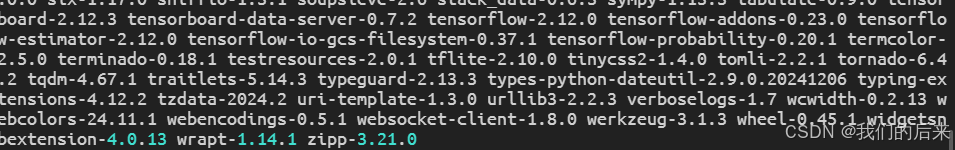

pip install hailo_dataflow_compiler-3.29.0-py3-none-linux_x86_64.whl提示报错:

安装一些必要的库:

apt install python3.10-dev

apt install gcc

apt install libgraphviz-dev

apt install python3-pip python3-dev

pip install pygraphviz

#验证

dpkg -L python3.10-dev再次执行即可:

2.2 安装hailo_model_zoo

下载地址:hailo_model_zoo

执行:

pip install hailo_model_zoo-2.13.0-py3-none-any.whl2.3 执行onnx-> hef demo

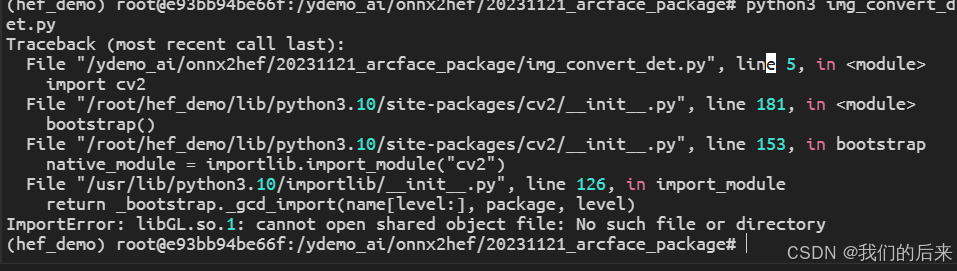

报错提示: ImportError: libGL.so.1: cannot open shared object file: No such file or directory

解决方法: 安装libgl1 库即可

解决方法: 安装libgl1 库即可

apt install libgl1

5495

5495

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?