Semantically Multi-modal Image Synthesis

作者:Zhen Zhu, Zhiliang Xu, Xiang Bai{Huazhong University of Science and Technology}, Ansheng You{Peking University}

会议:CVPR 2020

论文:https://openaccess.thecvf.com/content_CVPR_2020/papers/Zhu_Semantically_Multi-Modal_Image_Synthesis_CVPR_2020_paper.pdf

代码:https://github.com/Seanseattle/SMIS

项目界面(包含视频):https://seanseattle.github.io/SMIS/

Abstract

本文主要研究语义多模态图像合成(SMIS)任务,即在语义层面上生成多模态图像。先前的工作试图使用多个特定类的生成器,但它只能在具有少量类的数据集上的使用。相反,我们提出了一种新的Group Decreasing Network(GroupDNet),它利用生成器中的分组卷积group convolutions,并逐步减少解码器中卷积的分组数量。因此,GroupDNet在将语义标签翻译成自然图像方面具有更强的可控性,并且对于具有许多类别的数据集具有看似合理的高质量输出。在几个具有挑战性的数据集上的实验证明了GroupDNet在执行这些任务上的优越性。我们还表明,GroupDNet能够执行各种有趣的合成应用。代码和模型在:https://github.com/Seanseattle/SMIS。

1. Introduction

语义图像合成,即把语义标签翻译成自然图像,在现实世界中有许多应用,引起了社会的广泛关注。这本质上是一对多映射问题。无数可能的自然图像对应一个单一的语义标签。先前的工作使用了不同的策略来完成任务:采用可变自动编码器的思想[36,56,2,11],在训练时引入噪声[19],构建多个子网[10]并包括实例级特征嵌入[41]等。虽然这些方法在提高图像质量和扩展更多应用方面取得了非凡的成就,但我们更进一步,特别关注特定的多模态图像合成任务,这增加了控制生成结果的灵活性。

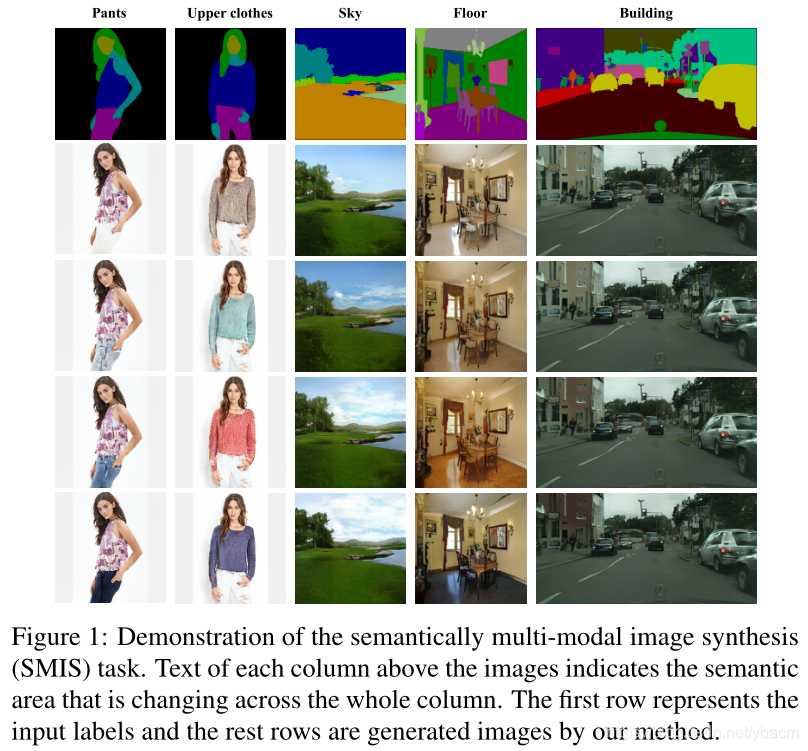

想象一下从人像语义图创建内容的场景。 借助语义到图像的转换模型,可以将解析图转换为真实的人像。总体看起来不错,但是上身的衣服不适合你的口味。那么问题来了——要么这些模型不支持多模态综合,要么当这些模型改变了上装,其他部分也相应地改变了。这两者都不符合你的意图。总之,这种用户可控的内容创建场景可以被解释为执行一项任务,该任务在语义级别上产生多模态结果,而其他语义部分未被触及。我们把这个任务概括为:语义多模态图像合成(Semantically Multi-modal Image Synthesis, SMIS)。如图1所示,对于每种语义,我们都有其特定的控制器。通过调整特定类别的控制器,仅相应地改变相应的区域。

该任务的一个直观解决方案是为不同的语义构建不同的生成网络,然后通过融合不同网络的输出来生成最终的图像。与[10]的整体方案颇为相似,侧重于人像编辑。然而,这种类型的方法很快会面临性能下降、训练时间和计算资源消耗线性增加的问题。

为了使网络更加优雅,我们创造性地用群卷积代替生成器中的所有常规卷积,从而将生成过程统一在一个模型中。当卷积的群数等于类的群数时,我们的策略在数学上和功能上等价于[10]。然而,我们采用的另一个策略是设置不同的方式——我们在forwarding的过程中减少解码器卷积中的组数。**我们观察到不同的类别之间有内在的相互关系,例如,草和树叶的颜色应该非常相似。在这种情况下,逐步合并这些组给模型足够的能力来建立不同类别之间的相互关系,从而提高整体图像质量。**此外,当数据集的类数量很大时(例如,ADE20K [53]),这种策略也大大减轻了计算消耗问题。我们把使用了这两种策略的发生器称为群递减网络(GroupDNet)。为了评估GroupDNet在SMIS任务中的表现,我们提出了两个新的度量标准,称为mean Class-Specific Diversigy(mCSD)和mean Other-Class Diversity(mOCD)。当一些语义部分变化很大,但其他部分保持不变时,mCSD度量往往保持较高的值,mOCD往往较低。

2. Related work

Generative models.

Conditional image synthesis.

Multi-modal label-to-image synthesis.

Group convolution. 以前的工作[25,44,51,32,43]表明,群卷积有利于降低计算复杂度和模型参数,因此它们已广泛应用于轻型网络。[32]提到组卷积的过度使用会导致较大的内存访问成本。尽管在网络中使用具有小分组甚至没有分组卷积的分组卷积是理想的,但是我们在实验中表明,在解码器中完全避免分组卷积对于SMIS任务的性能是有问题的。此外,我们的减少组数策略大大缓解了巨大的媒体访问控制问题,使其适用于现实世界的应用。

3. Semantically multi-modal image synthesis

3.1. Problem definition.

让M表示一个语义分割掩码。假设数据集中有C个语义类。H和W分别代表图像的高度和宽度。作为一种非常简单的进行标签到图像转换的方式,生成器G需要M作为条件输入来生成图像。**然而,为了支持多模态生成,我们需要另一个输入源来控制生成多样性。**通常,我们使用一个编码器来提取一个潜码Z作为控制器,其灵感来自于VAE [24]。在接收到这两个输入后,图像输出 O O O可以通过 O = G ( Z , M ) O = G(Z,M) O=G(Z,M)产生。然而,在语义多模态图像合成(SMIS)任务中,我们的目标是通过扰动特定类潜码class-specific latent code来产生语义多样的图像。

3.2. Challenge

**对于SMIS任务,关键是将潜码分成一系列特定类别的潜码,每个潜码只控制特定语义类别的生成。**传统的卷积编码器不是最佳选择,因为所有类别的特征表示都在潜在代码内部纠缠。即使我们有特定于类的潜在代码,如何利用这些代码仍然是个问题。正如我们将在实验部分说明的那样,简单地用特定类代码替换SPADE [36]中的原始潜在代码,处理SMIS任务的能力有限。这一现象启发我们,我们需要在编码器和解码器中进行一些架构修改,以更有效地完成任务。

3.3. GroupDNet

基于以上分析,我们现在给出更多关于这个任务的解决方案的细节——Group Decreasing Network。GroupDNet的主要体系结构是从SPADE [36]中获得的设计灵感,是因为SPADE在标签到图像生成任务中的卓越性能。GroupDNet的一个主要改进是将典型卷积替换为组卷积[25],以实现特定类别的可控性。在下文中,我们将首先简要概述我们的网络架构,然后描述我们在网络的不同组件中所做的修改。

group convolutions 分组卷积:

https://zhuanlan.zhihu.com/p/65377955

Overview. 从图2可以看出,GroupDNet包含一个编码器和一个解码器。受VAE [24]和SPADE [36]思想的启发,编码器E在训练过程中产生一个假定遵循高斯分布N(0,1)的潜码Z。测试时,编码器E被丢弃。从高斯分布中随机抽样的代码代替了Z。为了实现这一点,我们使用重新参数化技巧re-parameterization trick[24]来实现训练期间的可微损失函数。具体而言,编码器通过两个完全连接的层来预测均值向量和方差向量,以表示编码的分布。编码分布和高斯分布之间的差距可以通过施加KL-散度损失来最小化:

其中 D K L D_{KL} DKL代表KL散度。

Encoder . 让 M c M_c Mc为类c的二进制掩码, X ∈ R H × W X ∈ R^{H×W} X∈RH×W为输入图像。通过将X拆分为不同语义类的不同图像,我们有:

此操作减少了编码器处理特征解缠的工作,使得编码特征更加精确。编码器的输入是这些图像的拼接: S = c a t c X c S =\mathop{cat}\limits_ c X_c S=ccatXc。编码器E内的所有卷积都有相同的组数,也就是c类的总数。从输入端和架构端,我们解耦不同的类,使之相互独立。结果,编码的潜码Z由

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1730

1730

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?