一、资源限制对Pod调度的影响

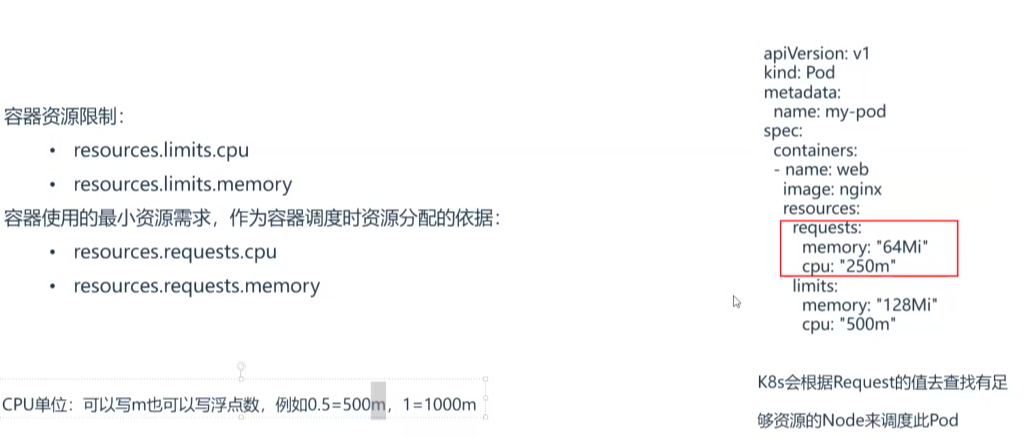

1. 资源限制配置示例

1)CPU单位换算

- 单位换算规则:

- 1核CPU = 1000m(毫核)

- 2核CPU = 2000m

- 0.5核 = 500m

- 0.1核 = 100m

- 表示方式:

- 可直接使用浮点数(如0.5)

- 也可使用毫核单位(如500m)

- 两者等价:

0.5=500m0.5=500m0.5=500m

,1=1000m1=1000m1=1000m

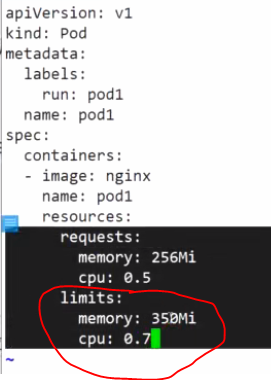

2)资源配置参数

- requests:

- 容器请求的基础资源(预留资源)

- 调度依据:K8s根据requests值选择有足够资源的Node

订阅专栏 解锁全文

订阅专栏 解锁全文

1227

1227

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?