ECA-Net:深度卷积神经网络中的高效通道注意力机制

在深度学习领域,特别是在深度卷积神经网络(DCNN)中,注意力机制已经成为提升模型性能的关键技术之一。其中,ECA模块(Efficient Channel Attention)作为一种新型的通道注意力机制,凭借其高效性和自适应特性,为网络提供了更强大的特征表示能力。本文将详细介绍ECA模块的工作原理、独特优势,并通过公式总结其核心机制。

一、通道注意力的作用

在深度卷积神经网络中,通道注意力机制的主要作用在于增强模型对重要特征的关注,从而提升模型在各种视觉任务上的性能。通过引入通道注意力,模型可以学习到每个通道特征的重要性,并据此调整不同通道的输出权重,使得网络更加关注对当前任务有利的特征。

二、ECA模块的机制

ECA模块的核心思想是通过一维卷积来捕捉通道间的依赖关系。与传统的注意力机制相比,ECA模块避免了复杂的降维和升维过程,从而实现了高效和轻量级的特性。

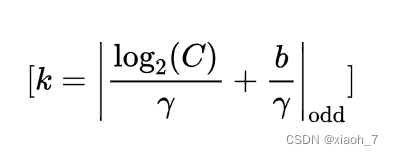

具体来说,ECA模块首先根据通道数自适应地计算一维卷积的核大小k。核大小的计算公式如下:

这个公式用于计算一维卷积的核大小k,其中C是输入特征的通道数,(\gamma)和b是超参数。取绝对值并向下取整到最近的奇数是为了确保核大小是奇数。

得到核大小k后,ECA模块将一维卷积应用于输入特征上,从而学习每个通道相对于其他通道的重要性。这个过程可以用以下公式表示:

![[ \text{out} = \text{Conv1D}_{k}(\text{in}) ]](https://i-blog.csdnimg.cn/blog_migrate/7b7aceb2f9df5010c5aa7ea607ca5792.png)

这个公式表示通过一维卷积操作(核大小为k)将输入特征in转换为输出特征out。Conv1D_{k}表示核大小为k的一维卷积操作。

三、ECA模块的独特优势

1. 计算高效

由于ECA模块避免了复杂的降维和升维过程,以及使用了简单的一维卷积操作,因此其计算效率非常高。这使得ECA模块能够在不增加显著计算负担的情况下,为模型带来性能提升。

2. 保留信息完整性

与传统的注意力机制相比,ECA模块无需进行降维和升维的操作,从而保留了原始通道特征的信息完整性。这有助于模型更好地利用通道间的依赖关系,提升特征表示能力。

3. 自适应核大小

ECA模块能够根据通道数自适应地调整一维卷积的核大小,使其能够灵活地捕捉不同范围内的通道依赖性。这种自适应机制使得ECA模块在不同规模的网络和不同深度的层次中都能有效工作。

4. 易于集成

由于其轻量级和高效的特性,ECA模块可以轻松地嵌入到任何现有的CNN架构中。无需对原始网络架构进行大的修改,即可为模型带来性能提升。这使得ECA模块成为一种简单而有效的网络优化手段。

五、代码实现

import torch

from torch import nn

from torch.nn import init

# 定义ECA注意力模块的类

class ECAAttention(nn.Module):

def __init__(self, kernel_size

本文详细介绍了ECA-Net,一种在深度学习特别是DCNN中通过高效和自适应的通道注意力机制提升模型性能的技术。ECA模块通过一维卷积捕捉通道依赖,具有计算高效、信息完整保留和自适应核大小等优势,适用于各种CNN结构的优化。

本文详细介绍了ECA-Net,一种在深度学习特别是DCNN中通过高效和自适应的通道注意力机制提升模型性能的技术。ECA模块通过一维卷积捕捉通道依赖,具有计算高效、信息完整保留和自适应核大小等优势,适用于各种CNN结构的优化。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

991

991