Model Pruning 是一种模型压缩方法,对深度神经网络的稠密连接引入稀疏性,通过将“不重要”的权值直接置零来减少非零权值数量.

在 Optimal Brain Damage【2】中,使用对角 Hessian 逼近计算每个权值的重要性,重要性低的权值被置零,然后重新训练网络。

在 Optimal Brain Surgeon【3】中,使用逆 Hessian 矩阵计算每个权值的重要性,重要性低的权值被置零,剩下的权值使用二阶泰勒逼近的 loss 增量更新。

基于幅度的权值剪枝方法【4】,该方法将权值取绝对值,与设定的 threshhold 值进行比较,低于门限的权值被置零。基于幅度的权值剪枝算法计算高效,可以应用到大部分模型和数据集。

TF 代码实现

TensorFlow 代码链接:https://github.com/tensorflow/tensorflow/tree/master/tensorflow/contrib/model_pruning/examples

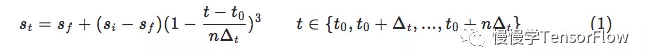

研究发现稀疏度不宜从一开始就设置最大,这样容易将重要的权值剪掉造成无法挽回的准确率损失,更好的方法是渐进稀疏度,从初始稀疏度 Si(一般为 0 )开始,逐步增大到最终稀疏度 Sf,这期间二进制掩模变量 mask 经历了 n 次更新,每次更新时的门限由当时的稀疏度决定,稀疏度由如下公式计算得到:

博客介绍了Model Pruning这一模型压缩方法,通过将深度神经网络中‘不重要’权值置零减少非零权值数量。提及Optimal Brain Damage、Optimal Brain Surgeon和基于幅度的权值剪枝等方法,给出TensorFlow代码链接,还指出采用渐进稀疏度更好。

博客介绍了Model Pruning这一模型压缩方法,通过将深度神经网络中‘不重要’权值置零减少非零权值数量。提及Optimal Brain Damage、Optimal Brain Surgeon和基于幅度的权值剪枝等方法,给出TensorFlow代码链接,还指出采用渐进稀疏度更好。

5971

5971

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?