解决ClickHouse的去重ReplacingMergeTree表引擎数据无法自动同步问题

问题描述:

建立了2个分片,每个分片下面有2个节点,互相做为备份,但是实际中,副本数据并没有在后台同步,一般zk会进行异步同步

原因分析:

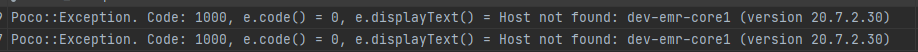

经调查,发现是Host not found,是因为host的ip没有和hostname做好映射

解决方案:

在每个clickhouse节点的/etc/hosts里面加入除本机外的hostname

10.100.*.100 dev-emr-core1

10.100.*.101 dev-emr-core2

10.100.*.110 dev-emr-core3

10.100.*.111 dev-emr-core4

当使用ClickHouse的ReplacingMergeTree表引擎时,遇到数据副本在分片间未自动同步的问题,原因是主机名与IP映射不正确。通过在每个节点的/etc/hosts文件中添加其他节点的hostname和IP地址,可以解决Hostnotfound问题,从而实现数据的后台同步。

当使用ClickHouse的ReplacingMergeTree表引擎时,遇到数据副本在分片间未自动同步的问题,原因是主机名与IP映射不正确。通过在每个节点的/etc/hosts文件中添加其他节点的hostname和IP地址,可以解决Hostnotfound问题,从而实现数据的后台同步。

7192

7192

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?