本文主要介绍一下spark streaming,从以下三个方面来介绍:

- Spark Streaming设计

- Spark Streaming与Storm的对比

- 从“Hadoop+Storm”架构转向Spark架构

Spark Streaming设计

Spark Streaming可整合多种输入数据源,如Kafka、Flume、HDFS,甚至是普通的TCP套接字。经处理后的数据可存储至文件系统、数据库,或显示在仪表盘里,如下图所示:

Spark Streaming的基本原理是将实时输入数据流以时间片(秒级)为单位进行拆分,然后经Spark引擎以类似批处理的方式处理每个时间片数据,如下图缩手:

spark streaming设计(秒级)

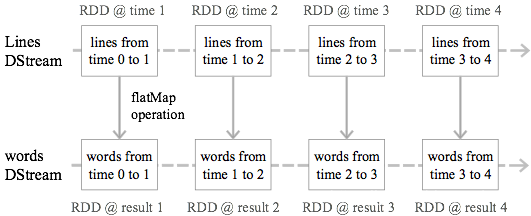

Spark Streaming最主要的抽象是DStream(Discretized Stream,离散化数据流),表示连续不断的数据流。在内部实现上,Spark Streaming的输入数据按照时间片(如1秒)分成一段一段,每一段数据转换为Spark中的RDD,这些分段就是Dstream,并且对DStream的操作都最终转变为对相应的RDD的操作。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1147

1147

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?