本文详细解析AI生态四大核心概念:LLM作为基础"大脑",RAG提供外部知识库解决时效性问题,MCP作为标准化接口连接AI与工具,Agent整合前三者实现自主任务执行。这四者共同构成了从语言理解到实际执行的完整AI工作流,使AI从聊天工具进化为能解决问题的生产力工具。理解这些概念及其关系,是掌握现代AI应用开发的关键。

首先,针对没时间看完的朋友,先上个“省流版”:

LLM (large language model,大语言模型) = 最强大脑。能思考,会说话,但有点像个刚毕业的天才,啥都懂,问啥都能白话上两句,但有可能会瞎编,也不能直接干活。

RAG (Retrieval-augmented generation,检索增强生成) = 外挂资料库。给“大脑”递小抄,让他能引经据典,而不是瞎编乱造。

MCP (Model Context Protocol,模型上下文协议) = 万能转接头(USB)。让“大脑”和各种工具无痛连接,规范了交互方式。

Agent (智能体) = 全能打工人。有了大脑、资料和工具,他就能自己接任务、定计划、开干,直到把事儿办成

一句话总结这四者的关系:

Agent 这个“打工人”,用着 LLM 这个“大脑”,翻着 RAG 给的“资料”,通过 MCP 这个“标准接口”去操作各种工具,最终完成你交代的任务。

听懂掌声。

没听懂也不要紧,接下来细说这些名词具体都是干嘛的。

1、 LLM:一切的起点——人造天才大脑

大语言模型这东西,就是最近这两年,我们所谈论的AI的起点。

可以说,从GPT-3.5破圈进入普通人的视野开始,人类就正式进入了 LLM 时代。

你可以把现在的各种大语言模型想象成一个刚毕业的天才大学生。

怎么个天才法?

他读过人类历史上几乎所有的书(海量数据预训练),脑子里装满了人类从古到今的所有知识。所以你跟他聊天,他上知天文、下知地理,能引经据典,能写诗、能写代码、能做总结……

这就是LLM最牛逼的地方:强大的自然语言理解和生成能力。这放在几年前还是我们都想都不敢想的事情。

目前我们常见的大模型:

海外:GPT、Claude、Gemini、Grok…

国内:Qwen(通义)、DeepSeek、Kimi、智谱 GLM…

但问题来了。

大模型虽然聪明,懂得多,但有两个致命弱点:

知识有“保质期”:他只知道自己“毕业”前(训练数据截止日期前)的事儿,你问他昨天发生了啥,他一脸懵逼,然后就开始说胡话,这也就是我们常说的“幻觉”。

是个“嘴炮王者”:只会说,不会干。你让他查个天气,他只能告诉你“我建议你使用天气查询工具”,但他自己动不了手。

所以,光有一个LLM大脑,还远远不够,它还需要其他支援,才能变得更加强大。

2、RAG:给智慧大脑一本可以随时更新的百科全书

天才大学生光有脑子不行啊,一问最新的事就露馅,或者问到你公司的内部机密,他更不可能知道。

咋办?

最简单的做法,就是把这些特殊知识编成提示词,告诉给大模型。但局限性也很明显,首先这个提示词得不断去维护,另外所有知识如果不加分类每次都喂给大模型,不光占用token,而且如果提示词内容过大,大模型也会找不到重点。

还有一种做法是,用自定义的数据,训练自己的大模型。这就好比给市面上通用的大模型重新洗了一次脑,把你想让了解的特殊知识灌给他。

但这种做法缺点也很明显,成本高、依赖技术能力。对于普通中小公司或者个人来说,很难完成。

那有没有更加方便友好适合普通公司普通人的方式呢?这就是RAG。

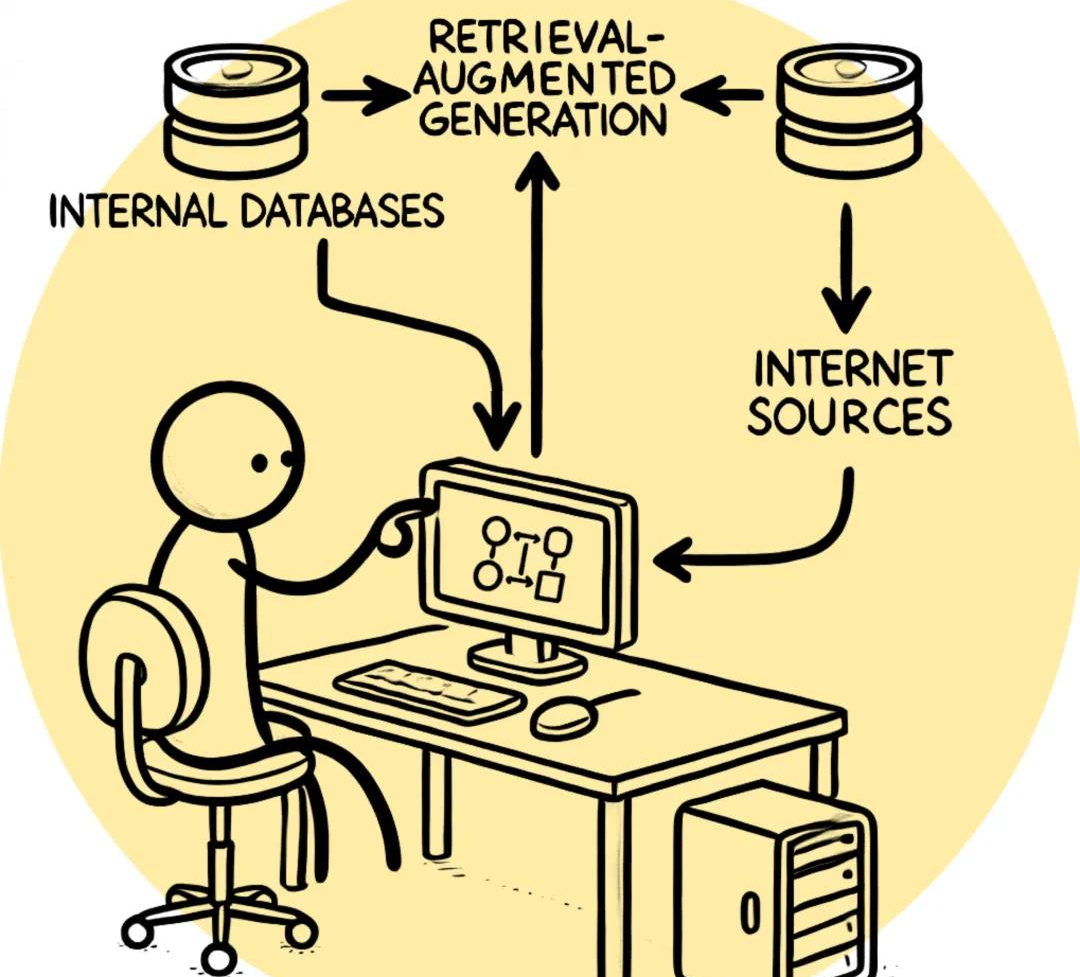

RAG的全称叫“检索增强生成”,听着很唬人,干的事儿特简单:

让LLM在回答问题前,先去你指定的资料库里“翻翻书”。说白了就是给他递小抄、发参考书。

这本书,可以是:

最新的网页搜索结果

你公司的内部知识库、PDF文档

你的个人笔记、聊天记录

这个过程,就跟我们考试开卷一模一样。

你提问:“帮我总结下我们公司上周的销售会议纪要。”

RAG启动:AI 先去你公司的会议纪要数据库里,找到相关的几段话,连同你的问题一起提供给 AI。

LLM作答:AI 把你的问题和搜到的纪要内容,一起在脑子里过一遍,然后生成一段条理清晰的总结,甚至还能告诉你“该结论出自第3页第5段”。

看到没?RAG解决了LLM两大痛点。

减少胡说八道:答案有据可查,不再是AI瞎猜,而是“根据资料显示”。

接入私有知识:让AI变成了超级懂你,只为你服务的私人专家。

可以说,有了RAG,我们就能让 LLM 这个天才大脑从“凭记忆瞎聊”变成了“有理有据的开卷学霸”了。

3、 MCP:没有规矩,不成方圆的“USB协议”

好了,大脑有了,资料也有了。

但新的问题又来了——怎么让 LLM 真正动手干活呢?

前面说了,LLM只会打嘴炮,问它今天天气如何,它只会说“你应该去查天气预报”,但他自己不会查啊。

后来OpenAI搞了个Function Calling,这个就厉害了,能让LLM 知道我手头都有哪些可用工具,然后能分析用户的问题输出一个标准指令。

比如你问大模型:“今天天气怎么样?”,同时告诉大模型我手头的工具有“天气查询”、“计算器”、“地图查询”,大模型分析了你的问题后就知道需要用“天气查询”工具,于是返回 { “工具名”: “天气查询”, “参数1”: “北京”, “参数2”:“2025-08-21” }。

外面的程序一收到这个指令,就知道,哦,该去调用计算器了。

于是乎,全世界的开发者都高潮了,开始疯狂利用LLM这个能力,开发对接各种工具给大模型。

紧接着灾难就来了:OpenAI的接口是一套标准,Google是另一套,Anthropic又是另一套… 各种工具的API,输入输出格式也各有各的规范。

这就好比回到了手机充电器的远古时代,诺基亚用圆孔,摩托罗拉用T形口,三星又是一个样。每个模型要用一个工具,都得单独做个转接头。

结果就是乱成一锅粥,多个模型对接多个工具就要写M×N 套代码,开发和维护成本高到爆炸!

这时候,一个带头大哥站了出来,它就是Anthropic(Claude的公司)。

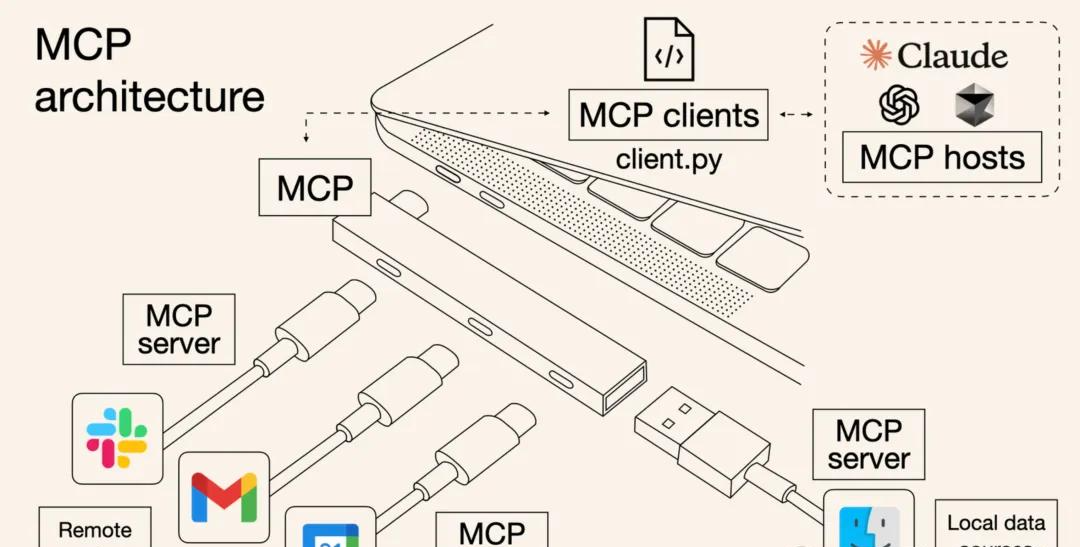

大哥已经发现苗头不对了,于是牵头搞了个MCP 协议,于2024年11月推出,很快就得到了各大厂商的一致性认可。

MCP这玩意说白了,它不是一个具体的软件,也不是一个什么新技术、新模型,它就是一套行业标准,跟USB接口、蓝牙协议一个性质,只不过这一次是给大模型与工具之间定义的标准。

MCP规定了,以后模型和工具之间,怎么打招呼(能力发现),怎么传递指令(消息格式),怎么报告错误(错误规范),都得按这个统一的格式来。

MCP就是AI世界的“USB协议”。

有了它,任何一个工具,只要符合MCP标准,就能像U盘一样,插到任何一个支持MCP的Agent上,即插即用。

这下,AI 工具生态一下子变得清爽了!

mcp.so,mcpmarket 等这样的MCP服务提供商也应运而生,开发者可以在日益庞大的MCP市场,非常便捷地给大模型配上手和脚。

由此可见,未来随着MCP 生态的不断发展,以后提供各种 API 工具的厂商,除了提供 API 接口外,都还会提供一个 MCP Server,来供 AI 智能体使用。

可以说,MCP的诞生,是 AI 工程化落地的一大步,它让 AI 在“能用工具”的基础上更进一步,变成了“能方便、稳定、规模化地使用工具”。

4、 Agent智能体:当下 AI 最终形态——能独当一面的打工人

好了,终于到了近半年以来讨论最火热的Agent 了。

当我们的天才大脑(LLM),能开卷考试(RAG),还能通过标准接口(MCP)熟练使用各种工具时……

一个全新的物种诞生了。

它就是Agent,智能体。

在OpenAI 推出 Function Call 之后,Agent 便开始发展。直到今年(2025年)的春天,Manus 团队发布了通用智能体产品,将 Agent 设计模式推到一个前所未有的高潮。

这玩意不再单纯是一个简单的聊天机器人了,而是一个能独立完成任务的“项目经理”或者“全能打工人”。

你只需要告诉他一个目标,比如:“帮我调研一下A公司最近的动态,整理成报告发给我。”

然后,Agent就会自己开始加班加点干活了:

思考与拆解:(大脑LLM启动) “嗯,这个任务得分几步。1)上网搜A公司最近的新闻。2)去数据库查一下他们的财报。3)把找到的所有资料做个总结。4)输出成报告格式。”

选择与执行:(通过MCP调用工具) “第一步,调用网页搜索工具……好了,新闻找到了。第二步,调用数据库查询工具.……财报也到手了……”

整合与生成:(再次动用大脑LLM) “OK,所有资料齐了,再让 LLM 给我按要求写个总结报告。”

交付:最终,一份完整的报告就交到你手上了。

整个过程,在外界看来,AI Agent 它会自己分析任务、自己规划、自己操作、自己检查,直到把事儿办妥。

实际上,Agent 可以看成是传统工作流 + AI 推理决策有机结合的新产物。

将过去,通过工程化很难做的语意分析决策部分,交给AI 来处理,让 AI 来推动整个流程上各个节点的流转和触发。这就让工作流有了像人一样的“智慧”。

这,便是AI Agent的真正威力。

目前,从n8n、Dify,coze扣子空间这种工作流平台,到ChatGPT、豆包这些产品级APP里内置的画图、分析文件功能,差不多都是这个思路,本质上都是Agent,只不过形态不同。

它让AI从那个只会聊天、作图的小伙伴,变成了一个能为你解决复杂问题的得力干将。

最后,我们再把这四个概念串成一个终极比喻:

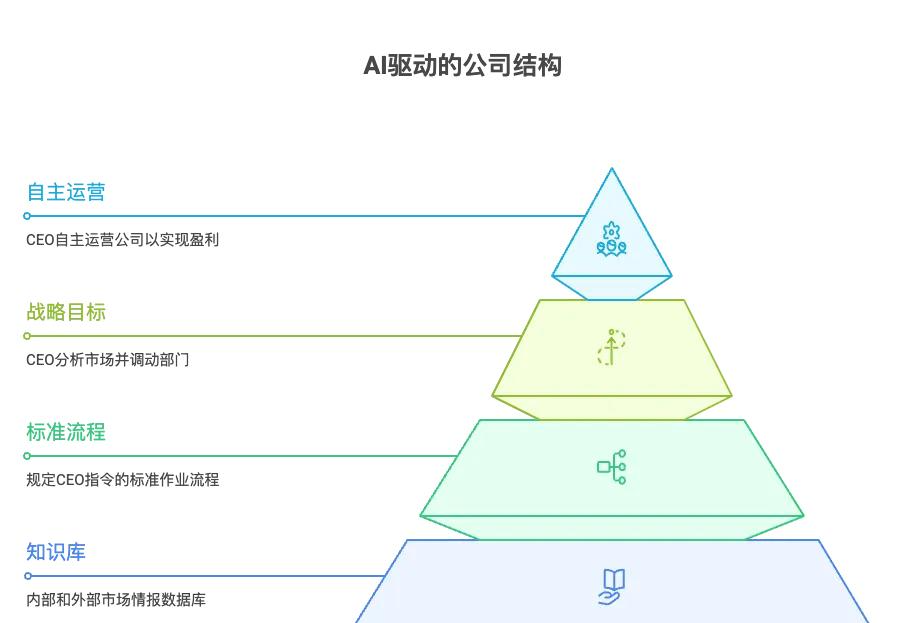

假设你要创办一家AI 驱动的全自动公司,那么:

LLM:是你花重金请来的那位天才CEO,拥有顶级的商业头脑和战略眼光。

RAG:是你交给CEO的公司内部知识库和外部市场情报数据库,让他决策时有据可依。

MCP:是你制定的全公司标准作业流程(SOP),规定了CEO如何向财务、销售、生产等各个部门(工具)下达标准化的指令。

Agent:就是这位CEO自主运营公司的整个过程。他根据你的战略目标(指令),自己分析市场(RAG)、调动各个部门(MCP调用工具),最终实现盈利(完成任务)。

一句话总结:LLM 是核心的智力,而 RAG、MCP、Agent,则是在这个智力基础上,搭建起来的知识体系、协作体系和执行体系。

我们正在亲历一个前所未有的时代。

AI 不再只是一个能聊天的玩具,它正在变成一个真正能干活、能解决问题的强大生产力。

而这,仅仅是AI 革命的开始。

那么,如何系统的去学习大模型LLM?

作为一名从业五年的资深大模型算法工程师,我经常会收到一些评论和私信,我是小白,学习大模型该从哪里入手呢?我自学没有方向怎么办?这个地方我不会啊。如果你也有类似的经历,一定要继续看下去!这些问题啊,也不是三言两语啊就能讲明白的。

所以我综合了大模型的所有知识点,给大家带来一套全网最全最细的大模型零基础教程。在做这套教程之前呢,我就曾放空大脑,以一个大模型小白的角度去重新解析它,采用基础知识和实战项目相结合的教学方式,历时3个月,终于完成了这样的课程,让你真正体会到什么是每一秒都在疯狂输出知识点。

由于篇幅有限,⚡️ 朋友们如果有需要全套 《2025全新制作的大模型全套资料》,扫码获取~

为什么要学习大模型?

我国在A大模型领域面临人才短缺,数量与质量均落后于发达国家。2023年,人才缺口已超百万,凸显培养不足。随着AI技术飞速发展,预计到2025年,这一缺口将急剧扩大至400万,严重制约我国AI产业的创新步伐。加强人才培养,优化教育体系,国际合作并进是破解困局、推动AI发展的关键。

👉大模型学习指南+路线汇总👈

我们这套大模型资料呢,会从基础篇、进阶篇和项目实战篇等三大方面来讲解。

👉①.基础篇👈

基础篇里面包括了Python快速入门、AI开发环境搭建及提示词工程,带你学习大模型核心原理、prompt使用技巧、Transformer架构和预训练、SFT、RLHF等一些基础概念,用最易懂的方式带你入门大模型。

👉②.进阶篇👈

接下来是进阶篇,你将掌握RAG、Agent、Langchain、大模型微调和私有化部署,学习如何构建外挂知识库并和自己的企业相结合,学习如何使用langchain框架提高开发效率和代码质量、学习如何选择合适的基座模型并进行数据集的收集预处理以及具体的模型微调等等。

👉③.实战篇👈

实战篇会手把手带着大家练习企业级的落地项目(已脱敏),比如RAG医疗问答系统、Agent智能电商客服系统、数字人项目实战、教育行业智能助教等等,从而帮助大家更好的应对大模型时代的挑战。

👉④.福利篇👈

最后呢,会给大家一个小福利,课程视频中的所有素材,有搭建AI开发环境资料包,还有学习计划表,几十上百G素材、电子书和课件等等,只要你能想到的素材,我这里几乎都有。我已经全部上传到优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

相信我,这套大模型系统教程将会是全网最齐全 最易懂的小白专用课!!

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?