📘 一、大语言模型是什么?

LLM(Large Language Model,大语言模型)是指基于深度学习、拥有大量参数(通常为十亿级以上)、在海量文本数据上进行训练的自然语言处理模型。它的目标,是让机器理解语言、生成语言、参与任务型语言交互。

这类模型的输入是自然语言文本,输出也是自然语言文本,能力涵盖写作、翻译、摘要、代码生成、问答、逻辑推理、知识记忆等。

它不仅仅是“聊天机器人”的技术底座,而是一种通用的语言认知引擎,是未来AI产品形态的中枢神经系统。

🧭 二、大模型的发展路径

很多人误以为大语言模型是从 ChatGPT 开始的,其实它的进化历史远比想象中更长:

- 20 世纪中后期:早期 NLP 使用基于规则或统计的方法(如 n-gram)进行语言处理。

- 2015 年前后:RNN、LSTM 等神经网络结构应用于语言建模,解决了部分序列建模难题。

- 2017:Google 提出 Transformer 架构,引入自注意力机制,成为现代 LLM 的技术基座。

- 2018~2020:BERT、GPT-2、T5 等模型发布,标志“预训练+微调”成为主流范式。

- 2020~2023:GPT-3 让语言模型进入“涌现能力”阶段,ChatGPT 爆火,大模型开始落地到产品中。

- 2024~至今:Claude 3.5、GPT-4o、Gemini 1.5、LLaMA 3.3 轮番更新,国产模型如 DeepSeek、通义千问、文心、GLM 等全面追赶。

🛠️ 三、大模型背后的关键技术(为什么它们让模型更强?)

今天的大语言模型之所以能“听得懂、答得快、记得住、推得准”,背后靠的是以下几大核心技术。我们不仅讲“技术是什么”,更讲“它们带来了什么能力”。

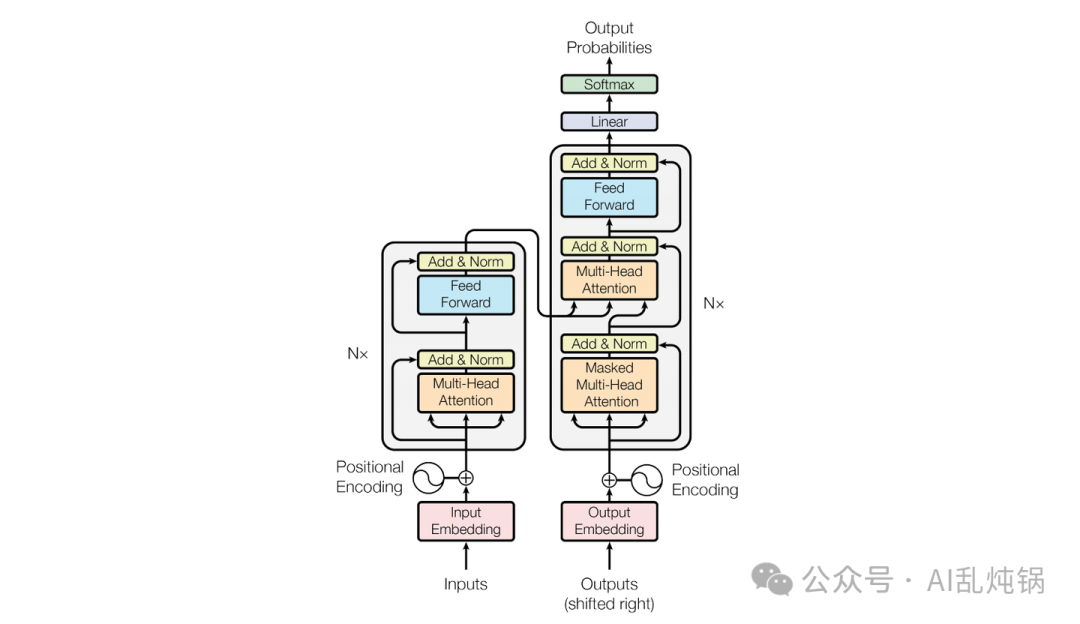

🔩 Transformer 架构

决定了模型能处理多复杂的上下文关系。

Transformer 是大模型的“骨架”,它用 Self-Attention(自注意力)机制 让模型每次处理词语时,能“同时关注”整个句子的所有词。

对大模型能力的直接影响是:

- 上下文理解更强

- 长距离依赖处理能力强

- 支持并行训练、加速大规模模型开发

🧠 预训练 + 微调范式

决定了模型能在多少任务上“零样本”适应

大模型的“聪明”,并不是每个任务都手把手教出来的,而是靠先学“语言世界”的通识知识,再通过少量示例快速适应任务。

这让模型具备了 few-shot/zero-shot 学习能力、极强的 泛化能力,并支持跨产品线快速部署。

🎯 自回归语言建模

决定了模型语言是否流畅、推理是否连续

通过逐词预测下一个 token,模型具备出色的文本连贯性、逻辑一致性,以及“逐步思考”的能力。它能“讲清楚一个故事”,也能“算清楚一道题”。

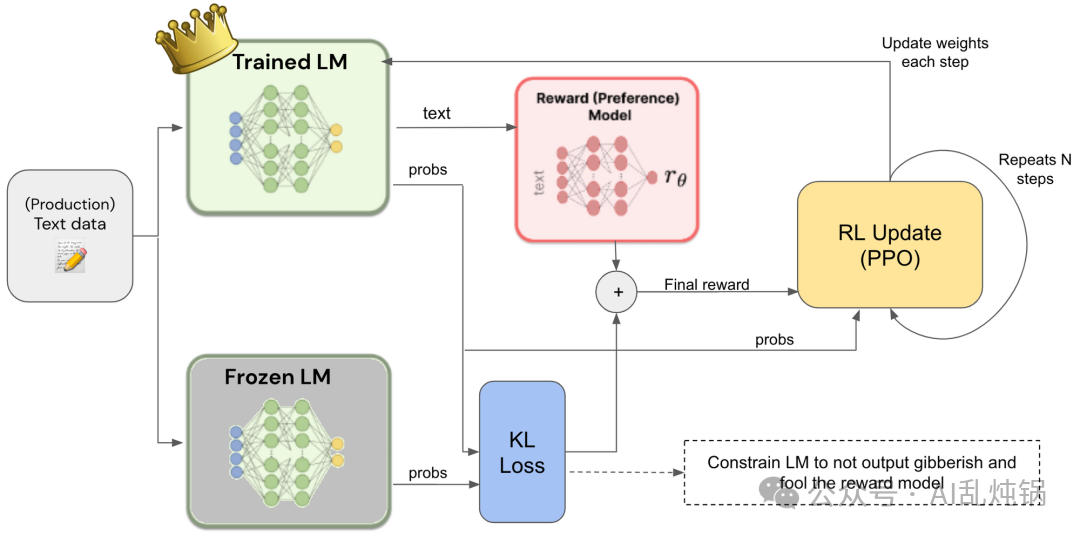

🤖 对齐训练 + 指令微调(RLHF + Instruction Tuning)

决定了模型“听话不听话”、“像人不像人”

LLM 会说话,不代表它会听话。通过指令微调和人类反馈强化学习,模型才能真正理解你的需求、给出合适的回应,并在安全性与可控性上迈进一大步。

🧰 工程机制:RAG、LoRA、Tool Use

决定了模型能不能真正“用得起、用得上”

现代 LLM 不只是语言生成工具,更是可以被调用的“智能插件系统”。通过轻量微调(如LoRA)、知识增强(如RAG)、函数调用机制(Function Calling),模型可以更稳定、更高效地适配具体产品任务。

🌐 四、大模型为什么“通用”?

大语言模型之所以被称为“通用人工智能的雏形”,是因为它并非只为某一类任务专门训练,而是具备了高度抽象与泛化的语言能力。

在预训练阶段,LLM通过海量多领域文本(新闻、小说、论文、对话、网页等)学习语言结构、知识分布与人类表达习惯。这使得它即使从未接触过某个具体任务,也能基于“指令提示”完成任务。

比如,它不是为了“翻译”而生,却能翻译;不是为“编程”而设计,却能输出结构清晰的函数;也不是传统意义上的“搜索引擎”,但能根据语义总结背景知识与解决方案。这就是 LLM 的通用性——语言就是接口,提示词就是功能调用方式。

❓ 五、大模型就是 ChatGPT 吗?

不是。ChatGPT 是 GPT 模型的产品形态之一,是 LLM + 对话管理 + 插件能力 + 前端封装的整合版本。

- ChatGPT 是“App”,LLM 是“底层操作系统”

- 一个 LLM 可以承载多个 ChatGPT,也可以支持搜索引擎、AI 助手、文档协作、代码补全等多种产品形态

换句话说,ChatGPT 跑在 LLM 上,就像微信跑在 iOS 上。

🔍 六、大模型为什么突然“爆了”?

ChatGPT 的爆红是公众认知的转折点,但真正让 LLM 全面爆发的,是过去几年积累的四大核心变量:

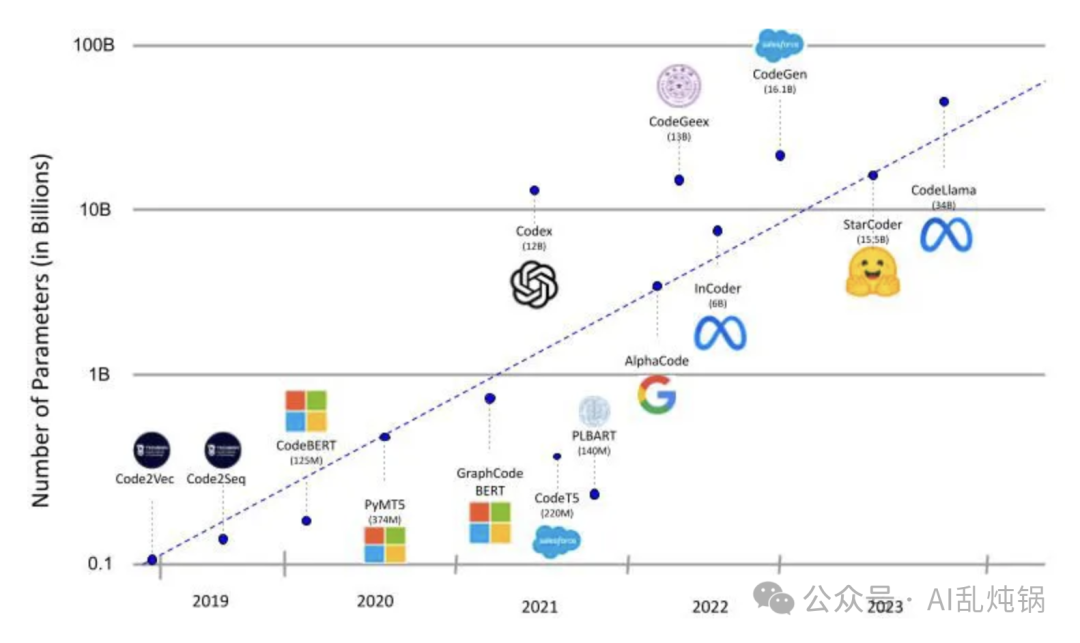

参数规模突破。当模型参数进入百亿级以上(如 GPT-3 的 1750 亿),模型不再只是“预测词”,而开始展现出涌现能力(Emergent Abilities),能在训练任务之外展现出逻辑推理、情绪表达、代码能力等“不可预期”能力。

训练数据质量跃迁。模型不再依赖通用网页语料,而是大量引入结构化、高质量内容:维基百科、法律文本、开源代码、科研论文等。这直接提高了模型的知识深度和语言严谨性。

模型工具链全面成熟。从 Megatron-LM 到 DeepSpeed、vLLM,再到 QLoRA、RAG、插件系统,训练效率和推理部署成本显著降低,产品团队能够在可控资源下快速上线一个可用的 LLM 系统。

算力基础设施的普及也起到了关键作用。随着 A100/H100 成为行业标准,集群训练、弹性推理和专用部署方案成为现实,模型“跑得动”,才有了商业化的前提。

👉 所以我们看到的不是“突然爆了”,而是技术、数据、工程、硬件“四线合流”的必然结果。

📍 七、目前有哪些大模型?

🌍 国际梯队:

-

OpenAI(GPT-4/4o):语言能力强,多模态对话领先

-

Anthropic(Claude 3系列):推理透明、对齐能力优异

-

Google(Gemini 1.5):文本+图像+音频统一模型

-

Meta(LLaMA 3.3 / LLaMA 4):开源推动者,MoE 架构初现

-

Mistral:轻量开源派代表,性能/成本比突出

🇨🇳 国内代表:

- 阿里(通义千问):系统稳定性高,企业级场景适配性强

- DeepSeek V3:高性价比代表,推理与编程能力领先

- 字节跳动(豆包):C端体验优化,对话自然流畅

- 百度(文心一言):通用能力稳健,知识问答与RAG表现突出

- 智谱AI(GLM):开源体系活跃,代码与中文能力领先

- 腾讯(混元):工具调用成熟,SaaS场景集成深入

✅ 总结

大语言模型不是“一个聊天机器人”,而是未来智能系统的“语言中枢”。

它能听懂人话、执行任务、调接口、生成内容、调用工具,是 AI 迈向“通用智能”的核心跳板。

未来十年,一切软件都值得被重写,一切产品都值得被 LLM 再定义。

那么,如何系统的去学习大模型LLM?

作为一名从业五年的资深大模型算法工程师,我经常会收到一些评论和私信,我是小白,学习大模型该从哪里入手呢?我自学没有方向怎么办?这个地方我不会啊。如果你也有类似的经历,一定要继续看下去!这些问题啊,也不是三言两语啊就能讲明白的。

所以我综合了大模型的所有知识点,给大家带来一套全网最全最细的大模型零基础教程。在做这套教程之前呢,我就曾放空大脑,以一个大模型小白的角度去重新解析它,采用基础知识和实战项目相结合的教学方式,历时3个月,终于完成了这样的课程,让你真正体会到什么是每一秒都在疯狂输出知识点。

由于篇幅有限,⚡️ 朋友们如果有需要全套 《2025全新制作的大模型全套资料》,扫码获取~

👉大模型学习指南+路线汇总👈

我们这套大模型资料呢,会从基础篇、进阶篇和项目实战篇等三大方面来讲解。

👉①.基础篇👈

基础篇里面包括了Python快速入门、AI开发环境搭建及提示词工程,带你学习大模型核心原理、prompt使用技巧、Transformer架构和预训练、SFT、RLHF等一些基础概念,用最易懂的方式带你入门大模型。

👉②.进阶篇👈

接下来是进阶篇,你将掌握RAG、Agent、Langchain、大模型微调和私有化部署,学习如何构建外挂知识库并和自己的企业相结合,学习如何使用langchain框架提高开发效率和代码质量、学习如何选择合适的基座模型并进行数据集的收集预处理以及具体的模型微调等等。

👉③.实战篇👈

实战篇会手把手带着大家练习企业级的落地项目(已脱敏),比如RAG医疗问答系统、Agent智能电商客服系统、数字人项目实战、教育行业智能助教等等,从而帮助大家更好的应对大模型时代的挑战。

👉④.福利篇👈

最后呢,会给大家一个小福利,课程视频中的所有素材,有搭建AI开发环境资料包,还有学习计划表,几十上百G素材、电子书和课件等等,只要你能想到的素材,我这里几乎都有。我已经全部上传到优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

相信我,这套大模型系统教程将会是全网最齐全 最易懂的小白专用课!!

219

219

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?