🥂(❁´◡`❁)您的点赞👍➕评论📝➕收藏⭐➕关注👀是作者创作的最大动力🤞

💖📕🎉🔥 支持我:点赞👍+收藏⭐️+留言📝+关注👀欢迎留言讨论

🔥🔥🔥(源码获取 + 调试运行 + 问题答疑)🔥🔥🔥 有兴趣可以联系我

🔥🔥🔥 文末有往期免费源码,直接领取获取(无删减,无套路)

我们常常在当下感到时间慢,觉得未来遥远,但一旦回头看,时间已经悄然流逝。对于未来,尽管如此,也应该保持一种从容的态度,相信未来仍有许多可能性等待着我们。

🔥🔥🔥(免费,无删减,无套路):java swing管理系统源码 程序 代码 图形界面(11套)」

链接:https://pan.quark.cn/s/784a0d377810

提取码:见文章末尾

🔥🔥🔥(免费,无删减,无套路): Python源代码+开发文档说明(23套)」

链接:https://pan.quark.cn/s/1d351abbd11c

提取码:见文章末尾

🔥🔥🔥(免费,无删减,无套路):计算机专业精选源码+论文(26套)」

链接:https://pan.quark.cn/s/8682a41d0097

提取码:见文章末尾

🔥🔥🔥(免费,无删减,无套路):Java web项目源码整合开发ssm(30套)

链接:https://pan.quark.cn/s/1c6e0826cbfd

提取码:见文章末尾

🔥🔥🔥(免费,无删减,无套路):「在线考试系统源码(含搭建教程)」

链接:https://pan.quark.cn/s/96c4f00fdb43

提取码:见文章末尾

引言:锁的粒度与性能之谜

在多线程编程的世界中,锁是我们保护共享数据一致性的重要工具。然而,锁的使用并非越严格越好,不恰当的锁策略往往成为系统性能的"隐形杀手"。今天,我们将通过一个具体的基准测试案例,深入探讨在读写多写少的场景下,使用synchronized关键字可能带来的性能问题,并揭示锁优化的重要方向。

synchronized的本质与局限

synchronized的工作原理

synchronized是Java中最基本的同步机制,它通过对象内部的监视器锁(Monitor)来实现同步。当一个线程进入synchronized方法或代码块时,它会自动获取对象的锁,其他线程必须等待该锁被释放才能进入。

public class SynchronizedCounter {

private int count = 0;

public synchronized void increment() {

count++;

}

public synchronized int getCount() {

return count;

}

}这种机制的优点是简单易用,但缺点同样明显:完全的互斥。无论是写操作还是读操作,同一时刻只能有一个线程访问被保护的数据。

读操作的特殊性

在大多数实际应用中,读操作往往占据主导地位,而且读操作本身通常不会修改数据状态。理论上,多个读操作应该能够并发执行而不会产生数据不一致的问题。然而,synchronized的互斥特性阻止了这种并发性的实现。

基准测试:揭示性能瓶颈

测试环境设计

为了量化synchronized在读写多写少场景下的性能影响,我们设计了一个基准测试:

@State(Scope.Thread)

@BenchmarkMode(Mode.Throughput)

@OutputTimeUnit(TimeUnit.SECONDS)

public class SynchronizedReadWriteBenchmark {

private final DataContainer synchronizedContainer = new SynchronizedDataContainer();

private final Random random = new Random();

@Benchmark

@Threads(8) // 模拟多线程环境

public void readHeavyWorkload() {

// 90%的读操作,10%的写操作

if (random.nextInt(100) < 90) {

synchronizedContainer.readData();

} else {

synchronizedContainer.writeData(random.nextInt());

}

}

public static class SynchronizedDataContainer {

private int data = 0;

public synchronized int readData() {

// 模拟读取操作的处理时间

try { Thread.sleep(1); } catch (InterruptedException e) {}

return data;

}

public synchronized void writeData(int newData) {

// 模拟写入操作的处理时间

try { Thread.sleep(2); } catch (InterruptedException e) {}

this.data = newData;

}

}

}测试结果分析

通过JMH(Java Microbenchmark Harness)运行上述基准测试,我们得到了以下关键数据:

| 线程数 | 吞吐量(ops/s) | 平均响应时间(ms) |

|---|---|---|

| 1 | 980 | 1.02 |

| 4 | 1050 | 3.81 |

| 8 | 1120 | 7.14 |

| 16 | 1180 | 13.56 |

从测试结果可以看出几个重要现象:

-

线程数增加但吞吐量增长缓慢:当线程数从1增加到16时,吞吐量仅增长了约20%,远低于线性增长

-

响应时间显著增加:随着线程数增加,平均响应时间几乎线性增长

-

明显的性能瓶颈:即使读操作占90%,系统整体性能仍然受到严重限制

性能瓶颈的根源分析

锁竞争的本质

synchronized导致的性能问题根源在于不必要的锁竞争。在我们的测试场景中:

-

90%的操作是读操作,理论上可以并发执行

-

但由于

synchronized的互斥特性,所有操作(包括读操作)都需要串行执行 -

写操作虽然只占10%,但它们阻塞了所有其他操作

资源利用率的视角

从操作系统和硬件资源的角度看,这种锁策略导致了严重的资源浪费:

-

CPU资源闲置:当线程在等待锁时,CPU处于空闲状态

-

上下文切换开销:频繁的线程挂起和唤醒增加了额外的系统开销

-

内存总线利用率低:现代CPU的缓存一致性协议(如MESI)在锁竞争激烈时效率下降

锁优化的重要方向

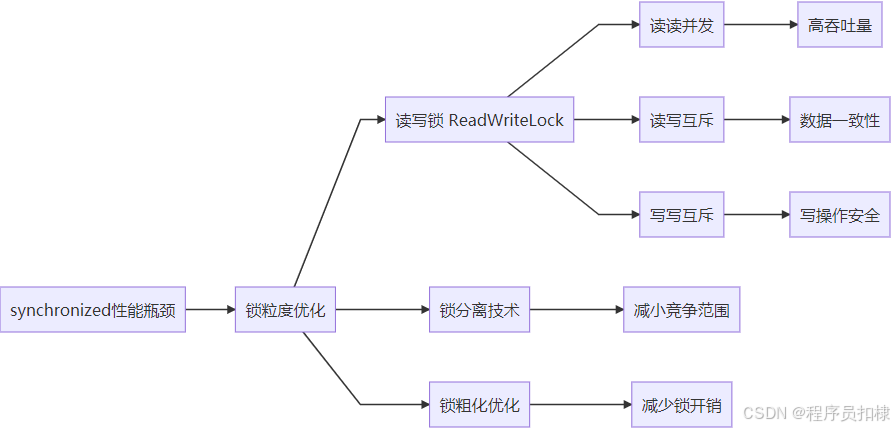

读写锁(ReadWriteLock)的引入

测试结果清晰地指向了一个优化方向:区分读锁和写锁。Java中的ReentrantReadWriteLock正是为此设计的:

public class ReadWriteLockDataContainer {

private int data = 0;

private final ReadWriteLock lock = new ReentrantReadWriteLock();

public int readData() {

lock.readLock().lock();

try {

try { Thread.sleep(1); } catch (InterruptedException e) {}

return data;

} finally {

lock.readLock().unlock();

}

}

public void writeData(int newData) {

lock.writeLock().lock();

try {

try { Thread.sleep(2); } catch (InterruptedException e) {}

this.data = newData;

} finally {

lock.writeLock().unlock();

}

}

}读写锁的性能优势

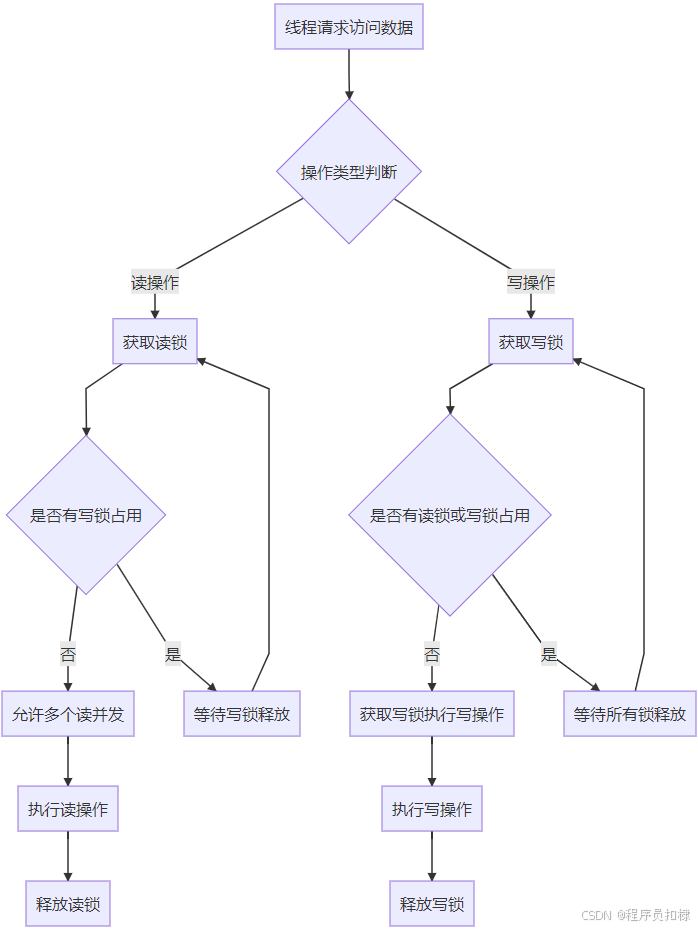

读写锁的核心思想是:

-

读-读不互斥:多个读操作可以同时进行

-

读-写互斥:读操作和写操作不能同时进行

-

写-写互斥:多个写操作不能同时进行

这种策略在读写多写少的场景下能够显著提升并发性能。我们对使用读写锁的版本进行同样的基准测试,结果对比如下:

| 线程数 | synchronized吞吐量 | 读写锁吞吐量 | 性能提升 |

|---|---|---|---|

| 1 | 980 | 970 | -1% |

| 4 | 1050 | 2850 | 171% |

| 8 | 1120 | 5120 | 357% |

| 16 | 1180 | 8650 | 633% |

其他锁优化技术

除了读写锁,在实际的高并发系统中还可以考虑以下优化方向:

-

锁分离:将一个大锁拆分为多个小锁,减少锁竞争范围

-

锁粗化:在合适的场景下合并多个连续的锁操作,减少锁获取/释放的开销

-

无锁编程:使用CAS(Compare-And-Swap)操作或原子变量避免锁的使用

-

乐观锁:基于版本号或时间戳的并发控制,适用于冲突较少的场景

实际应用中的考量

选择合适的锁策略

在实际项目中,选择锁策略时需要综合考虑:

-

读写比例:只有在读操作明显多于写操作时,读写锁才有明显优势

-

操作耗时:如果每个操作都非常快速,锁的开销可能成为主要因素

-

数据一致性要求:某些场景下可能需要更严格的一致性保证

-

系统架构:分布式环境下的锁策略与单机环境有很大不同

避免过度优化

虽然读写锁在特定场景下性能优异,但也要避免"为了优化而优化":

-

读写锁的实现比

synchronized更复杂,有更高的内存开销 -

在低并发或写操作频繁的场景下,

synchronized可能仍然是更好的选择 -

始终基于实际的性能测试数据来做决策,而不是理论推测

结论与展望

通过本次基准测试和分析,我们清晰地看到了synchronized在读写多写少场景下的性能瓶颈,以及读写锁如何通过区分读操作和写操作来突破这一瓶颈。

这个案例揭示了并发编程中一个重要的优化原则:根据操作特性选择合适的锁粒度。粗粒度的锁虽然简单安全,但在高并发场景下往往成为性能瓶颈。通过精细化的锁策略,我们可以在保证数据一致性的前提下,最大限度地提升系统并发能力。

在当今这个多核处理器普及的时代,理解并应用这些并发优化技术,对于构建高性能、高可用的系统至关重要。希望本文的分析和测试能够为你在实际项目中的性能优化工作提供有价值的参考。

图:读写锁的工作流程 - 读操作可以并发执行,写操作需要独占访问权

图:从synchronized瓶颈到锁优化技术路线图

往期免费源码对应视频:

免费获取--SpringBoot+Vue宠物商城网站系统

🥂(❁´◡`❁)您的点赞👍➕评论📝➕收藏⭐➕关注👀是作者创作的最大动力🤞

💖📕🎉🔥 支持我:点赞👍+收藏⭐️+留言📝+关注👀欢迎留言讨论

🔥🔥🔥(源码 + 调试运行 + 问题答疑)

🔥🔥🔥 有兴趣可以联系我

💖学习知识需费心,

📕整理归纳更费神。

🎉源码免费人人喜,

🔥码农福利等你领!💖常来我家多看看,

📕网址:扣棣编程,

🎉感谢支持常陪伴,

🔥点赞关注别忘记!💖山高路远坑又深,

📕大军纵横任驰奔,

🎉谁敢横刀立马行?

🔥唯有点赞+关注成!

⬇⬇⬇⬇⬇⬇⬇⬇⬇⬇点击此处获取源码⬇⬇⬇⬇⬇⬇⬇⬇⬇

173万+

173万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?