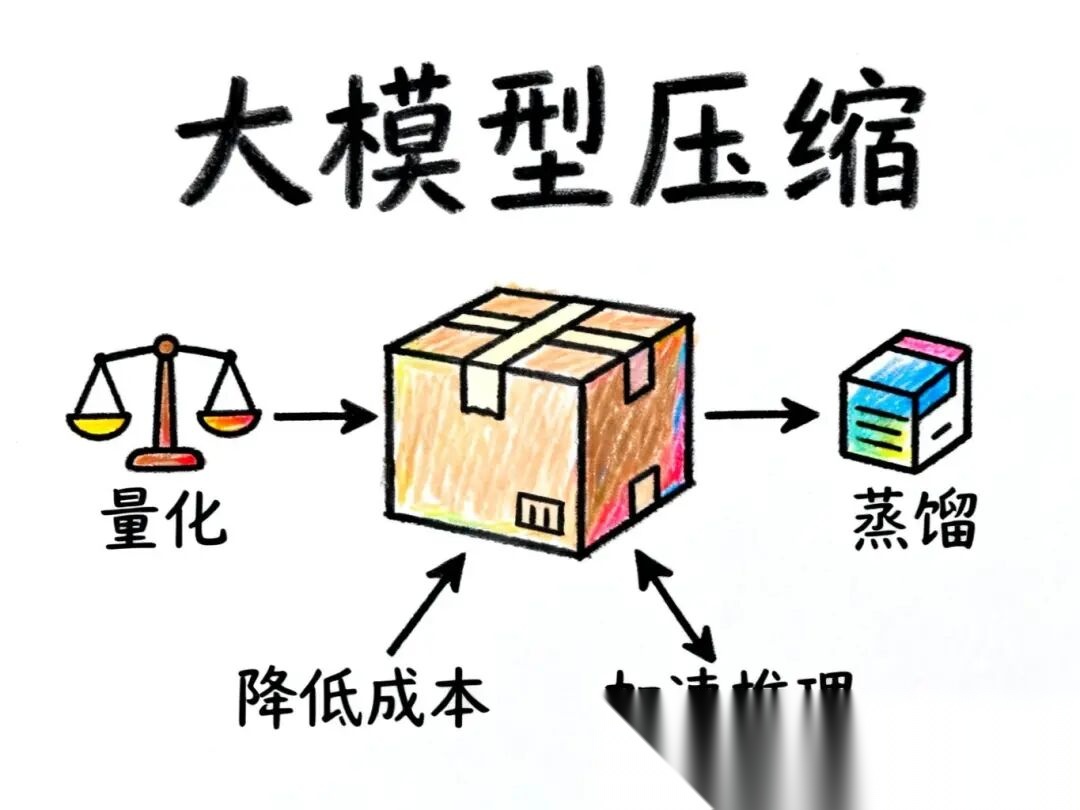

文章介绍大模型压缩的两大主流技术:量化通过降低参数精度(如Float32转INT8)减少存储需求与计算资源,同时保持性能;蒸馏则训练小模型模仿大模型行为,大幅缩减模型规模。量化实施简单不需重新训练,蒸馏灵活度高可获全新小模型。这些技术对降低AI部署成本、实现技术"平民化"至关重要,是开发者必备知识。

前排提示,文末有大模型AGI-优快云独家资料包哦!

为什么要给大模型"瘦身"?

在AI技术飞速发展的今天,大语言模型已经成为各行各业的得力助手。但你是否知道,部署一个大模型的成本有多高?

一个千亿参数级别的模型,不仅需要占用大量的存储空间,在实际运行时更是需要惊人的计算资源。对于企业来说,这意味着高昂的硬件成本和运营开支。因此,如何在保持模型性能的同时降低部署成本,成为了AI工程师们必须面对的挑战。

今天,我们就来聊聊大模型压缩的两大主流技术——量化(Quantization)和蒸馏(Distillation)。

量化:用更少的位数存储参数

什么是量化?

要理解量化,我们首先需要知道:大模型本质上是由海量参数组成的。比如GPT-3,就包含了1750亿个参数。每个参数都是一个数值,而这些数值的存储方式,直接决定了模型占用的空间大小。

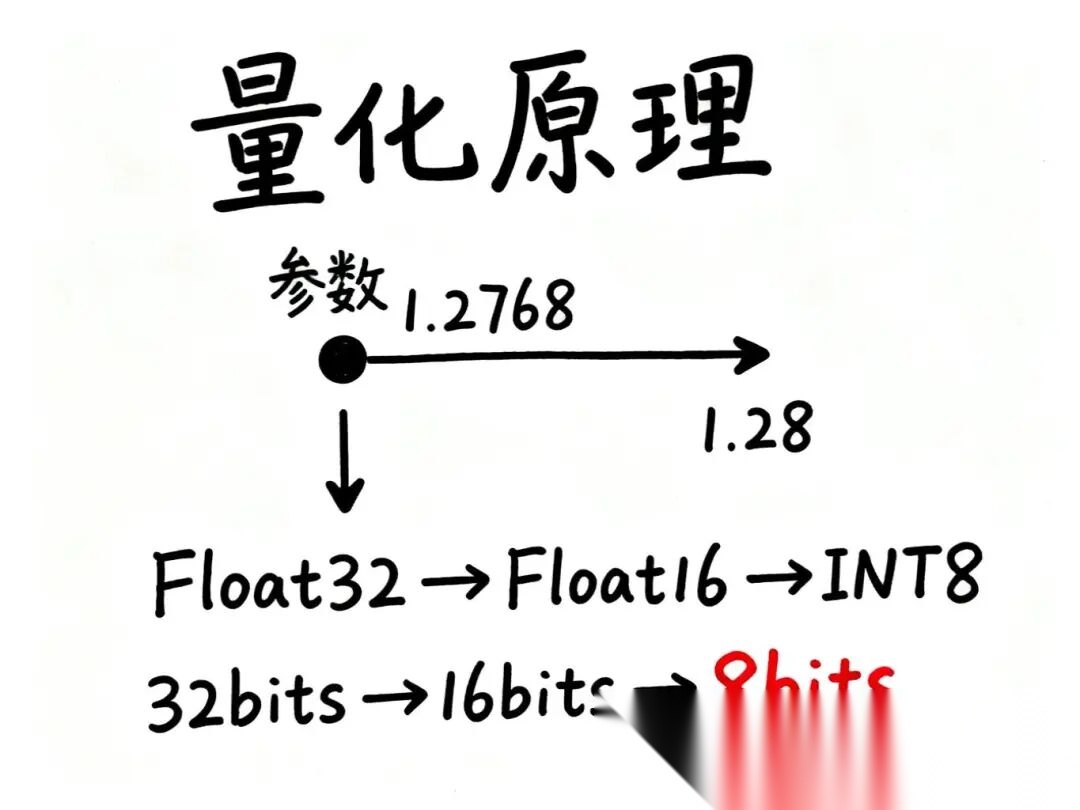

让我们举个简单的例子。假设某个参数的值是1.2768,为了在计算机中存储这个精确的数值,我们需要开辟一定的内存空间。但如果我们做个"四舍五入",把它简化成1或者1.28,所需的存储空间就会大大减少。

这就是量化的核心思想——通过降低数值精度来节省存储空间。

从Float32到INT8的转变

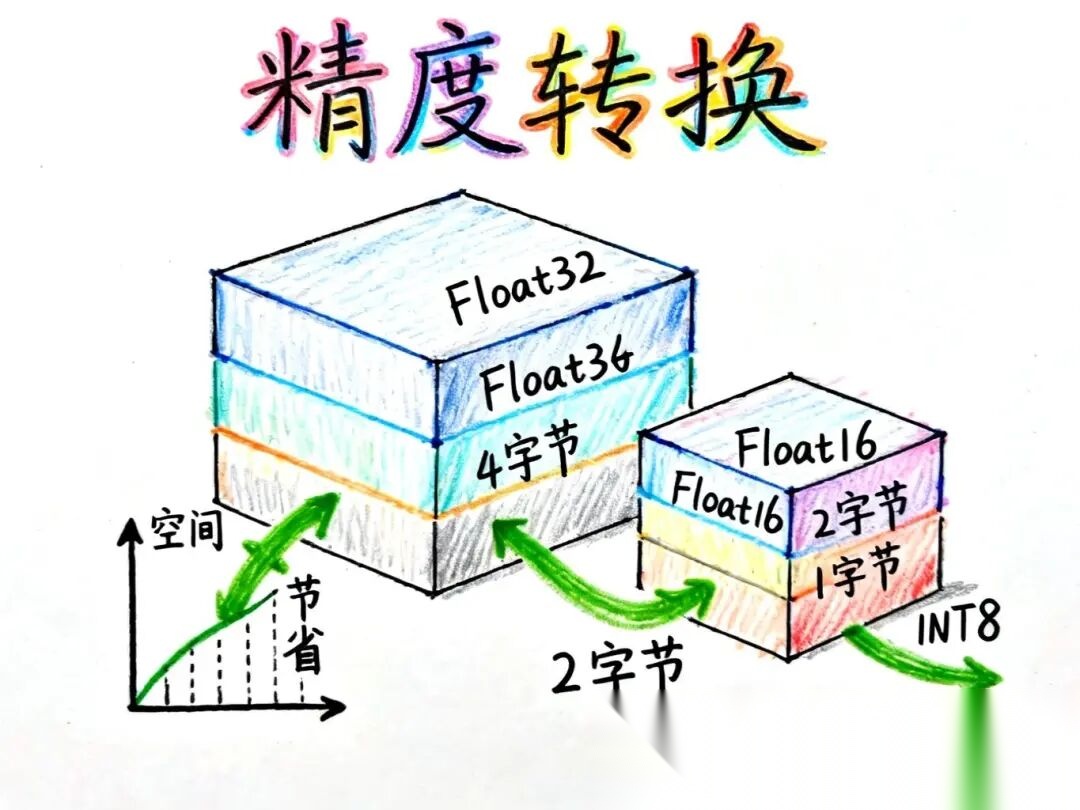

在深度学习中,参数通常以Float32的格式存储,也就是说每个参数占用32个bits(4个字节)的空间。但通过量化技术,我们可以将这些参数转换为更低精度的数据类型:

- Float32 → Float16:空间减半,每个参数仅占16个bits

- Float32 → INT8:空间压缩至1/4,每个参数仅占8个bits

这种转换带来的好处是显而易见的:

- 大幅降低存储需求:模型文件变小,更容易部署

- 加速推理速度:计算量减少,响应更快

- 降低成本:对硬件的要求大幅下降

你可能会担心:精度降低了,模型的准确率会不会受影响?

答案是:**如果量化过程把控得当,模型的准确率是有保障的。**这也是为什么量化成为目前大模型压缩最常用的方法之一。

蒸馏:让小模型学会"模仿"

蒸馏的本质是什么?

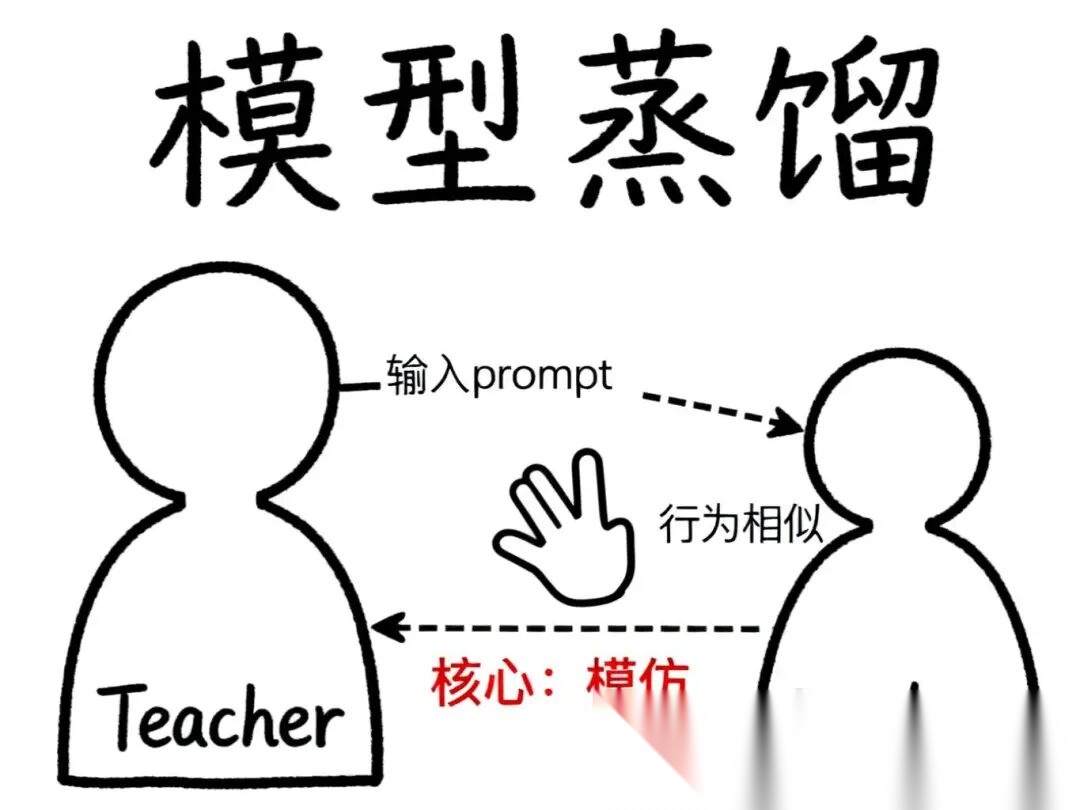

如果说量化是"压缩参数",那么蒸馏则是完全不同的思路——让一个小模型去模仿大模型的行为。

想象一个场景:我们已经训练好了一个千亿参数的大模型,但它太大太重,部署成本太高。这时候,我们可以构造一个小得多的模型,然后让这个"学生模型"(Student Model)去学习"教师模型"(Teacher Model)的行为。

蒸馏是如何工作的?

具体来说,蒸馏的过程是这样的:

- 给定一个输入(比如一个prompt)

- 将这个输入同时喂给大模型和小模型

- 观察大模型的输出

- 训练小模型,让它的输出尽可能接近大模型的输出

就像小孩子模仿大人一样,大模型做什么,小模型也学着做什么。

通过这种方式,小模型逐渐学会了大模型的"行为模式",最终能够在保持相似性能的同时,大幅减少模型规模和计算开销。

蒸馏在实际中的应用

蒸馏技术不仅用于模型压缩,在训练新模型时也经常使用。

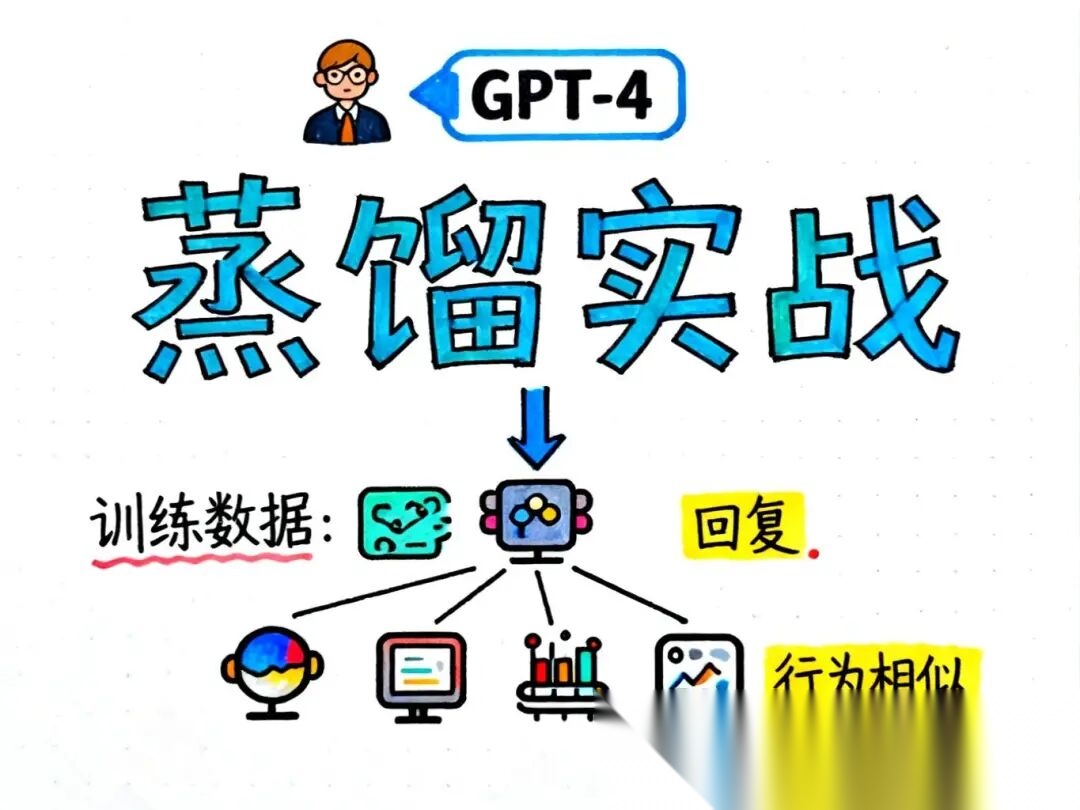

一个典型的例子是:市面上很多开源大模型,都是通过"模仿"GPT-4训练出来的。具体做法是:

- 收集GPT-4对各种问题的回复

- 将这些输入-输出对作为训练数据

- 用这些数据训练自己的模型

通过这种方式,开源模型能够逐步接近GPT-4的表现,同时保持更低的部署成本。

量化vs蒸馏:该选哪一个?

这两种技术各有特点,适用于不同场景:

量化技术:

- 优势:实施简单,不需要重新训练,压缩效果明显

- 适用场景:已有模型的快速优化,对精度要求不是特别严格的应用

- 主流方法:目前大模型压缩最常用的手段

蒸馏技术:

- 优势:可以获得一个全新的小模型,灵活性更高

- 适用场景:需要大幅度缩小模型规模,或训练新模型时借鉴大模型能力

- 应用广泛:很多开源模型都基于蒸馏思路训练

在实际应用中,这两种技术也可以结合使用,达到更好的压缩效果。

其他压缩技术

除了量化和蒸馏,还有一些其他的模型压缩技术,比如剪枝(Pruning)——通过移除模型中不重要的参数或连接来减小模型规模。

但在大模型领域,剪枝的实用性相对较弱,量化和蒸馏仍然是最主流、最实用的两种方法。

写在最后

随着大模型应用的不断普及,模型压缩技术变得越来越重要。无论是量化还是蒸馏,它们的目标都是在保证模型性能的前提下,让AI技术更加"平民化"——降低部署门槛,让更多人能够用得起、用得好大模型。

对于开发者来说,理解这些技术原理,不仅能帮助我们更好地部署模型,也能在设计AI应用时做出更明智的技术选择。

你在实际项目中使用过这些技术吗?欢迎在评论区分享你的经验!

读者福利:倘若大家对大模型感兴趣,那么这套大模型学习资料一定对你有用。

针对0基础小白:

如果你是零基础小白,快速入门大模型是可行的。

大模型学习流程较短,学习内容全面,需要理论与实践结合

学习计划和方向能根据资料进行归纳总结

包括:大模型学习线路汇总、学习阶段,大模型实战案例,大模型学习视频,人工智能、机器学习、大模型书籍PDF。带你从零基础系统性的学好大模型!

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

👉AI大模型学习路线汇总👈

大模型学习路线图,整体分为7个大的阶段:(全套教程文末领取哈)

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

👉大模型实战案例👈

光学理论是没用的,要学会跟着一起做,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

👉大模型视频和PDF合集👈

这里我们能提供零基础学习书籍和视频。作为最快捷也是最有效的方式之一,跟着老师的思路,由浅入深,从理论到实操,其实大模型并不难。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

924

924

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?