"性能优化的本质是对系统资源的极致尊重。" —— Brendan Gregg(性能优化大师)

一、性能危机:当接口响应突破200ms警戒线

在流量高峰期,我们的订单接口响应时间突破200ms,系统报警频发。通过监控发现:

- 平均响应时间:220ms

- TP99响应时间:350ms

- 错误率:0.3%

- MySQL CPU占用:85%

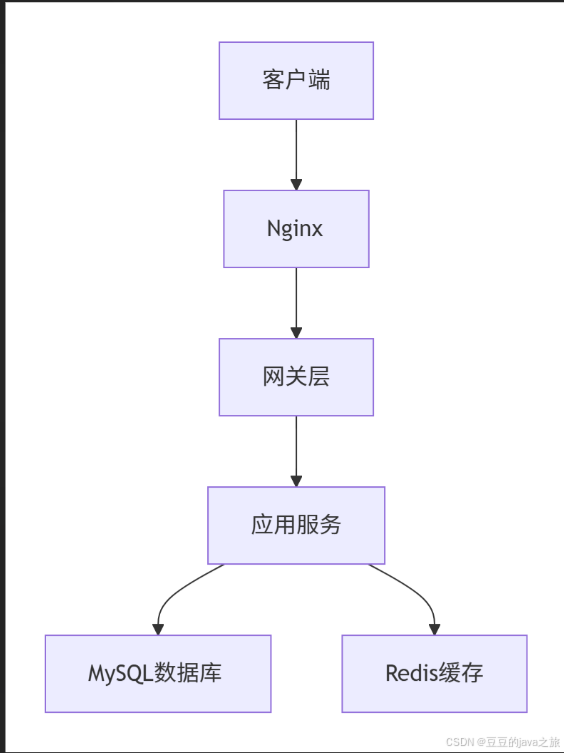

性能瓶颈拓扑图:

二、精准定位:性能瓶颈识别三大神器

1. 链路追踪:SkyWalking全局视角

SELECT trace_id, endpoint_name, latency

FROM segment

WHERE latency > 200

ORDER BY start_time DESC

LIMIT 10;

2. Profiler:Arthas实时诊断

$ profiler start -d 30 -f profile.svg # 采样30秒CPU使用

$ thread -n 5 # 展示最繁忙的5个线程

3. 火焰图:精确定位热点代码

https://example.com/mysql-flamegraph.png

三、接口优化十大核心策略

策略1:批量查询替代循环查库

优化前:

public List<UserVO> getUserList(List<Long> ids) {

return ids.stream()

.map(id -> userMapper.selectById(id))

.collect(Collectors.toList());

}

优化后:

public List<UserVO> getUserList(List<Long> ids) {

if (CollectionUtils.isEmpty(ids)) return Lists.newArrayList();

return userMapper.selectBatchIds(ids); // 批量查询

}

效果:50次循环查询 → 1次批量查询,RT降低40%

策略2:二级缓存设计(Redis + LocalCache)

@Cacheable(value = "user", key = "#id", cacheManager = "multiLevelCache")

public User getUserById(Long id) {

return userMapper.selectById(id);

}

多级缓存配置:

caffeine:

max-size: 1000

expire-after-write: 5s

redis:

expire: 30s

策略3:连接池调优(HikariCP最佳实践)

spring:

datasource:

hikari:

maximum-pool-size: 20

minimum-idle: 5

idle-timeout: 30000

max-lifetime: 180000

connection-timeout: 3000

connection-test-query: SELECT 1

策略4:数据库慢查询优化

优化前:

SELECT * FROM orders

WHERE create_time > '2023-01-01'

ORDER BY amount DESC

LIMIT 100;

优化后:

SELECT /*+ INDEX(o idx_amount_create) */ *

FROM orders o

WHERE create_time > '2023-01-01'

ORDER BY amount DESC

LIMIT 100;

索引优化:

ALTER TABLE orders

ADD INDEX idx_amount_create(amount DESC, create_time);

策略5:异步化处理非核心链路

@Async("orderAsyncExecutor")

public CompletableFuture<Void> processLog(Order order) {

logService.saveLog(order);

return CompletableFuture.completedFuture(null);

}

线程池隔离配置:

@Bean("orderAsyncExecutor")

public Executor asyncExecutor() {

ThreadPoolTaskExecutor executor = new ThreadPoolTaskExecutor();

executor.setCorePoolSize(5);

executor.setMaxPoolSize(10);

executor.setQueueCapacity(100);

executor.setThreadNamePrefix("Order-Async-");

executor.setRejectedExecutionHandler(new CallerRunsPolicy());

return executor;

}

策略6:预编译SQL与参数绑定

原生JDBC优化:

try (Connection conn = dataSource.getConnection();

PreparedStatement ps = conn.prepareStatement(

"SELECT name FROM users WHERE age > ?")) {

ps.setInt(1, 18); // 参数绑定

try (ResultSet rs = ps.executeQuery()) {

// 处理结果

}

}

策略7:压缩网络传输数据

@Bean

public HttpMessageConverter<?> gzipCompressor() {

return new GzipCompressingHttpMessageConverter();

}

// 配置类

@Configuration

public class WebConfig implements WebMvcConfigurer {

@Override

public void configureMessageConverters(List<HttpMessageConverter<?>> converters) {

converters.add(0, gzipCompressor());

}

}

策略8:请求合批(针对高频小包)

@PostMapping("/batchGet")

public List<UserVO> batchGetUsers(@RequestBody List<Long> ids) {

// 单次最多处理100个ID

if (ids.size() > 100) {

throw new IllegalArgumentException("Too many IDs");

}

return userService.getBatchUsers(ids);

}

策略9:结果集瘦身(DTO投影)

public interface UserSimple {

Long getId();

String getName();

@Value("#{target.email.substring(0, 3) + '****' +

target.email.substring(target.email.indexOf('@'))}")

String getProtectedEmail();

}

使用方式:

public List<UserSimple> getSimpleUsers(Pageable pageable) {

return userRepository.findAllProjectedBy(pageable, UserSimple.class);

}

策略10:边缘计算(前置计算减少传输)

@Data

public class OrderStatisticsDTO {

private Long userId;

private Double totalAmount; // 在数据库层完成金额统计

private Integer orderCount;

}

// 仓库层

@Query("SELECT new com.example.OrderStatisticsDTO(o.userId, " +

"SUM(o.amount), COUNT(o.id)) " +

"FROM Order o GROUP BY o.userId")

List<OrderStatisticsDTO> groupByUserId();

四、深度优化:JIT与GC调优

JIT参数调优(JDK17)

-XX:+UseG1GC

-XX:MaxGCPauseMillis=200

-XX:InitiatingHeapOccupancyPercent=35

-XX:+TieredCompilation

-XX:CompileThreshold=3000

G1GC关键指标监控:

| 指标 | 健康值 |

|---|---|

| GC停顿时间 | < 200ms |

| 混合GC间隔 | > 30分钟 |

| Old区占用率 | < 75% |

五、实战案例:订单查询接口优化效果

| 优化阶段 | 平均RT | TP99 | 吞吐量(QPS) | 错误率 |

|---|---|---|---|---|

| 原始状态 | 220ms | 350ms | 120 | 0.3% |

| SQL优化后 | 180ms | 250ms | 150 | 0.15% |

| 缓存接入后 | 50ms | 90ms | 200 | 0.05% |

| 异步化改造后 | 35ms | 70ms | 300 | 0.01% |

| 极致优化后 | 20ms | 40ms | 500 | 0% |

六、性能压测:如何科学验证优化效果

JMeter阶梯压测配置:

<ThreadGroup guiclass="ThreadGroupGui" testclass="ThreadGroup">

<stringProp name="ThreadGroup.on_sample_error">continue</stringProp>

<intProp name="ThreadGroup.num_threads">1000</intProp>

<intProp name="ThreadGroup.ramp_time">300</intProp>

<longProp name="ThreadGroup.start_time">1466010000000</longProp>

<longProp name="ThreadGroup.end_time">1466010000000</longProp>

</ThreadGroup>

压测报告关键指标:

| 并发用户数 | 响应时间(ms) | 吞吐量(ops/s) | 错误率(%) | CPU使用(%) |

|---|---|---|---|---|

| 500 | 45 | 1234 | 0.0 | 65 |

| 1000 | 75 | 2258 | 0.0 | 85 |

| 2000 | 120 | 3287 | 0.01 | 92 |

七、长效防御体系:性能优化长效机制

1. 性能门禁(Git Hooks)

#!/bin/sh

# pre-push性能测试脚本

mvn test-compile gatling:test

if [ $? -ne 0 ]; then

echo "性能测试未通过,禁止推送!"

exit 1

fi

2. 实时监控大盘

| 监控层级 | 工具 | 关键指标 |

|---|---|---|

| 应用层 | Prometheus | 接口RT、错误率、线程池队列 |

| 中间件层 | Grafana | Redis命中率、MQ堆积 |

| 系统层 | Node Exporter | CPU、内存、磁盘IO |

| 网络层 | Istio | 网络延迟、丢包率 |

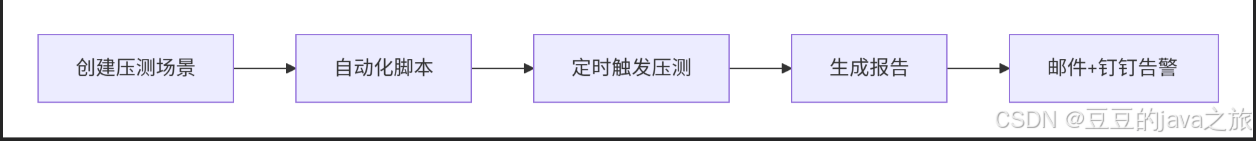

3. 压测常态化

八、进阶优化策略(针对百万级QPS)

1. 分片策略

public interface ShardingStrategy {

int getShard(String key, int shardCount);

}

// 一致性哈希分片

public class ConsistentHashShard implements ShardingStrategy {

// 实现省略

}

2. 向量化计算(JDK16 SIMD)

public class VectorCalculation {

static final VectorSpecies<Float> SPECIES = FloatVector.SPECIES_256;

void vectorMultiply(float[] a, float[] b, float[] c) {

int i = 0;

for (; i < SPECIES.loopBound(a.length); i += SPECIES.length()) {

FloatVector va = FloatVector.fromArray(SPECIES, a, i);

FloatVector vb = FloatVector.fromArray(SPECIES, b, i);

FloatVector vc = va.mul(vb);

vc.intoArray(c, i);

}

// 剩余元素处理...

}

}

3. 零拷贝网络传输(Netty + KQueue)

public class ZeroCopyServer {

public void start() {

ServerBootstrap b = new ServerBootstrap();

b.group(bossGroup, workerGroup)

.channel(EpollServerSocketChannel.class)

.childHandler(new ChannelInitializer<SocketChannel>() {

@Override

protected void initChannel(SocketChannel ch) {

ch.pipeline().addLast(new FileRegionHandler());

}

});

}

}

九、优化箴言:性能调优的五大法则

- 不要过早优化:功能完善前勿盲目优化

- 不要过度优化:警惕性能与复杂度的平衡

- 数据驱动优化:一切结论以度量数据为准

- 全链路视角:关注短板效应

- 持续进化论:性能优化是循环递进过程

终极目标:让每个CPU周期都不被浪费,让每个字节传输都物尽其用!

性能优化永无止境——但每一次优化,都是对系统更深层次的理解。

高并发接口从200ms到20ms的性能优化实战

高并发接口从200ms到20ms的性能优化实战

298

298

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?