VERY DEEP CONVOLUTIONAL NETWORKS FOR LARGE-SCALE IMAGE RECOGNITION

文章链接VGG16

摘要:本文主要贡献在于随着不能增加的网络层数并使用3*3的卷积核,在层数达到16-19层达到了高的性能提升;

1、介绍:创造出更精确的卷积框架,其不仅取得分类与定位任务的良好效果,并且可以应用于其他识别的数据集;

下面是文章的布局:

第二部分 描述卷积网络的参数配置 第三部分 图片分类的训练和评估的细节 第四部分 在the ILSVRC 分类任务的比较;第五部分总结这个文章;

2、卷积网络的配置

对于测量增加深度的卷积层带来性能上的提升,所有的卷积层配置被用来设计相同,首先描述卷积层布局的配置2.1,然后在评估阶2.2段细化,对于这样的设计在2.3部分给予对于与讨论

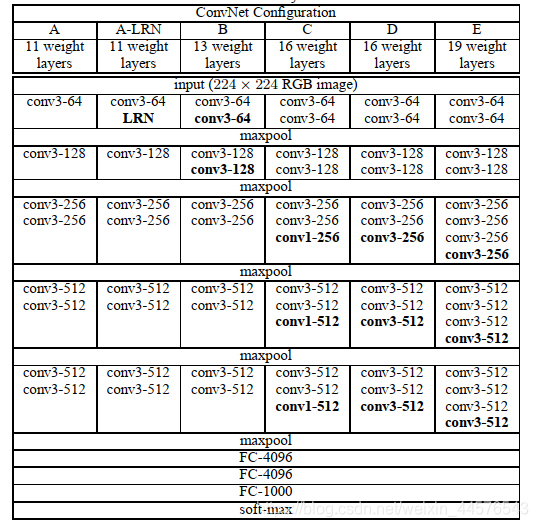

2.1框架 在训练过程中,使用rgb 224*224 的图片作为输入,做一个预处理(对于训练集的每个图像的像素减去rgb的均值),使用统一的卷积核3*3,当然也使用1*1的卷积核作为线性转化,步长为1;使用最大池化2*2 步长为2

对于全连接层,前两个是4096个通道,第三个是1000对于图片的分类,最终的softmax层同样也是1024

激活函数都是使用 RELU ,包括本地相应归一化(LRU 其占用内存 浪费时间)

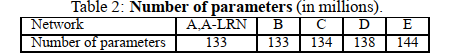

2.2 配置 卷积层的配置在表1中 分为A-E 种网络框架,不同的深度 表2 表示参数的数量,

2.3 主要提出了使用了卷积核3*3的 可以有效的 代替 7*7 5*5 同时减少了参数的数量;

3 分类框架

训练过程的设置,使用多尺度的照片,通过使用mini-batch 梯度下降 最优化回归,batch_size 为256 momentum=0.9 权重损失5*10的-4次方,前两个全连接层dropout=0.5 , learning -rate=0.01 ,总之 学习率减少3倍,在74 次迭代后停止,即使存在大量的参数,(对于KRIZHEVSKEY ET AL ,2012)迭代的次数很少很快实现收敛,有两点原因:第一暗含的正则化提出 更深的网络与更小的卷积,第二 对于一定层进行权重预初始化, 刚开始训练深度框架,先对前四个卷积层以及后三个全连接层进行了权重初始化,在预初始化的过程中,没有减少其学习率;初始化方法使用正太分布 均值为0 方差为10的-2次方,偏置初始化为0,

数据增强方面,使用224的尺寸,随机剪裁图片,进一步的增强是随机水平翻转,随机RGB 彩色偏差。

训练图片尺寸:统一使用224 通过两种不同的方式来裁剪出224的图片

3.2 测试 通过对测试图片翻转,得出的结果与原始的图片 做平均,主要是讲述多种crop 发挥的作用

3.3 实施细节:

工具:C++ CAFFE 多GPU并行运算 4GPU 比单GPU速度3.75倍, 在配备4个GPU的基础上,训练单个网络使用2-3周时间

4 分类实验部分

the ILSVRC-2012 dataset 总共1000类图片 三部分,训练1.3M张, 验证50K ,测试100K张

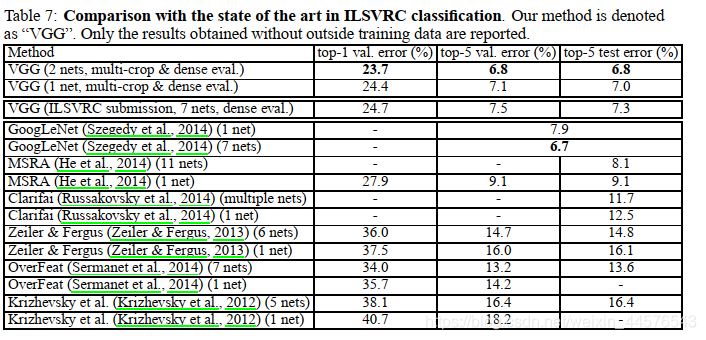

以下是单一尺度 与 多尺度的具体分析 、卷积网络融合,这里忽略

4.5 比较

5 结论

主要表面网络深度对性能提升的重要性

VGG16深度卷积网络解析

VGG16深度卷积网络解析

本文探讨VGG16深度卷积网络在大规模图像识别中的应用,通过增加网络层数至16-19层,使用3*3卷积核,实现了性能的显著提升。介绍了网络配置、训练细节及在ILSVRC分类任务中的表现。

本文探讨VGG16深度卷积网络在大规模图像识别中的应用,通过增加网络层数至16-19层,使用3*3卷积核,实现了性能的显著提升。介绍了网络配置、训练细节及在ILSVRC分类任务中的表现。

405

405

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?