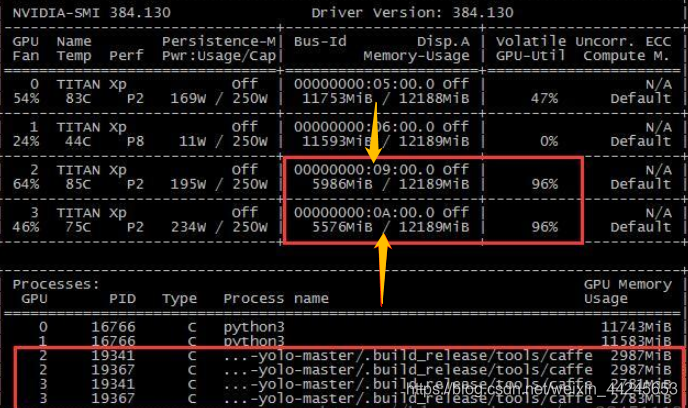

首先,在终端输入nvidia-smi:

可以查看当前正常使用的GPU情况,如下图所示:

如果要一直刷进度 nvidia-smi -l (一般看数据训练情况) nvidia-smi 实时刷新 实时显示显存使用情况

进程会一直刷出来~

想要终止其中某个/或几个GPU进程,可通过以下命令实现:kill -9 PID

现在要关闭占用2和3号GPU的四个进程的PID分别是:19341、19367、19341、19367

(其实,后2个和前2个是一样的,因为我在训练的时候指定了用2个GPU训练,实际只包含2个PID)

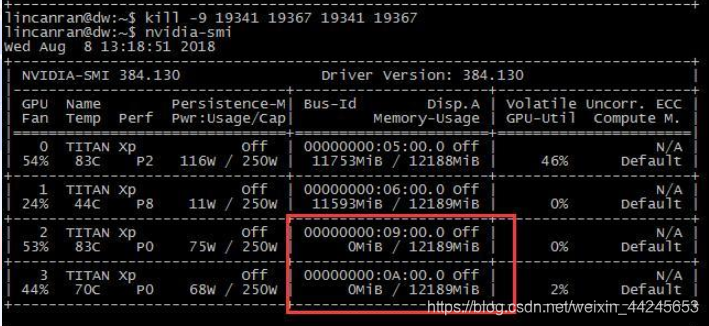

在终端输入后,回车:

kill -9 19341 19367 19341 19367

(进程之间用空格隔开)

结果如下:

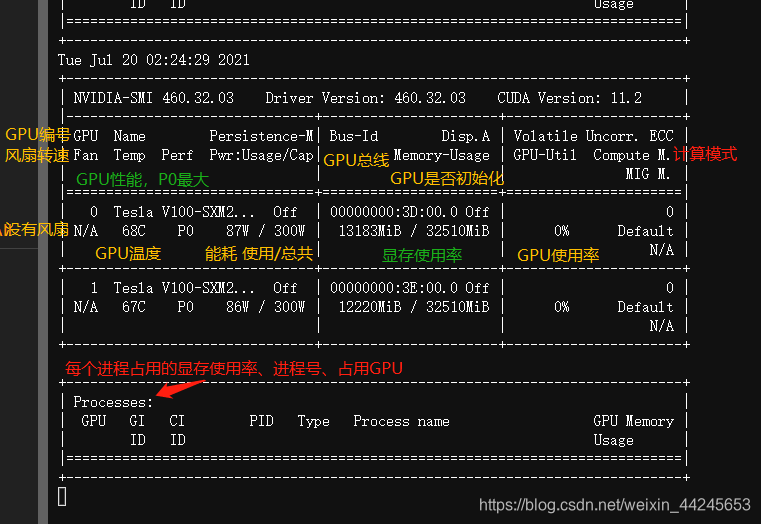

对于NVIDIA的显存详细注释如下:

显存占用和GPU占用是两个不一样的东西,显卡是由GPU和显存等组成的,显存和GPU的关系有点类似于内存和CPU的关系。跑caffe代码的时候显存占得少,GPU占得多;跑TensorFlow代码的时候,显存占得多,GPU占得少。

简而言之:

显卡=GPU+显存+…… 类似 CPU+内存

在Linux环境下,可以通过命令查看GPU使用情况,如nvidia-smi实时刷新展示显存使用。若需结束GPU进程,可指定PID进行关闭。显存占用与GPU占用不同,根据运行的代码类型(如TensorFlow或Caffe),二者占用比例会有所变化。

在Linux环境下,可以通过命令查看GPU使用情况,如nvidia-smi实时刷新展示显存使用。若需结束GPU进程,可指定PID进行关闭。显存占用与GPU占用不同,根据运行的代码类型(如TensorFlow或Caffe),二者占用比例会有所变化。

12万+

12万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?