声明:本文只作学习研究,禁止用于非法用途,否则后果自负,如有侵权,请告知删除,谢谢!

项目场景:

网址:https://epub.cnki.net/kns/brief/result.aspx?dbprefix=SCPD

这次给大家带来的是知网专利信息的获取,没有复杂的反爬措施,只要先用session获取查询时的cookie,然后带着cookie访问列表页即可。

项目代码:

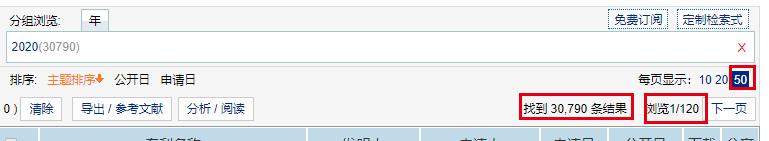

这里要讲解一下,一个页面最多50条数据,最多120页,所以我们要想获取全部的数据,就要对专利类型进行帅选(尽量细分),这样根据日期和专利类型搜索,大部分数据都能获取到。

测试代码如下,可自行修改

import requests,re

from lxml import etree

def get_cookie(): # 获取访问的cookie

params = (

('action', ''),

('NaviCode', 'A'), # 筛选的类别

('ua', '1.21'),

('PageName', 'ASP.brief_result_aspx'),

('DbPrefix', 'SCPD'),

('DbCatalog', '\u4E2D\u56FD\u4E13\u5229\u6570\u636E\u5E93'),

('ConfigFile', 'SCPD.xml'),

('db_opt', '\u4E2D\u56FD\u4E13\u5229\u6570\u636E\u5E93'),

('db_value', '\u4E2D\u56FD\u4E13\u5229\u6570\u636E\u5E93'),

('date_gkr_from', '2020-01-24'), # 筛选日期

('date_gkr_to', '2020-01-24'), # 筛选日期

('his', '0'),

('__', 'Fri Oct 16 2020 14:37:38 GMT+0800 (\u4E2D\u56FD\u6807\u51C6\u65F6\u95F4)'),

)

session = requests.session()

session.get('https://epub.cnki.net/kns/request/SearchHandler.ashx', headers=headers, params=params)

本文介绍如何使用Python和XPath爬取知网专利信息。通过设置session获取cookie,结合专利类型筛选,实现数据的全面抓取。示例代码提供了一个获取页面数据的基础框架。

本文介绍如何使用Python和XPath爬取知网专利信息。通过设置session获取cookie,结合专利类型筛选,实现数据的全面抓取。示例代码提供了一个获取页面数据的基础框架。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1917

1917

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?