2.3 Kernel Methods 核方法

- recall: 在2.2.2部分,我们看到,general linear basis models 通过依靠一组函数 { ϕj}\{\phi_j\}{ ϕj} 将输入 xi∈Rdx_i \in \mathbb{R}^dxi∈Rd 转换在 R\mathbb{R}R 上。而 { ϕj}\{\phi_j\}{ ϕj} 被称为 feature maps 特征映射,它们将从输入数据中提取 有用的特征,并允许我们在生成的空间 R\mathbb{R}R 中使用 线性模型。

- 这部分,我们将在 kernel methods 中广泛的应用这个想法。

2.3.1 最小二乘(revisited)

考虑 l2\mathcal{l}^2l2 - 正则最小二乘问题(也称为 ridge regression 岭回归),其 feature map 为 {

ϕj}j=0M−1\{\phi_j\}^{M-1}_{j=0}{

ϕj}j=0M−1 ,

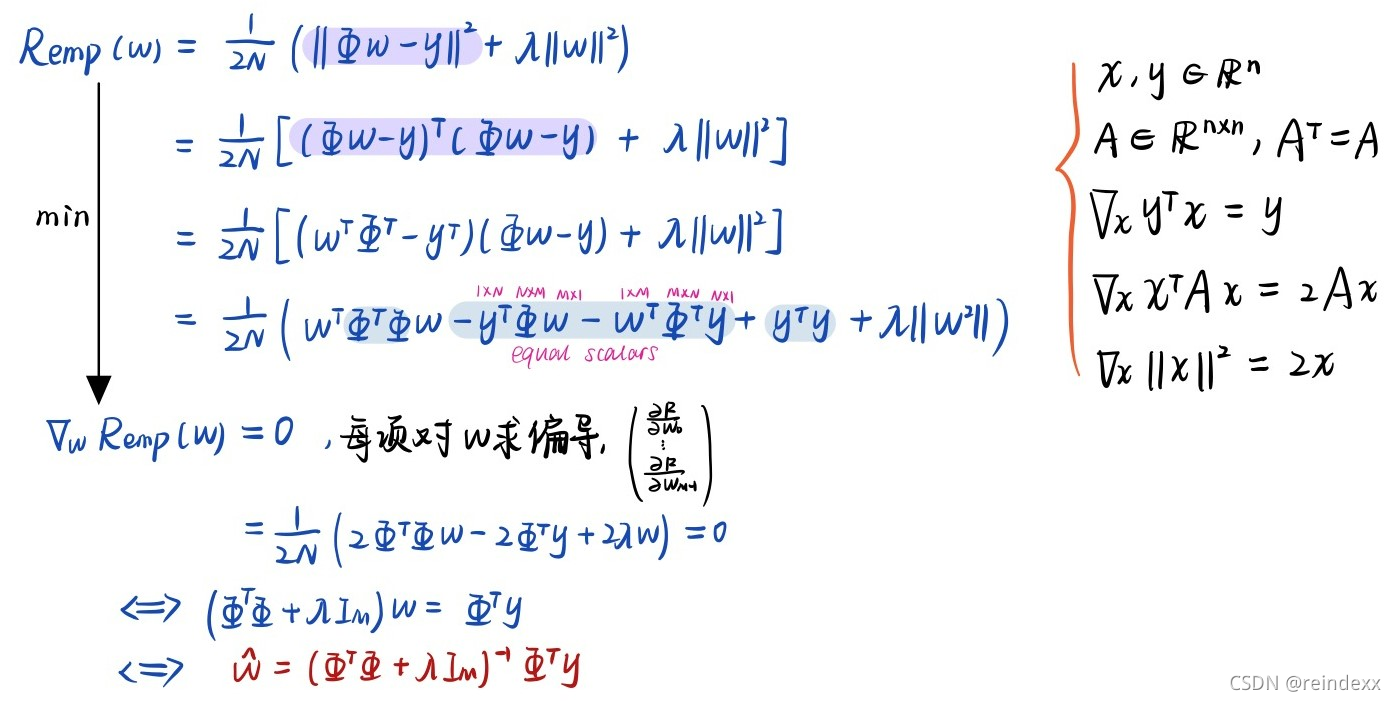

Remp(w)=12N(∣∣Φω−y∣∣2+λ∣∣ω∣∣2)(2.34) R_{emp}(w)=\frac{1}{2N}(||\Phi\omega-y||^2+\lambda||\omega||^2)\tag{2.34} Remp(w)=2N1(∣∣Φω−y∣∣2+λ∣∣ω∣∣2)(2.34)

回忆到 design matrix Φ\PhiΦ 的定义:

假设正则系数 λ>0\lambda\gt 0λ>0 ,和 Proposition 2.7,我们可以证明最小二乘的解可由下式得到:

w^=(ΦTΦ+λIM)−1ΦTy(2.35) \hat{w}=(\Phi^T\Phi+\lambda I_M)^{-1}\Phi^Ty\tag{2.35} w^=(ΦTΦ+λIM)−1ΦTy(2.35)

且预测输出为 y^=Φw^\hat{y}=\Phi\hat{w}y^=Φw^ 。

更普遍的情况下,在假设空间里的最佳逼近方程 f^\hat{f}f^ 对一个新的样本 x∈Rdx\in\mathbb{R}^dx∈Rd 做出如下预测:

f^(x)=ϕ(x)Tw^(2.36) \hat{f}(x)=\phi(x)^T\hat{w}\tag{2.36} f^(x)=ϕ(x)Tw^(2.36)

其中,ϕ(x)=(ϕ0(x),...,ϕM−1(x))\phi(x)=(\phi_0(x),...,\phi_{M-1}(x))ϕ(x)=(ϕ0(x),...,ϕM−1(x))。

注意到,不像 Proposition 2.7 ,我们在此处不需要可逆性的条件,因为 ΦTΦ+λIM\Phi^T\Phi+\lambda I_MΦTΦ+λIM 永远为正(λ>0\lambda\gt0λ>0),所以本身就是可逆的。

-

Exercise 2.14

推导正则化最小二乘解(2.35)。

-

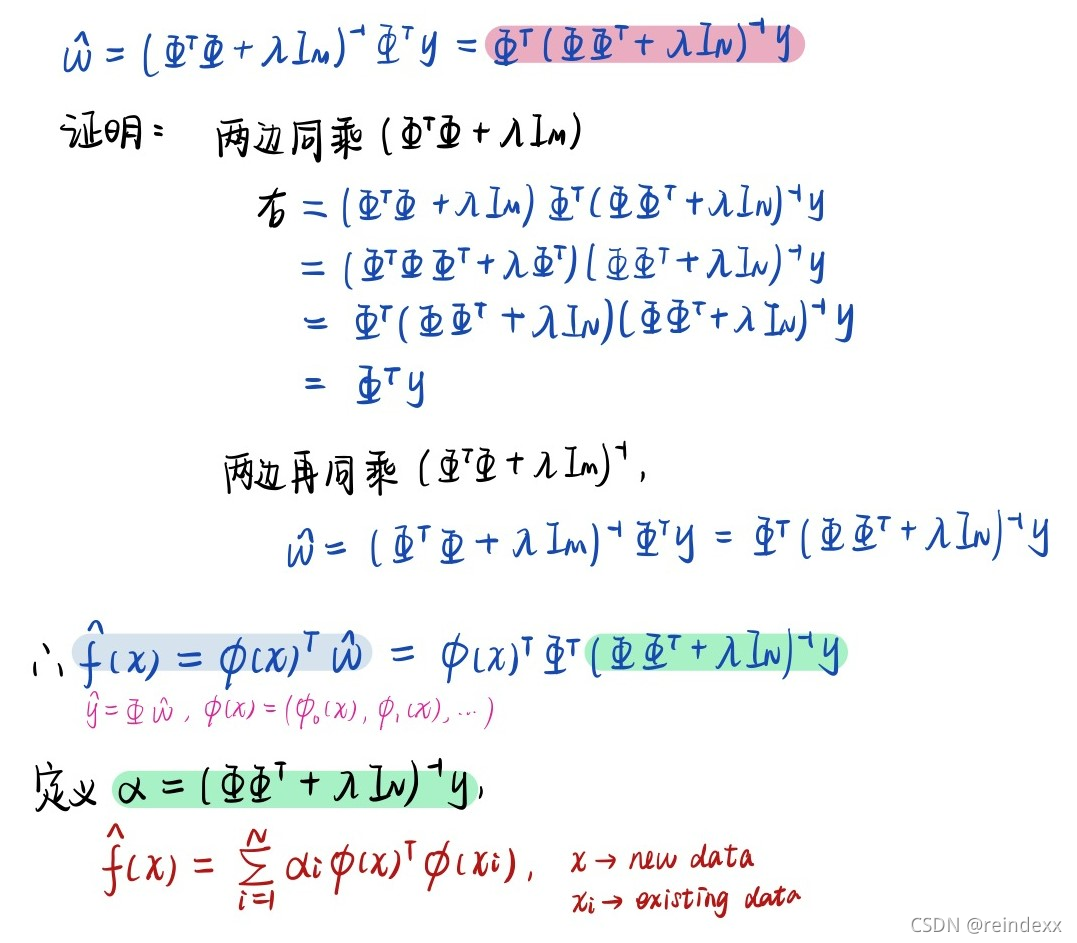

现考虑正则化最小二乘解的另一形式:

w^=(ΦTΦ+λIM)−1ΦTy=ΦT(ΦΦT+λIN)−1y(2.37) \hat{w}=(\Phi^T\Phi+\lambda I_M)^{-1}\Phi^Ty=\Phi^T(\Phi\Phi^T+\lambda I_N)^{-1}y\tag{2.37} w^=(ΦTΦ+λIM)−1ΦTy=ΦT(ΦΦT+λIN)−1y(2.37)

我们又可以得到:

f^(x)=∑i=1Nαiϕ(x)Tϕ(xi)(2.42) \hat{f}(x)=\sum^N_{i=1}\alpha_i\phi(x)^T\phi(x_i)\tag{2.42} f^(x)=i=1∑Nαiϕ(x)Tϕ(xi)(2.42)

式子(2.42)和(2.36)实际上是等价的。

说明啥?

注意到,N×NN \times NN×N 的矩阵 ΦΦT\Phi\Phi^TΦΦT 的第 iii 和 jjj 部分可以写成 ϕ(xi)Tϕ(xj)\phi(x_i)^T\phi(x_j)ϕ(xi)Tϕ(xj) 。因此,不像式子(2.36),式子(2.42)只取决于 feature map ϕ\phiϕ by 函数 (x,x′)↦ϕ(x)Tϕ(x′)(x,x')\mapsto \phi(x)^T\phi(x')

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?