调参核心

- 调参1:提高准确率":num_leaves, max_depth, learning_rate

- 调参2:降低过拟合 max_bin min_data_in_leaf

- 调参3:降低过拟合 正则化L1, L2

- 调参4:降低过拟合 数据抽样 列抽样

调参方向:处理过拟合(过拟合和准确率往往相反)

-

使用较小的

max_bin -

使用较小的

num_leaves -

使用

min_data_in_leaf和min_sum_hessian_in_leaf -

通过设置

bagging_fraction和bagging_freq来使用bagging -

通过设置

feature_fraction <1来使用特征抽样 -

使用更大的训练数据

-

使用

lambda_l1, lambda_l2和min_gain_to_split来使用正则 -

尝试

max_depth来避免生成过深的树

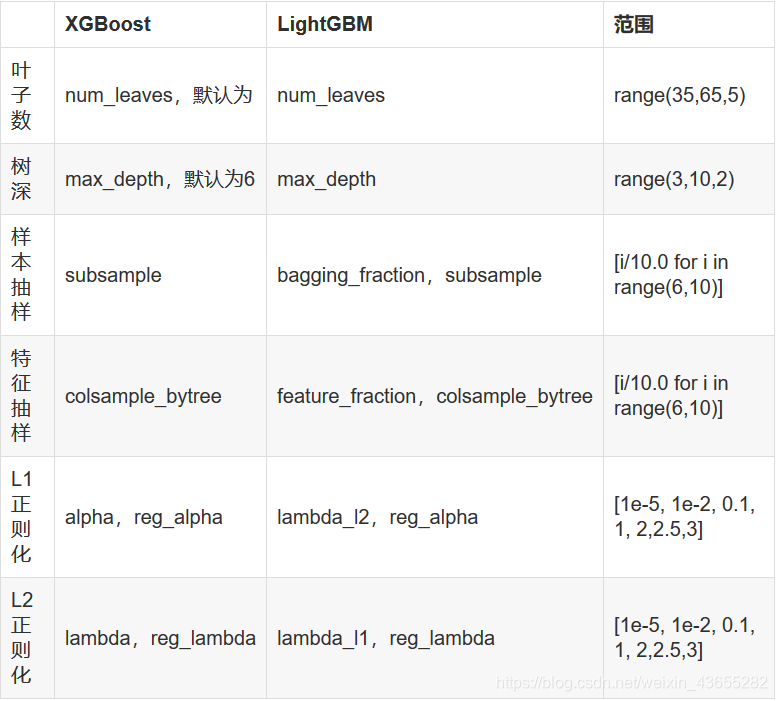

调参范围

本文探讨了针对过拟合问题的模型调参策略,包括调整num_leaves、max_depth、learning_rate等参数以提高预测准确性,以及通过数据抽样、正则化等手段降低过拟合风险。

本文探讨了针对过拟合问题的模型调参策略,包括调整num_leaves、max_depth、learning_rate等参数以提高预测准确性,以及通过数据抽样、正则化等手段降低过拟合风险。

627

627

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?