- 目录

- 目标

- 定向爬虫思路

- 代码

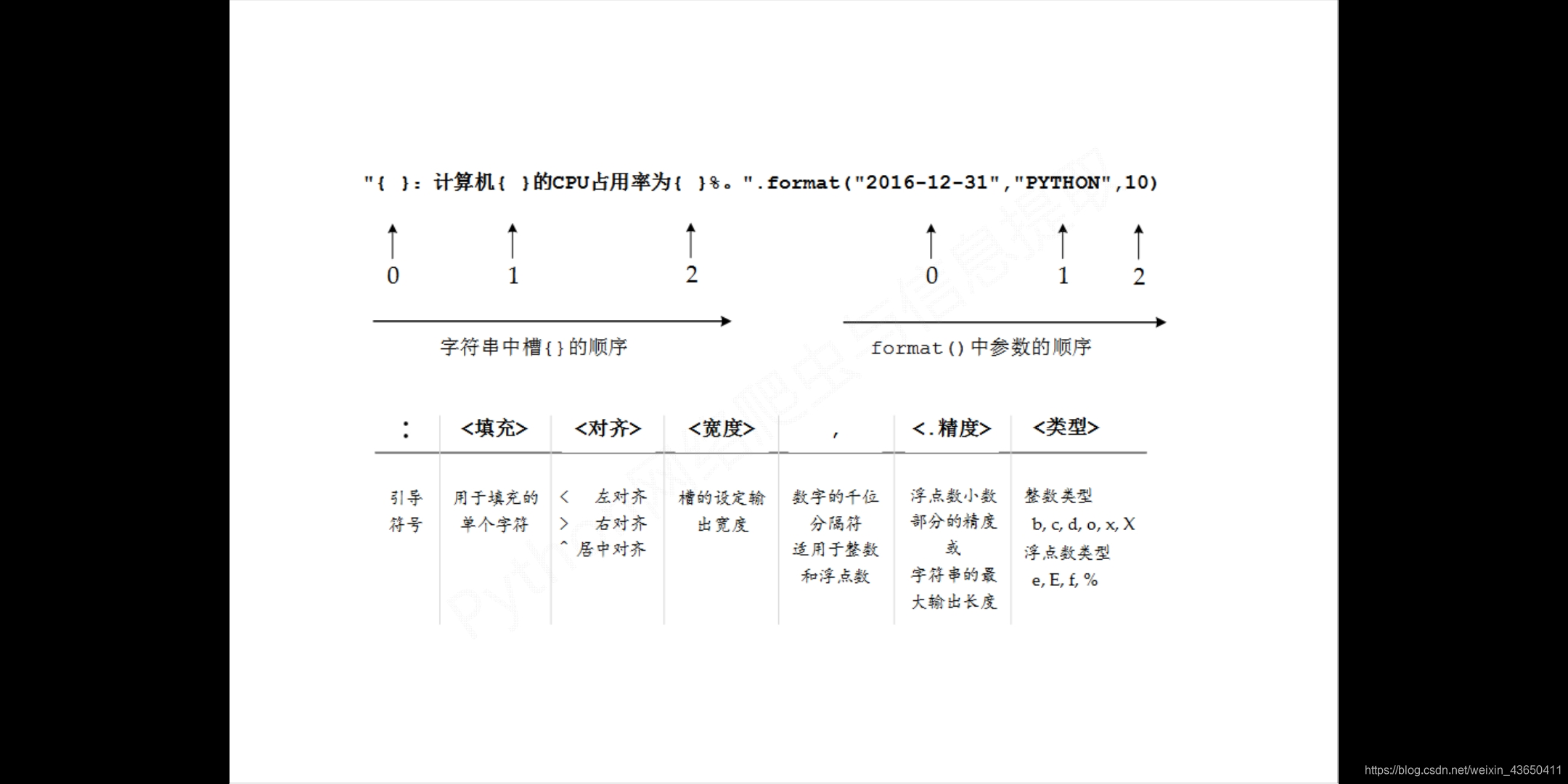

- 复习format(优化中英输出排版)

- 附注:Mooc-python网络爬虫与信息提取

- 目的

从最好大学网,获取:大学排名、名称、总分 - 思路:定向爬虫

- 仅对输入url爬取,不拓展

- 结构设计

- 获取大学排名 – getHtmlText()

- 提取网页内容至合适结构 – fillUnivList()

- 展示 – printUnivList()

- 接口设计

- 编程

- 代码

# -*- coding: utf-8 -*-

'''

从最好大学网,获取:大学排名、名称、总分

1.获取网页

2.解析网面

3.输入

- 查询网站robots公告,发现无公告,默认随意爬

- 编程提取前30名

- 查看网页源码

-

'''

from bs4 import BeautifulSoup

import requests, bs4

class spider(object):

def __init__(self):

self.url = 'http://www.zuihaodaxue.com/zuihaodaxuepaiming2019.html'

self.__ulist = []

def getHtmlText(self):

try:

req = requests.get(self.url)

req.raise_for_status()

req.encoding = req.apparent_encoding

return req.text

except Exception as e:

return '产生异常:{}'.format(e)

def fillUnivList(self):

soup = BeautifulSoup(self.getHtmlText(), 'html.parser')

for tr in soup.find('tbody').children:

if isinstance(tr, bs4.element.Tag): # 所有的信息都储存在td标签中,信息过滤

tds = tr('td')

self.__ulist.append([tds[0].string, tds[1].string, tds[3].string])

def printUnivList(self, num):

tplt = "{0:^10}\t{1:{3}^30}\t{2:^10}" # char(12288) 中文空格;由于py默认使用英文空格填充长度多出来的部分,影响排版

print(tplt.format('排名', '学校名称', '总分', chr(12288)))

for i in range(num):

u = self.__ulist[i]

print(tplt.format(u[0], u[1], u[2], chr(12288)))

def main():

sp = spider()

sp.fillUnivList()

sp.printUnivList(20)

if __name__ == '__main__':

main()

排名 学校名称 总分

1 清华大学 94.6

2 北京大学 76.5

3 浙江大学 72.9

4 上海交通大学 72.1

5 复旦大学 65.6

6 中国科学技术大学 60.9

7 华中科技大学 58.9

7 南京大学 58.9

9 中山大学 58.2

10 哈尔滨工业大学 56.7

11 北京航空航天大学 56.3

12 武汉大学 56.2

13 同济大学 55.7

14 西安交通大学 55.0

15 四川大学 54.4

16 北京理工大学 54.0

17 东南大学 53.6

18 南开大学 52.8

19 天津大学 52.3

20 华南理工大学 52.0

[Finished in 5.6s]

-

复习

.format()

-

Review & Optimation

# -*- coding: utf-8 -*-

'''

- 2019.6.7

- 1.查看网站robots公告

- 2.获取html

- 3.解析网页,并用适当的方式存储

- 4.以合适的格式输出存储

'''

from bs4 import BeautifulSoup

import requests, bs4

class spider(object):

def __init__(self):

self.url = 'http://www.zuihaodaxue.com/zuihaodaxuepaiming2019.html'

self.ulist = []

pass

def getHtmlText(self):

try:

req = requests.get(self.url)

req.raise_for_status()

req.encoding = req.apparent_encoding

return req.text

except Exception as e:

return '产生异常:{}'.format(e)

def parserHtml(self, html):

soup = BeautifulSoup(html, 'html.parser')

for tr in soup.find('tbody').children:

if isinstance(tr, bs4.element.Tag):

univ = tr('td')

self.ulist.append([univ[0].string, univ[1].string, univ[3].string])

def printRank(self, num):

fmt = '\t{0:^10}\t{1:{3}^30}\t{2:^10}'

print(fmt.format('排名', '大学名称', '评分', chr(12288)))

for i in self.ulist[:num]:

print(fmt.format(i[0], i[1], i[2], chr(12288)))

def main():

sp = spider()

sp.parserHtml(sp.getHtmlText())

sp.printRank(30)

if __name__ == '__main__':

main()

排名 大学名称 评分

1 清华大学 94.6

2 北京大学 76.5

3 浙江大学 72.9

4 上海交通大学 72.1

5 复旦大学 65.6

6 中国科学技术大学 60.9

7 华中科技大学 58.9

7 南京大学 58.9

9 中山大学 58.2

10 哈尔滨工业大学 56.7

11 北京航空航天大学 56.3

12 武汉大学 56.2

13 同济大学 55.7

14 西安交通大学 55.0

15 四川大学 54.4

16 北京理工大学 54.0

17 东南大学 53.6

18 南开大学 52.8

19 天津大学 52.3

20 华南理工大学 52.0

21 中南大学 50.3

22 北京师范大学 49.7

23 山东大学 49.1

23 厦门大学 49.1

25 吉林大学 48.9

26 大连理工大学 48.6

27 电子科技大学 48.4

28 湖南大学 48.1

29 苏州大学 47.3

30 西北工业大学 46.7

[Finished in 5.4s]

该博客介绍了如何使用Python进行定向爬虫,以从最好大学网站抓取大学的排名、名称和总分信息。通过getHtmlText()获取网页内容,fillUnivList()进行内容提取并结构化,最后printUnivList()展示结果。文章还涉及了代码的编写和复习,对format函数的使用进行了优化,以改善中英输出的排版。

该博客介绍了如何使用Python进行定向爬虫,以从最好大学网站抓取大学的排名、名称和总分信息。通过getHtmlText()获取网页内容,fillUnivList()进行内容提取并结构化,最后printUnivList()展示结果。文章还涉及了代码的编写和复习,对format函数的使用进行了优化,以改善中英输出的排版。

2153

2153

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?