目录

一、Spark简介

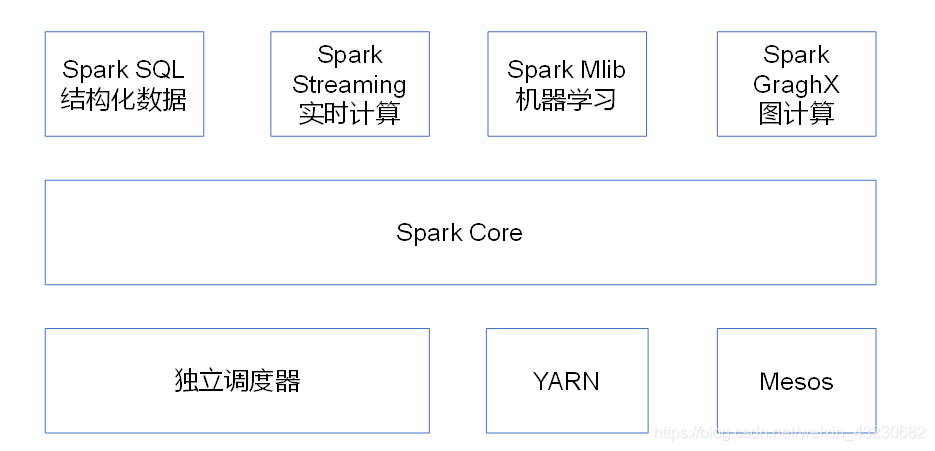

1、内置模块介绍

Spark Core:实现了Spark的基本功能,包含任务调度、内存管理、错误恢复、与存储系统交互等模块。Spark Core中还包含了对弹性分布式数据集(Resilient Distributed DataSet,简称RDD)的API定义。

Spark SQL:是Spark用来操作结构化数据的程序包。通过Spark SQL,我们可以使用 SQL或者Apache Hive版本的SQL方言(HQL)来查询数据。Spark SQL支持多种数据源,比如Hive表、Parquet以及JSON等。

Spark Streaming:是Spark提供的对实时数据进行流式计算的组件。提供了用来操作数据流的API,并且与Spark Core中的 RDD API高度对应。

Spark MLlib:提供常见的机器学习(ML)功能的程序库。包括分类、回归、聚类、协同过滤等,还提供了模型评估、数据 导入等额外的支持功能。

集群管理器:Spark 设计为可以高效地在一个计算节点到数千个计算节点之间伸缩计 算。为了实现这样的要求,同时获得最大灵活性,Spark支持在各种集群管理器(Cluster Manager)上运行,包括Hadoop YARN、Apache Mesos,以及Spark自带的一个简易调度 器,叫作独立调度器。

Spark得到了众多大数据公司的支持,这些公司包括Hortonworks、IBM、Intel、Cloudera、MapR、Pivotal、百度、阿里、腾讯、京东、携程、优酷土豆。当前百度的Spark已应用于大搜索、直达号、百度大数据等业务;阿里利用GraphX构建了大规模的图计算和图挖掘系统,实现了很多生产系统的推荐算法;腾讯Spark集群达到8000台的规模,是当前已知的世界上最大的Spark集群。

2、Spark特点

二、Spark基本架构和运行流程

1、基本架构

Spark基本概念:

1)Application:用户编写的Spark应用程序。

2)Driver:是Spark的驱动器,是执行开发程序中的main方法的进程。它负责开发人员编写的用来创建SparkContext、创建RDD,以及进行RDD的转化操作和行动操作代码的执行。如果你是用spark shell,那么当你启动Spark shell的时候,系统后台自启了一个Spark驱动器程序,就是在Spark shell中预加载的一个叫作 sc的SparkContext对象。如果驱动器程序终止,那么Spark应用也就结束了。主要负责:

- 把用户程序转为作业(JOB)

- 跟踪Executor的运行状况

- 为执行器节点调度任务

- UI展示应用运行状况

3)Executor:是一个工作进程,负责在 Spark 作业中运行Task任务,任务间相互独立。Spark 应用启动时,Executor节点被同时启动,并且始终伴随着整个 Spark 应用的生命周期而存在。如果有Executor节点发生了故障或崩溃,Spark 应用也可以继续执行,会将出错节点上的任务调度到其他Executor节点上继续运行。主要负责:

- 负责运行组成 Spark 应用的任务,并将结果返回给驱动器进程;

- 通过自身的块管理器(Block Manager)为用户程序中要求缓存的RDD提供内存式存储。RDD是直接缓存在Executor进程内的,因此任务可以在运行时充分利用缓存数据加速运算。

4)RDD:弹性分布式数据集,是分布式内存的一个抽象概念,提供了一种高度受限的共享内存模型(后面详解)。

5)DAG:DAG(Directed Acyclic Graph)叫做有向无环图,原始的RDD通过一系列的转换就就形成了DAG,根据RDD之间的依赖关系的不同将DAG划分成不同的Stage,对于窄依赖,partition的转换处理在Stage中完成计算。对于宽依赖,由于有Shuffle的存在,只能在parent RDD处理完成后,才能开始接下来的计算,因此宽依赖是划分Stage的依据。

6)Task:运行在Executor上的工作单元。

7)Job:一个Job包含多个RDD及作用于相应RDD上的各种操作。

8)Stage:是Job的基本调度单位,一个Job会分为多组Task,每组Task被称为Stage,或者也被称为TaskSet,代表一组关联的,相互之间没有Shuffle依赖关系的任务组成的任务集。

9)Cluter Manager:指的是在集群上获取资源的外部服务。目前有三种类型

- Standalon : spark原生的资源管理,由Master负责资源的分配

- Apache Mesos:与hadoop MR兼容性良好的一种资源调度框架

- Hadoop Yarn: 主要是指Yarn中的ResourceManager

一个Application由一个Driver和若干个Job构成,一个Job由多个Stage构成,一个Stage由多个没有Shuffle关系的Task组成。

当执行一个Application时,Driver会向集群管理器申请资源,启动Executor,并向Executor发送应用程序代码和文件,然后在Executor上执行Task,运行结束后,执行结果会返回给Driver,或者写到HDFS或者其它数据库中。

本文详细介绍了Spark的架构,包括内置模块如Spark Core、Spark SQL、Spark Streaming和Spark MLlib,以及Spark在集群管理器上的运行。此外,文章深入探讨了RDD的概念,包括其属性、特点、依赖关系、缓存和CheckPoint,展示了RDD在Spark计算模型中的关键作用。

本文详细介绍了Spark的架构,包括内置模块如Spark Core、Spark SQL、Spark Streaming和Spark MLlib,以及Spark在集群管理器上的运行。此外,文章深入探讨了RDD的概念,包括其属性、特点、依赖关系、缓存和CheckPoint,展示了RDD在Spark计算模型中的关键作用。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2504

2504

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?