非正常关闭hdfs 并且节点还没全部起来就开始格式化

然后怎么格式化都不会出现集群所有节点出来

解决办法:

1、删除文件重新格式化

可以选择 删除所有节点的/var/hadoop-data/dfs/data/current文件 然后在NN里格式化 就会再次生成了

格式化前 需要 先启动JN hadoop-daemon.sh start journalnode node02 03 04 逐个启动

hdfs格式化命令(hdfs namenode -format)时,这时namenode的clusterID会重新生成,而datanode的clusterID 保持不变。

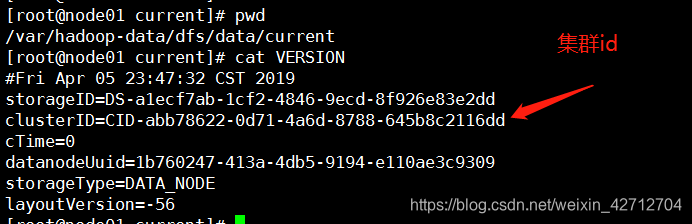

2、修改集群id

在/var/hadoop-data/dfs/data/current文件夹下 进入VERSION

解决办法 将NN的clisterID 复制到其他去 然后单独重启DN

hadoop-daemon.sh start datanode

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?