1概述

了解一个框架就去它的官网上看 http://flume.apache.org/

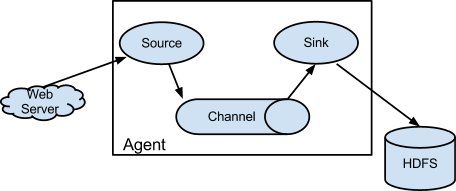

Flume is a distributed, reliable, and available service for efficiently collecting, aggregating, and moving large amounts of log data. It has a simple and flexible architecture based on streaming data flows. It is robust and fault tolerant with tunable reliability mechanisms and many failover and recovery mechanisms. It uses a simple extensible data model that allows for online analytic application.

使用:使用flume的关键就是写配置文件

A) 配置Source

B) 配置Channel

C) 配置Sink

D) 把它们串联起来

第一种方式:从网络端口采集数据输出到控制台

netcat source +memory channel +logger sink

# Name the components on this agent 定义这个Agent名称为a1,sources,sinks,channels名称为r1,k1,c1

a1.sources = r1

a1.sinks = k1

a1.channels = c1

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

3654

3654

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?