LangFlow与市场调研结合:消费者偏好挖掘

在电商平台每天产生数百万条用户评论的今天,企业如何从海量非结构化文本中快速提炼出有价值的消费者洞察?传统的市场调研方式——比如人工阅读问卷、组织焦点小组——不仅耗时长,而且容易受主观判断影响。当一款新产品上线后,团队等不起两周才拿到分析报告。他们需要的是实时反馈、自动化处理和可复现的分析逻辑。

正是在这种背景下,生成式AI与自然语言处理技术开始深度介入市场研究领域。而真正让这项能力“飞入寻常业务部门”的,不是复杂的代码工程,而是一个看似简单的工具:LangFlow。

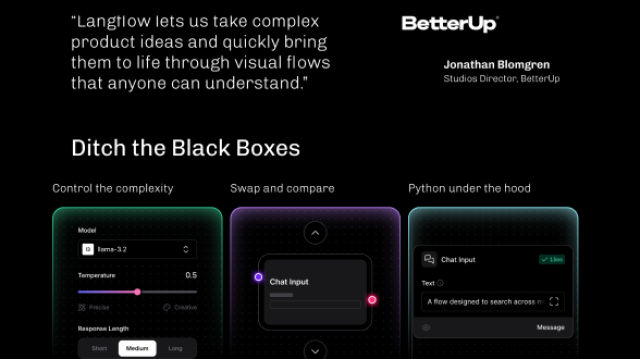

LangFlow 并不神秘。它本质上是一个基于 Web 的可视化工作流平台,专为 LangChain 生态设计。你可以把它想象成“AI版的流程图编辑器”:把大模型、提示词、数据源、输出解析等功能模块做成一个个可拖拽的节点,用连线定义它们之间的数据流动。不需要写一行 Python 代码,就能构建一个完整的 LLM 应用原型。

这种“所见即所得”的开发模式,对于市场研究人员来说意义重大。过去,想让大模型自动总结用户评论中的偏好点,必须依赖算法工程师写脚本;现在,产品经理自己就可以在下午茶时间搭好一个分析流水线,并立刻看到结果。

它的底层其实还是 LangChain 那套东西——模块化组件、链式调用、向量检索、输出解析……但 LangFlow 把这些抽象概念转化成了图形界面里的按钮和输入框。你不必知道 LLMChain 是什么,只需要知道“我把提示模板连到模型上,就能出结果”。

举个最简单的例子。假设我们有一段用户对耳机的评价:“音质不错,佩戴舒服,就是价格偏高。”

通过 LangFlow 搭建的工作流可以自动输出:

{

"positive_keywords": ["音质好", "佩戴舒适"],

"negative_keywords": ["价格贵"],

"suggestion": "考虑推出更具性价比的版本"

}

这个过程是怎么实现的?

首先,在画布上拉入一个 Prompt Template 节点,设置如下提示词:

请从以下用户评论中提取:

1. 正面评价关键词(最多3个)

2. 负面评价关键词(最多3个)

3. 改进建议(一句话概括)

评论内容:{input}

输出格式:JSON

然后连接一个 LLM 节点,比如选择 HuggingFace 上的 google/flan-t5-large 或者 OpenAI 的 gpt-3.5-turbo。再接一个 JsonOutputParser 节点确保返回结构合法。最后运行流程,输入原始文本,系统就会一步步执行并展示每一步的结果。

这背后对应的其实是标准的 LangChain 代码逻辑:

from langchain.prompts import PromptTemplate

from langchain_community.llms import HuggingFaceHub

from langchain.chains import LLMChain

from langchain.output_parsers import PydanticOutputParser

from pydantic import BaseModel, Field

class AnalysisResult(BaseModel):

positive_keywords: list[str] = Field(..., description="正面关键词")

negative_keywords: list[str] = Field(..., description="负面关键词")

suggestion: str = Field(..., description="改进建议")

parser = PydanticOutputParser(pydantic_object=AnalysisResult)

prompt = PromptTemplate(

input_variables=["input"],

template="请从以下用户评论中提取...\n{format_instructions}\n评论内容:{input}"

).partial(format_instructions=parser.get_format_instructions())

llm = HuggingFaceHub(repo_id="google/flan-t5-large")

chain = LLMChain(llm=llm, prompt=prompt, output_parser=parser)

result = chain.run("这个耳机音质很好,佩戴也很舒适,就是价格有点贵。")

但在 LangFlow 中,这一切都被封装成了图形操作。更重要的是,它支持实时预览——点击任意节点,你能立刻看到它的输入输出。这对调试提示词特别有用。当你发现模型总是漏掉某个维度的信息时,可以直接修改提示语,重新运行,几秒钟内就能验证效果。

回到实际应用场景。某家电品牌刚发布了一款空气净化器,急需了解用户的真实反馈。他们收集了京东、天猫上的 2000 条评论,准备做一次深度分析。

如果采用传统方式,可能需要安排两名分析师花三天时间逐条阅读、归类、汇总。而现在,他们的市场专员打开了本地部署的 LangFlow 实例,开始搭建自动化流程:

- 使用 File Loader 节点加载 CSV 文件;

- 通过 Text Splitter 将长评论切分为语义完整的片段;

- 接入 HuggingFace Embeddings 生成文本向量;

- 存入 FAISS Vector Store 构建本地索引,便于后续相似内容检索;

- 设计结构化提示模板,要求模型提取正负向关键词与改进建议;

- 调用 ChatOpenAI 或国产模型如 Qwen 进行推理;

- 最终由 JsonOutputParser 输出标准化 JSON 结果。

整个流程像搭积木一样完成。运行后,系统在不到十分钟内完成了全部评论的处理,并将结果导出为结构化数据,供 BI 工具进一步生成可视化报表。

更关键的是,这套流程是可复用、可迭代的。下次分析新产品的用户反馈时,只需替换数据源和微调提示词即可。团队甚至可以把这个工作流保存为模板,成为公司级的“消费者声音(VoC)分析标准流程”。

在这个过程中,LangFlow 解决了市场调研中的三个核心痛点:

一是效率问题。人工分析一条评论平均需 30 秒,一天最多处理 1000 条;而 LLM 流程每秒可处理多条,单日处理十万级评论毫无压力。

二是一致性问题。不同分析师对同一句话的理解可能存在偏差,例如有人认为“还行”是中性评价,有人视为轻微负面。而固定提示词+统一模型保证了分析标准的一致性。

三是深层洞察挖掘能力。LLM 不只是关键词匹配,它能理解语义关联。例如,“晚上开着也不吵”被准确归纳为“低噪声运行”,并进一步推导出“适合夜间使用”这一潜在场景。这类隐性需求往往是产品创新的关键突破口。

当然,好用不代表无门槛。我们在实践中也发现几个必须注意的设计要点。

首先是提示工程的质量直接决定输出质量。很多初学者会写出模糊的指令,比如“总结一下用户的看法”。这样的提示会导致模型自由发挥,输出杂乱无章。正确的做法是明确结构、限定长度、提供示例(few-shot learning)。例如:

示例输入:电池续航很强,充一次能用一周。

示例输出:{“battery_life”: “优秀”, “usability”: “高”}现在请分析:充电速度很快,半小时充满80%。

这种方式能显著提升模型遵循指令的能力。

其次是模型选型要贴合业务场景。虽然 GPT-4 效果最好,但中文理解不一定优于专门优化过的国产模型。像通义千问、ChatGLM3、百川等在中文电商评论分析任务中表现优异,且支持本地部署,更适合涉及敏感数据的企业环境。

第三是上下文管理。不要试图一次性输入整篇万字访谈记录。超出 token 限制会导致信息截断。合理的做法是先分块处理,再通过聚合节点进行二次归纳。LangFlow 支持嵌套流程和条件分支,完全可以实现“先分后总”的复杂逻辑。

第四是安全与合规。客户的真实对话、未公开的产品反馈属于敏感信息。建议在内网环境中运行 LangFlow,关闭公网访问权限,避免数据外泄风险。同时,所有流程配置都应以 .json 文件形式存档,做到版本可控、过程可追溯。

LangFlow 的出现,标志着 AI 应用开发正在经历一场“民主化”变革。它没有取代程序员,而是让更多非技术人员也能参与智能系统的构建。市场分析师不再只是提需求的人,他们可以亲手搭建分析工具,即时验证假设,快速响应业务变化。

未来,随着更多行业专用组件的集成——比如电商评论情感强度评分器、竞品对比矩阵生成器、NPS 归因分析模块——LangFlow 完全有可能演变为一个通用的 AI 市场研究平台。企业不再需要组建庞大的数据科学团队,也能具备强大的消费者洞察能力。

这种高度集成、低代码驱动的分析范式,正在重塑我们获取商业智慧的方式。它的价值不仅在于节省了多少工时,更在于让决策链条变得更短、更敏捷、更贴近真实用户的声音。

当一个产品经理能在周五下午上传一批新评论,周一早上就拿着结构化洞察走进会议室时,我们就知道:下一代市场调研,已经来了。

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

5万+

5万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?