LangFlow创业扶持基金投资方向说明

在AI技术快速渗透各行各业的今天,一个现实问题摆在许多创业者面前:如何在没有庞大工程团队的情况下,快速验证一个基于大语言模型(LLM)的商业想法?传统开发模式要求精通Python、熟悉LangChain API、能处理异构服务集成——这对早期项目而言,成本太高、周期太长。

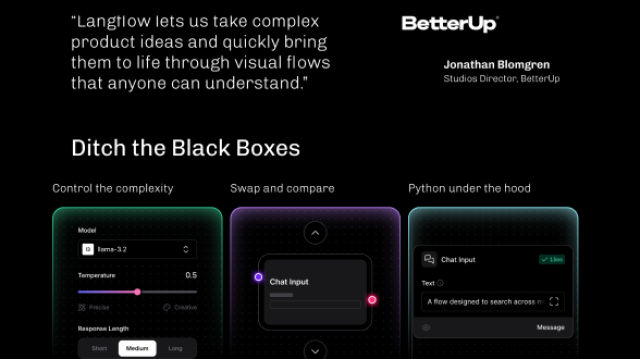

正是在这种背景下,LangFlow 走到了舞台中央。它不是另一个AI模型,也不是某种新型算法,而是一种“让普通人也能构建智能系统”的方式。通过拖拽组件、连线逻辑、实时调试,用户可以在几小时内完成原本需要数天才能实现的AI流程原型。这种效率跃迁,正在重新定义AI产品的创新节奏。

LangFlow本质上是一个为LangChain生态量身打造的可视化开发环境。它的核心理念很简单:把复杂的代码逻辑转化为可视化的“积木拼接”。每一个功能模块——无论是调用大模型、生成提示词,还是检索知识库——都被封装成一个图形节点。你不需要写一行代码,就能把这些节点连接起来,形成一条完整的AI工作流。

这听起来像是低代码平台的老套路,但在AI领域,它的意义完全不同。因为AI系统的复杂性不在于语法,而在于链式结构的设计与调试。比如,你是先做意图识别再查数据库,还是反过来?提示词模板是否覆盖了边缘情况?中间输出有没有被污染?这些问题在纯代码中很难直观发现,而在LangFlow里,每一步都有迹可循。

整个系统的运行机制其实非常清晰。当你在界面上完成节点连接后,LangFlow会将这个图形结构解析成一个有向无环图(DAG),然后进行拓扑排序,确定执行顺序。接着,它可以有两种处理方式:一种是直接调用LangChain运行时来执行;另一种是生成标准的Python代码供后续部署使用。这意味着,你在前端看到的每一条连线,背后都对应着真实的数据流向和函数调用。

更关键的是,这套系统支持双向同步。如果你修改了某个节点的参数,底层代码自动更新;反之,如果你用脚本调整了逻辑,图形界面也能反向渲染出来。这种“所见即所得”的能力,极大提升了协作效率。产品经理可以参与流程设计,运营人员可以测试不同策略,而工程师则专注于高阶优化——角色之间的鸿沟被填平了。

我们来看一个实际案例。假设一家初创公司想做一个智能客服助手,目标是从内部文档中提取答案并自然回应用户提问。传统做法可能需要:

- 写代码接入LLM API

- 构建提示模板

- 集成向量数据库做语义检索

- 处理异常输入

- 实现缓存和日志记录

整个过程至少需要3到5个工作日,且高度依赖全栈AI工程师。而在LangFlow中,同样的流程可以这样完成:

- 拖入

TextInput节点接收用户问题; - 连接到

PromptTemplate节点构造查询语句; - 接入

VectorStoreRetriever查找最相关的FAQ条目; - 将结果传给

LLM节点生成最终回复; - 输出到前端界面。

整个链条只需几个小时即可搭建完毕,并立即投入测试。你可以输入“忘记密码怎么办”,然后逐节点查看输出:提示词填充是否正确?检索返回的文档是否相关?LLM的回答是否准确?所有中间状态一目了然。

# 实际上,这条链对应的代码可能是这样的:

from langchain.prompts import PromptTemplate

from langchain_community.llms import HuggingFaceHub

from langchain.chains import LLMChain

prompt = PromptTemplate(

input_variables=["topic"],

template="请简要介绍 {topic} 的基本原理及其应用场景。"

)

llm = HuggingFaceHub(repo_id="google/flan-t5-large", model_kwargs={"temperature": 0.7})

chain = LLMChain(llm=llm, prompt=prompt)

result = chain.run(topic="量子计算")

这段代码并不复杂,但对于非程序员来说仍是一道门槛。而LangFlow的作用,就是把这类逻辑变成可视操作,让更多人能参与进来。

LangFlow的技术架构也颇具前瞻性。前端基于React构建,提供流畅的画布交互体验;后端采用FastAPI暴露REST接口,处理工作流保存、运行请求等操作;运行时则依赖LangChain核心框架执行具体任务。外部服务如OpenAI、Pinecone、Chroma等均可无缝接入。

更重要的是,它是可扩展的。开发者可以通过注册自定义Python类的方式添加新节点。例如,如果你有一个私有API用于订单查询,完全可以封装成一个工具节点,供团队其他成员复用。这种开放性使得LangFlow不仅能用于原型验证,还能逐步演进为生产级系统的开发平台。

当然,使用过程中也有一些值得注意的设计考量。我们在多个早期项目中观察到一些常见误区:

- 节点过多导致失控:有些团队试图在一个工作流中塞进20多个节点,结果调试极其困难。建议单个流程控制在10个节点以内,必要时拆分为子流程或微服务。

- 忽略安全性:API密钥硬编码在节点配置中是非常危险的行为。正确的做法是通过环境变量注入,结合权限管理系统隔离敏感信息。

- 缺乏版本管理:很多人只在界面上操作,却不保存导出的JSON文件。一旦服务器崩溃,所有进度清零。最佳实践是将工作流导出为

.json并纳入Git管理,实现变更追踪与协作审查。 - 盲目信任可视化结果:虽然实时预览很方便,但生成的代码可能存在性能瓶颈或冗余调用。定期检查底层LangChain代码仍然是必要的。

从投资角度看,LangFlow之所以值得专门设立创业扶持基金,是因为它改变了创新的经济模型。过去,AI创业往往是“重资产”游戏:你需要融资百万才能雇得起算法工程师;而现在,一个人、一台笔记本、一个LangFlow实例,就可以跑通整个MVP逻辑。

我们关注的项目类型包括但不限于:

- 利用LangFlow快速构建行业专属聊天机器人的团队,比如法律咨询、医疗问答、教育辅导;

- 基于可视化流程实现自动化SOP的企业服务工具,如客户工单分类、合同条款提取;

- 结合RAG(检索增强生成)架构,在垂直领域打造知识中枢的产品;

- 将LangFlow作为内部AI赋能平台,提升非技术人员生产力的组织。

这些项目的共同特点是:不追求最前沿的模型,而是追求最快触达用户的路径。他们未必拥有顶尖的AI人才,但他们懂得如何用工具放大杠杆效应。

值得一提的是,LangFlow并非孤立存在。它正处于一个更大的趋势之中——AI开发的“图形化+低代码”转型。类似Node-RED之于物联网,Unreal Blueprint之于游戏开发,LangFlow正在成为AI应用的“可视化编程语言”。未来,我们甚至可能看到“流程即产品”的形态:投资人不再看PRD文档,而是直接运行一个LangFlow工作流来评估项目可行性。

这也意味着,创业的竞争维度正在转移。不再是“谁有更好的模型”,而是“谁有更好的流程设计能力”。谁能更快地迭代逻辑、谁能更精准地捕捉用户意图、谁能更灵活地整合工具链,谁就更有可能赢得市场。

LangFlow创业扶持基金的投资逻辑正源于此:我们寻找那些善于利用工具降低创新成本、以敏捷方式验证商业假设的早期团队。我们不在乎你是否会写复杂的PyTorch代码,也不要求你训练自己的大模型。我们关心的是:你是否能用最短路径把一个想法变成可交互的产品?你是否能让非技术人员也成为AI系统的共建者?

在这个AI民主化的时代,真正的壁垒不再是技术本身,而是对场景的理解力与快速行动的能力。而LangFlow,正是让小团队也能发起闪电战的那把枪。

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

1845

1845

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?