简介:MPI(Message Passing Interface)是一种用于分布式内存系统的并行计算通信接口标准,广泛应用于高性能计算领域。本文介绍了MPI的基础程序示例——“Hello World”,演示了如何使用MPI的通信原语在多个进程间传递信息。示例中,”hello_mpi.c”程序展示了如何初始化MPI环境、获取进程ID和大小,以及如何打印出带有进程ID的”Hello, World!”消息。同时,文章提供了编译和运行该程序的Makefile规则和命令,以及MPI的关键通信原语。掌握MPI对于开发高效的并行算法至关重要,它支持科学计算、数据分析和机器学习等多个领域。

1. MPI简介和并行程序编写

1.1 并行计算背景

随着科技的发展,对高性能计算的需求日益增长。并行计算作为处理大量数据和复杂计算的有效方法,已成为IT行业的重要研究领域。消息传递接口(MPI)作为一种成熟的并行编程标准,广泛应用于科学计算和工程计算中,使得开发者可以编写能够在多处理器环境中运行的程序。

1.2 MPI的定义和特性

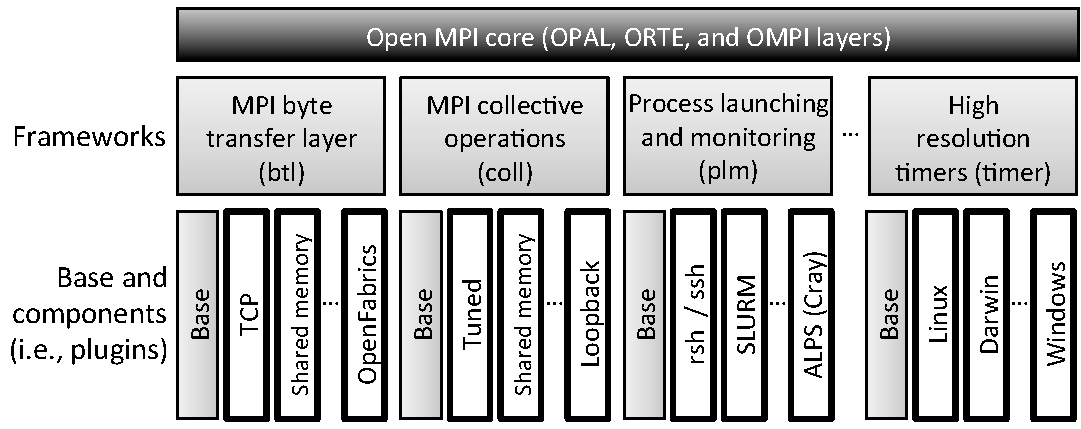

消息传递接口(MPI)是针对分布式存储和共享内存系统的并行计算,提供了丰富的进程间通信函数。MPI不仅支持点对点通信,还支持集合通信,让数据在多个进程间高效流通。它拥有高度的可移植性,能够在各种架构的计算机上运行,从普通的多核工作站到大型并行计算机集群。

1.3 并行程序编写基础

并行程序编写要求开发者对程序执行的流程有深入的理解,同时需要关注数据依赖、负载平衡和通信开销等问题。并行程序的核心是将任务合理分配到不同的处理器或核心上,以实现时间或资源上的节约。在编写并行程序时,合理划分任务,最小化通信延迟,以及优化数据管理,都是实现高效率并行计算的关键。

代码块示例:

#include <mpi.h>

#include <stdio.h>

int main(int argc, char** argv) {

// 初始化MPI环境

MPI_Init(&argc, &argv);

// 获取当前进程的排名

int rank;

MPI_Comm_rank(MPI_COMM_WORLD, &rank);

// 打印消息

printf("Hello World from process %d of %d\n", rank, size);

// 清理并结束MPI环境

MPI_Finalize();

return 0;

}

在上述简单的代码示例中,展现了MPI环境初始化、进程排名获取和消息打印的基本流程。实际编写复杂的并行程序时,需要对每一个步骤进行深入的规划和设计。

2. MPI “Hello World” 示例程序分析

2.1 MPI程序结构概述

2.1.1 MPI程序的入口和出口

MPI程序以 main 函数作为程序的入口点和出口点,类似于传统的C程序。然而,其内部结构会有一些不同,以适应并行计算环境的需求。入口点负责初始化MPI环境,而出口点则负责结束并清理资源。程序执行流程的开始和结束都是通过调用MPI库函数来控制的,如 MPI_Init 和 MPI_Finalize 。

#include <mpi.h>

#include <stdio.h>

int main(int argc, char** argv) {

// 程序初始化

MPI_Init(&argc, &argv);

// ... (并行计算的主要部分)

// 程序结束前的清理工作

MPI_Finalize();

return 0;

}

2.1.2 MPI程序的基本组成

MPI程序基本组成可以分为几个主要部分:

- 初始化MPI环境( MPI_Init )

- 执行并行计算任务

- 结束并清理资源( MPI_Finalize )

并行计算任务是核心部分,通常包括进程间的消息传递( MPI_Send 和 MPI_Recv )以及各种集合通信操作( MPI_Bcast , MPI_Gather 等)。

2.2 “Hello World”程序解析

2.2.1 “Hello World”程序的代码框架

“Hello World”程序是学习任何编程语言的第一个示例,MPI也不例外。下面是一个简单的MPI “Hello World”示例代码:

#include <mpi.h>

#include <stdio.h>

int main(int argc, char **argv) {

// 初始化MPI

MPI_Init(&argc, &argv);

int world_size;

MPI_Comm_size(MPI_COMM_WORLD, &world_size);

int world_rank;

MPI_Comm_rank(MPI_COMM_WORLD, &world_rank);

// 打印出"Hellow World"信息

printf("Hello World from process %d of %d!\n", world_rank, world_size);

// 清理MPI环境

MPI_Finalize();

return 0;

}

2.2.2 程序流程和各函数作用

该程序流程由以下几个步骤组成:

1. 初始化MPI环境 - MPI_Init 函数初始化MPI环境,并为每个进程提供 argc 和 argv 参数的副本。

2. 获取并打印进程信息 - MPI_Comm_size 获取进程总数, MPI_Comm_rank 获取当前进程的标识符,并打印出相应的问候信息。

3. 结束并清理 - MPI_Finalize 清理MPI环境并结束程序。

2.3 并行编程基础概念

2.3.1 进程、线程与并行处理

并行计算通常涉及多个进程或线程同时工作来解决问题。进程是系统进行资源分配和调度的基本单位,拥有独立的地址空间,而线程是在同一个进程内的执行路径。在并行计算中,线程通常被用于多线程共享内存的计算,而进程则适用于分布式内存系统,比如使用MPI进行的集群计算。

2.3.2 并行计算模型简介

并行计算模型描述了如何将计算任务分解为可以并行处理的部分,然后在多个处理器上执行。最著名的并行计算模型之一是共享内存模型和分布式内存模型。MPI主要针对分布式内存模型,通过消息传递在不同内存空间的进程之间交换信息。该模型通过显式的通信操作来管理数据的共享和同步。

现在我们已经涵盖了MPI “Hello World”程序的分析,接下来,让我们深入探究MPI环境初始化和进程通信的具体细节。

3. MPI环境的初始化与进程通信

随着高性能计算的快速发展,分布式计算已经成为不可或缺的一部分。在众多并行计算框架中,消息传递接口(MPI)因其在大规模计算中的高效性能而广受欢迎。本章将深入探讨MPI环境的初始化与进程间通信的基本原理和实践应用。

3.1 MPI环境初始化

3.1.1 MPI_Init函数的作用和参数

在MPI程序中,初始化环境是整个程序能够正确运行的第一步。 MPI_Init 函数用于初始化MPI通信环境,它在程序中是必须调用的,通常只在程序的入口点调用一次。这个函数有两个参数: argc 和 argv 。这两个参数直接传递自 main 函数,用于处理命令行参数,虽然在大多数情况下,它们在MPI程序中并不使用。

#include <mpi.h>

int main(int argc, char *argv[]) {

MPI_Init(&argc, &argv);

// 你的代码

MPI_Finalize();

return 0;

}

3.1.2 初始化后的工作

在 MPI_Init 函数调用之后,程序中所有的MPI操作都是有效的,可以开始使用其他的MPI函数进行进程间通信和同步等操作。需要注意的是,在完成所有并行计算任务之后,应当调用 MPI_Finalize 函数结束MPI环境。这是一个良好的编程习惯,能够确保资源得到正确释放,避免程序运行完毕后资源占用的问题。

3.2 进程间通信基础

3.2.1 MPI_Comm_rank函数解析

在MPI中,进程之间的通信是通过通信器(communicator)来实现的。 MPI_Comm_rank 函数用于获取当前进程在指定通信器中的唯一标识,即rank。每个进程的rank值从0开始,到总进程数减1结束。这是进程间区分彼此的标识,也是实现点对点通信的重要参数。

MPI_Comm comm = MPI_COMM_WORLD;

int rank, size;

MPI_Comm_rank(comm, &rank); // 获取当前进程的rank值

MPI_Comm_size(comm, &size); // 获取通信器中的进程总数

3.2.2 MPI_Comm_size函数解析

与 MPI_Comm_rank 相对应的是 MPI_Comm_size 函数,它用于获取在指定通信器中的进程总数。了解进程总数对于许多并行算法设计是非常重要的,例如,确定每个进程需要处理的数据量、分配任务等。

3.3 进程间通信实践

3.3.1 MPI消息传递基本概念

在MPI中,进程间通信主要是通过消息传递来完成的。消息由发送者(sender)和接收者(receiver)组成,消息可以包含任意的数据类型,但必须一致。在发送消息之前,需要确定消息的目的地,即接收者的rank值。

3.3.2 点对点通信模式

点对点通信(Point-to-Point Communication)是最基本的进程间通信方式,它涉及两个进程之间的消息传递。MPI提供了 MPI_Send 和 MPI_Recv 两个函数来分别进行消息发送和接收。点对点通信要求通信双方的进程必须明确知道通信对方的rank值,这在某些复杂并行计算场景下,可以有效地控制数据流的走向。

int MPI_Send(const void *buf, int count, MPI_Datatype datatype, int dest, int tag, MPI_Comm comm);

int MPI_Recv(void *buf, int count, MPI_Datatype datatype, int source, int tag, MPI_Comm comm, MPI_Status *status);

在使用上述函数时,需要指定消息的内容、消息的长度、数据类型、接收者或发送者的rank值、一个通信标签(用于区分不同的通信消息),以及通信器。发送和接收操作在不同的进程中进行,构成一个完整的通信过程。

// 简单的点对点通信示例

if (rank == 0) {

MPI_Send(buf, count, datatype, 1, tag, comm);

} else if (rank == 1) {

MPI_Recv(buf, count, datatype, 0, tag, comm, &status);

}

点对点通信的效率对于整个并行程序的性能至关重要。在实际应用中,合理选择通信模式和优化通信路径可以显著提高程序运行效率。

在本章中,我们已经讨论了MPI环境初始化的必要步骤,以及基础的进程间通信方式。接下来,我们将深入了解MPI中的消息传递机制,并探索如何有效地管理和终止MPI环境。

4. MPI程序中的消息传递与环境关闭

4.1 MPI消息传递机制

消息传递接口MPI提供了丰富的函数用于在并行程序的不同进程间传递数据。消息传递是MPI最基本的通信方式,也是构建更复杂通信模式的基石。

4.1.1 MPI发送和接收消息的函数

在MPI中, MPI_Send 函数用于发送消息,而 MPI_Recv 函数用于接收消息。这两个函数是最基本的消息传递操作,它们的调用形式如下:

int MPI_Send(void *buf, int count, MPI_Datatype datatype, int dest, int tag, MPI_Comm comm)

int MPI_Recv(void *buf, int count, MPI_Datatype datatype, int source, int tag, MPI_Comm comm, MPI_Status *status)

-

buf:指向发送或接收数据的缓冲区的指针。 -

count:发送或接收数据的元素数量。 -

datatype:数据类型,确保发送和接收端的数据类型匹配。 -

dest或source:目标进程或源进程的排名。 -

tag:消息标签,用于区分不同消息。 -

comm:通信器,定义了一组参与通信的进程。 -

status:一个MPI_Status结构,用于存放接收操作的额外信息。

4.1.2 阻塞和非阻塞消息传递

MPI支持阻塞(Blocking)和非阻塞(Non-blocking)消息传递。阻塞操作直到数据完全发送或接收成功后才返回;而非阻塞操作允许在数据传输尚未完成时就返回,提供了更好的并行性能。

非阻塞消息传递函数如下:

int MPI_Isend(void *buf, int count, MPI_Datatype datatype, int dest, int tag, MPI_Comm comm, MPI_Request *request)

int MPI_Irecv(void *buf, int count, MPI_Datatype datatype, int source, int tag, MPI_Comm comm, MPI_Request *request)

非阻塞操作完成后,需要调用 MPI_Wait 或 MPI_Test 等函数来确认操作完成。

4.2 MPI打印消息

在MPI程序中,打印调试信息是非常常见的,MPI为打印消息提供了 printf 函数的类似功能。

4.2.1 使用printf函数

MPI支持标准的C语言 printf 函数。需要注意的是,由于并行执行,不同进程的输出可能会交错出现,这在调试时会造成混乱。

printf("This is a message from process %d\n", my_rank);

4.2.2 消息格式化输出

MPI提供了 MPI_Comm_rank 和 MPI_Comm_size 等函数来获取当前进程的排名和通信器中进程的总数。这些函数可以与 printf 结合,使得输出更加有意义。

int my_rank, comm_size;

MPI_Comm_rank(MPI_COMM_WORLD, &my_rank);

MPI_Comm_size(MPI_COMM_WORLD, &comm_size);

printf("Process %d of %d is running\n", my_rank, comm_size);

4.3 MPI环境关闭

在并行程序运行结束后,必须进行适当的环境清理,以释放系统资源。

4.3.1 MPI_Finalize函数的作用

MPI_Finalize 函数用于结束MPI执行环境。

int MPI_Finalize(void)

该函数调用后,所有进程都应该退出,否则程序将无法正确清理资源。

4.3.2 程序结束前的资源清理

在调用 MPI_Finalize 之前,应确保所有非阻塞消息传递操作都已完成,所有资源如文件、内存等被正确释放。这通常在主程序的退出阶段完成。

// 示例代码

int main(int argc, char* argv[]) {

// 初始化环境

MPI_Init(&argc, &argv);

int my_rank;

MPI_Comm_rank(MPI_COMM_WORLD, &my_rank);

// 执行并行任务...

// 清理非阻塞操作

// ...

// 打印结束信息

printf("Process %d is ready to finish.\n", my_rank);

// 关闭MPI环境

MPI_Finalize();

return 0;

}

在以上示例代码中,程序在所有并行任务执行完毕后打印一条消息,并在每个进程中调用 MPI_Finalize 来结束MPI环境。这样确保了程序的优雅退出和资源的正确释放。

5. MPI并行程序的编译和执行

5.1 Makefile编译规则

5.1.1 Makefile的基本组成

Makefile是一种自动化编译的工具,它是make程序运行时查找的配置文件。Makefile文件主要包含一组规则,这些规则定义了如何编译和链接程序。一个基本的Makefile通常包括以下几个部分:

- 目标(target):通常是一个文件名,告诉make需要构建的最终产物是什么。

- 依赖(dependencies):构建目标所需要的先决条件,可以是源文件、头文件或其他目标。

- 命令(commands):创建目标所需的命令或指令。

Makefile的编写原则是尽量保持简洁明了,并且易于维护。一个简单的Makefile示例如下:

CC=gcc

CFLAGS=-g -Wall

LDFLAGS=

TARGET=mpi_program

all: $(TARGET)

$(TARGET): main.o utils.o

$(CC) $(CFLAGS) $(LDFLAGS) -o $(TARGET) main.o utils.o

main.o: main.c utils.h

$(CC) $(CFLAGS) -c main.c

utils.o: utils.c utils.h

$(CC) $(CFLAGS) -c utils.c

clean:

rm -f $(TARGET) *.o

在这个示例中,我们定义了编译器( CC )、编译器标志( CFLAGS )和链接器标志( LDFLAGS )。 TARGET 定义了我们希望创建的程序名。依赖部分列出了目标文件( main.o 和 utils.o )以及它们需要的源文件。命令部分定义了如何生成目标文件和最终的可执行文件。

5.1.2 MPI程序编译规则详解

对于MPI程序,编译过程稍有不同,因为你需要使用支持MPI的编译器,并且可能要链接MPI库。一个典型的MPI Makefile规则可能会是这样的:

CC=mpicc

CFLAGS=-g

LDFLAGS=

LIBS=-lmpi

TARGET=mpi_program

all: $(TARGET)

mpi_program: main.o utils.o

$(CC) $(CFLAGS) $(LDFLAGS) -o $(TARGET) main.o utils.o $(LIBS)

main.o: main.c

$(CC) $(CFLAGS) -c main.c

utils.o: utils.c

$(CC) $(CFLAGS) -c utils.c

clean:

rm -f $(TARGET) *.o

在这个Makefile中, CC 变量被设置为 mpicc ,这是MPI提供的一个特殊编译器,它知道如何编译MPI程序。 LIBS 变量包含了MPI库,确保链接时能够找到MPI函数。编译和链接命令同样被适当地修改以适应MPI环境。

5.2 mpirun命令运行并行程序

5.2.1 mpirun的基本使用方法

mpirun 是MPI中用于启动并行应用程序的命令行工具。它负责将程序分发到多个计算节点上并运行。基本的 mpirun 命令语法如下:

mpirun [options] <program> [<args>]

其中 [options] 是 mpirun 的参数,用于控制程序的运行方式; <program> 是要启动的程序; [<args>] 是传递给程序的参数。

例如,如果你想在4个处理器上运行名为 mpi_program 的程序,你会使用如下命令:

mpirun -np 4 mpi_program

这里 -np 选项指定了进程的数量。

5.2.2 运行参数和集群配置

除了基本的 -np 参数外, mpirun 还有许多其他选项用于更细致地控制程序的运行,例如:

-

-hostfile <hostfile>:指定一个文件,文件中列出了所有计算节点的主机名。 -

-machinefile <machinefile>:同-hostfile。 -

-host <hostname>:在本地机器上启动指定的主机名。 -

-map-by ppr:N:node:按节点分配进程,N是每个节点上的进程数。 -

-bind-to <bind-to-specification>:将进程绑定到特定的资源。

考虑一个复杂的例子,假设你有一个集群,需要在不同节点上运行你的程序,且每个节点需要运行指定数量的进程。你的 hostfile 可能如下所示:

node1 slots=4

node2 slots=4

然后,你可以使用 mpirun 运行你的程序,并指定每个节点的进程数:

mpirun -hostfile my_hostfile -np 8 -map-by node ./mpi_program

该命令会在 node1 和 node2 上分配总共8个进程,每个节点4个进程。

要全面掌握并行程序的编译和执行,IT和相关行业的专业人员需要了解Makefile的编写方法以及 mpirun 命令的灵活运用。以上示例与解释提供了必要的基础知识和指导,但在实际环境中,开发人员还需要根据具体的应用场景和集群配置进行调整和优化。

6. MPI通信原语详解

MPI通信原语是并行程序中进程间通信的核心,它们使得数据可以在不同进程间高效传递。本章节将深入探讨MPI中常用的通信原语,包括点对点通信和集合通信原语,并解析其应用场景。

6.1 点对点通信

点对点通信是指两个进程间直接进行数据传输的通信方式,是最基本的通信模式之一。在MPI中,点对点通信涉及 MPI_Send 和 MPI_Recv 两个主要的函数。

6.1.1 MPI_Send和MPI_Recv函数使用

MPI_Send 函数用于发送消息,其基本语法如下:

int MPI_Send(void *buf, int count, MPI_Datatype datatype, int dest, int tag, MPI_Comm comm)

-

buf:指向消息数据的指针。 -

count:发送数据的元素数量。 -

datatype:数据类型。 -

dest:目标进程的秩(rank)。 -

tag:消息标签,用于区分不同消息。 -

comm:通信域。

MPI_Recv 函数用于接收消息,其基本语法如下:

int MPI_Recv(void *buf, int count, MPI_Datatype datatype, int source, int tag, MPI_Comm comm, MPI_Status *status)

-

buf:用于存放接收到的数据的缓冲区指针。 -

count:期望接收的最大元素数量。 -

datatype:数据类型。 -

source:发送者进程的秩(rank)。 -

tag:消息标签。 -

comm:通信域。 -

status:状态对象,包含消息的相关信息。

6.1.2 点对点通信的典型场景

点对点通信在许多并行计算场景中都有应用,比如在处理分治算法时,主进程可能需要将任务分配给工作进程,工作进程处理完任务后,将结果返回给主进程。这里的工作进程和主进程间使用点对点通信进行数据交换。另一个场景是在并行矩阵乘法中,多个进程需要相互交换中间数据以计算最终结果。

6.2 集合通信原语

集合通信涉及多个进程间的协作,更适用于处理全局通信问题。MPI提供了一系列集合通信原语,例如广播、收集和分散通信。

6.2.1 广播通信MPI_Bcast

MPI_Bcast 函数用于实现广播通信,一个进程可以将数据发送给通信域中的所有其他进程。基本语法如下:

int MPI_Bcast(void *buffer, int count, MPI_Datatype datatype, int root, MPI_Comm comm)

-

buffer:根进程中的缓冲区,包含要广播的数据。 -

count:从缓冲区发送/接收的数据元素数量。 -

datatype:数据类型。 -

root:广播数据的根进程秩(rank)。 -

comm:通信域。

6.2.2 收集通信MPI_Gather

MPI_Gather 用于收集所有进程的数据到一个单一的进程中。基本语法如下:

int MPI_Gather(void *sendbuf, int sendcount, MPI_Datatype sendtype, void *recvbuf, int recvcount, MPI_Datatype recvtype, int root, MPI_Comm comm)

-

sendbuf:发送缓冲区。 -

sendcount:每个发送缓冲区中的元素数量。 -

sendtype:发送数据类型。 -

recvbuf:接收缓冲区。 -

recvcount:根进程接收缓冲区中的元素数量。 -

recvtype:接收数据类型。 -

root:接收数据的根进程秩(rank)。 -

comm:通信域。

6.2.3 分散通信MPI_Scatter

MPI_Scatter 用于将一个进程中的数据分散到所有其他进程中。其基本语法与 MPI_Gather 相似,但数据流向相反。

通信原语应用场景示例

例如,假设有一个需要并行处理的科学计算任务,首先主进程通过 MPI_Bcast 将初始数据广播给所有其他进程。在计算过程中,每个进程可能需要从其他进程接收中间结果,这时可以用 MPI_Recv 。计算完成后,各个进程将局部结果汇总到主进程,这时可以使用 MPI_Gather 或 MPI_Scatter 。

| 通信原语 | 描述 | 典型应用 |

|---|---|---|

| MPI_Send | 发送数据到指定进程 | 任务分配 |

| MPI_Recv | 接收来自指定进程的数据 | 结果收集 |

| MPI_Bcast | 向所有进程广播数据 | 初始化数据传播 |

| MPI_Gather | 从所有进程收集数据到根进程 | 结果汇总 |

| MPI_Scatter | 将根进程数据分散给所有进程 | 初始数据分配 |

在本节中,我们了解了MPI中关键的通信原语。通过点对点和集合通信原语,可以实现复杂的并行计算任务。在下一节,我们将学习如何将MPI并行程序编译和执行,以应用于高性能计算环境。

7. MPI在高性能计算中的应用

高性能计算(HPC)是指利用并行处理技术,特别是在超级计算机上执行的计算。其目的是通过分散任务到多个计算单元,来缩短解决复杂问题的时间。MPI作为并行编程的一种标准,已被广泛应用于高性能计算领域。

7.1 高性能计算概述

7.1.1 高性能计算的定义和重要性

高性能计算是一种在科学、工程、金融等多个领域广泛应用的计算形式。它通过结合多台计算机(节点)的处理能力和存储能力,执行单个计算机无法完成或需要不切实际长时间完成的大规模计算任务。高性能计算的目标是实现更快的处理速度,更短的计算时间,以便能够应对那些需要巨大计算资源的复杂问题。

7.1.2 并行计算的挑战和机遇

并行计算的挑战主要在于如何设计高效的算法来分配任务、同步进程、管理数据传输和合并结果。在HPC中,机遇则在于能够处理过去无法解决的问题,比如气候变化模拟、药物研发、新能源材料设计等。

7.2 MPI在科学工程中的应用案例

7.2.1 并行算法的设计与实现

在设计并行算法时,首先要考虑的是如何将问题分解为可以并行处理的部分。这些部分随后被映射到不同的处理单元(如CPU核心或GPU)。并行算法的设计需要考虑负载平衡、通信开销和数据依赖性等问题。

下面是一个简单的并行算法实现案例。假设我们要并行计算一个数组的元素之和:

#include <mpi.h>

#include <stdio.h>

int main(int argc, char** argv) {

MPI_Init(NULL, NULL);

int world_size;

MPI_Comm_size(MPI_COMM_WORLD, &world_size);

int world_rank;

MPI_Comm_rank(MPI_COMM_WORLD, &world_rank);

int number;

MPI_Status status;

if (world_rank == 0) {

// Master process

int sum = 0;

int n = 100;

for (int i = 0; i < n; i++) {

MPI_Recv(&number, 1, MPI_INT, MPI_ANY_SOURCE, 0, MPI_COMM_WORLD, &status);

sum += number;

}

printf("Sum is: %d\n", sum);

} else {

// Worker process

int local_number = world_rank + 1;

MPI_Send(&local_number, 1, MPI_INT, 0, 0, MPI_COMM_WORLD);

}

MPI_Finalize();

return 0;

}

在上述代码中,主进程0收集其他所有进程发送的数组元素值并计算总和。每个工作进程(非0进程)发送它自己的数组元素值到主进程。

7.2.2 大数据处理中的MPI应用

在大数据处理领域,MPI能够帮助我们快速处理和分析大规模数据集。例如,使用MPI可以并行化MapReduce操作,在多个节点上同时进行数据映射(Map)和归约(Reduce)操作。一个典型的大数据应用案例是并行处理日志文件或数据集中的统计信息。

7.3 未来发展趋势与挑战

7.3.1 MPI的发展历程与未来

自1990年代问世以来,MPI经历了多次版本迭代,不断优化其性能和功能。随着硬件的发展和计算需求的增长,MPI也在持续演进,支持更多种类的并行计算架构。未来的MPI可能会包含更多对异构计算(如CPU和GPU协同工作)的支持,以及对容错机制和网络拓扑的优化。

7.3.2 并行编程的新范式与技术

随着多核处理器和众核处理器的普及,新的并行编程范式和技术如OpenMP、CUDA、OpenCL等开始流行。这些技术通常与MPI结合使用,以进一步提高计算性能。例如,可以在一个MPI程序中,使用OpenMP来并行化单个节点上的代码执行。

在并行编程的未来,我们可以预见更加智能的编译器,能够自动识别并行化潜力,简化并行编程过程。同时,随着量子计算、非冯·诺依曼架构等研究的深入,将出现更多并行计算的新模式和新工具。

在这一章节中,我们探讨了MPI在高性能计算中的应用,了解了高性能计算的基本概念、MPI在科学工程应用案例以及未来并行计算的挑战和发展趋势。接下来的章节将详细介绍如何编译和执行MPI程序,以及MPI通信原语的详解。

简介:MPI(Message Passing Interface)是一种用于分布式内存系统的并行计算通信接口标准,广泛应用于高性能计算领域。本文介绍了MPI的基础程序示例——“Hello World”,演示了如何使用MPI的通信原语在多个进程间传递信息。示例中,”hello_mpi.c”程序展示了如何初始化MPI环境、获取进程ID和大小,以及如何打印出带有进程ID的”Hello, World!”消息。同时,文章提供了编译和运行该程序的Makefile规则和命令,以及MPI的关键通信原语。掌握MPI对于开发高效的并行算法至关重要,它支持科学计算、数据分析和机器学习等多个领域。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?