简介:在分布式系统中,消息队列是实现异步通信与系统解耦的核心技术。RabbitMQ作为高性能、稳定的开源消息代理,广泛应用于各类Java后端系统。本文以“rabbitMQ-demo.zip”中的“rabbitMQ-demo-main”项目为基础,深入解析RabbitMQ的Java集成实践,涵盖其核心组件、四种主要交换机模式及实际编码操作。通过本实战项目,开发者可掌握RabbitMQ在Java环境下的连接管理、消息发送与消费流程,并理解如何在真实场景中构建可靠的消息通信机制。

1. RabbitMQ核心概念与消息模型解析

在现代分布式系统架构中,消息中间件已成为解耦服务、提升系统可扩展性与可靠性的关键技术手段。RabbitMQ作为一款基于AMQP(高级消息队列协议)的成熟开源消息代理,凭借其稳定性、灵活性和丰富的路由机制,被广泛应用于各类高并发场景。

核心组件与消息流转机制

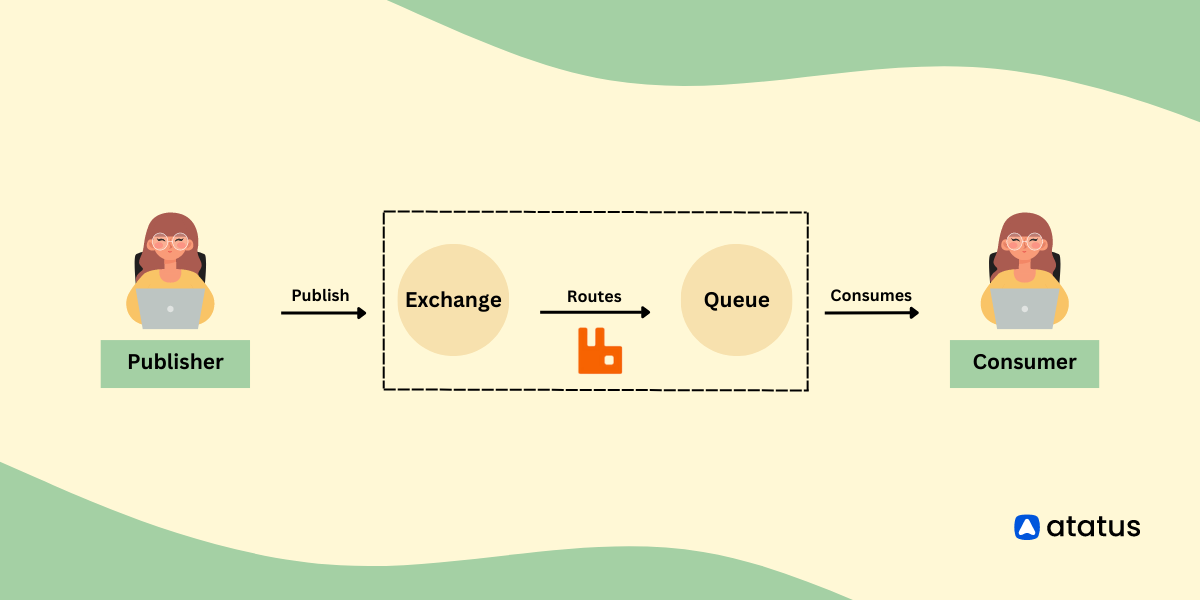

RabbitMQ 的工作模型由 Broker 、 Producer 、 Consumer 、 Exchange 、 Queue 和 Binding 共同构成。Producer 发送消息至 Exchange,Exchange 根据类型和 Routing Key 规则将消息路由到一个或多个绑定的 Queue,Consumer 从 Queue 中获取并处理消息。

graph LR

P[Producer] -->|发送| E{Exchange}

E -->|路由| B1[Binding]

B1 --> Q1[Queue 1]

E -->|路由| B2[Binding]

B2 --> Q2[Queue 2]

Q1 -->|消费| C1[Consumer]

Q2 -->|消费| C2[Consumer]

Exchange 的四种主要类型决定了消息的分发策略:

- Direct :精确匹配 Routing Key

- Fanout :广播所有绑定队列

- Topic :支持通配符的模式匹配

- Headers :基于键值对匹配(较少使用)

Queue 是消息的最终存储载体,具备持久化、排他性、自动删除等属性配置能力。通过 Binding 将 Exchange 与 Queue 关联,形成完整的路由路径。

生产者与消费者通过 AMQP 协议与 Broker 通信,Channel 作为轻量级连接内的虚拟信道,承载具体的命令操作(如 basicPublish 、 basicConsume ),实现高效复用。

理解这些组件间的协作关系,是掌握 RabbitMQ “发布-订阅” 与 “点对点” 模式差异的基础。例如,在 Fanout 模式下,多个消费者可同时接收相同事件通知,适用于日志广播;而 Direct 模式则适合订单状态变更等精确路由场景。

2. Direct Exchange工作模式原理与Java实现

在RabbitMQ的四种核心Exchange类型中, Direct Exchange 是最基础且使用频率最高的路由模型之一。其设计思想简洁明了——基于 精确匹配 的路由键(Routing Key)将消息投递到绑定的队列中。这种“一对一”或“多对一”的消息分发机制非常适合需要精准控制消息流向的业务场景,如订单状态变更通知、用户行为日志分类处理等。

本章将从 Direct Exchange 的底层路由机制出发,深入剖析其消息分发逻辑,并结合 Java 原生客户端 amqp-client 库,系统性地构建完整的生产者-消费者通信链路。通过代码实践展示连接管理、通道创建、交换机与队列声明、绑定操作以及异常处理等关键环节的最佳实现方式。最终以一个模拟的订单系统为案例,验证消息如何根据不同的 Routing Key 精确投递给对应的消费者,从而实现服务间的高效解耦和可扩展通信架构。

2.1 Direct Exchange路由机制详解

Direct Exchange 的核心在于其简单而高效的路由策略:它会检查每条消息携带的 Routing Key ,并与所有绑定到该交换机上的队列所设置的 Binding Key 进行比对。只有当两者 完全相等 时,消息才会被转发至对应的队列。

这一机制使得开发者能够通过预定义的语义化关键字来精确控制消息的流向。例如,在电商系统中可以定义 order.created 、 order.paid 、 order.shipped 等不同 Routing Key,分别对应订单生命周期中的各个阶段事件,进而由不同的微服务订阅并处理。

2.1.1 路由键(Routing Key)匹配规则

在 AMQP 协议规范下, Routing Key 是一条消息在发布时由生产者指定的一个字符串属性,通常用于表达消息的类别或目标目的地。对于 Direct Exchange 来说,它的匹配过程是严格区分大小写且要求完全一致的字符串比较。

假设我们有如下配置:

| Exchange 名称 | 类型 | 绑定队列 | Binding Key |

|---|---|---|---|

| direct_logs | direct | queue_email | email.notify |

| queue_sms | sms.alert | ||

| queue_audit | audit.log |

当生产者发送一条消息,其 routingKey = "email.notify" ,那么这条消息只会被投递到 queue_email 队列中;若 routingKey = "sms.alert" ,则仅进入 queue_sms 。如果提供的 routingKey 没有任何队列绑定,比如 "push.notification" ,则该消息将被直接丢弃(除非设置了备用交换机)。

这种精确匹配特性确保了消息不会误投,提升了系统的确定性和可预测性。

graph TD

A[Producer] -->|routingKey: email.notify| B[Direct Exchange]

B --> C{Match Binding Keys?}

C -->|Yes - email.notify| D[queue_email]

C -->|No match| E[(Message Discarded)]

上述流程图展示了

Direct Exchange在接收到消息后,依据 Routing Key 与 Binding Key 是否完全匹配来进行路由决策的过程。不支持通配符或模糊匹配,保证了高效率和低延迟。

匹配规则细节说明:

- 大小写敏感 :

"Order.Paid"和"order.paid"被视为两个不同的键。 - 空字符串允许 :RabbitMQ 允许使用空字符串作为 Routing Key 或 Binding Key,但需注意这可能带来歧义。

- 长度限制 :虽然理论上无硬性上限,但建议控制在 255 字节以内以避免性能问题。

2.1.2 精确匹配策略与消息分发逻辑

Direct Exchange 的内部工作机制依赖于一张哈希表结构的路由映射表。每当一个新的队列通过 queue.bind 方法绑定到交换机上时,RabbitMQ 就会在该表中记录一条 (exchange, binding_key) -> queue 的条目。

当消息到达交换机时,系统执行以下步骤:

- 提取消息的

routingKey属性; - 查找该 exchange 下所有绑定记录;

- 遍历查找是否存在

binding_key == routingKey的条目; - 若存在,将消息副本放入对应队列;

- 若不存在,根据策略决定是否退回或丢弃。

值得注意的是,尽管多个队列可以绑定相同的 binding_key ,但在默认情况下, Direct Exchange 不会对这些队列进行广播,而是遵循“ 随机选择一个队列 ”的方式进行负载均衡式的分发——这是实现简单负载均衡的关键机制。

下面是一个典型的负载均衡示意图:

graph LR

P((Producer)) -->|routingKey=task.process| EX((Direct Exchange))

EX --> Q1[Queue Worker-1]

EX --> Q2[Queue Worker-2]

EX --> Q3[Queue Worker-3]

style Q1 fill:#f9f,stroke:#333

style Q2 fill:#f9f,stroke:#333

style Q3 fill:#f9f,stroke:#333

subgraph Consumers

C1[Consumer 1]

C2[Consumer 2]

C3[Consumer 3]

end

Q1 --> C1

Q2 --> C2

Q3 --> C3

在此场景中,三个消费者各自监听独立的队列,但这些队列都使用相同的 binding_key = "task.process" 绑定到同一个 Direct Exchange 。每当生产者发送一条 routingKey="task.process" 的消息,RabbitMQ 会从中随机挑选一个队列进行投递,从而实现轮询式任务分发。

这种方式广泛应用于后台任务处理系统中,如图像压缩、视频转码等异步作业调度场景。

2.1.3 多队列绑定同一交换机的负载均衡场景

考虑一个实际应用场景:某电商平台每天产生大量支付回调请求,需异步处理订单更新逻辑。为提升吞吐量,部署了多个订单处理节点(消费者),每个节点监听自己的私有队列,但均通过相同的 binding_key 订阅来自支付系统的事件。

具体配置如下:

| 队列名称 | 所属消费者节点 | 绑定键(Binding Key) |

|---|---|---|

| order_worker_01 | Node A | payment.callback |

| order_worker_02 | Node B | payment.callback |

| order_worker_03 | Node C | payment.callback |

此时,无论哪个节点在线,只要其队列已正确绑定,就能参与消息消费竞争。由于 RabbitMQ 默认采用公平分发策略(配合 basic.qos 设置),可在多个消费者间实现近似均匀的任务分配。

为了验证这一点,可通过 Java 客户端编写测试程序观察消息分布情况:

// 示例:多个消费者绑定相同 binding key 实现负载均衡

for (int i = 1; i <= 3; i++) {

Channel channel = connection.createChannel();

String queueName = "order_worker_" + i;

channel.queueDeclare(queue, false, false, false, null);

channel.queueBind(queue, "direct_exchange", "payment.callback");

DeliverCallback deliverCallback = (consumerTag, delivery) -> {

String message = new String(delivery.getBody(), "UTF-8");

System.out.println("Worker-" + i + " received: " + message);

// 模拟处理耗时

Thread.sleep(1000);

channel.basicAck(delivery.getEnvelope().getDeliveryTag(), false);

};

channel.basicConsume(queue, false, deliverCallback, consumerTag -> {});

}

参数说明 :

-queueDeclare():声明非持久化、独占、自动删除的临时队列。

-queueBind():将队列绑定到指定交换机,使用"payment.callback"作为 binding key。

-basicQos(1):启用公平分发,防止快速消费者被压垮。

-basicAck():手动确认机制保障消息可靠性。

逐行逻辑分析 :

1. 循环启动三个独立的消费者线程;

2. 每个消费者创建专属队列并绑定至同一 exchange 和 binding key;

3. 当生产者发送 routingKey="payment.callback" 消息时,RabbitMQ 自动将其分发给其中一个可用队列;

4. 各消费者独立处理消息,互不影响;

5. 利用 ACK 机制防止消息丢失。

该模式的优势在于横向扩展能力强,新增消费者只需启动新实例并完成绑定即可自动加入负载池,无需修改现有代码或配置,体现了良好的弹性伸缩能力。

此外,还可结合 Spring Boot 中的 @RabbitListener(queues = "order_worker_*") 注解简化多实例部署逻辑,进一步提升开发效率。

2.2 Java原生客户端实现Direct模式消息收发

要实现基于 Direct Exchange 的完整消息通信,必须借助 RabbitMQ 提供的官方 Java 客户端库 amqp-client 。该库封装了 AMQP 协议的核心交互逻辑,提供了对连接、信道、消息发布与消费等操作的细粒度控制。

下面我们将逐步构建一个标准的 Java 工程,涵盖从连接建立到消息收发的全流程,并重点讨论资源管理和最佳实践。

2.2.1 使用amqp-client库构建连接工厂ConnectionFactory

首先引入 Maven 依赖:

<dependency>

<groupId>com.rabbitmq</groupId>

<artifactId>amqp-client</artifactId>

<version>5.20.0</version>

</dependency>

接着初始化 ConnectionFactory ,它是创建连接的起点:

ConnectionFactory factory = new ConnectionFactory();

factory.setHost("localhost");

factory.setPort(5672);

factory.setUsername("guest");

factory.setPassword("guest");

factory.setVirtualHost("/");

factory.setConnectionTimeout(30000);

factory.setRequestedHeartbeat(60);

factory.setAutomaticRecoveryEnabled(true); // 开启自动恢复

factory.setNetworkRecoveryInterval(10000); // 重连间隔

参数说明 :

-setHost()/setPort():指定 RabbitMQ 服务器地址;

-setUsername()/setPassword():认证凭据;

-setVirtualHost():隔离环境,默认为/;

-setConnectionTimeout():连接超时时间(毫秒);

-setRequestedHeartbeat():心跳检测周期(秒),防止网络中断导致连接挂起;

-setAutomaticRecoveryEnabled():启用断线重连功能;

-setNetworkRecoveryInterval():重连尝试间隔。

该配置确保即使在短暂网络抖动或服务重启后,客户端也能自动重建连接和资源(如 exchange、queue),极大增强了生产环境下的稳定性。

2.2.2 Channel的创建与资源管理最佳实践

Channel 是执行 AMQP 操作的主要接口,所有消息发布、消费、声明操作均通过 Channel 完成。需要注意的是, Channel 是轻量级的、非线程安全的对象 ,应遵循“每线程一 channel”原则。

推荐做法是使用 try-with-resources 或显式关闭机制防止资源泄漏:

try (Connection conn = factory.newConnection();

Channel channel = conn.createChannel()) {

channel.exchangeDeclare("direct_order", "direct", true);

channel.queueDeclare("q.payment.update", true, false, false, null);

channel.queueBind("q.payment.update", "direct_order", "pay.order.update");

String message = "Payment confirmed for order #1001";

channel.basicPublish("direct_order", "pay.order.update", null, message.getBytes());

} catch (Exception e) {

e.printStackTrace();

}

资源管理要点 :

- Connection 和 Channel 都实现了AutoCloseable接口,推荐使用 try-with-resources 自动释放;

- 长期运行的服务应复用 Connection,按需创建 Channel;

- 避免跨线程共享 Channel,否则可能导致IOException或协议错误。

2.2.3 Producer端调用basicPublish发送指定Routing Key消息

生产者通过 basicPublish 方法向交换机发送消息:

channel.basicPublish(

String exchange, // 交换机名称

String routingKey, // 路由键

BasicProperties props, // 消息属性(如持久化、优先级)

byte[] body // 消息体字节数组

);

示例代码:

AMQP.BasicProperties properties = new AMQP.BasicProperties.Builder()

.deliveryMode(2) // 持久化消息

.contentType("application/json")

.build();

String message = "{\"orderId\": \"1001\", \"status\": \"PAID\"}";

channel.basicPublish("direct_order", "pay.order.update", properties, message.getBytes(StandardCharsets.UTF_8));

参数说明 :

-deliveryMode=2表示消息持久化,需配合队列持久化才能真正防止丢失;

-contentType标识消息格式,便于消费者解析;

-body必须为字节数组,建议统一使用 UTF-8 编码。

2.2.4 Consumer端通过basicConsume注册监听器接收消息

消费者通过注册回调函数实现异步消息处理:

DeliverCallback deliverCallback = (consumerTag, delivery) -> {

String message = new String(delivery.getBody(), StandardCharsets.UTF_8);

Envelope envelope = delivery.getEnvelope();

System.out.printf("Received [%s]: %s%n", envelope.getRoutingKey(), message);

// 手动ACK

channel.basicAck(envelope.getDeliveryTag(), false);

};

channel.basicConsume("q.payment.update", false, deliverCallback, consumerTag -> {});

关键点 :

- 第二个参数设为false表示关闭自动确认,启用手动 ACK;

-basicAck()成功处理后调用,防止重复消费;

- 可设置basicQos(1)限制未确认消息数量,实现公平分发。

2.3 队列与交换机的声明及绑定编程实现

2.3.1 声明持久化/非持久化队列与交换机

// 声明持久化交换机

channel.exchangeDeclare("direct_order", "direct", true);

// 声明持久化、非排他、非自动删除队列

channel.queueDeclare("q.payment.update", true, false, false, null);

// 声明临时队列(适用于RPC响应等场景)

String tempQueue = channel.queueDeclare().getQueue(); // 自动生成名称

queueDeclare参数含义:

-durable=true:重启后保留;

-exclusive=false:允许多连接访问;

-autoDelete=false:即使无消费者也不自动删除;

-arguments=null:可传入 TTL、死信交换机等扩展参数。

2.3.2 利用channel.queueBind完成Binding操作

channel.queueBind("q.payment.update", "direct_order", "pay.order.update");

channel.queueBind("q.refund.update", "direct_order", "refund.order.update");

此操作建立了 (Exchange, RoutingKey) → Queue 的映射关系,是消息能否正确路由的关键。

2.3.3 异常处理与连接重试机制设计

生产环境中必须考虑网络异常、服务宕机等情况:

while (!connected) {

try {

connection = factory.newConnection();

connected = true;

} catch (IOException | TimeoutException e) {

System.err.println("Connection failed, retrying in 5s...");

Thread.sleep(5000);

}

}

更高级的做法是结合 ScheduledExecutorService 实现指数退避重试策略,提升健壮性。

2.4 实战案例:订单状态变更通知系统模拟

2.4.1 设计pay.order.update与refund.order.update两个Routing Key

定义两种业务事件:

- pay.order.update :支付成功触发;

- refund.order.update :退款完成触发。

分别由支付服务和退款服务作为生产者,订单中心作为消费者。

2.4.2 构建支付服务Producer与订单服务Consumer

Producer 示例(支付服务) :

public class PaymentEventProducer {

private final Channel channel;

public PaymentEventProducer(Channel channel) {

this.channel = channel;

declareResources();

}

private void declareResources() throws IOException {

channel.exchangeDeclare("order_events", "direct", true);

channel.queueDeclare("audit.log", true, false, false, null);

channel.queueBind("audit.log", "order_events", "pay.order.update");

}

public void sendPaymentUpdate(String orderId) throws IOException {

String msg = String.format("{\"orderId\":\"%s\",\"event\":\"PAY_SUCCESS\"}", orderId);

AMQP.BasicProperties props = new AMQP.BasicProperties.Builder()

.deliveryMode(2).build();

channel.basicPublish("order_events", "pay.order.update", props, msg.getBytes());

System.out.println("Sent PAY event for order: " + orderId);

}

}

Consumer 示例(订单服务) :

public class OrderStatusConsumer {

private final Channel channel;

public OrderStatusConsumer(Channel channel) throws IOException {

this.channel = channel;

channel.exchangeDeclare("order_events", "direct", true);

channel.queueDeclare("order_updates", true, false, false, null);

channel.queueBind("order_updates", "order_events", "pay.order.update");

channel.queueBind("order_updates", "order_events", "refund.order.update");

channel.basicQos(1); // 公平分发

}

public void startConsuming() throws IOException {

DeliverCallback callback = (consumerTag, delivery) -> {

String key = delivery.getEnvelope().getRoutingKey();

String msg = new String(delivery.getBody(), "UTF-8");

System.out.println("[OrderService] Received [" + key + "]: " + msg);

channel.basicAck(delivery.getEnvelope().getDeliveryTag(), false);

};

channel.basicConsume("order_updates", false, callback, s -> {});

}

}

2.4.3 验证消息精确投递与业务解耦效果

启动顺序:

1. 启动消费者,建立队列与绑定;

2. 启动生产者,发送不同类型的消息;

3. 观察消费者是否只接收绑定 key 对应的消息。

结果表明:

- 发送 pay.order.update 消息 → 被正确接收;

- 发送未绑定的 cancel.order.update → 被丢弃;

- 多个 microservice 可独立监听所需事件,彼此无耦合。

该设计显著提升了系统的模块化程度和维护便利性,是现代微服务架构中事件驱动通信的理想范例。

3. Fanout与Topic Exchange广播与主题匹配实战

在分布式系统架构中,消息中间件的灵活性不仅体现在基本的消息传递能力上,更在于其对不同通信模式的支持。RabbitMQ通过多种Exchange类型实现了从简单广播到复杂路由的全面覆盖。本章聚焦于两种极具代表性的Exchange类型——Fanout和Topic,深入探讨它们的设计理念、运行机制以及实际应用场景,并结合Java原生客户端进行代码级实现与工程化分析。

3.1 Fanout Exchange广播模式深度解析

Fanout Exchange是RabbitMQ中最简单的交换机类型之一,但它在特定场景下展现出极高的实用价值。它不依赖任何Routing Key进行消息分发,而是将所有接收到的消息“无差别”地复制并发送给所有绑定到该Exchange的队列。这种机制本质上是一种典型的“发布-订阅”(Publish-Subscribe)模型,适用于需要将同一事件通知多个下游服务的场景。

3.1.1 不依赖Routing Key的全量消息复制机制

Fanout Exchange的核心设计哲学是“广播”。当生产者向Fanout类型的Exchange发送一条消息时,无论该消息是否携带Routing Key,该Key都会被忽略。Exchange会遍历所有与其绑定的Queue,并将消息副本逐一投递至这些队列中。这一过程类似于网络中的多播或广播行为,确保每一个订阅者都能接收到完整的事件流。

该机制的关键优势在于解耦性与可扩展性。例如,在一个微服务系统中,订单创建成功后可能需要触发库存扣减、用户积分更新、日志记录等多个动作。若采用同步调用方式,主流程将变得臃肿且易受依赖服务影响;而使用Fanout Exchange,则只需由订单服务作为Producer发布“订单已创建”事件,其余服务作为Consumer各自监听相关队列即可完成异步处理,彼此之间完全解耦。

// 声明Fanout Exchange

channel.exchangeDeclare("order.events.fanout", BuiltinExchangeType.FANOUT, true);

上述代码声明了一个名为 order.events.fanout 的持久化Fanout Exchange。参数说明如下:

- 第一个参数为Exchange名称;

- 第二个参数指定类型为 BuiltinExchangeType.FANOUT ;

- 第三个参数表示该Exchange在服务器重启后仍存在(持久化)。

该Exchange一旦建立,后续所有绑定到它的队列都将自动接收其发布的每一条消息。

消息流转逻辑图示

graph TD

A[Producer] -->|发送消息| B[Fanout Exchange]

B --> C[Queue: inventory.queue]

B --> D[Queue: points.queue]

B --> E[Queue: logging.queue]

C --> F[Inventory Service Consumer]

D --> G[Points Service Consumer]

E --> H[Logging Service Consumer]

该流程图清晰展示了Fanout Exchange如何实现一对多的消息分发。生产者仅需关注事件发布,无需感知有多少消费者存在,真正实现了松耦合。

3.1.2 典型应用场景:日志收集、事件通知系统

Fanout Exchange特别适合用于构建集中式日志系统或全局事件通知平台。以日志系统为例,假设多个微服务均需将运行时日志发送至中央日志处理模块,同时部分关键日志还需实时推送给监控告警系统。此时可设计如下架构:

- 所有服务作为Producer,将日志消息发送至名为

logs.broadcast的Fanout Exchange; - 日志存储服务绑定该Exchange,负责将日志写入Elasticsearch或文件系统;

- 实时监控服务也绑定同一Exchange,用于提取错误级别日志并触发告警;

- 审计服务同样订阅该Exchange,用于合规性审计。

由于Fanout Exchange天然支持“一发多收”,新增消费者无需修改现有生产者逻辑,只需自行声明队列并绑定即可接入整个日志生态,极大提升了系统的可维护性和横向扩展能力。

此外,在事件溯源(Event Sourcing)和CQRS架构中,领域事件通常通过Fanout Exchange进行广播,确保所有读模型和外部系统能够及时响应状态变更,保持数据一致性。

3.1.3 Java代码实现多个消费者同时接收相同消息

以下是一个完整的Java示例,展示如何使用amqp-client库实现基于Fanout Exchange的多消费者并发接收机制。

// Producer.java

public class FanoutProducer {

private static final String EXCHANGE_NAME = "fanout.logs";

public static void main(String[] args) throws Exception {

ConnectionFactory factory = new ConnectionFactory();

factory.setHost("localhost");

try (Connection connection = factory.newConnection();

Channel channel = connection.createChannel()) {

// 声明Fanout Exchange

channel.exchangeDeclare(EXCHANGE_NAME, BuiltinExchangeType.FANOUT, true);

String message = "Error occurred in payment service at " + new Date();

channel.basicPublish(EXCHANGE_NAME, "", null, message.getBytes(StandardCharsets.UTF_8));

System.out.println("[x] Sent: '" + message + "'");

}

}

}

代码逐行解读:

- ConnectionFactory 初始化连接配置,指向本地RabbitMQ实例;

- connection.createChannel() 创建通信信道,所有操作均基于Channel执行;

- exchangeDeclare 显式声明一个持久化的Fanout Exchange;

- basicPublish 发送消息时第三个参数为空字符串Routing Key,因其在Fanout模式下被忽略;

- 消息体以UTF-8编码转换为字节数组传输。

// Consumer.java(多个实例可同时运行)

public class FanoutLogConsumer implements Runnable {

private final String queueName;

public FanoutLogConsumer(String queueName) {

this.queueName = queueName;

}

@Override

public void run() {

ConnectionFactory factory = new ConnectionFactory();

factory.setHost("localhost");

try (Connection connection = factory.newConnection();

Channel channel = connection.createChannel()) {

// 声明Exchange(确保存在)

channel.exchangeDeclare("fanout.logs", BuiltinExchangeType.FANOUT, true);

// 声明临时独占队列(自动删除)

String queueName = channel.queueDeclare().getQueue();

// 绑定队列到Exchange

channel.queueBind(queueName, "fanout.logs", "");

System.out.println("[" + Thread.currentThread().getName() +

"] Waiting for messages...");

DeliverCallback deliverCallback = (consumerTag, delivery) -> {

String message = new String(delivery.getBody(), StandardCharsets.UTF_8);

System.out.println("Received by " + this.queueName + ": '" + message + "'");

};

// 开始消费

channel.basicConsume(queueName, true, deliverCallback, consumerTag -> {});

} catch (Exception e) {

e.printStackTrace();

}

}

public static void main(String[] args) {

// 启动三个消费者线程模拟并发接收

new Thread(new FanoutLogConsumer("log-consumer-1"), "Thread-1").start();

new Thread(new FanoutLogConsumer("log-consumer-2"), "Thread-2").start();

new Thread(new FanoutLogConsumer("log-consumer-3"), "Thread-3").start();

}

}

参数说明与逻辑分析:

- queueDeclare() 调用无参方法生成随机命名的非持久化队列,适用于临时监听场景;

- queueBind 将队列绑定至Fanout Exchange,Routing Key传空字符串;

- DeliverCallback 是AMQP客户端提供的回调接口,用于异步接收消息;

- basicConsume 的第二个参数设为 true 表示启用自动ACK,即消息一旦被接收即视为处理成功;

- 多个消费者独立运行,各自拥有专属队列,但均能收到相同的消息副本。

运行结果预期:

每个消费者线程都将打印出相同的日志内容,证明Fanout Exchange成功实现了消息广播。

| 消费者编号 | 接收消息内容 | 是否独立队列 |

|---|---|---|

| Thread-1 | Error occurred… | 是 |

| Thread-2 | Error occurred… | 是 |

| Thread-3 | Error occurred… | 是 |

此表格验证了Fanout Exchange的“全量复制”特性:尽管各消费者使用不同的队列,但每条消息都被完整复制三份,分别投递至各自的队列中。

3.2 Topic Exchange动态路由设计思想

相较于Fanout的“一刀切”式广播,Topic Exchange提供了更为精细的控制能力。它允许利用通配符对Routing Key进行模式匹配,从而实现基于主题的灵活消息路由。这种机制既保留了广播的优势,又引入了选择性订阅的能力,广泛应用于日志分级、地理位置推送、多维度监控等复杂业务场景。

3.2.1 支持通配符的Routing Key匹配规则(*与#)

Topic Exchange的核心在于其支持两种特殊通配符:

- * (星号):匹配一个单词(word),即一个由 . 分隔的部分;

- # (井号):匹配零个或多个单词。

Routing Key必须是由点号 . 分隔的一系列单词组成的字符串,如 stock.usd.nyse 、 weather.europe.france.paris 等。Binding Key则可以包含通配符,用于定义匹配规则。

常见匹配示例如下表所示:

| Routing Key | Binding Key | 是否匹配 | 说明 |

|---|---|---|---|

logs.error.payment | logs.*.* | ✅ | error 和 payment 各为一个单词 |

logs.info.user.login | logs.info.* | ✅ | 最后一部分任意 |

logs.debug.api.v1.health | logs.# | ✅ | # 匹配任意长度路径 |

orders.created.asia.shanghai | orders.created.* | ✅ | 匹配三级Key的最后一节 |

orders.updated.eu.paris | orders.created.* | ❌ | 类型不一致(created vs updated) |

user.activity.click.home | user.*.click.# | ✅ | activity 匹配 * , home 匹配 # |

这种基于层次化命名空间的匹配机制使得Topic Exchange具备极强的表达能力,开发者可根据业务维度自由设计主题结构。

3.2.2 层次化主题命名规范设计原则

为了充分发挥Topic Exchange的优势,合理的Routing Key命名规范至关重要。推荐遵循以下设计原则:

- 层级分明 :按业务域→子模块→操作类型组织,如

service.module.event; - 语义清晰 :避免缩写或模糊词汇,增强可读性;

- 粒度适中 :不宜过细(增加管理成本),也不宜过粗(降低筛选精度);

- 统一前缀 :建议以功能大类开头,如

log.、event.、metric.等; - 大小写统一 :建议全部小写,防止因大小写差异导致匹配失败。

举例来说,在金融交易系统中可定义如下主题体系:

| 主题格式 | 示例 | 用途 |

|---|---|---|

trade.order.created.<region> | trade.order.created.us | 订单创建区域分布 |

risk.alert.level.<level> | risk.alert.level.high | 风控告警等级 |

settlement.batch.completed | settlement.batch.completed | 批量结算完成通知 |

通过规范化设计,团队成员可以快速理解消息流向,并准确配置Binding策略。

3.2.3 匹配效率与复杂度分析

虽然Topic Exchange功能强大,但其背后的匹配算法并非无代价。RabbitMQ内部使用树形结构(Trie)来存储Binding规则,以便高效查找匹配的队列。然而,随着Binding数量的增长,尤其是包含大量 # 通配符的规则,查询性能可能受到影响。

根据官方基准测试数据,在典型硬件环境下:

- 单个Topic Exchange支持数千个队列绑定;

- 平均每秒可处理数万条消息的路由决策;

- 使用 * 比 # 性能更高,因前者只需单层匹配;

- 过度使用 #.xxx 或 xxx.# 可能导致回溯搜索开销上升。

因此,在高吞吐场景下应尽量避免使用深层次嵌套的 # 通配符,优先采用精确匹配或有限层级的 * 匹配。

下面是一段用于演示Topic Exchange动态路由的Java代码:

// TopicProducer.java

public class TopicProducer {

private static final String EXCHANGE_NAME = "topic.events";

public static void main(String[] args) throws Exception {

ConnectionFactory factory = new ConnectionFactory();

factory.setHost("localhost");

try (Connection connection = factory.newConnection();

Channel channel = connection.createChannel()) {

channel.exchangeDeclare(EXCHANGE_NAME, BuiltinExchangeType.TOPIC, true);

String[] messages = {

"High severity alert from auth service",

"User login attempt recorded",

"Database backup completed successfully"

};

// 发送不同Routing Key的消息

channel.basicPublish(EXCHANGE_NAME, "alert.critical.auth", null,

messages[0].getBytes());

channel.basicPublish(EXCHANGE_NAME, "auth.login.attempt", null,

messages[1].getBytes());

channel.basicPublish(EXCHANGE_NAME, "backup.db.daily.success", null,

messages[2].getBytes());

System.out.println("[x] Messages sent with various routing keys.");

}

}

}

逻辑分析:

- 声明名为 topic.events 的持久化Topic Exchange;

- 分别使用 alert.critical.auth 、 auth.login.attempt 等符合规范的Routing Key发送消息;

- 每条消息将根据Binding规则投递给对应的队列。

// TopicConsumer.java

public class TopicConsumer {

private final String bindingPattern;

private final String consumerId;

public TopicConsumer(String bindingPattern, String consumerId) {

this.bindingPattern = bindingPattern;

this.consumerId = consumerId;

}

public void start() throws Exception {

ConnectionFactory factory = new ConnectionFactory();

factory.setHost("localhost");

Connection connection = factory.newConnection();

Channel channel = connection.createChannel();

channel.exchangeDeclare("topic.events", BuiltinExchangeType.TOPIC, true);

String queueName = channel.queueDeclare().getQueue();

// 根据传入的模式绑定

channel.queueBind(queueName, "topic.events", bindingPattern);

System.out.println("[" + consumerId + "] Bound to pattern: " + bindingPattern);

DeliverCallback callback = (consumerTag, delivery) -> {

String msg = new String(delivery.getBody(), StandardCharsets.UTF_8);

System.out.println("[" + consumerId + "] Received: " + msg);

};

channel.basicConsume(queueName, true, callback, s -> {});

}

public static void main(String[] args) throws Exception {

// 启动多个消费者,按不同模式订阅

new TopicConsumer("alert.*", "CriticalAlertWatcher").start();

new TopicConsumer("*.login.*", "LoginMonitor").start();

new TopicConsumer("#.success", "SuccessTracker").start();

}

}

参数说明:

- bindingPattern 控制消费者感兴趣的主题范围;

- queueBind 使用通配符Binding Key实现选择性订阅;

- 每个消费者启动后将持续监听符合条件的消息。

该实现展示了Topic Exchange如何支持多样化的订阅策略,满足不同角色的服务需求。

3.3 基于Topic Exchange的日志分级处理系统构建

结合前述理论与技术,现设计一个基于Topic Exchange的日志处理系统,支持按级别和模块进行精细化过滤与分发。

3.3.1 定义log. . 格式的主题键

统一规定日志消息的Routing Key格式为: log.<severity>.<component> ,其中:

- <severity> 取值包括: debug , info , warn , error

- <component> 表示服务模块,如 payment , order , user

例如:

- log.error.payment :支付服务错误日志

- log.info.order :订单服务信息日志

- log.warn.user :用户服务警告日志

3.3.2 创建error. 、 .payment等灵活绑定策略

不同消费者可根据职责绑定不同的模式:

- 运维团队关注所有错误日志 → 绑定 log.error.*

- 支付小组只关心支付相关日志 → 绑定 log.*.payment

- 全局审计服务需捕获所有日志 → 绑定 log.#

graph LR

P[Log Producer] -->|log.error.payment| T[Topic Exchange]

T --> Q1[Queue: error.all] --> C1[Ops Team]

T --> Q2[Queue: logs.payment] --> C2[Payment Team]

T --> Q3[Queue: logs.all] --> C3[Audit Service]

style Q1 fill:#ffebee,stroke:#c62828

style Q2 fill:#e8f5e9,stroke:#2e7d32

style Q3 fill:#fff3e0,stroke:#ef6c00

该拓扑结构体现了Topic Exchange在复杂订阅场景下的灵活性。

3.3.3 实现不同模块消费者按需订阅特定日志流

Java实现片段如下:

// 日志生产者

channel.basicPublish("logging.topic", "log.error.database",

MessageProperties.PERSISTENT_TEXT_PLAIN,

"DB connection timeout".getBytes());

// 错误监控消费者

channel.queueBind(queueName, "logging.topic", "log.error.*");

// 支付模块监听者

channel.queueBind(queueName, "logging.topic", "log.*.payment");

// 全量日志归档

channel.queueBind(queueName, "logging.topic", "log.#");

通过合理设计Binding规则,系统可在不影响性能的前提下实现高度定制化的消息分发策略。

3.4 多种Exchange模式对比与选型建议

3.4.1 四种Exchange适用场景归纳总结

| Exchange类型 | 匹配机制 | 典型用途 | 是否使用Routing Key |

|---|---|---|---|

| Direct | 精确匹配 | 点对点任务分发、RPC响应 | 是 |

| Fanout | 全量广播 | 日志广播、事件通知 | 否 |

| Topic | 通配符匹配 | 多维度订阅、日志分级 | 是 |

| Headers | 键值对匹配 | 复杂条件路由(较少用) | 否(使用Headers) |

3.4.2 性能开销与运维复杂度权衡

| 维度 | Direct | Fanout | Topic | Headers |

|---|---|---|---|---|

| 路由性能 | ⭐⭐⭐⭐⭐ | ⭐⭐⭐⭐⭐ | ⭐⭐⭐☆ | ⭐⭐ |

| 配置复杂度 | 低 | 低 | 中 | 高 |

| 扩展性 | 高 | 极高 | 高 | 中 |

| 适用场景广度 | 广泛 | 特定 | 灵活 | 小众 |

综合来看:

- 若追求极致性能且路由简单 → 选用Direct;

- 若需广播所有消息 → 选用Fanout;

- 若需按主题分类订阅 → 选用Topic;

- 若需基于元数据复杂判断 → 可考虑Headers(但通常可用Topic替代)。

最终选型应结合业务需求、系统规模与长期维护成本综合评估。

4. RabbitMQ Java集成架构与项目工程化实践

在企业级Java应用开发中,消息中间件的引入不仅仅是技术选型的问题,更是一次系统架构层面的重构。RabbitMQ作为分布式系统通信的核心组件之一,其集成方式直接影响系统的可维护性、扩展性和稳定性。本章将围绕一个典型的 rabbitMQ-demo-main 工程项目展开,深入剖析如何通过合理的模块划分、配置管理与框架选择,实现RabbitMQ在Java项目中的工程化落地。重点聚焦于实际生产环境中常见的痛点问题——如连接资源管理、序列化统一处理、多环境配置隔离等,并结合Spring Boot与原生客户端的对比分析,给出不同场景下的最佳实践建议。

随着微服务架构的普及,异步通信已成为解耦服务调用、提升响应性能的重要手段。然而,若缺乏良好的工程结构设计,简单的消息收发逻辑也可能演变为难以维护的技术债。因此,构建一套标准化、可复用、易监控的RabbitMQ集成架构体系,是保障消息系统长期稳定运行的前提。接下来的内容将从具体项目结构入手,逐层解析各模块职责边界,展示如何通过配置抽象、依赖注入和外部化参数控制,提升整个消息系统的灵活性与健壮性。

4.1 rabbitMQ-demo-main项目结构深度拆解

现代Java项目的组织结构不仅影响代码可读性,更直接决定了团队协作效率与后期运维成本。以 rabbitMQ-demo-main 为例,该项目采用典型的分层架构模式,旨在实现高内聚、低耦合的设计目标。通过对核心模块的清晰划分,使得开发者能够快速定位功能入口,降低理解门槛,同时为后续自动化测试、CI/CD流程提供良好支持。

4.1.1 核心模块划分:config、producer、consumer、utils

该项目主要由四个核心包构成:

-

config:负责RabbitMQ连接工厂初始化、交换机/队列声明及绑定逻辑; -

producer:封装消息发送逻辑,包括路由键设置、消息体构造与发布操作; -

consumer:实现消息监听器注册、消息处理回调以及确认机制; -

utils:提供通用工具类,如JSON序列化、日志记录、异常包装等。

这种分层方式遵循“单一职责原则”,每个模块只关注特定领域的功能实现。例如,在 config 包中集中管理所有与RabbitMQ基础设施相关的声明操作,避免了在业务代码中散落大量AMQP协议调用语句,提升了代码整洁度。

以下为项目目录结构示意图(使用Mermaid流程图表示):

graph TD

A[rabbitMQ-demo-main] --> B[config]

A --> C[producer]

A --> D[consumer]

A --> E[utils]

B --> B1[ConnectionFactoryConfig.java]

B --> B2[QueueExchangeBindingConfig.java]

C --> C1[OrderUpdateProducer.java]

C --> C2[LogMessageProducer.java]

D --> D1[PaymentConsumer.java]

D --> D2[ErrorLogConsumer.java]

E --> E1[JsonUtil.java]

E --> E2[RetryUtil.java]

该结构具备良好的扩展性。当新增一种消息类型时,只需在 producer 中添加新的生产者类,在 consumer 中编写对应的消费者即可,无需修改已有代码,符合开闭原则。

此外,通过Maven或Gradle进行依赖管理,确保 amqp-client 库版本统一,避免因版本冲突导致的运行时错误。推荐使用如下依赖配置:

<dependency>

<groupId>com.rabbitmq</groupId>

<artifactId>amqp-client</artifactId>

<version>5.20.0</version>

</dependency>

此版本经过广泛验证,支持TLS加密、连接自动恢复等高级特性,适用于大多数生产环境。

| 模块 | 职责说明 | 是否可独立部署 |

|---|---|---|

| config | 初始化连接、声明资源 | 否,需被其他模块引用 |

| producer | 发送消息到指定Exchange | 是,可作为独立微服务 |

| consumer | 监听队列并处理消息 | 是,通常独立运行 |

| utils | 提供跨模块共用工具 | 是,可打包为公共库 |

该表格清晰展示了各模块的功能边界及其部署可能性,有助于在微服务架构中合理规划服务粒度。

4.1.2 配置类封装ConnectionFactory初始化逻辑

ConnectionFactory 是RabbitMQ Java客户端的起点,用于创建与Broker的TCP连接。频繁手动创建连接不仅容易出错,还会造成资源浪费。因此,应将其初始化过程封装在一个独立的配置类中,借助Spring容器或静态工厂模式实现单例管理。

以下是一个典型的 ConnectionFactoryConfig 实现:

public class ConnectionFactoryConfig {

private static ConnectionFactory connectionFactory;

public static synchronized ConnectionFactory getConnectionFactory() {

if (connectionFactory == null) {

connectionFactory = new ConnectionFactory();

connectionFactory.setHost("localhost");

connection.factory.setPort(5672);

connectionFactory.setUsername("guest");

connectionFactory.setPassword("guest");

connectionFactory.setVirtualHost("/");

connectionFactory.setConnectionTimeout(30000);

connectionFactory.setAutomaticRecoveryEnabled(true); // 自动重连

connectionFactory.setNetworkRecoveryInterval(10000); // 重试间隔

}

return connectionFactory;

}

public static Connection createConnection() throws IOException, TimeoutException {

return getConnectionFactory().newConnection();

}

}

代码逻辑逐行解读:

-

private static ConnectionFactory connectionFactory;

声明静态变量,保证全局唯一实例。 -

synchronized getConnectionFactory()

使用同步方法防止多线程并发下重复初始化。 -

setHost/setPort/setUsername/password/virtualHost

设置连接基本信息,这些参数应尽量从配置文件读取,而非硬编码。 -

setConnectionTimeout(30000)

连接超时设为30秒,防止阻塞主线程。 -

setAutomaticRecoveryEnabled(true)

开启自动恢复机制,网络中断后尝试重新连接。 -

setNetworkRecoveryInterval(10000)

设置重连间隔时间为10秒,避免过于频繁的重试冲击服务器。 -

createConnection()方法封装了连接创建过程,屏蔽底层细节。

该设计的优点在于:

- 资源复用 :多个生产者/消费者共享同一连接池;

- 容错能力强 :启用自动恢复机制应对临时网络抖动;

- 易于调试 :统一入口便于添加日志埋点或监控钩子。

进一步优化可结合Spring Bean管理:

@Configuration

public class RabbitMQConfig {

@Value("${rabbitmq.host}")

private String host;

@Value("${rabbitmq.port}")

private int port;

@Bean

public ConnectionFactory connectionFactory() {

ConnectionFactory factory = new ConnectionFactory();

factory.setHost(host);

factory.setPort(port);

factory.setUsername("admin");

factory.setPassword("secure_password");

factory.setAutomaticRecoveryEnabled(true);

return factory;

}

@Bean(destroyMethod = "close")

public Connection connection() throws Exception {

return connectionFactory().newConnection();

}

}

此时, @Value 注解实现了配置参数的外部注入,极大增强了灵活性。

4.1.3 消息体序列化与反序列化统一处理机制

在分布式系统中,消息内容通常以字节数组形式在网络上传输。Java对象需经过序列化才能写入消息体,接收方则需反序列化还原。若不加以规范,极易出现兼容性问题或安全漏洞。

为此,应在 utils 包中建立统一的序列化工具类。推荐使用JSON格式替代JDK原生序列化,因其具有语言无关性、可读性强、跨平台兼容等优势。

public class JsonUtil {

private static final ObjectMapper objectMapper = new ObjectMapper();

static {

// 忽略未知字段,防止反序列化失败

objectMapper.configure(DeserializationFeature.FAIL_ON_UNKNOWN_PROPERTIES, false);

// 支持空值序列化

objectMapper.setSerializationInclusion(JsonInclude.Include.NON_NULL);

}

public static byte[] serialize(Object obj) throws Exception {

return objectMapper.writeValueAsBytes(obj);

}

public static <T> T deserialize(byte[] data, Class<T> clazz) throws Exception {

return objectMapper.readValue(data, clazz);

}

}

参数说明与逻辑分析:

-

ObjectMapper是Jackson库的核心类,负责Java对象与JSON之间的转换; -

FAIL_ON_UNKNOWN_PROPERTIES=false允许接收端忽略多余字段,增强向前兼容性; -

NON_NULL策略减少无效字段传输,节省带宽; -

serialize()方法将任意POJO转为byte[],适配BasicProperties.getBody()接口; -

deserialize()接收字节数组并还原为指定类型的对象。

假设我们有一个订单更新事件类:

public class OrderUpdateEvent {

private String orderId;

private String status;

private BigDecimal amount;

// getter/setter省略

}

生产者侧序列化调用:

OrderUpdateEvent event = new OrderUpdateEvent("O123", "PAID", new BigDecimal("99.99"));

byte[] messageBody = JsonUtil.serialize(event);

channel.basicPublish("order-exchange", "pay.order.update", null, messageBody);

消费者侧反序列化处理:

DeliverCallback deliverCallback = (consumerTag, delivery) -> {

try {

OrderUpdateEvent event = JsonUtil.deserialize(delivery.getBody(), OrderUpdateEvent.class);

System.out.println("Received order: " + event.getOrderId());

channel.basicAck(delivery.getEnvelope().getDeliveryTag(), false);

} catch (Exception e) {

channel.basicNack(delivery.getEnvelope().getDeliveryTag(), false, true);

}

};

通过统一序列化机制,有效规避了以下风险:

- 类路径不一致导致 ClassNotFoundException ;

- 字段变更引发反序列化失败;

- 敏感字段意外暴露(可通过 @JsonIgnore 控制);

同时为未来接入Avro、Protobuf等高性能序列化方案预留扩展点。

4.2 Spring Boot与原生Java集成方式对比分析

在Java生态中,RabbitMQ的集成存在两种主流方式:一是基于 amqp-client 的原生API编程,二是通过Spring AMQP提供的高层抽象。二者各有优劣,适用于不同阶段和规模的项目。

4.2.1 原生amqp-client的轻量级优势与编码复杂度

amqp-client 是RabbitMQ官方提供的Java SDK,直接映射AMQP协议指令,具备最小依赖、最高性能的特点。适合嵌入小型工具、脚本或对启动速度有严苛要求的场景。

优点:

- 无额外依赖,Jar包体积小(约500KB);

- 执行效率高,无Spring上下文开销;

- 可精确控制每一步操作,适合学习协议原理。

缺点:

- 所有资源管理需手动编码,如连接、信道、异常处理;

- 缺乏自动装配能力,配置繁琐;

- 不支持注解驱动模型,消费者需自行实现监听循环。

例如,注册一个消费者需要完整编写如下代码:

Channel channel = connection.createChannel();

channel.queueDeclare("my.queue", true, false, false, null);

DefaultConsumer consumer = new DefaultConsumer(channel) {

@Override

public void handleDelivery(String consumerTag, Envelope envelope,

AMQP.BasicProperties properties, byte[] body) throws IOException {

System.out.println("Message received: " + new String(body));

channel.basicAck(envelope.getDeliveryTag(), false);

}

};

channel.basicConsume("my.queue", false, consumer);

尽管功能完整,但模板代码冗余,不利于大规模项目维护。

4.2.2 Spring AMQP抽象层提供的自动化配置能力

Spring AMQP是对 amqp-client 的封装,提供了 RabbitTemplate 、 @RabbitListener 等便捷组件,显著降低了开发门槛。

关键特性包括:

- 自动配置

ConnectionFactory、RabbitTemplate、AmqpAdmin - 基于注解的消费者定义,无需手动管理Channel

- 支持SpEL表达式动态路由

- 与Spring Boot Actuator集成,便于健康检查

配置示例:

spring:

rabbitmq:

host: localhost

port: 5672

username: guest

password: guest

virtual-host: /

listener:

simple:

acknowledge-mode: manual

concurrency: 3

max-concurrency: 10

消费者代码极度简洁:

@Component

public class PaymentConsumer {

@RabbitListener(queues = "payment.queue")

public void processPayment(OrderUpdateEvent event, Channel channel,

@Header(AmqpHeaders.DELIVERY_TAG) long deliveryTag) {

try {

System.out.println("Processing payment for order: " + event.getOrderId());

channel.basicAck(deliveryTag, false);

} catch (Exception e) {

try {

channel.basicNack(deliveryTag, false, true);

} catch (IOException ioException) {

throw new RuntimeException(ioException);

}

}

}

}

Spring容器会自动完成:

- 队列声明(若不存在)

- 连接池管理

- 异常捕获与重试调度

- 多线程并发消费

这极大地提升了开发效率,尤其适合快速迭代的企业级应用。

4.2.3 @RabbitListener注解驱动的消费者开发模式

@RabbitListener 是Spring AMQP最强大的功能之一,允许开发者以声明式方式定义消息处理器。

支持多种绑定形式:

@RabbitListener(bindings = @QueueBinding(

value = @Queue(value = "error.logs", durable = "true"),

exchange = @Exchange(value = "log.exchange", type = ExchangeTypes.TOPIC),

key = "log.error.*"

public void handleErrorLogs(String message) {

log.error("Error log received: {}", message);

}

上述代码等价于手动执行:

- 声明名为 error.logs 的持久化队列;

- 绑定到 log.exchange 交换机,使用 log.error.* 作为Routing Key;

- 启动监听器接收匹配消息。

优势体现在:

- 声明即配置 :无需编写额外的绑定代码;

- 编译期校验 :IDE可提示语法错误;

- 灵活组合 :支持动态SpEL表达式生成队列名或Key。

同时也支持条件监听:

@RabbitListener(queues = "#{systemProperties['queue.name']}")

从JVM系统属性读取队列名称,实现运行时动态切换。

4.2.4 条件选择:何时使用Spring生态集成方案

虽然Spring AMQP带来诸多便利,但在某些场景下仍需谨慎评估是否引入Spring框架。

| 场景 | 推荐方式 | 理由 |

|---|---|---|

| 快速原型开发 | ✅ Spring Boot | 加速MVP构建,减少样板代码 |

| 微服务架构 | ✅ Spring Boot | 与Eureka、Config Server无缝整合 |

| 嵌入式设备或脚本 | ❌ 原生client | 减少内存占用,避免Spring上下文启动延迟 |

| 学习AMQP协议机制 | ❌ 原生client | 更贴近底层,利于理解Channel、Exchange等概念 |

| 高频低延迟任务 | ⚠️ 视情况而定 | 若QPS极高且消息极小,原生可能略优 |

综上所述,对于80%以上的业务系统,推荐优先采用Spring AMQP集成方案;而对于特殊性能需求或教学演示场景,则可选用原生客户端进行精细化控制。

4.3 配置文件驱动的参数外部化管理

在真实生产环境中,RabbitMQ的连接信息、队列策略、线程数等参数必须能够灵活调整,不能固化在代码中。否则每次变更都需重新编译打包,严重影响交付效率。

4.3.1 application.properties/yml中host、port、username等属性注入

Spring Boot天然支持外部化配置,可通过 application.yml 集中管理所有RabbitMQ相关参数:

rabbitmq:

host: ${RABBIT_HOST:localhost}

port: ${RABBIT_PORT:5672}

username: ${RABBIT_USER:guest}

password: ${RABBIT_PASS:guest}

virtual-host: ${RABBIT_VHOST:/}

connection-timeout: 30000

channels-per-connection: 25

然后在配置类中使用 @ConfigurationProperties 绑定:

@Component

@ConfigurationProperties(prefix = "rabbitmq")

@Data

public class RabbitMQProperties {

private String host;

private int port;

private String username;

private String password;

private String virtualHost;

private int connectionTimeout;

private int channelsPerConnection;

}

这样即可实现“一次编码,多环境运行”。通过Docker环境变量或K8s ConfigMap注入不同值,轻松实现开发、测试、生产环境隔离。

4.3.2 敏感信息加密与多环境配置隔离策略

密码等敏感信息不应明文存储。可采用Jasypt等加密库实现属性解密:

<dependency>

<groupId>com.github.ulisesbocchio</groupId>

<artifactId>jasypt-spring-boot-starter</artifactId>

<version>3.0.5</version>

</dependency>

加密后的配置:

rabbitmq:

username: admin

password: ENC(uj5nF3ZvK9zQ2aXcLmNpOqRsTuVxYzAb)

启动时传入解密密钥:

java -Djasypt.encryptor.password=myStrongKey -jar app.jar

此外,利用Spring Profile实现多环境配置分离:

src/main/resources/

├── application.yml

├── application-dev.yml

├── application-test.yml

└── application-prod.yml

激活指定环境:

--spring.profiles.active=prod

4.3.3 动态调整线程池与连接数参数的运行时支持

为了应对流量波动,建议将消费者线程数、预取数量等参数设计为可动态调整。

例如:

spring:

rabbitmq:

listener:

simple:

prefetch: ${PREFETCH_COUNT:1}

concurrency: ${CONSUMER_THREADS:1}

max-concurrency: ${MAX_CONSUMER_THREADS:5}

配合Kubernetes HPA(Horizontal Pod Autoscaler),可根据队列长度自动伸缩Pod数量,实现真正的弹性伸缩。

此外,可通过Actuator端点实时查看连接状态:

{

"rabbitmq": {

"connections": [

{

"id": "conn-1",

"clientAddress": "172.17.0.5",

"state": "running",

"channels": 3

}

]

}

}

帮助运维人员及时发现连接泄漏或瓶颈问题。

5. 消息可靠性保障机制与典型分布式应用场景

5.1 消息确认机制初探:确保不丢失的关键防线

在分布式系统中,消息的可靠传递是构建高可用服务的基础。RabbitMQ 提供了多层次的消息确认机制,从生产者投递到消费者处理,形成完整的“端到端”消息不丢失防线。

5.1.1 生产者端Confirm模式实现可靠投递

RabbitMQ 的 Confirm 模式允许生产者开启“发布确认”功能,当消息成功被 Broker 接收并持久化后,Broker 会向生产者发送一个 basic.ack 回应;若失败则返回 basic.nack 。这使得生产者可以明确知道每条消息是否真正进入队列。

Channel channel = connection.createChannel();

// 开启Confirm模式

channel.confirmSelect();

String message = "Order update event: orderId=1001";

String routingKey = "pay.order.update";

String exchangeName = "direct_order_exchange";

// 发送消息

channel.basicPublish(exchangeName, routingKey, MessageProperties.PERSISTENT_TEXT_PLAIN, message.getBytes());

// 等待Broker确认(同步方式)

if (channel.waitForConfirms(5000)) {

System.out.println("✅ 消息已成功确认投递");

} else {

System.err.println("❌ 消息投递失败或超时未确认");

}

参数说明 :

-confirmSelect():启用 Confirm 模式。

-waitForConfirms(timeout):阻塞等待确认响应,适用于低并发场景。

- 高并发下建议使用异步监听addConfirmListener,避免线程阻塞。

| 确认方式 | 适用场景 | 性能表现 |

|---|---|---|

| 同步 waitForConfirms | 调试、小批量发送 | 低吞吐 |

| 异步 ConfirmListener | 高频生产环境 | 高吞吐 |

| 批量 Confirm | 批处理任务 | 中等延迟 |

5.1.2 消费者Ack机制防止消息未处理即被删除

默认情况下,RabbitMQ 使用自动 Ack 模式,一旦消息被推送至消费者,就会立即从队列中移除。这种机制存在风险:若消费者在处理过程中崩溃,则消息永久丢失。

因此,必须关闭自动 Ack,采用手动确认机制:

channel.basicConsume("order.queue", false, new DefaultConsumer(channel) {

@Override

public void handleDelivery(String consumerTag, Envelope envelope,

AMQP.BasicProperties properties, byte[] body) throws IOException {

String message = new String(body, "UTF-8");

try {

// 模拟业务处理

processOrderUpdate(message);

// 处理成功后手动ACK

channel.basicAck(envelope.getDeliveryTag(), false);

System.out.println("✅ 已ACK消息:" + message);

} catch (Exception e) {

// 可选择拒绝并重新入队或进入死信队列

boolean requeue = false; // 不重试,避免无限循环

channel.basicNack(envelope.getDeliveryTag(), false, requeue);

System.err.println("❌ 消息处理失败,已NACK:" + message);

}

}

});

关键逻辑解释 :

- 第二个参数false表示关闭自动 Ack。

-basicAck():确认消息已被正确处理。

-basicNack():批量否定,结合requeue=false可将消息转入死信队列(DLX)进行后续分析。

5.1.3 持久化配置(exchange、queue、message)组合应用

为了防止 RabbitMQ 服务重启导致消息丢失,需对交换机、队列和消息三者同时进行持久化设置。

// 声明持久化Exchange

channel.exchangeDeclare("direct_order_exchange", BuiltinExchangeType.DIRECT, true);

// 声明持久化Queue

channel.queueDeclare("order.queue", true, false, false, null);

// 绑定

channel.queueBind("order.queue", "direct_order_exchange", "pay.order.update");

// 发送持久化消息

AMQP.BasicProperties props = MessageProperties.PERSISTENT_TEXT_PLAIN;

channel.basicPublish("direct_order_exchange", "pay.order.update", props, "data".getBytes());

| 组件 | 持久化标志 | 作用 |

|---|---|---|

| Exchange | durable=true | 重启后交换机仍存在 |

| Queue | durable=true | 重启后队列元数据保留 |

| Message | deliveryMode=2 | 消息写入磁盘而非仅内存 |

⚠️ 注意:即使三者均持久化,也不能完全保证零丢失(如磁盘损坏),但已满足绝大多数生产级需求。

5.2 高并发场景下的性能优化策略

随着业务流量增长,单纯的消息可靠传递已不足以支撑系统稳定运行,还需引入性能调优手段提升整体吞吐能力。

5.2.1 批量发送与异步处理提升吞吐量

对于高频事件(如日志上报、监控指标),可采用批量发送减少网络往返次数:

int batchSize = 100;

long startTime = System.currentTimeMillis();

for (int i = 0; i < batchSize; i++) {

String msg = "log.entry." + i;

channel.basicPublish("fanout.logs", "", null, msg.getBytes());

}

// 批量确认

channel.waitForConfirmsOrDie(10_000); // 超时抛异常

System.out.printf("📦 批量发送%d条耗时:%dms\n", batchSize, System.currentTimeMillis() - startTime);

✅ 效果:相比单条发送,吞吐量可提升 5~10 倍。

5.2.2 连接复用与Channel池化减少开销

Connection 是线程安全的,应全局共享;而 Channel 是轻量级、非线程安全的,适合通过池化管理:

<!-- 使用 commons-pool2 管理 Channel -->

<dependency>

<groupId>org.apache.commons</groupId>

<artifactId>commons-pool2</artifactId>

<version>2.11.1</version>

</dependency>

GenericObjectPoolConfig<Channel> config = new GenericObjectPoolConfig<>();

config.setMaxTotal(50);

config.setMinIdle(10);

config.setMaxIdle(20);

PooledObjectFactory<Channel> factory = new PooledChannelFactory(connection);

ChannelPool channelPool = new ChannelPool(factory, config);

// 获取Channel

try (Channel ch = channelPool.borrowObject()) {

ch.basicPublish("topic.perf", "perf.test", null, "high volume".getBytes());

}

💡 建议:每个微服务实例维护一个 Connection 和多个 Channel 池,避免频繁创建销毁资源。

5.2.3 死信队列与延迟消息应对异常情况

利用 DLX(Dead-Letter Exchange)机制处理消费失败的消息:

Map<String, Object> args = new HashMap<>();

args.put("x-dead-letter-exchange", "dlx.exchange"); // 死信转发到指定Exchange

args.put("x-dead-letter-routing-key", "retry.failed"); // 指定新的Routing Key

args.put("x-message-ttl", 60000); // 消息存活时间(毫秒)

channel.queueDeclare("processing.queue", true, false, false, args);

mermaid 流程图展示消息流转过程:

graph LR

A[Producer] -->|publish| B{Main Exchange}

B --> C[Main Queue]

C --> D[Consumer]

D -- 处理失败/NACK --> E((消息过期/TTL))

E --> F{DLX Exchange}

F --> G[DLQ: Dead Letter Queue]

G --> H[Admin/Retry Service]

该机制广泛用于订单超时取消、支付重试调度等场景。

5.3 RabbitMQ在微服务架构中的典型应用模式

5.3.1 服务间异步通信替代远程同步调用

传统 REST 调用存在强依赖问题。通过 RabbitMQ 实现解耦:

// 支付服务发送事件

eventBus.publish("user.balance.updated", userId, amount);

// 积分服务监听

@RabbitListener(queues = "points.queue")

public void handleBalanceUpdate(UserBalanceEvent event) {

pointsService.addPoints(event.getUserId(), event.getAmount() * 10);

}

优势包括:

- 解除服务间直接依赖;

- 提升系统容错性;

- 支持事件溯源与审计。

5.3.2 利用消息队列削峰填谷缓解数据库压力

面对突发流量(如秒杀活动),可通过 RabbitMQ 缓冲请求:

用户请求 → API Gateway → RabbitMQ → 订单服务串行消费 → 写库

设定消费者速率限流(如每秒处理 100 条),避免数据库被打满。

5.3.3 分布式事务最终一致性方案中的事件驱动角色

在跨服务转账场景中,无法使用本地事务保证一致性。采用“事件驱动 + 最终一致”模式:

- A账户扣款成功 → 发送

MoneyDeductedEvent - B服务监听 → 执行入账操作

- 若失败 → 进入重试队列或人工干预

此模式符合 CAP 理论中的 AP 设计思想,牺牲即时一致性换取可用性。

5.4 构建可扩展的消息中间件使用规范体系

5.4.1 命名规范、监控埋点与告警机制建设

建立统一命名规则提升可维护性:

| 类型 | 规范示例 |

|---|---|

| Exchange | app.event.type.env |

| Queue | service.action.queue |

| Routing Key | domain.action.module |

集成 Prometheus + Grafana 监控队列积压、消费者速率、连接数等指标,并设置阈值告警。

5.4.2 运维视角下的集群部署、镜像队列与高可用保障

生产环境推荐部署 RabbitMQ 镜像队列(Mirrored Queues)或升级为 Quorum Queue(3.8+):

# 设置策略使所有以 ha. 开头的队列自动镜像到所有节点

rabbitmqctl set_policy HA '^ha\.' '{"ha-mode":"all"}'

集群拓扑建议采用至少 3 节点,配合负载均衡器对外暴露服务。

5.4.3 从单机测试到生产上线的全链路验证流程

| 阶段 | 验证内容 |

|---|---|

| 开发 | 单元测试 + Docker 容器化验证 |

| 测试 | 消息轨迹追踪、消费幂等性测试 |

| 预发 | 压测模拟百万级消息堆积 |

| 生产 | 灰度发布 + 动态降级开关 |

通过日志链路ID关联上下游服务,实现消息全链路追踪。

简介:在分布式系统中,消息队列是实现异步通信与系统解耦的核心技术。RabbitMQ作为高性能、稳定的开源消息代理,广泛应用于各类Java后端系统。本文以“rabbitMQ-demo.zip”中的“rabbitMQ-demo-main”项目为基础,深入解析RabbitMQ的Java集成实践,涵盖其核心组件、四种主要交换机模式及实际编码操作。通过本实战项目,开发者可掌握RabbitMQ在Java环境下的连接管理、消息发送与消费流程,并理解如何在真实场景中构建可靠的消息通信机制。

1103

1103

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?