简介:数据分析的关键步骤之一是数据预处理,它影响后续分析的准确性和可靠性。本文深入探讨使用Python进行数据预处理,特别是对Excel文件的操作。介绍了如何导入pandas库、加载和查看Excel文件信息、处理缺失值、识别和处理异常值等关键操作,并提供保存处理后数据的方法。这些基础操作是理解更复杂数据处理策略的起点,有助于提升数据分析的整体质量。

1. Python数据预处理基础

数据预处理是数据分析和机器学习项目中至关重要的一步。在开始分析之前,我们需要确保数据是干净、整齐、一致和完整的。数据预处理包含多个步骤,比如数据清洗、数据转换、数据规范化和归一化等。在这一章节中,我们将简要介绍数据预处理的定义、目的和重要性,并概述数据预处理常见的步骤,为读者构建一个坚实的数据预处理基础。

1.1 数据预处理定义与目的

数据预处理是一个用来准备原始数据以便进行分析的过程。数据在原始状态下往往杂乱无章,存在错误、不一致、重复或缺失等问题。预处理的目的是要使得数据更加适合于分析,减少错误和偏差,提高数据质量和分析结果的可靠性。

1.2 数据预处理的重要性

在数据科学中,”Garbage in, garbage out”(输入垃圾,输出垃圾)这句谚语经常被引用。好的数据预处理可以显著地提高模型的预测性能和准确性。没有经过预处理的数据可能会导致模型训练失败或产生误导性的分析结果。

1.3 数据预处理常见步骤

数据预处理包括但不限于以下步骤:

- 数据清洗(去除重复、纠正错误、处理缺失值)

- 数据集成(合并来自多个源的数据)

- 数据转换(规范化、归一化、特征构造)

- 数据规约(降维)

- 数据离散化(将连续属性转换为离散属性)

预处理是数据科学和机器学习中的基础,接下来的章节将深入探讨如何在Python中使用各种工具和库来实现这些数据预处理步骤。

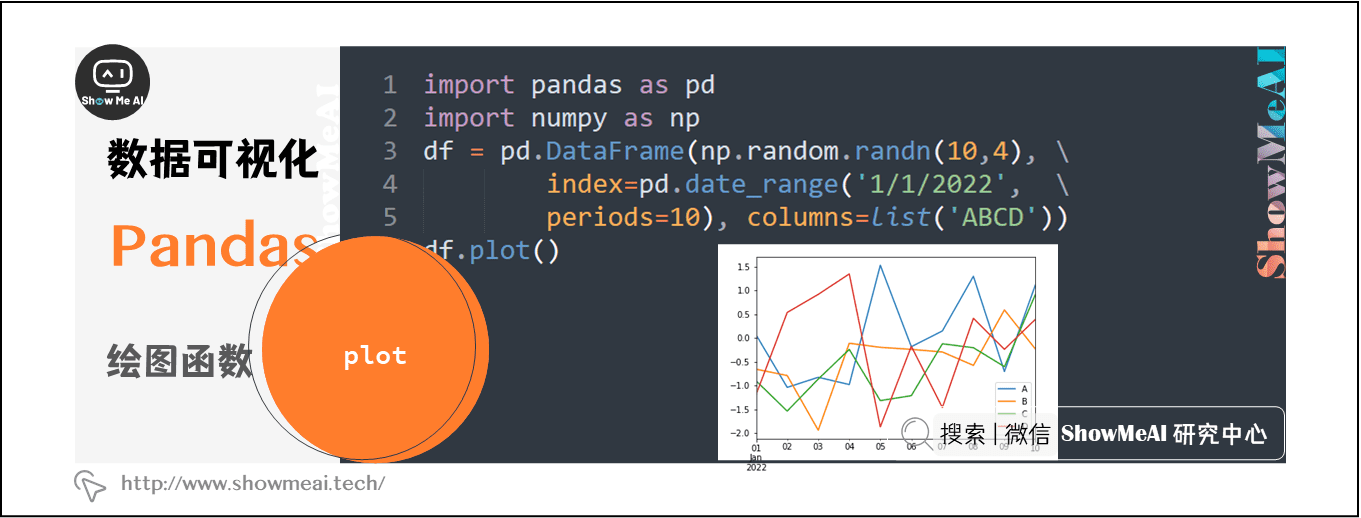

2. Pandas库与DataFrame使用

2.1 Pandas库概述

2.1.1 Pandas库的安装与导入

Pandas是一个开源的Python库,广泛用于数据分析和数据处理领域。它是建立在NumPy之上的一个强大工具,提供了高性能的数据结构,如Series和DataFrame,以及数据操作和分析的功能。安装Pandas库十分简单,可以使用pip进行安装。

pip install pandas

安装完毕后,在Python脚本中,我们首先需要导入Pandas库,通常我们会使用其别名 pd :

import pandas as pd

2.1.2 Pandas库的数据结构

Pandas库提供了两种数据结构: Series 和 DataFrame 。

-

Series是一个一维数组结构,可以存储任何数据类型(整数、字符串、浮点数、Python对象等),其中的元素都有一个与之相关的数据标签,叫做索引。创建一个Series对象非常简单:

s = pd.Series([1, 3, 5, np.nan, 6, 8])

-

DataFrame是一个二维的、表格型的数据结构,可以存储多种数据类型。它是Pandas中最常用的数据结构,适合处理表格形式的数据。创建一个DataFrame对象可以通过多种方式,最简单的一种是使用字典来创建:

data = {

'A': [1, 2, 3, 4],

'B': ['a', 'b', 'c', 'd']

}

df = pd.DataFrame(data)

2.2 DataFrame基本操作

2.2.1 创建DataFrame

创建DataFrame的方法有很多种,除了使用字典之外,还可以从二维数组、结构化或记录数组、元组列表、Series字典等多种形式创建DataFrame对象。

这里以二维数组为例:

import numpy as np

import pandas as pd

data = np.array([

['A', 'B', 'C'],

['X', 'Y', 'Z']

])

columns = ['One', 'Two', 'Three']

index = [0, 1]

df = pd.DataFrame(data, index=index, columns=columns)

以上代码中, data 是一个二维数组, columns 为列名, index 为行索引,创建了一个具有指定行列索引的DataFrame。

2.2.2 DataFrame的索引与切片

索引和切片是操作DataFrame时最基础也是最常用的功能。Pandas中的索引功能非常强大,可以通过标签或位置进行索引,切片则是获取子集的一种方式。

- 索引:

# 通过标签索引

df_label = df.loc[0, 'One']

# 通过位置索引

df_position = df.iloc[1, 2]

- 切片:

# 根据标签切片

df_slice_label = df.loc[:1, 'One':'Two']

# 根据位置切片

df_slice_position = df.iloc[0:2, 0:2]

以上代码展示了如何使用 .loc[] 和 .iloc[] 方法进行索引和切片操作。 .loc[] 用于基于标签的索引,而 .iloc[] 用于基于位置的索引。

2.2.3 DataFrame的基本函数应用

DataFrame提供了许多内置函数来帮助进行数据分析,包括统计函数、字符串处理函数、时间序列分析函数等。

以下是一些常用的数据处理函数:

- 统计函数:

# 获取每列的统计信息

df_stats = df.describe()

# 计算每列的均值

df_mean = df.mean()

- 字符串处理函数:

# 统计每列中字符串长度

df_apply = df.apply(lambda x: x.str.len())

- 时间序列分析函数:

# 如果DataFrame中有一列是日期格式,可以进行时间序列分析

df['date_column'] = pd.to_datetime(df['date_column'])

df_resample = df.resample('M').mean() # 按月重采样并计算均值

在使用Pandas进行数据预处理时,熟悉并掌握这些基本操作是十分重要的,它们为数据分析和预处理工作奠定了基础。

3. 查看Excel数据基本信息

在处理数据之前,了解数据的结构、范围和潜在问题至关重要。本章将引导读者通过Pandas库来查看Excel数据的基本信息,包括读取Excel文件、数据查看技巧等,为后续的数据处理工作打下坚实的基础。

3.1 读取Excel文件

3.1.1 Pandas读取Excel文件的方法

Pandas库为读取Excel文件提供了非常便捷的方法。 read_excel() 函数是Pandas中用于读取Excel文件的主要函数,它能够将Excel文件中的数据直接加载到DataFrame对象中。

import pandas as pd

# 读取Excel文件

df = pd.read_excel('example.xlsx')

通过这个方法,我们就可以将名为 example.xlsx 的Excel文件中的数据读取到DataFrame df 中。在读取的过程中,Pandas会自动根据Excel表单的数据类型来转换数据,例如,文本会转换为字符串类型,数字会转换为浮点数或整数类型。

3.1.2 文件读取选项的使用

read_excel() 函数提供了许多选项来控制如何读取Excel文件,例如指定工作表、读取特定的列、设置索引列等。

# 指定读取特定的工作表

df = pd.read_excel('example.xlsx', sheet_name='Sheet1')

# 读取特定的列

df = pd.read_excel('example.xlsx', usecols=['A', 'C', 'D'])

# 设置索引列

df = pd.read_excel('example.xlsx', index_col='ID')

在实际应用中,合理使用这些选项可以大大提高数据处理的效率,尤其是在处理包含多个工作表或大量列的大型Excel文件时。

3.2 数据查看技巧

3.2.1 DataFrame的头部尾部数据查看

查看DataFrame的头部和尾部数据是了解数据集结构的第一步。Pandas提供了 head() 和 tail() 方法,分别用于查看前几行和后几行数据。

# 查看前5行数据

df_head = df.head()

# 查看后5行数据

df_tail = df.tail()

通过观察头部和尾部数据,我们可以初步判断数据的类型、是否存在异常值以及数据集的总体规模。

3.2.2 DataFrame的统计信息概览

为了更全面地了解数据集的统计特性,可以使用 describe() 方法来获取数据的描述性统计信息。

# 获取数据集的描述性统计信息

df_desc = df.describe()

describe() 方法会返回一个包含计数、均值、标准差、最小值、25%分位数、50%分位数、75%分位数和最大值的统计信息表,这对于初步的数据探索和后续的数据分析非常有用。

在这一章节中,我们介绍了使用Pandas读取Excel文件的方法和一些基本的数据查看技巧。通过这些操作,我们可以有效地掌握数据的基本面貌,为后续的深入分析和处理打下基础。在接下来的章节中,我们将深入了解如何处理缺失值和异常值,以及如何保存清洗后的数据。

4. 缺失值处理方法

4.1 缺失值的识别

4.1.1 缺失值的判断标准

在数据处理过程中,识别出缺失值是第一步,也是至关重要的一步。缺失值通常是指在数据集中预期存在的值却没有出现的情况。这些缺失值可能是由于数据录入错误、数据收集不完整、数据传输过程中丢失等原因造成的。

在Pandas中,缺失值通常用 NaN (Not a Number)表示。当我们读取数据时,Pandas可以自动识别并处理这些缺失值。例如,在读取Excel文件时,如果某列包含空单元格,Pandas读取该列时会将这些空单元格转换为 NaN 。

4.1.2 缺失值的可视化表示

可视化是识别缺失值的直观方法之一。通过绘制数据的热图或使用箱型图,我们可以直观地看到数据中哪些部分缺失。例如,使用 seaborn 库中的 heatmap 函数,可以生成一个矩阵的热图,其中 NaN 值会被特别标记出来。

import seaborn as sns

import pandas as pd

import numpy as np

# 创建一个包含缺失值的DataFrame

data = {

'A': [1, 2, np.nan, 4],

'B': [5, np.nan, np.nan, 8],

'C': [9, 10, 11, 12]

}

df = pd.DataFrame(data)

# 使用seaborn绘制热图

sns.heatmap(df.isnull(), cbar=False, cmap='viridis')

在这段代码中,我们首先创建了一个包含缺失值的DataFrame,并使用 seaborn 的 heatmap 函数生成了一个热图。 isnull() 函数返回一个同样大小的布尔型DataFrame,其中 True 表示原始数据中对应位置是缺失值。通过热图,我们可以清晰地看到哪些数据是缺失的。

4.2 缺失值的处理策略

4.2.1 删除含有缺失值的行或列

在处理缺失值时,一种简单粗暴但有时非常有效的策略是直接删除含有缺失值的行或列。这可以通过Pandas的 dropna() 函数实现。如果我们决定删除包含缺失值的行,我们可以这样做:

df_cleaned = df.dropna(axis=0)

这里, axis=0 参数指定我们按行来删除数据。如果要删除包含缺失值的列,我们可以使用 axis=1 参数。

然而,在实际操作中,删除数据可能会导致我们失去大量的有用信息,特别是当数据集很大或者缺失值比例较高时。因此,在删除数据之前,我们需要仔细考虑是否还有其他更好的方法来处理缺失值。

4.2.2 缺失值填充的方法

另一种处理缺失值的常用策略是使用某种值来填充缺失值,这种方法称为缺失值的“填充”或“插补”。常见的填充方法有使用均值、中位数、众数或固定值等。

以下是一个使用列均值填充缺失值的例子:

df_filled = df.fillna(df.mean())

在这里, fillna() 函数用于填充缺失值,而 df.mean() 返回每列的平均值。这种方法适用于数值型数据,且当数据符合正态分布时效果最佳。对于分类数据,可以使用众数来进行填充。

另外,有时候我们可能希望对不同类型的列使用不同的填充策略。为此,可以结合使用 fillna() 函数与 map() 或 apply() 函数来实现更复杂的填充逻辑:

# 自定义填充策略函数

def fill_strategy(column):

if column.dtype == np.number:

return column.fillna(column.mean())

else:

return column.fillna('Unknown')

# 应用填充策略

df_filled = df.apply(fill_strategy, axis=0)

在上述代码中,我们定义了一个 fill_strategy 函数,它检查每个列的数据类型并相应地应用不同的填充策略。数值列使用均值填充,而分类列使用字符串’Unknown’填充。然后使用 apply() 函数将这个策略应用到每一列上。

处理缺失值的方法选择取决于数据的具体情况以及分析的目标。在实际操作中,建议根据数据的分布和业务逻辑来选择最适合的填充方法。

5. 异常值识别与处理

5.1 异常值的识别方法

异常值是数据集中那些不符合预期模式的值,可能是由数据录入错误、测量误差或者真实且重要的变异所导致的。处理异常值是数据预处理中非常关键的一步,它能够显著地影响到后续的数据分析和模型预测的准确性。

5.1.1 箱型图的使用

箱型图是识别异常值的一种直观方法,它基于数据的四分位数来构造,能够显示数据的分布情况,包括中位数、四分位数以及可能的异常值。

import pandas as pd

import matplotlib.pyplot as plt

# 假设df是一个DataFrame,我们使用箱型图来识别其中的异常值

df.boxplot(column=['data_column'])

plt.show()

在上述代码中, boxplot 方法用于绘制指定列的箱型图。异常值通常被定义为小于 Q1 - 1.5 * IQR 或大于 Q3 + 1.5 * IQR 的值,其中 Q1 和 Q3 分别是第一四分位数和第三四分位数,IQR 是四分位距,即 Q3 - Q1。

5.1.2 Z-score方法的介绍与应用

Z-score方法是另一种识别异常值的统计方法。它通过计算数据点与均值的偏差,并将其除以标准差来确定异常值。数据点的Z-score如果大于3或小于-3,通常被认为是异常值。

from scipy import stats

# 计算Z-score

z_scores = stats.zscore(df['data_column'])

abs_z_scores = abs(z_scores)

# 找出Z-score大于3的异常值

filtered_entries = (abs_z_scores < 3)

outliers = df[~filtered_entries]

print("异常值:")

print(outliers)

在该代码块中, stats.zscore 函数计算指定数据列的Z-score值。然后通过比较绝对值是否小于3来筛选出异常值。对于连续变量数据,Z-score方法是一种相对有效的异常值检测手段。

5.2 异常值的处理策略

处理异常值的策略通常包括删除异常值和变换处理。选择哪种策略取决于数据的性质和分析的目的。

5.2.1 删除异常值

删除异常值是最直接的处理方法,但可能会导致数据丢失过多,特别是在异常值本身就蕴含重要信息的情况下。

# 删除数据中的所有异常值

df_cleaned = df[(abs_z_scores < 3)]

在上面的代码中,通过索引过滤掉Z-score大于3或小于-3的行,从而清理了数据集中的异常值。在删除数据时,应该谨慎考虑其可能带来的信息损失。

5.2.2 异常值的变换处理

变换处理是一种保留异常值并减少其影响的方法,通常包括对数变换、平方根变换、Box-Cox变换等。

import numpy as np

# 对数变换示例

df['data_column_log'] = np.log(df['data_column'])

# 平方根变换示例

df['data_column_sqrt'] = np.sqrt(df['data_column'])

# Box-Cox变换示例(需要正态分布的数据)

from scipy.stats import boxcox

df['data_column_boxcox'], _ = boxcox(df['data_column'] + 1) # 加1是为了保证数据中的非零值

变换处理可以使得数据更符合模型的假设条件,比如正态分布,同时减少极端值的影响。变换后,应重新评估数据以确认异常值的影响已被适当处理。

在本章节的介绍中,我们详细探讨了如何识别和处理异常值,展示了箱型图和Z-score方法,并提供了异常值处理策略的代码实例。接下来,我们将转入数据清洗后的保存阶段,进一步巩固数据处理的整个流程。

6. 数据清洗后的保存

在完成了数据预处理的各种操作之后,数据清洗的最后一步通常是保存处理后的数据,以便于进一步分析或备份。本章节将讨论如何验证数据清洗的效果,并且详细介绍如何将清洗后的数据保存为不同的文件格式。

6.1 数据清洗的验证

在保存数据之前,我们需要确保数据清洗的过程是正确的,并且达到了预期的效果。这里涉及到两个重要的验证步骤:清洗前后数据对比和数据清洗的完整性检查。

6.1.1 清洗前后数据对比

要验证数据清洗的效果,首先需要对比清洗前后的数据。这可以通过比较几个关键的统计量来实现,例如:

- 数据行数和列数

- 数据类型

- 统计指标(均值、中位数、标准差等)

这里我们可以使用Pandas库中的 describe() 函数来获取数据的基本统计信息,然后进行对比。

# 假设df_cleaned是清洗后的数据集,df_original是原始数据集

# 显示原始数据集的基本统计信息

print("原始数据集统计信息:")

print(df_original.describe())

# 显示清洗后数据集的基本统计信息

print("\n清洗后数据集统计信息:")

print(df_cleaned.describe())

6.1.2 数据清洗的完整性检查

除了对比数据统计信息之外,还需要检查数据清洗是否影响了数据的完整性。例如,确保所有的业务规则都被正确地应用到了数据清洗过程中。这包括检查:

- 是否所有预期删除的数据行都被删除了

- 是否所有缺失值都已正确填充或删除

- 是否异常值处理符合预期

此外,还应该考虑数据清洗后是否引入了新的问题,比如数据类型错误、数据丢失或不一致性等。

6.2 数据的保存方法

验证了数据清洗效果之后,下一步是保存处理后的数据。Pandas库提供了多种保存数据的选项,以支持不同格式的输出。本节将重点介绍如何保存为Excel文件和CSV、HDF5等格式。

6.2.1 保存为Excel文件

使用Pandas的 to_excel() 函数,我们可以轻松地将DataFrame保存到Excel文件中。这个函数允许我们指定文件名和其他选项,如工作表名、是否保存索引等。

# 保存清洗后的数据到Excel文件

df_cleaned.to_excel('cleaned_data.xlsx', index=False)

6.2.2 保存为其他格式(如CSV、HDF5等)

除了Excel格式,Pandas还支持将数据保存为CSV、HDF5、JSON等格式。这些格式各有特点,比如CSV文件便于跨平台使用,HDF5支持大数据集,而JSON则常用于数据交换。

保存为CSV文件

# 保存清洗后的数据到CSV文件

df_cleaned.to_csv('cleaned_data.csv', index=False)

保存为HDF5文件

# 保存清洗后的数据到HDF5文件

df_cleaned.to_hdf('cleaned_data.h5', 'data', mode='w')

保存为JSON文件

# 保存清洗后的数据到JSON文件

df_cleaned.to_json('cleaned_data.json', orient='records')

在选择保存格式时,应考虑数据的使用场景和环境要求,以便于选择最合适的方式。

通过本章的学习,我们了解了如何验证数据清洗的效果,并且掌握了多种将清洗后的数据保存到不同格式的方法。这为后续的数据分析和处理提供了坚实的基础。

简介:数据分析的关键步骤之一是数据预处理,它影响后续分析的准确性和可靠性。本文深入探讨使用Python进行数据预处理,特别是对Excel文件的操作。介绍了如何导入pandas库、加载和查看Excel文件信息、处理缺失值、识别和处理异常值等关键操作,并提供保存处理后数据的方法。这些基础操作是理解更复杂数据处理策略的起点,有助于提升数据分析的整体质量。

1113

1113

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?