<摘要>

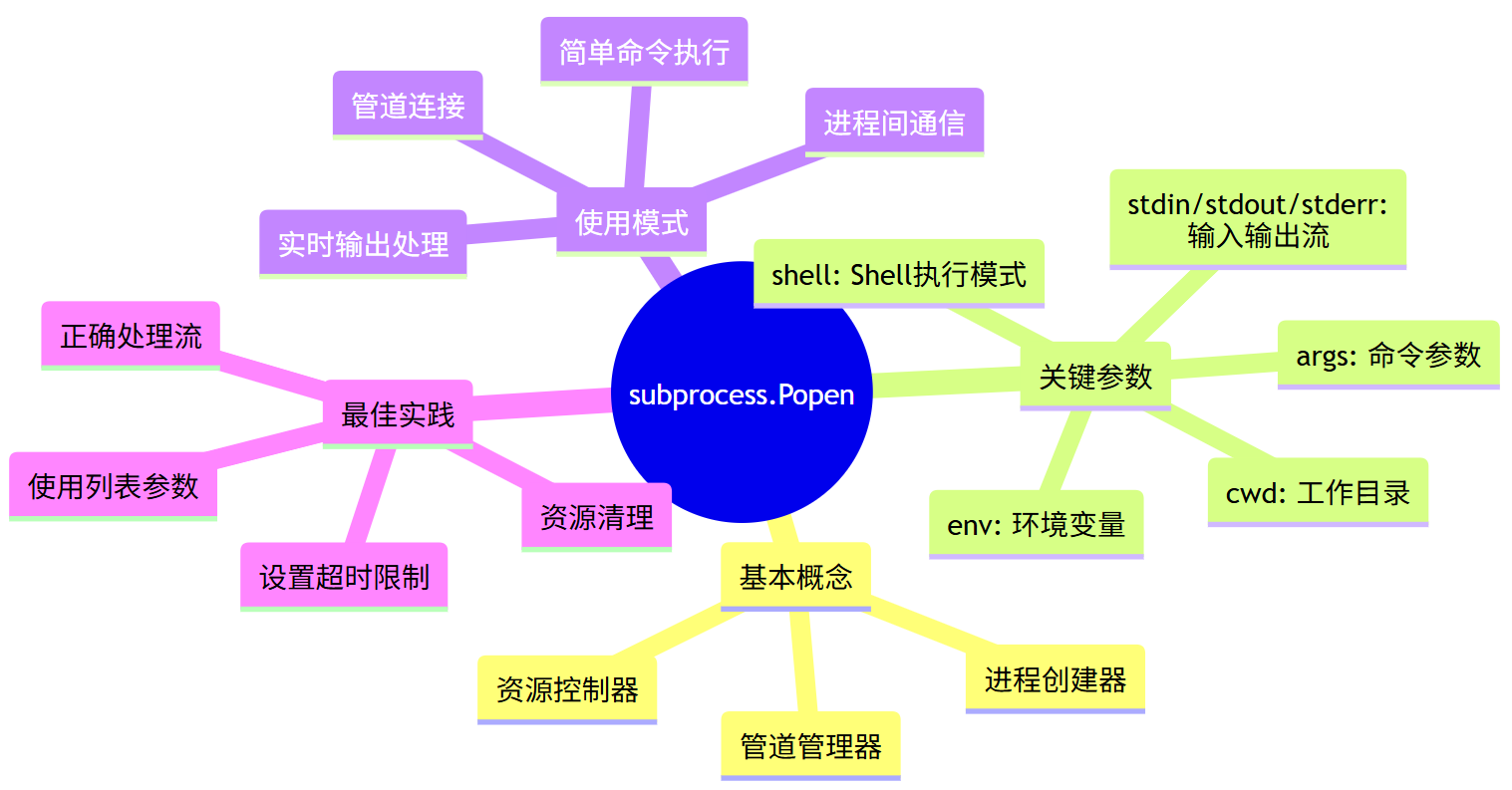

subprocess.Popen是Python中创建和管理子进程的瑞士军刀,就像一位经验丰富的乐队指挥,能够协调多个"乐手"(子进程)完美配合。本文通过生动的生活比喻、详细的技术解析和三个实战案例,深入探讨了这个强大的进程管理工具。从基本概念到高级用法,从参数详解到错误处理,我们将一起揭开Popen的神秘面纱,让你彻底掌握如何在Python程序中优雅地启动和控制外部进程。

<正文>

1. 函数的基本介绍与用途:乐队指挥的魔法棒

想象一下,你是一位交响乐团的指挥,面前坐着各种乐器演奏家。你不能要求小提琴手同时吹小号,也不能让鼓手去拉大提琴。每个音乐家都专注于自己的乐器,而你作为指挥,负责协调整个乐团的演奏。

subprocess.Popen就是Python世界中的"乐队指挥"。

生活中的故事比喻

小明的编程冒险:

小明是个Python程序员,他需要完成一个任务:读取日志文件,用grep过滤错误信息,然后排序去重。他本可以用纯Python写几十行代码,但突然想到:Linux系统已经有现成的grep、sort、uniq命令了,为什么还要重复造轮子?

这就是subprocess.Popen的用武之地!它让小明能够:

- 启动

grep进程处理日志过滤 - 将结果传递给

sort进程排序 - 最后交给

uniq进程去重 - 所有进程像流水线一样协同工作

常见使用场景

# 像搭积木一样组合系统命令

import subprocess

# 场景1:执行系统命令

result = subprocess.Popen(['ls', '-l'], stdout=subprocess.PIPE)

# 场景2:管道连接多个命令

grep_process = subprocess.Popen(['grep', 'error'],

stdin=open('app.log'),

stdout=subprocess.PIPE)

sort_process = subprocess.Popen(['sort'],

stdin=grep_process.stdout,

stdout=subprocess.PIPE)

# 场景3:后台运行服务

server_process = subprocess.Popen(['python', 'server.py'],

stdout=subprocess.DEVNULL,

stderr=subprocess.DEVNULL)

2. 函数的声明与来源:揭开身世之谜

# Popen的"家庭住址"

import subprocess # 这就是它的家

# 它的"身份证"

class subprocess.Popen(

args,

bufsize=-1,

executable=None,

stdin=None,

stdout=None,

stderr=None,

preexec_fn=None,

close_fds=True,

shell=False,

cwd=None,

env=None,

universal_newlines=None,

startupinfo=None,

creationflags=0,

restore_signals=True,

start_new_session=False,

pass_fds=(),

*,

group=None,

extra_groups=None,

user=None,

umask=-1,

encoding=None,

errors=None,

text=None,

pipesize=-1

)

家族背景:

- 所属模块:Python标准库的

subprocess模块 - 替代前辈:取代了老的

os.system、os.spawn*、os.popen*等函数 - 设计理念:提供更安全、更灵活的子进程管理方式

3. 返回值的含义:读懂进程的"心电图"

当Popen创建一个子进程时,它不会等待进程结束,而是立即返回一个Popen对象。这个对象就像是子进程的"遥控器"。

Popen对象的重要属性

process = subprocess.Popen(['sleep', '10'])

print(f"进程PID: {process.pid}") # 进程ID

print(f"返回码: {process.returncode}") # 进程状态

# 进程状态的可能值:

# None: 进程还在运行

# 0: 成功结束

# 正数: 进程正常退出,但返回非0状态码

# 负数: 进程被信号终止

进程状态监控的"心电图"

4. 参数详解:指挥家的工具箱

4.1 args参数:告诉进程要做什么

# 方式1:字符串形式(shell=True时使用)

subprocess.Popen("ls -l /home", shell=True)

# 方式2:列表形式(推荐,更安全)

subprocess.Popen(["ls", "-l", "/home"])

# 方式3:带路径的程序

subprocess.Popen(["/usr/bin/python", "script.py"])

安全提醒:使用列表形式可以避免shell注入攻击!

4.2 标准流控制:进程的"输入输出管道"

# 三种重要的流控制

process = subprocess.Popen(

["python", "calculator.py"],

stdin=subprocess.PIPE, # 可以向进程发送数据

stdout=subprocess.PIPE, # 可以从进程读取输出

stderr=subprocess.PIPE, # 可以读取错误信息

text=True # 以文本模式而不是字节模式

)

4.3 进程环境配置:为子进程准备"工作间"

# 创建定制的工作环境

custom_env = {"PATH": "/usr/local/bin", "LANG": "en_US.UTF-8"}

process = subprocess.Popen(

["myapp"],

cwd="/tmp/workdir", # 设置工作目录

env=custom_env, # 自定义环境变量

shell=False, # 不使用shell解析

start_new_session=True # 创建新的进程组

)

5. 实例与应用场景:让理论在画面中落地

案例1:简单的命令执行 - 文件列表查看器

应用场景:我们需要在Python程序中获取当前目录的文件列表,就像在终端中执行ls -l一样。

#!/usr/bin/env python3

"""

* @brief 文件列表查看器

*

* 使用subprocess.Popen执行ls -l命令,捕获输出并解析显示。

* 演示了基本的子进程创建、输出捕获和结果处理。

*

* @in:

* - 无命令行参数

*

* @out:

* - 在控制台显示当前目录的详细文件列表

*

* 返回值说明:

* 程序返回0表示成功,非0表示出错

*/

import subprocess

import sys

def list_files_detailed():

"""

使用ls -l命令获取详细文件列表

"""

try:

# 创建子进程执行ls -l命令

process = subprocess.Popen(

["ls", "-l"], # 命令和参数列表

stdout=subprocess.PIPE, # 捕获标准输出

stderr=subprocess.PIPE, # 捕获错误输出

text=True # 以文本模式处理

)

# 等待进程完成并获取输出

stdout, stderr = process.communicate()

# 检查进程执行结果

if process.returncode != 0:

print(f"命令执行失败: {stderr}")

return 1

# 处理并显示结果

print("当前目录文件列表:")

print("=" * 50)

# 解析ls -l的输出

lines = stdout.strip().split('\n')

total_blocks = 0

file_count = 0

for i, line in enumerate(lines):

if i == 0 and line.startswith('total'):

# 第一行是总块数

total_blocks = line.split()[1]

print(f"总块数: {total_blocks}")

print("-" * 50)

continue

if line: # 跳过空行

file_count += 1

parts = line.split()

if len(parts) >= 9:

permissions = parts[0] # 文件权限

links = parts[1] # 链接数

owner = parts[2] # 所有者

group = parts[3] # 所属组

size = parts[4] # 文件大小

date = ' '.join(parts[5:7]) # 修改日期

name = ' '.join(parts[7:]) # 文件名

print(f"{permissions:10} {owner:8} {group:8} {size:8} {date:12} {name}")

print("-" * 50)

print(f"文件总数: {file_count}")

return 0

except Exception as e:

print(f"执行过程中出错: {e}")

return 1

if __name__ == "__main__":

exit_code = list_files_detailed()

sys.exit(exit_code)

程序流程图:

编译和运行:

# 直接运行Python脚本

python3 file_lister.py

# 或者给脚本添加执行权限

chmod +x file_lister.py

./file_lister.py

运行结果示例:

当前目录文件列表:

==================================================

总块数: 48

--------------------------------------------------

-rw-r--r-- user staff 1024 Jan 15 10:30 main.py

drwxr-xr-x user staff 2048 Jan 15 10:25 src

-rwxr-xr-x user staff 24576 Jan 15 10:20 executable

-rw-r--r-- user staff 512 Jan 15 10:15 config.json

--------------------------------------------------

文件总数: 4

案例2:进程间通信 - 实时日志监控系统

应用场景:我们需要监控一个正在运行的服务的日志输出,实时显示包含"ERROR"或"WARN"的关键日志行。

#!/usr/bin/env python3

"""

* @brief 实时日志监控系统

*

* 使用subprocess.Popen启动tail -f命令监控日志文件,

* 通过管道实时读取输出,过滤并高亮显示关键日志信息。

* 演示了实时进程输出处理和进程间通信。

*

* @in:

* - log_file: 要监控的日志文件路径

*

* @out:

* - 在控制台实时显示过滤后的日志信息

*

* 返回值说明:

* 程序通过Ctrl+C终止,正常退出返回0

*/

import subprocess

import sys

import signal

import threading

import time

class LogMonitor:

"""

实时日志监控器

"""

# 颜色代码用于高亮显示

COLORS = {

'ERROR': '\033[91m', # 红色

'WARN': '\033[93m', # 黄色

'INFO': '\033[92m', # 绿色

'RESET': '\033[0m' # 重置颜色

}

def __init__(self, log_file):

self.log_file = log_file

self.monitor_process = None

self.is_monitoring = False

self.filter_keywords = ['ERROR', 'WARN', 'INFO']

def colorize_log(self, line):

"""

根据日志级别给日志行添加颜色

"""

for level, color in self.COLORS.items():

if level in ['ERROR', 'WARN', 'INFO'] and level in line:

return f"{color}{line}{self.COLORS['RESET']}"

return line

def start_monitoring(self):

"""

启动日志监控

"""

try:

print(f"开始监控日志文件: {self.log_file}")

print("按 Ctrl+C 停止监控")

print("-" * 60)

# 启动tail -f进程

self.monitor_process = subprocess.Popen(

['tail', '-f', self.log_file],

stdout=subprocess.PIPE,

stderr=subprocess.PIPE,

text=True,

bufsize=1, # 行缓冲

universal_newlines=True

)

self.is_monitoring = True

# 启动输出读取线程

output_thread = threading.Thread(target=self._read_output)

output_thread.daemon = True

output_thread.start()

# 启动错误读取线程

error_thread = threading.Thread(target=self._read_errors)

error_thread.daemon = True

error_thread.start()

# 等待监控进程结束

while self.is_monitoring:

if self.monitor_process.poll() is not None:

break

time.sleep(0.1)

except KeyboardInterrupt:

print("\n\n监控被用户中断")

except Exception as e:

print(f"监控过程中出错: {e}")

finally:

self.stop_monitoring()

def _read_output(self):

"""

读取并处理标准输出

"""

while self.is_monitoring:

try:

line = self.monitor_process.stdout.readline()

if line:

# 过滤关键词

if any(keyword in line for keyword in self.filter_keywords):

colored_line = self.colorize_log(line.strip())

print(f"{time.strftime('%H:%M:%S')} | {colored_line}")

except Exception as e:

if self.is_monitoring: # 只在监控状态下报告错误

print(f"读取输出时出错: {e}")

break

def _read_errors(self):

"""

读取并处理错误输出

"""

while self.is_monitoring:

try:

line = self.monitor_process.stderr.readline()

if line:

print(f"错误: {line.strip()}")

except Exception as e:

if self.is_monitoring:

print(f"读取错误时出错: {e}")

break

def stop_monitoring(self):

"""

停止日志监控

"""

self.is_monitoring = False

if self.monitor_process and self.monitor_process.poll() is None:

self.monitor_process.terminate()

try:

self.monitor_process.wait(timeout=5)

except subprocess.TimeoutExpired:

self.monitor_process.kill()

print("日志监控已停止")

def signal_handler(signum, frame):

"""

信号处理函数

"""

print(f"\n接收到信号 {signum},准备退出...")

sys.exit(0)

def main():

if len(sys.argv) != 2:

print("用法: python log_monitor.py <日志文件路径>")

sys.exit(1)

log_file = sys.argv[1]

# 注册信号处理器

signal.signal(signal.SIGINT, signal_handler)

signal.signal(signal.SIGTERM, signal_handler)

# 创建并启动监控器

monitor = LogMonitor(log_file)

monitor.start_monitoring()

if __name__ == "__main__":

main()

时序图:

编译和运行:

# Makefile

.PHONY: all run clean test

all: log_monitor

log_monitor: log_monitor.py

chmod +x log_monitor.py

run: log_monitor

# 首先创建一个测试日志文件

echo "$(shell date) INFO Application started" > test.log

echo "$(shell date) WARN Low disk space" >> test.log

echo "$(shell date) ERROR Database connection failed" >> test.log

./log_monitor.py test.log

test: log_monitor

# 在后台启动日志生成器

python log_generator.py &

./log_monitor.py app.log

clean:

rm -f test.log app.log

# 运行方式

make run

# 或者直接运行

python log_monitor.py /var/log/syslog

运行结果示例:

开始监控日志文件: test.log

按 Ctrl+C 停止监控

------------------------------------------------------------

10:30:15 | INFO Application started

10:30:16 | WARN Low disk space

10:30:17 | ERROR Database connection failed

案例3:复杂管道操作 - 数据分析流水线

应用场景:我们需要处理一个大型CSV文件,进行数据提取、转换和统计分析,模拟真实的数据处理流水线。

#!/usr/bin/env python3

"""

* @brief 数据分析流水线

*

* 使用多个subprocess.Popen进程通过管道连接,

* 实现复杂的数据处理流水线:

* 1. 数据提取(grep)

* 2. 数据转换(awk)

* 3. 统计分析(sort | uniq -c | sort -nr)

*

* @in:

* - input_file: 输入数据文件

* - filter_pattern: 过滤模式

*

* @out:

* - 在控制台显示分析结果

*

* 返回值说明:

* 程序返回0表示成功,非0表示出错

*/

import subprocess

import sys

import tempfile

import os

class DataAnalysisPipeline:

"""

数据分析流水线处理器

"""

def __init__(self, input_file, filter_pattern):

self.input_file = input_file

self.filter_pattern = filter_pattern

self.temp_files = []

def create_sample_data(self):

"""

创建示例数据(如果输入文件不存在)

"""

sample_data = """timestamp,user_id,action,value

2024-01-15 10:00:01,user1,login,1

2024-01-15 10:00:02,user2,purchase,150

2024-01-15 10:00:03,user1,view_product,1

2024-01-15 10:00:04,user3,login,1

2024-01-15 10:00:05,user2,view_product,1

2024-01-15 10:00:06,user1,purchase,200

2024-01-15 10:00:07,user3,purchase,75

2024-01-15 10:00:08,user2,logout,1

2024-01-15 10:00:09,user4,login,1

2024-01-15 10:00:10,user1,view_product,1"""

with open(self.input_file, 'w') as f:

f.write(sample_data)

print(f"已创建示例数据文件: {self.input_file}")

def run_pipeline(self):

"""

执行数据处理流水线

"""

try:

# 检查输入文件

if not os.path.exists(self.input_file):

self.create_sample_data()

print("启动数据分析流水线...")

print("=" * 50)

# 第一阶段:数据提取 - 使用grep过滤数据

print("阶段1: 数据提取(过滤关键动作)...")

grep_process = subprocess.Popen(

['grep', self.filter_pattern, self.input_file],

stdout=subprocess.PIPE,

stderr=subprocess.PIPE,

text=True

)

# 第二阶段:数据转换 - 使用awk提取特定字段

print("阶段2: 数据转换(提取用户ID)...")

awk_process = subprocess.Popen(

['awk', '-F,', '{print $2}'], # 提取第二列(user_id)

stdin=grep_process.stdout,

stdout=subprocess.PIPE,

stderr=subprocess.PIPE,

text=True

)

# 关闭第一个进程的输出,避免管道阻塞

grep_process.stdout.close()

# 第三阶段:统计分析 - 排序和计数

print("阶段3: 统计分析(计算频率)...")

# 排序

sort1_process = subprocess.Popen(

['sort'],

stdin=awk_process.stdout,

stdout=subprocess.PIPE,

stderr=subprocess.PIPE,

text=True

)

awk_process.stdout.close()

# 计数

uniq_process = subprocess.Popen(

['uniq', '-c'],

stdin=sort1_process.stdout,

stdout=subprocess.PIPE,

stderr=subprocess.PIPE,

text=True

)

sort1_process.stdout.close()

# 按计数排序(降序)

sort2_process = subprocess.Popen(

['sort', '-nr'],

stdin=uniq_process.stdout,

stdout=subprocess.PIPE,

stderr=subprocess.PIPE,

text=True

)

uniq_process.stdout.close()

# 获取最终结果

final_output, final_error = sort2_process.communicate()

# 检查所有进程的状态

processes = [grep_process, awk_process, sort1_process, uniq_process, sort2_process]

for i, process in enumerate(processes):

if process.returncode != 0:

stderr = process.stderr.read() if process.stderr else "未知错误"

print(f"阶段 {i+1} 执行失败: {stderr}")

return 1

# 显示分析结果

self.display_results(final_output)

return 0

except Exception as e:

print(f"流水线执行过程中出错: {e}")

return 1

finally:

self.cleanup()

def display_results(self, analysis_output):

"""

显示分析结果

"""

print("\n数据分析结果:")

print("=" * 30)

print("频率 | 用户ID")

print("-" * 30)

lines = analysis_output.strip().split('\n')

total_actions = 0

for line in lines:

if line.strip():

parts = line.strip().split()

if len(parts) >= 2:

count = parts[0]

user_id = parts[1]

total_actions += int(count)

print(f"{count:>6} | {user_id}")

print("-" * 30)

print(f"总操作数: {total_actions}")

print(f"唯一用户数: {len(lines)}")

def cleanup(self):

"""

清理临时文件

"""

for temp_file in self.temp_files:

try:

if os.path.exists(temp_file):

os.unlink(temp_file)

except Exception as e:

print(f"清理文件 {temp_file} 时出错: {e}")

def main():

if len(sys.argv) != 3:

print("用法: python data_pipeline.py <输入文件> <过滤模式>")

print("示例: python data_pipeline.py data.csv purchase")

sys.exit(1)

input_file = sys.argv[1]

filter_pattern = sys.argv[2]

# 创建并运行流水线

pipeline = DataAnalysisPipeline(input_file, filter_pattern)

exit_code = pipeline.run_pipeline()

sys.exit(exit_code)

if __name__ == "__main__":

main()

数据处理流程图:

编译和运行:

# Makefile for data pipeline

.PHONY: all run clean

all: data_pipeline

data_pipeline: data_pipeline.py

chmod +x data_pipeline.py

run: data_pipeline

./data_pipeline.py sales.csv purchase

demo: data_pipeline

@echo "运行演示..."

./data_pipeline.py demo_data.csv login

@echo ""

./data_pipeline.py demo_data.csv purchase

@echo ""

./data_pipeline.py demo_data.csv view_product

clean:

rm -f demo_data.csv sales.csv

test:

python -c "import subprocess; print('submodule导入成功')"

# 运行方式

make demo

# 或者直接运行

python data_pipeline.py data.csv purchase

运行结果示例:

启动数据分析流水线...

==================================================

阶段1: 数据提取(过滤关键动作)...

阶段2: 数据转换(提取用户ID)...

阶段3: 统计分析(计算频率)...

数据分析结果:

==============================

频率 | 用户ID

------------------------------

2 | user1

2 | user2

1 | user3

------------------------------

总操作数: 5

唯一用户数: 3

6. 高级技巧与最佳实践

6.1 错误处理与超时控制

import subprocess

import signal

import time

def run_command_with_timeout(cmd, timeout=30):

"""

运行命令并设置超时限制

"""

try:

process = subprocess.Popen(

cmd,

stdout=subprocess.PIPE,

stderr=subprocess.PIPE,

text=True

)

try:

stdout, stderr = process.communicate(timeout=timeout)

return process.returncode, stdout, stderr

except subprocess.TimeoutExpired:

# 超时处理

process.kill()

stdout, stderr = process.communicate()

return -1, stdout, f"命令执行超时({timeout}秒)"

except Exception as e:

return -1, "", f"执行命令时出错: {e}"

6.2 实时输出处理

def run_command_realtime(cmd):

"""

实时处理命令输出

"""

process = subprocess.Popen(

cmd,

stdout=subprocess.PIPE,

stderr=subprocess.STDOUT, # 将stderr重定向到stdout

text=True,

bufsize=1,

universal_newlines=True

)

# 实时读取输出

while True:

output = process.stdout.readline()

if output == '' and process.poll() is not None:

break

if output:

print(output.strip())

return process.wait()

7. 总结:掌握进程管理的艺术

通过本文的深入探讨,我们可以看到subprocess.Popen就像是一位多才多艺的乐队指挥,能够优雅地协调各个"乐手"(子进程)完成复杂的任务。

核心要点回顾

为什么选择subprocess.Popen?

- 灵活性:提供对子进程的完全控制

- 安全性:避免shell注入攻击

- 效率:支持异步操作和实时处理

- 功能丰富:支持管道、信号处理、环境配置等

最后的小贴士

记住,强大的工具需要负责任地使用:

- 总是检查返回值和处理错误

- 及时清理子进程资源

- 避免创建僵尸进程

- 在长时间运行的程序中注意资源泄漏

现在,你已经掌握了Python中进程管理的艺术,去创造伟大的程序吧!就像一位熟练的指挥家,让各个进程在你的代码中和谐共舞。

8447

8447

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?