准备:

-

安装JDK1.8,并配置环境变量。

-

下载hadoop2.7.7,并配置环境变量。

链接: https://pan.baidu.com/s/1dCKDx5wcPOu13OxRBOajYg 提取码: rp65 -

下载hadooponwindows

地址:https://github.com/sardetushar/hadooponwindows -

把hadoop下的etc和bin替换为hadooponwindows下的etc和bin

-

下载hbase-1.3.3.并配置环境变量

链接: https://pan.baidu.com/s/1rkJxmA-T8z-58McN_layDA 提取码: 4g7z -

安装zookeeper https://my.oschina.net/demons99/blog/1928362?tdsourcetag=s_pcqq_aiomsg

修改配置文件

-

1.hadoop

-

etc/hadoop/core-site.xml

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

- etc/hadoop/mapred-site.xml

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

- etc/hadoop/hdfs-site.xml

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>/D:/Java/hadoop-2.7.7/data/namenode</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>/D:/Java/hadoop-2.7.7/data/datanode</value>

</property>

- etc\hadoop\yarn-site.xml

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.nodemanager.aux-services.mapreduce.shuffle.class</name>

<value>org.apache.hadoop.mapred.ShuffleHandler</value>

</property>

- etc/hadoop/hadoop-env.cmd

@rem set JAVA_HOME=%JAVA_HOME%

export JAVA_HOME=D:\Java\jdk1.8.0_172

执行命令

- 格式化namenode(bin目录下)

hdfs namenode -format

- 启动Hadoop(sbin目录下执行)

start-all.cmd

启动了4个窗口

namenode

datanode

yarn resourcemanager

yarn nodemanager.

- 停止Hadoop(sbin目录下执行)

stop-all

Hadoop都停止了。

-

2.Hbase

-

conf/hbase-env.cmd (第27行)

export JAVA_HOME=D:\Java\jdk1.8.0_172

- conf/hbase-site.xml

在hbase-1.3.3创建data文件夹,

在data文件夹下创建tmp和zoo文件夹

<property>

<name>hbase.master</name>

<value>localhost:6000</value>

</property>

<property>

<name>hbase.master.maxclockskew</name>

<value>180000</value>

</property>

<property>

<name>hbase.rootdir</name>

<value>file:///D:/Java/hbase-1.3.3/data</value>

</property>

<property>

<name>hbase.tmp.dir</name>

<value>D:/Java/hbase-1.3.3/data/tmp</value>

</property>

<property>

<name>hbase.zookeeper.quorum</name>

<value>127.0.0.1</value>

</property>

<property>

<name>hbase.zookeeper.property.dataDir</name>

<value>D:/Java/hbase-1.3.3/data/zoo</value>

</property>

<property>

<name>hbase.cluster.distributed</name>

<value>false</value>

</property>

启动

- 启动hadoop

bin>hdfs namenode -format

sbin>start-all.cmd

- 启动hbase

bin>start-hbase.cmd

-

用jps命令查看Hbase是否启动成功,如果启动成功的会看到”HMaster”的进程

-

通过shell操作hbase

-

如果是部署pinpoint要初始化数据(hbase-create.hbase)

链接: https://pan.baidu.com/s/1szqJUIh6dvf4OMaeqTBa8g 提取码: w7sj

./hbase shell "文件路径"/hbase-create.hbase

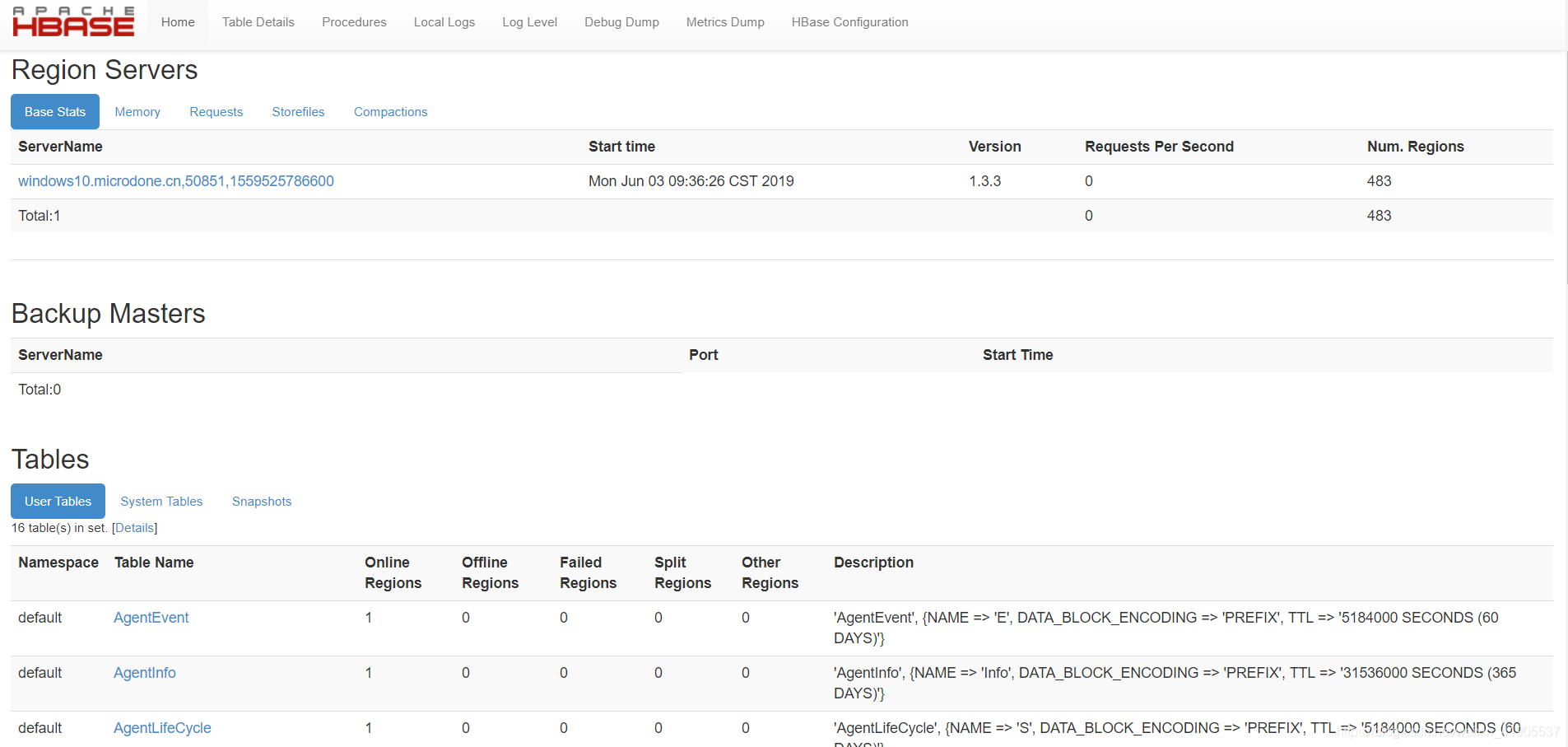

- 访问页面测试是否成功:http://localhost:16010/master-status ,如果成功在页面的tables标签下能看到导入的表。

本文详细介绍了如何在Windows环境下搭建Hadoop与HBase集群,包括JDK、Hadoop及HBase的安装配置,环境变量设置,以及关键配置文件的修改。提供了格式化namenode、启动和停止Hadoop与HBase的步骤,并指导如何通过shell操作HBase及测试页面确认搭建成功。

本文详细介绍了如何在Windows环境下搭建Hadoop与HBase集群,包括JDK、Hadoop及HBase的安装配置,环境变量设置,以及关键配置文件的修改。提供了格式化namenode、启动和停止Hadoop与HBase的步骤,并指导如何通过shell操作HBase及测试页面确认搭建成功。

7801

7801

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?