首先:

support vector classify(SVC)支持分类机做二分类的,找出分类面,解决分类问题

support vector regression(SCR)支持回归机做曲线拟合、函数回归 ,做预测,温度,天气,股票

这些都会用于数据挖掘、文本分类、语音识别、生物信息,具体问题具体分析

其中:

C-Support Vector Classication和v-Support Vector Classication区别:

C-SVC:参数C[0,无穷大]

v-SVC:使用参数v[0,1]用来控制支持向量的数量和训练错误。

One-class SVM是用来估计数据的分布的(Distribution Estimation)

e-Support Vector Regression。

v-Support Vector Regression增加了控制支持向量参数的参数

每个对应不同的Formulations

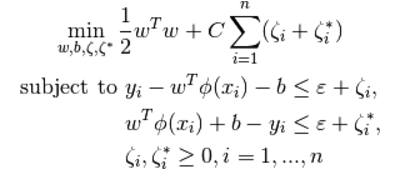

从目标函数和约束条件上的区别:

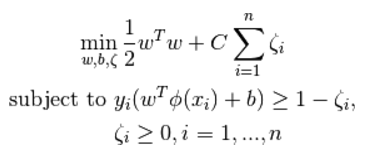

SVC:

SVR:

约束中松弛变量 与惩罚项的关系。

与惩罚项的关系。

最后总结:

分类是找一个平面,边界上点到平面的距离最远,回归是让每个点到回归线的距离最小。SVM 回归机引入一个 ε-不敏感损失函数作 为损失函数

本文主要介绍了SVC和SVR。SVC是支持分类机,用于二分类,找出分类面;SVR是支持回归机,用于曲线拟合和预测。还提及了C-SVC、v-SVC等不同类型的区别,以及SVC和SVR在目标函数、约束条件上的差异。最后总结了分类和回归的特点,SVM回归机引入了ε - 不敏感损失函数。

本文主要介绍了SVC和SVR。SVC是支持分类机,用于二分类,找出分类面;SVR是支持回归机,用于曲线拟合和预测。还提及了C-SVC、v-SVC等不同类型的区别,以及SVC和SVR在目标函数、约束条件上的差异。最后总结了分类和回归的特点,SVM回归机引入了ε - 不敏感损失函数。

1023

1023

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?