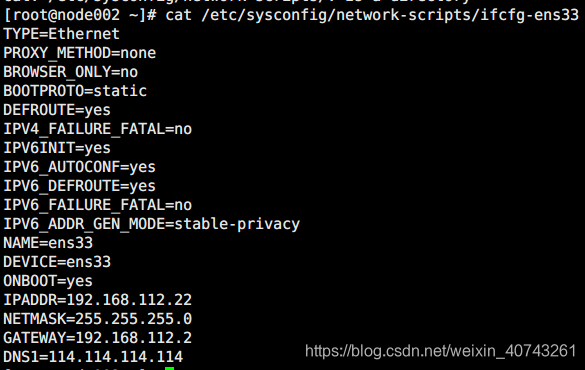

首先设置节点IP和网关:

配置文件:/etc/sysconfig/network-scripts/ifcfg-ens33

修改本机名:

配置文件:/etc/hostname

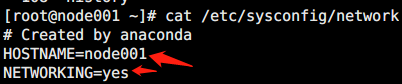

修改网络名:

配置文件:/etc/sysconfig/network

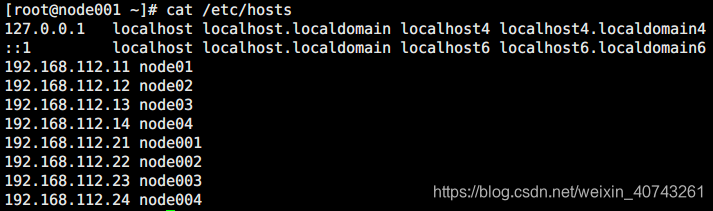

修改hosts文件:

配置文件:/etc/hosts

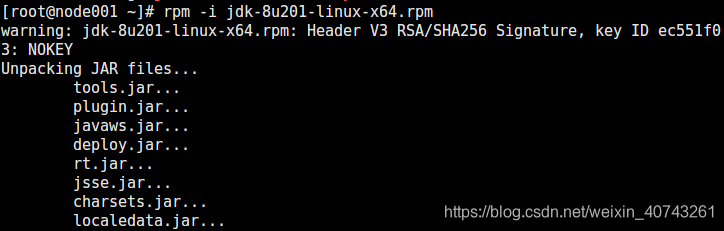

安装jdk:

rpm -i jdk-8u201-linux-x64.rpm

添加环境变量:

vi /etc/profile

# 添加如下命令

export JAVA_HOME=/usr/java/jdk1.8.0_201-amd64

export PATH=$PATH:$JAVA_HOME/bin

#保存退出

#使环境变量起作用

source /etc/profile

安装配置Hadoop:

安装

#解压Hadoop包

tar -xzvf hadoop-2.6.5.tar.gz

#移动到软件目录

mkdir /opt/sxt && mv hadoop-2.6.5 /opt/sxt

#添加环境变量

vi /etc/profile

内容如下:

export JAVA_HOME=/usr/java/jdk1.8.0_201-amd64

export HADOOP_HOME=/opt/sxt/hadoop-2.6.5

export PATH=$PATH:$JAVA_HOME/bin:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

#保存退出

#使环境变量起作用

source /etc/profile

配置

#进入配置目录

cd /opt/sxt/hadoop-2.6.5/etc/hadoop

#修改 hadoop-env.sh mapred-env.sh yarn-env.sh 中的JAVA_HOME为绝对路径

export JAVA_HOME=/usr/java/jdk1.8.0_201-amd64

#以下为官网指定配置,指定namenode在哪个节点以什么端口号启动。

#添加配置

#默认文件系统入口

#注意把localhost换成主机名

vi core-site.xml:

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>

#副本数设置为1,默认为3

vi hdfs-site.xml:

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

</configuration>

#设置DataNode

vi slaves

这里先写入node01

#在core-site.xml中更改文件路径,默认在tmp下不安全

<property>

<name>hadoop.tmp.dir</name>

<value>/var/sxt/hadoop/local</value>

</property>

#修改hdfs-site.xml,指定secondary启动路径:

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>node01:50090</value>

</property>

本文详细介绍如何在Linux环境下安装和配置Hadoop集群,包括设置节点IP、网关、主机名等基本网络配置,以及安装Java环境并配置Hadoop各组件。

本文详细介绍如何在Linux环境下安装和配置Hadoop集群,包括设置节点IP、网关、主机名等基本网络配置,以及安装Java环境并配置Hadoop各组件。

1507

1507

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?