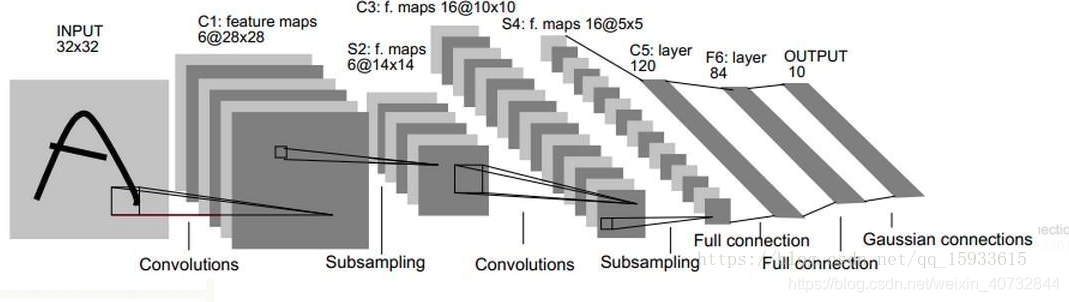

LeNet-5

CNN分类网络开端,用于手写字符识别识别率相当高。

创建卷积框,设置大小、步长、数量等,对图像进行卷积操作,提取特征的操作,池化降维,全连接分类输出。之后的分类网络都是基于此框架进行的优化。

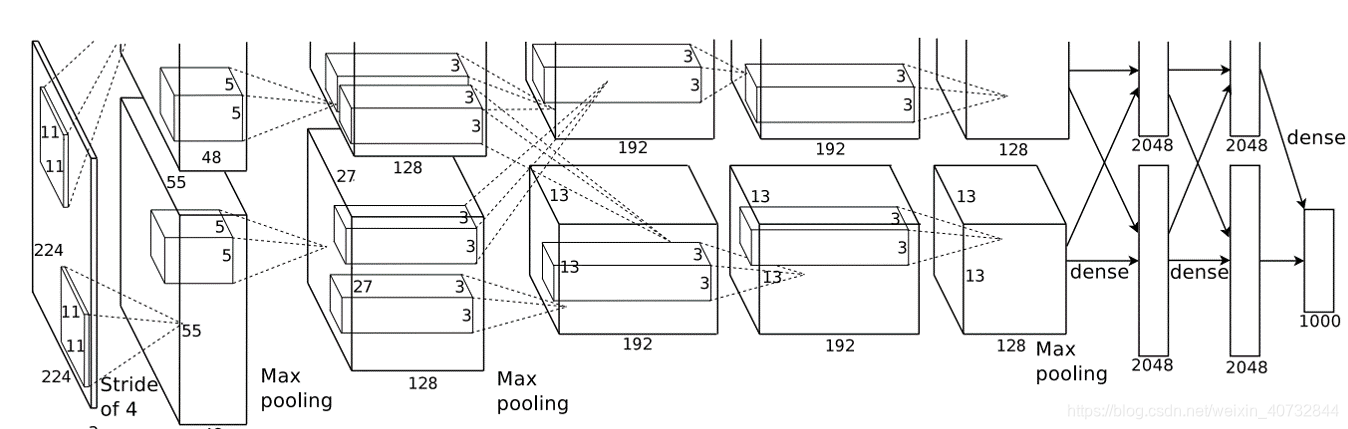

AlexNet

作为2012年ImageNet分类冠军,把LeNet发扬光大,运用了Relu,Dropout,LRN等trick,并且使用GPU加速。

使用Relu 对梯度衰减进行加速,并且一定程度的避免过拟合,f=max(0,x)

Dropout采用部分神经元进行训练,对过拟合有奇效。

在第2,4,5层均是前一层自己GPU内连接,第3层是与前面两层全连接,全连接是2个GPU全连接

LRN局部响应归一化

采用数据增强,随机地从256256的原始图像中截取224224大小的区域(以及水平翻转的镜像),相当于增加了2*(256-224)^2=2048倍的数据量。如果没有数据增强,仅靠原始的数据量,参数众多的CNN会陷入过拟合中,使用了数据增强后可以大大减轻过拟合,提升泛化能力。进行预测时,则是取图片的四个角加中间共5个位置,并进行左右翻转,一共获得10张图片,对他们进行预测并对10次结果求均值。同时,AlexNet论文中提到了会对图像的RGB数据进行PCA处理,并对主成分做一个标准差为0.1的高斯扰动,增加一些噪声,这个Trick可以让错误率再下降1%

ZFNet

AlexNet的改进,改动不大,主要是引入了可视化,使用了解卷积和反池化(无法实现,只能近似)的近似对每一层进行可视化,并采用一个GPU进行训练

本文介绍了卷积神经网络(CNN)的经典模型,包括LeNet-5的特征提取原理,AlexNet的优化技巧如ReLU、Dropout和LRN,以及ZFNet对AlexNet的改进,特别是引入了可视化技术。这些网络在图像分类任务中起到了里程碑式的作用。

本文介绍了卷积神经网络(CNN)的经典模型,包括LeNet-5的特征提取原理,AlexNet的优化技巧如ReLU、Dropout和LRN,以及ZFNet对AlexNet的改进,特别是引入了可视化技术。这些网络在图像分类任务中起到了里程碑式的作用。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

399

399

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?