Exception in thread “main” java.lang.NoSuchMethodError: scala.Predef$

(我这里是idea + spark + Scala)

这个错误是由于spark中的Scala 和 系统中的Scala 版本不一致导致的错误,需要引用到spark对应的Scala版本,之前我也根据网上的信息进行修改,怎么也没有发现他们说的方式。

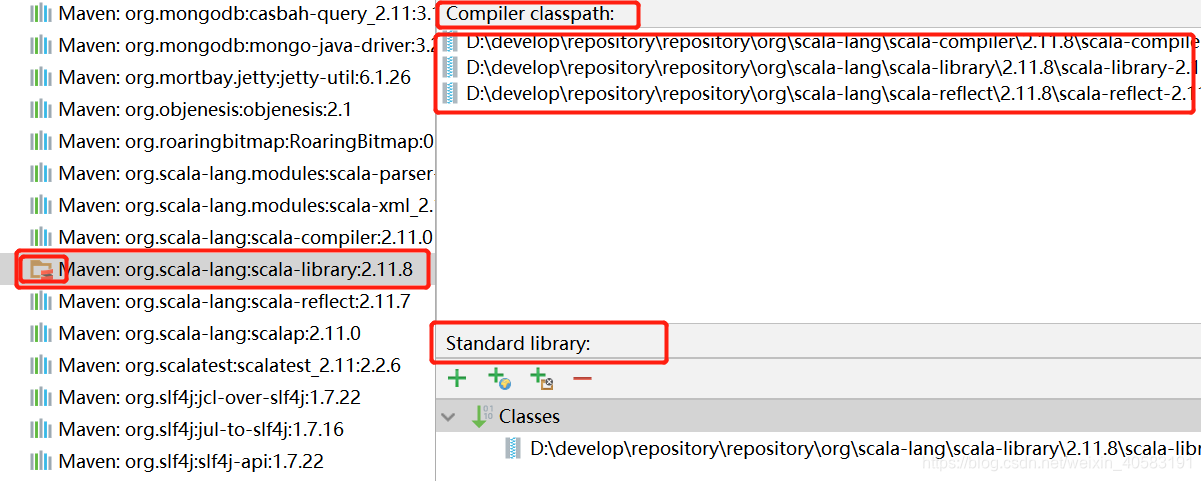

正确的样式如下图:(project setting --》libraries --》选你使用的某块)

这样表示你引用的是spark依赖中的Scala版本。我是通过修改pom文件中的

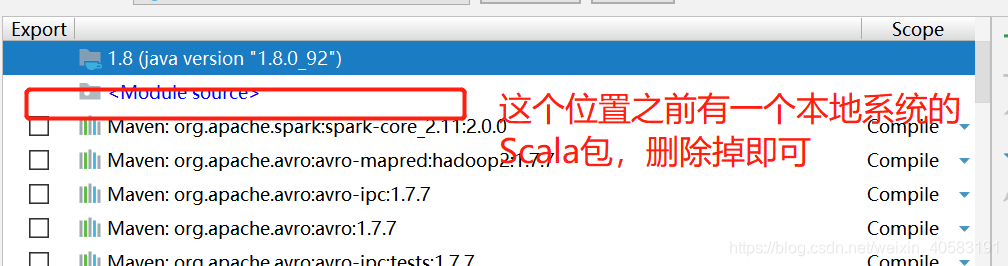

里面的编辑插件;然后将要操作的模块中的原来的Scala包删除如图:

经过以上操作我的这个问题解决了!!!

本文解决了一个常见的IDEA+Spark+Scala环境下,因Scala版本不一致引发的NoSuchMethodError错误。通过调整POM文件中Scala版本,确保与Spark依赖的Scala版本一致,最终解决了问题。

本文解决了一个常见的IDEA+Spark+Scala环境下,因Scala版本不一致引发的NoSuchMethodError错误。通过调整POM文件中Scala版本,确保与Spark依赖的Scala版本一致,最终解决了问题。

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?