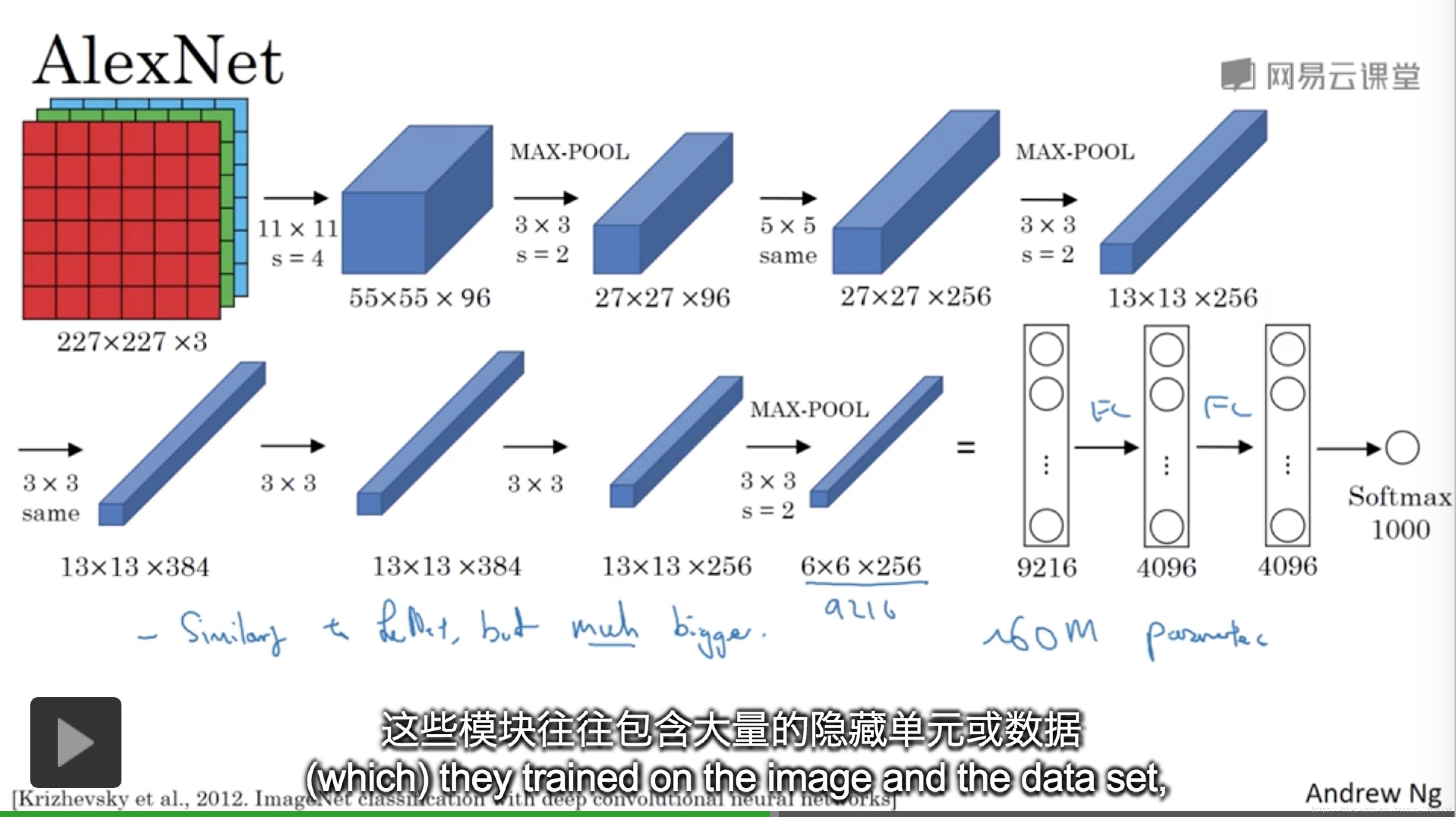

AlexNet:

AlexNet能够处理非常相似的基本结构模块。AlexNet比上述leNET表现更优秀的原因:它使用了relu函数。

AlexNet 的很多层被分到不同的GPU上。

经典的AlexNet还有另外一个类型的层叫做“局部响应归一化层”,基本思路:假如网络的一块(13*13*256),LRN要做的是选取一个位置,从这个位置穿过整个信道,得到256个数字,并进行归一化。进行局部响应归一化层的动机是对于13*13的图像的每个位置,我们可能并不需要太多的高激活神经元。但是后来研究发现起不了多大作用。AlexNet包含6000万的参数。

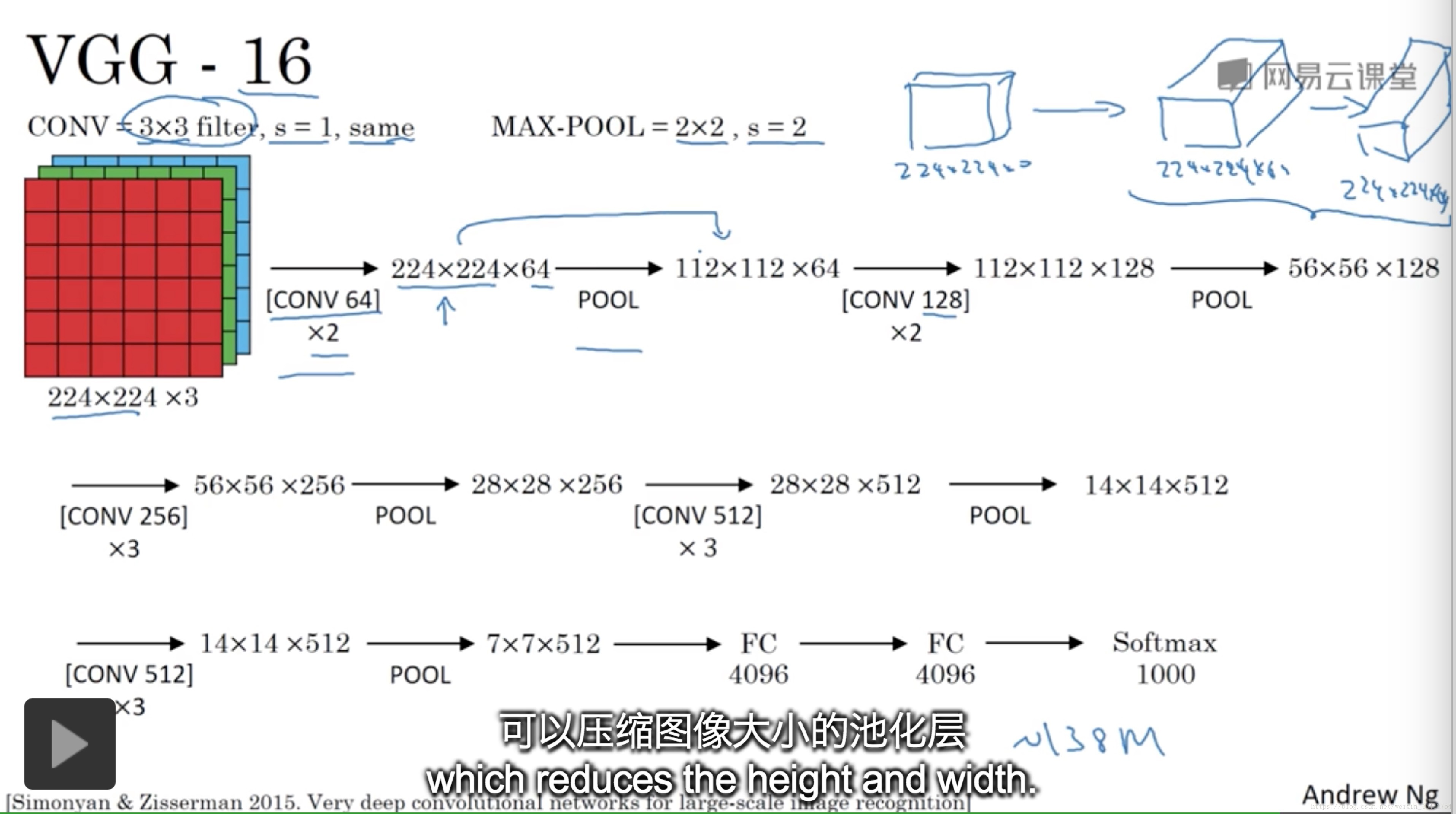

VGG:

这是一种只需要专注于构建卷积层的简单网络。16的意思是包括16个卷积层和全连接层。

池化层缩小图像的高度和宽度与此同时,卷积层的过滤数量变化存在一定的规律,每一步都翻倍。或者说每一组卷积层进行过滤翻倍。正是设计这种网络结构的简单原则。这种相对一致的网络结构对研究者很有吸引力。它的主要缺点是需要训练的特征数量特别大。

VGG-16包含16个卷积层和一个全连接层。在每一组的卷积层进行过滤器翻倍工作正是设计网络结构的另一个简单的原则,缺点是训练的特征数量非常巨大的。

文中揭示了随着网络的加深,图像的高度和宽度在以一定规律不断的缩小,每次池化后缩小一半。信道数不断增加,而且刚好也是每组卷积操作后增加一倍。也就是说图像缩小的比例和信道数增加的比例是有规律的。

本文探讨了深度学习中两个经典卷积神经网络模型——AlexNet和VGG的架构特点。AlexNet通过ReLU激活函数和多GPU并行计算提高了模型性能;而VGG则以其简单的卷积层堆叠结构和规律性的通道数翻倍设计著称。

本文探讨了深度学习中两个经典卷积神经网络模型——AlexNet和VGG的架构特点。AlexNet通过ReLU激活函数和多GPU并行计算提高了模型性能;而VGG则以其简单的卷积层堆叠结构和规律性的通道数翻倍设计著称。

5339

5339

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?