输入 x和y有很多情况,输入Tx输出Ty的数量不一定相等。

大致有多对多、多对一、一对一、一对多等情况。

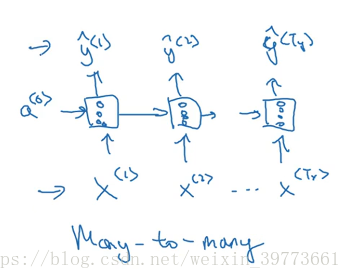

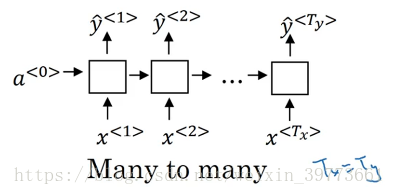

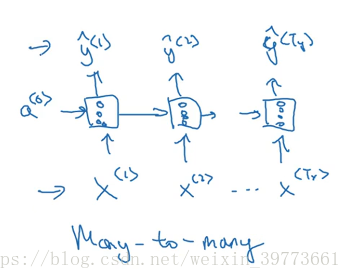

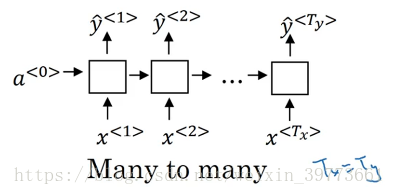

多对多序列:

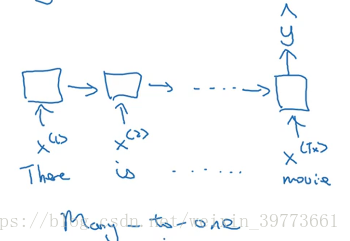

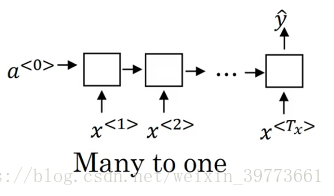

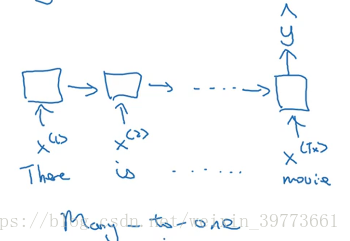

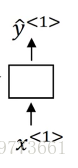

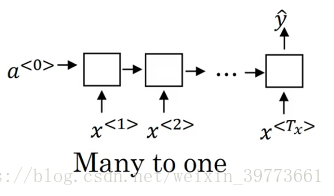

多对一序列:

情感分类时,输入可能是一个句子,输出是1-5的数字代表不同的情感或者星星数。

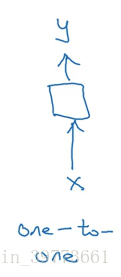

一对一结构(少见小型标准网络):

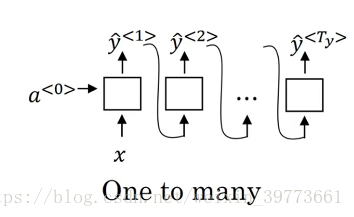

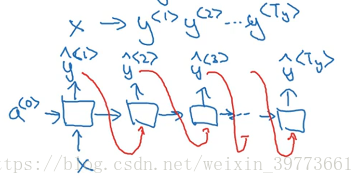

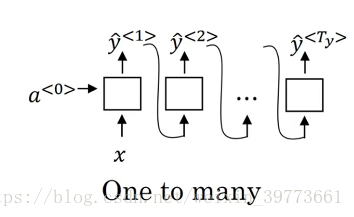

一对多:(音乐生成,输入一个数字生成一段音乐)

这里每个输出y当作下一段预测的输入

这里每个输出y当作下一段预测的输入

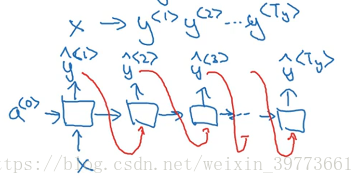

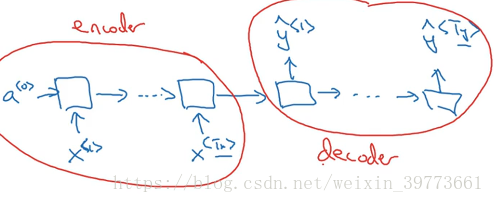

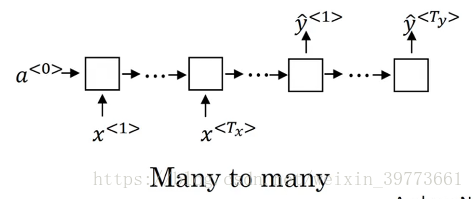

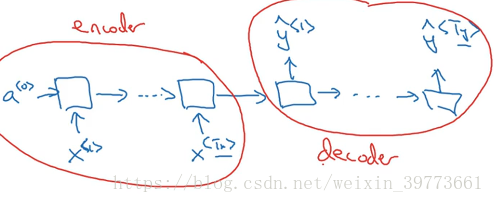

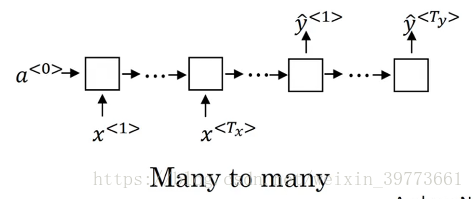

多对多序列例子:机器翻译

把法语翻译成英语:多对多结构,输入输出长度不等

左边是输入部分,编码器,右边是输出部分,解码器。

不同结构RNN标准网络图形:

输入 x和y有很多情况,输入Tx输出Ty的数量不一定相等。

大致有多对多、多对一、一对一、一对多等情况。

多对多序列:

多对一序列:

情感分类时,输入可能是一个句子,输出是1-5的数字代表不同的情感或者星星数。

一对一结构(少见小型标准网络):

一对多:(音乐生成,输入一个数字生成一段音乐)

这里每个输出y当作下一段预测的输入

这里每个输出y当作下一段预测的输入

把法语翻译成英语:多对多结构,输入输出长度不等

左边是输入部分,编码器,右边是输出部分,解码器。

不同结构RNN标准网络图形:

1159

1159

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?