使用SSD

增强Ceph性能并对比测试几年前,用Proxmox Virtual Environment(一个VMWare Vsphere的开源替代,以后简称PVE)搭建了一个测试云平台,使用了PVE自带的分布式存储Ceph。加上PVE自带的KVM虚拟机和LXC容器,再配置了虚拟交换机Open vSwitch,勉强算是一个所谓的超融合构架。当时没有考虑存储性能的问题,只是用一个万兆交换机把几个节点的几十块磁盘链接起来,后来在使用中感觉读取速度还行,写入确实太慢了。翻了些关于ceph的优化的文章,最好的办法是使用固态硬盘作为日志和缓存。这次给每台主机增加了一块400G的固态硬盘,对比测试发现ceph的读写性能明显提升。测试不是很专业的评测,但对一般中小型企业,足够参考了。测试 下面是比较测试结果,操作系统分别为windows 2003SP1 / win7SP1 / RedHat Enterprise Linux Enterprise Server release 5.11 (Carthage)

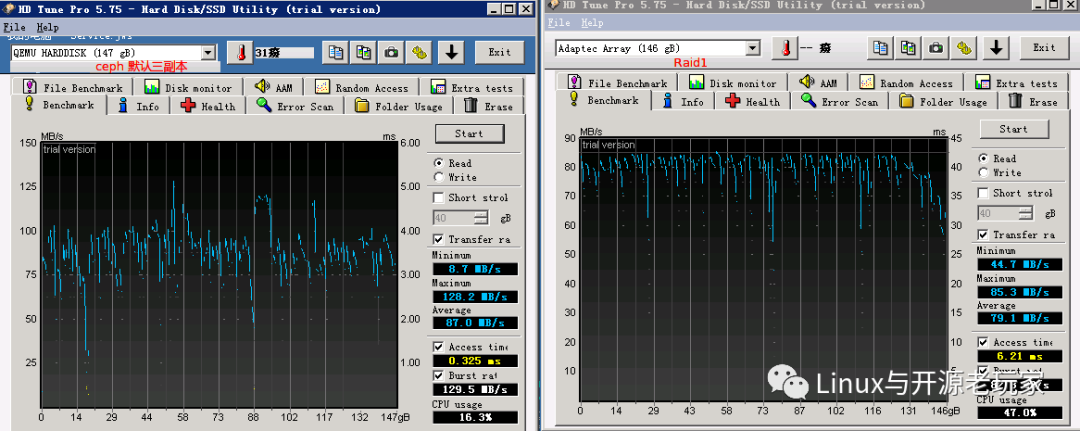

1. 基于windows 2003sp1的HD tune和CrystalDiskMark比较测试

Windows2003sp1测试使用一个是物理机上一个虚拟机,后者是把前者迁移到虚拟化平台上,存储分别是Adaptec Raid1和ceph

Windows2003sp1上该HD tune只能测试读性能,而CrystalDiskMark在物理机上测试写性能到”RAND4K Q32T16”的时候出现内存报错,所以结果不完整

HD tune测试读性能的结果

测试项目 |

最小(MB/s) |

最大(MB/s) |

平均(MB/s) |

ceph |

8.7 |

128.2 |

本文通过Windows 2003sp1上的HD tune和CrystalDiskMark,Windows7上的HD tune以及RHEL5的DD命令对比测试,展示了SSD在Ceph等存储系统中的性能提升。测试结果显示,不同工具和方法得到的性能数据有差异,但SSD作为缓存对提升存储性能效果显著。建议性能不佳的分布式存储系统考虑采用SSD缓存。

本文通过Windows 2003sp1上的HD tune和CrystalDiskMark,Windows7上的HD tune以及RHEL5的DD命令对比测试,展示了SSD在Ceph等存储系统中的性能提升。测试结果显示,不同工具和方法得到的性能数据有差异,但SSD作为缓存对提升存储性能效果显著。建议性能不佳的分布式存储系统考虑采用SSD缓存。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

3191

3191

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?