简介:该项目是一个基于计算机视觉和深度学习的OpenCV应用,目标是在Linux环境下通过OpenCV库实现高精度的手部姿态识别。开发者将通过配置编译环境安装OpenCV库,在Clion IDE中进行开发。项目可能包含训练模型、示例图像和测试数据。实现识别需要准备训练数据集,使用预训练的深度学习模型进行迁移学习或从头训练,并在OpenCV环境中部署模型。识别精度可以通过多种技术进行优化,如数据增强和轻量级模型应用。该项目还涉及实时视频流或单张图像上的关键点检测和手势计算,是全面学习计算机视觉、深度学习和C++编程的好机会。

1. 手部姿态识别项目介绍

1.1 项目背景与意义

在人机交互领域中,手部姿态识别技术作为新兴的计算机视觉应用,正逐步改变我们的生活。它能够使计算机理解并响应人类手势,为无接触操作提供可能。该技术不仅提升了用户体验,还在医疗、游戏、虚拟现实(VR)等领域展示了广泛的应用前景。

1.2 技术挑战与解决方案

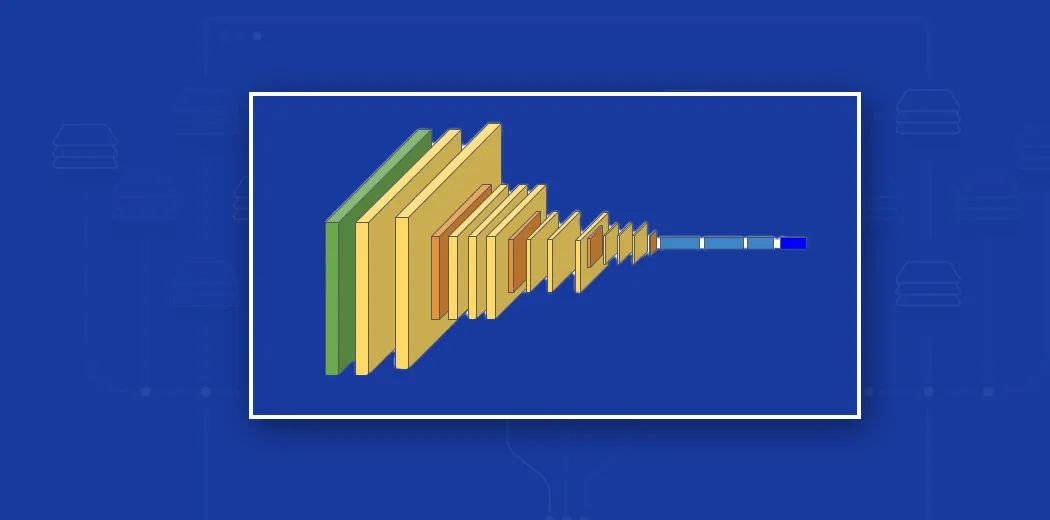

手部姿态识别面临的主要挑战包括复杂背景下的手势分割、光照变化的适应性、计算资源的限制以及实时性的需求。项目将采用先进的深度学习技术和优化算法来解决这些挑战。例如,应用卷积神经网络(CNN)进行高效的手势特征提取,并使用实时跟踪算法来提高识别的准确性。

1.3 项目目标与预期成果

本项目旨在构建一个准确、高效、鲁棒的手部姿态识别系统。通过优化训练模型和部署流程,我们预期能够实现低延迟的手势识别,使其在多种应用场景中均可稳定运行。此外,项目将探索轻量级模型设计,以满足不同平台(如移动设备)的性能需求。

2. Linux环境下OpenCV开发环境搭建

Linux是开发和部署各种计算机视觉和深度学习应用的流行选择,特别是在服务器和嵌入式设备上。OpenCV是一个强大的开源计算机视觉和机器学习软件库,支持广泛的视觉应用。在本章节中,我们将详细介绍如何在Linux环境下搭建OpenCV开发环境。

2.1 开发环境需求分析

2.1.1 硬件配置要求

在Linux环境下进行OpenCV开发,硬件配置取决于预期的工作负载。一般来说,以下是推荐的硬件配置:

- 处理器:至少为双核处理器,建议使用四核或以上,以支持复杂的图像处理任务。

- 内存:至少需要4GB RAM,推荐使用8GB或更高,以提供足够的内存用于算法计算。

- 存储:至少需要10GB的硬盘空间,推荐使用固态硬盘(SSD),以提高数据读写速度。

2.1.2 软件依赖和安装流程

在安装OpenCV之前,确保您的系统已安装以下软件依赖:

- CMake :构建OpenCV所需的构建系统。

- GCC/G++ :用于编译C++代码。

- Python :用于编写跨平台的脚本和应用。

- Git :用于版本控制和代码下载。

接下来是安装流程:

- 打开终端,更新系统包列表:

bash sudo apt-get update

- 安装OpenCV依赖包:

bash sudo apt-get install build-essential cmake git libgtk2.0-dev pkg-config libavcodec-dev libavformat-dev libswscale-dev

- 安装Python依赖:

bash sudo apt-get install python-dev python-numpy libtbb2 libtbb-dev

- 安装Python3版本的依赖(如果需要):

bash sudo apt-get install python3-dev python3-numpy libtbb2 libtbb-dev

2.2 OpenCV环境配置

2.2.1 OpenCV库的安装与配置

OpenCV可以使用源码编译安装,也可以通过包管理器安装预编译包。在这里,我们将通过源码编译安装OpenCV,以确保获得最新版本和功能。

- 下载OpenCV源码。可以使用

wget命令下载:

bash wget -O opencv.zip https://github.com/opencv/opencv/archive/refs/tags/4.5.5.zip unzip opencv.zip

- 创建构建目录并进入:

bash mkdir opencv_build cd opencv_build

- 配置CMake构建环境:

bash cmake -D CMAKE_BUILD_TYPE=RELEASE \ -D CMAKE_INSTALL_PREFIX=/usr/local \ -D BUILD_EXAMPLES=ON \ -D OPENCV_EXTRA_MODULES_PATH=~/opencv_contrib/modules ..

这里 OPENCV_EXTRA_MODULES_PATH 指向opencv_contrib仓库,包含了额外的非官方模块。

- 编译和安装:

bash make -j$(nproc) sudo make install

使用 -j$(nproc) 参数可以加速编译过程。

2.2.2 验证OpenCV环境

安装完成后,可以通过编译一个简单的OpenCV程序来验证环境是否配置成功:

- 创建一个测试文件

test.cpp,包含以下代码:

```cpp

#include

#include

int main() {

std::cout << “OpenCV Version: ” << CV_VERSION << std::endl;

return 0;

}

```

- 编译测试程序:

bash g++ `pkg-config --cflags --libs opencv4` test.cpp -o opencv_test

注意:根据安装的OpenCV版本, opencv4 可能需要替换为 opencv 。

- 运行测试程序:

bash ./opencv_test

如果没有错误,并且控制台输出了OpenCV版本信息,则表示安装成功。

通过以上步骤,您将在Linux环境下成功搭建了OpenCV开发环境。接下来,您可以开始进行计算机视觉项目的开发,例如手部姿态识别。

3. 训练数据集准备和模型训练

3.1 数据集的收集与处理

3.1.1 数据集来源和采集方法

在手部姿态识别项目中,高质量的数据集是模型训练的基础。数据集的来源可以通过多种方式,包括公开的数据集、自制数据集或者通过网络爬虫收集图片等。对于手部姿态识别,公开数据集如NYU Hand Pose Dataset、First-Person Hand Action Benchmark等已经提供大量的标注数据,这些数据集经过预处理,可以直接用于模型训练。

自制数据集则需要我们自己收集图片或视频,然后通过标注软件(如LabelImg、MakeSense.ai等)进行关键点的标注。此外,网络爬虫可以从互联网上抓取包含手部图像的图片或视频,但这通常需要较高的预处理工作量,包括去噪、裁剪等步骤。

无论数据集来源如何,确保数据的多样性和代表性是关键。这不仅指不同的手部形态、肤色、光照条件等,还指不同的人使用手势时的空间位置和角度。可以通过数据增强技术(如旋转、缩放、裁剪等)来扩展数据集的多样性,提高模型的泛化能力。

3.1.2 数据预处理和增强

数据预处理的目的是确保输入模型的图像数据具有一致的格式、尺寸和质量。常见的预处理步骤包括:

- 格式转换 :将图像转换为模型训练所支持的格式,如将JPEG转换为PNG。

- 尺寸统一 :调整图像大小以适应模型输入,通常会调整到模型训练时定义的固定尺寸,比如224x224像素。

- 归一化 :将图像像素值归一化到[0,1]范围或进行标准化,以帮助模型更快收敛。

- 数据增强 :为了防止模型过拟合,可以通过随机旋转、裁剪、颜色变换等手段人为增加数据的多样性。

数据增强可以通过多种方法实现,一种常见的方法是使用OpenCV库中的数据增强函数,如 cv2.flip 实现图像的水平翻转, cv2.rotate 实现旋转等。也可以使用更高级的图像处理库,如Python的PIL或Pillow库,来实现更复杂的数据增强功能。

下面的Python代码块演示了如何使用OpenCV进行简单的图像预处理和增强操作。

import cv2

import numpy as np

# 图像读取

image = cv2.imread('hand_image.jpg')

image = cv2.cvtColor(image, cv2.COLOR_BGR2RGB)

# 图像尺寸调整

resized_image = cv2.resize(image, (224, 224))

# 颜色归一化

normalized_image = resized_image / 255.0

# 数据增强:随机水平翻转

flip_code = 1 if np.random.rand() > 0.5 else 0

flipped_image = cv2.flip(normalized_image, flip_code)

# 保存增强后的图像

cv2.imwrite('flipped_image.jpg', cv2.cvtColor((flipped_image * 255.0).astype('uint8'), cv2.COLOR_RGB2BGR))

预处理和增强是循环迭代的过程,通过不断调整和验证模型性能来找到最合适的参数和方法。

3.2 深度学习模型的选择与训练

3.2.1 模型架构简介

深度学习在手部姿态识别领域已经展现出强大的能力,多种深度学习架构已被应用,包括卷积神经网络(CNN),递归神经网络(RNN)和生成对抗网络(GAN)等。尤其以CNN中的Hourglass网络和Deep High-Resolution Network(HRNet)在姿态估计任务中表现突出。

Hourglass网络因其能够通过多次下采样和上采样进行多尺度特征学习,适合解决姿态估计中常见的尺度变化问题。HRNet则采用并行多尺度表示,并在整个过程中保持高分辨率,这使得模型能够捕捉更细致的手部关键点信息。

选择模型架构时需要考虑到手部姿态识别的精度、速度、实时性等因素。对于实际应用,实时性和速度可能比最高精度更为重要。模型选择不当,不仅影响识别性能,还会导致资源浪费。

3.2.2 训练过程的监控和调试

在模型训练过程中,监控训练的进度和性能至关重要。这通常涉及到损失函数的监控和验证集上指标的评估。在手部姿态识别中,常用的损失函数包括均方误差(MSE)和平均精度(mAP)。

使用TensorBoard进行可视化是常见的监控手段。TensorBoard是TensorFlow提供的可视化工具,能够实时展示损失函数、准确率、接收者操作特征曲线(ROC)等图表,帮助我们更好地理解训练进度。

调试过程中,我们可能会遇到过拟合、欠拟合、梯度消失或梯度爆炸等问题。针对这些问题,我们可以使用各种正则化技术、调整学习率、增加批量大小、使用早停等策略。

以下是一个使用TensorFlow训练手部姿态识别模型的代码示例,展示了如何定义模型架构、编译模型,并使用回调函数监控训练过程。

import tensorflow as tf

from tensorflow.keras.callbacks import TensorBoard

from models import HandPoseEstimator

# 实例化模型

model = HandPoseEstimator()

# 编译模型

model.compile(optimizer='adam', loss='mse', metrics=['acc'])

# 定义TensorBoard回调

tensorboard = TensorBoard(log_dir='./logs')

# 训练模型

history = model.fit(

x_train, y_train,

validation_data=(x_val, y_val),

epochs=50,

callbacks=[tensorboard]

)

# 模型评估

model.evaluate(x_test, y_test)

在实际开发中,我们还需要设置适当的保存点(checkpoint)来保存训练过程中的最佳模型,确保不会因为程序中断而丢失训练成果。监控和调试是确保模型质量的关键环节。

3.3 模型评估与参数优化

在深度学习模型的训练过程中,评估模型的性能是至关重要的。这可以通过各种评估指标来完成,如准确率(Accuracy)、精确度(Precision)、召回率(Recall)和F1分数等。对于手部姿态识别,我们通常使用平均精度均值(mAP)或平均交并比(mIoU)来评估模型的性能。

评估完成后,我们会根据评估结果调整模型的参数,以期望得到更好的结果。这个过程称为参数优化。优化可以是手动的,也可以使用自动化工具如Hyperopt、Optuna等。

手动优化通常涉及到以下步骤:

- 更改学习率 :调整模型的学习率,寻找最适合模型训练的学习率。

- 调整批量大小 :批量大小影响模型训练的速度和稳定性,需要找到一个平衡点。

- 调整优化器 :不同的优化器可能会对模型训练产生不同的影响,如Adam、SGD等。

- 剪枝和正则化 :对于过拟合的情况,可以考虑剪枝或者添加正则化项。

在Python的Keras框架中,我们可以使用回调函数(Callback)在训练过程中动态调整超参数。例如,使用 LearningRateScheduler 调整学习率:

from tensorflow.keras.callbacks import LearningRateScheduler

# 学习率调度器

def scheduler(epoch, lr):

if epoch < 10:

return lr

else:

return lr * tf.math.exp(-0.1)

# 实例化学习率调度器回调

lr_scheduler = LearningRateScheduler(scheduler)

# 训练模型时应用学习率调度器

history = model.fit(

x_train, y_train,

validation_data=(x_val, y_val),

epochs=50,

callbacks=[tensorboard, lr_scheduler]

)

自动化优化工具则通过构建搜索空间,使用贝叶斯优化等算法来自动寻找最优的超参数组合。虽然这些方法可能会消耗较多的计算资源,但它们能帮助我们发现更优的模型参数,特别是在超参数空间非常大的情况下。

通过上述过程不断迭代,我们最终可以得到一个性能优异的手部姿态识别模型。在这个过程中,我们不仅提升了模型的性能,也对深度学习模型的调优有了更深入的理解。

4. 预训练深度学习模型应用

深度学习模型的高效应用是当前技术发展中的重要一环。预训练模型因其在特定任务上已经训练好的权重,可用来提升新任务的开发速度和性能。在本章节中,我们将详细介绍预训练模型的导入与使用,以及如何在不同场景下应用这些模型。

4.1 预训练模型的导入与使用

预训练模型的选择和使用是深度学习应用中的关键步骤,通过利用这些预训练的模型,我们可以更快地适应新任务,并在缺乏大量标注数据的情况下,依然能获得相对较好的性能。

4.1.1 预训练模型的选择与下载

在选择预训练模型时,首先需要考虑的是模型的来源。目前有多种深度学习平台提供预训练模型,例如TensorFlow的Model Zoo、PyTorch的Model Hub以及Keras Applications等。此外,一些研究机构和公司也会公开自己的预训练模型。

选择合适的模型是基于应用场景和任务需求。例如,如果我们面对的是手部姿态识别的任务,我们可能会选择在大型数据集ImageNet上预训练过的模型,如ResNet、Inception或MobileNet等,因为这些模型已经对物体的形态特征有了较好的理解。

下载预训练模型的方法也相对简单。以下是一个使用PyTorch下载预训练ResNet模型的示例代码:

import torchvision.models as models

# 下载预训练的ResNet50模型

model = models.resnet50(pretrained=True)

# 如果需要将模型保存到磁盘

torch.save(model.state_dict(), 'resnet50_pretrained.pth')

4.1.2 模型的微调和适配

预训练模型尽管在原始任务上表现良好,但在新任务中可能需要一定的调整,这就是微调(fine-tuning)。微调的过程包括解冻(unfreezing)模型的某些层,以及在新数据集上继续训练模型。

在微调模型时,通常的做法是保持模型的前期层固定,只对后期层进行训练。这通常是因为前期层捕捉的是通用的特征,如边缘、纹理等,而后期层则捕捉更具体的特征,这些特征与具体任务密切相关。

以下是微调预训练模型的一个代码示例:

# 假设已经加载了预训练的模型,并且已经定义了损失函数和优化器

model = ... # 预训练模型

criterion = ... # 损失函数

optimizer = ... # 优化器

# 冻结模型前期层的参数

for param in model.parameters():

param.requires_grad = False

# 只解冻最后几层

for param in model.layer4.parameters():

param.requires_grad = True

for param in model.fc.parameters():

param.requires_grad = True

# 在新数据集上训练模型

for epoch in range(num_epochs):

# 训练过程...

for inputs, labels in train_loader:

optimizer.zero_grad()

outputs = model(inputs)

loss = criterion(outputs, labels)

loss.backward()

optimizer.step()

# 如果需要保存微调后的模型

torch.save(model.state_dict(), 'resnet50_finetuned.pth')

4.2 模型在不同场景下的应用

在将预训练模型适配到手部姿态识别任务后,接下来需要了解如何在不同场景下评估和应用这些模型。

4.2.1 模型的泛化能力测试

模型的泛化能力是指模型在未见过的数据上的表现。评估模型泛化能力的一种方法是将数据集划分为训练集和测试集,模型在训练集上进行训练,在测试集上进行评估。

以下是一个划分数据集并进行测试的代码示例:

from sklearn.model_selection import train_test_split

# 假设X为特征数据,y为标签

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 在划分好的训练集上训练模型...

# 在测试集上评估模型

model.eval() # 设置模型为评估模式

with torch.no_grad():

predictions = model(X_test)

# 评估性能...

4.2.2 模型在多视角下的表现

手部姿态识别往往需要模型在不同的视角下都能有良好的表现。因此,测试模型在多视角下的表现是十分必要的。一种简单的测试方法是收集多视角的数据,并在这些数据集上进行测试。

以下是一个模拟多视角测试的代码流程:

# 假设我们已经有一个视图变换函数

def transform_view(image):

# 对图像进行变换操作,模拟不同的视角

pass

# 创建多个视图并测试模型

for view in range(num_views):

# 获取新视角的图像

transformed_image = transform_view(original_image)

# 对新视角的图像进行预测

prediction = model(transformed_image)

# 分析预测结果...

在上述章节中,我们详细介绍了预训练深度学习模型的导入与使用,以及如何在不同的场景下应用这些模型。通过选择合适的预训练模型、进行适当的微调、测试模型的泛化能力和多视角表现,我们可以确保模型在实际应用中具有良好的适应性和准确性。这些知识对于从事IT行业以及相关领域的专业人士来说,是理解和实践预训练模型应用的宝贵财富。

5. 模型在OpenCV中的部署

5.1 OpenCV中的模型集成

5.1.1 OpenCV与深度学习框架的对接

OpenCV本身不包含深度学习框架,但其新版本提供了与多种深度学习框架的接口,如TensorFlow、PyTorch等。这些接口允许我们在OpenCV中加载预训练的深度学习模型,从而在项目中利用这些模型的推理能力。

集成模型的第一步是确保你的环境已经安装了OpenCV库,并且可以访问到深度学习框架。以TensorFlow为例,首先需要下载对应的模型文件(如 .pb 文件),然后使用OpenCV的 readNetFromTensorflow 函数来加载模型。

import cv2

# 加载模型

net = cv2.dnn.readNetFromTensorflow(modelFile='model.pb', configFile='model.pbtxt')

# 读取图像

image = cv2.imread('hand的姿态.jpg')

# 预处理图像并进行推理

blob = cv2.dnn.blobFromImage(image, size=(300, 300), mean=(104, 117, 123), swapRB=True)

net.setInput(blob)

out = net.forward()

# 结果处理...

5.1.2 部署流程和性能评估

部署流程从准备环境和工具开始,到最终的模型集成和性能评估结束。首先,你需要准备好运行环境,包括安装OpenCV及其深度学习模块。接着,根据模型的特定需求对输入数据进行预处理。之后,将模型加载到OpenCV中,并通过实际的视频流或者图像数据集进行推理测试。

性能评估是部署流程中至关重要的一环,它可以帮助开发者了解模型在实际应用中的表现。评估主要基于准确性、延迟(latency)、吞吐量(throughput)等指标。在OpenCV中,可以通过计时器来测量模型推理的时间。

import time

# 计时开始

start_time = time.time()

# 执行模型推理

net.forward()

# 计时结束

end_time = time.time()

# 计算推理时间

inference_time = end_time - start_time

print("推理时间: {:.2f} ms".format(inference_time * 1000))

5.2 实时视频流处理与手势识别

5.2.1 实时视频流的捕获与处理

在OpenCV中处理实时视频流涉及到视频捕获设备的接入、帧的读取以及实时处理。使用OpenCV的VideoCapture类可以轻松实现视频流的捕获。同时,为了实时显示处理结果,通常需要使用循环来不断读取帧,并应用模型进行识别。

import cv2

# 打开摄像头

cap = cv2.VideoCapture(0)

while True:

# 逐帧捕获

ret, frame = cap.read()

if not ret:

break

# 应用手势识别模型...

# 显示结果

cv2.imshow('Hand Gesture Recognition', frame)

# 按下'q'键退出循环

if cv2.waitKey(1) & 0xFF == ord('q'):

break

# 清理资源

cap.release()

cv2.destroyAllWindows()

5.2.2 手势识别结果的实时展示

识别结果的实时展示需要在视频帧处理完毕后立即显示。通常情况下,识别结果以边界框、标签或其他图形的形式覆盖在原始帧上。为了使用户能够直观地理解识别结果,可以在图像上添加文本描述或其他视觉提示。

# 假设识别出的手势类别存储在hand_gesture变量中

# 在帧上绘制边界框并添加文字描述

if hand_gesture is not None:

cv2.rectangle(frame, (x, y), (x + w, y + h), (0, 255, 0), 2)

cv2.putText(frame, hand_gesture, (x, y - 5), cv2.FONT_HERSHEY_SIMPLEX, 0.5, (0, 255, 0), 2)

完成上述步骤后,你将能够在视频流中实时显示手部姿态识别的结果。

简介:该项目是一个基于计算机视觉和深度学习的OpenCV应用,目标是在Linux环境下通过OpenCV库实现高精度的手部姿态识别。开发者将通过配置编译环境安装OpenCV库,在Clion IDE中进行开发。项目可能包含训练模型、示例图像和测试数据。实现识别需要准备训练数据集,使用预训练的深度学习模型进行迁移学习或从头训练,并在OpenCV环境中部署模型。识别精度可以通过多种技术进行优化,如数据增强和轻量级模型应用。该项目还涉及实时视频流或单张图像上的关键点检测和手势计算,是全面学习计算机视觉、深度学习和C++编程的好机会。

944

944

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?