#include<stdio.h>

int main(){

// char n[5];

// int i;

// int j;

// for(i=0;i<5;i++){

// scanf("%c",n[i]);

// }

// for(j=0;j<5;j++){

// printf("%c",n[j]);

// }

// n[5]=getchar();

// for(i=0;i<5;i++){

// putchar(n[i]);}

// getchar();

// return 0;

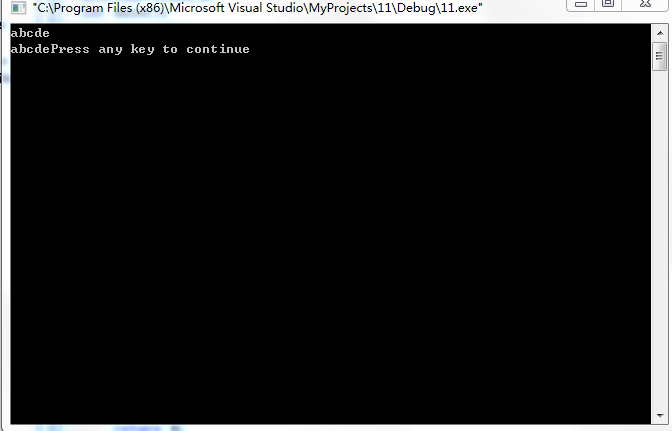

char a,b,c,d,e;

a=getchar();

b=getchar();

c=getchar();

d=getchar();

e=getchar();

putchar(a);

putchar(b);

putchar(c);

putchar(d);

putchar(e);

return 0;

}

2177

2177

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?