项目GitHub地址:https://github.com/heibaiying/BigData-Notes

前 言

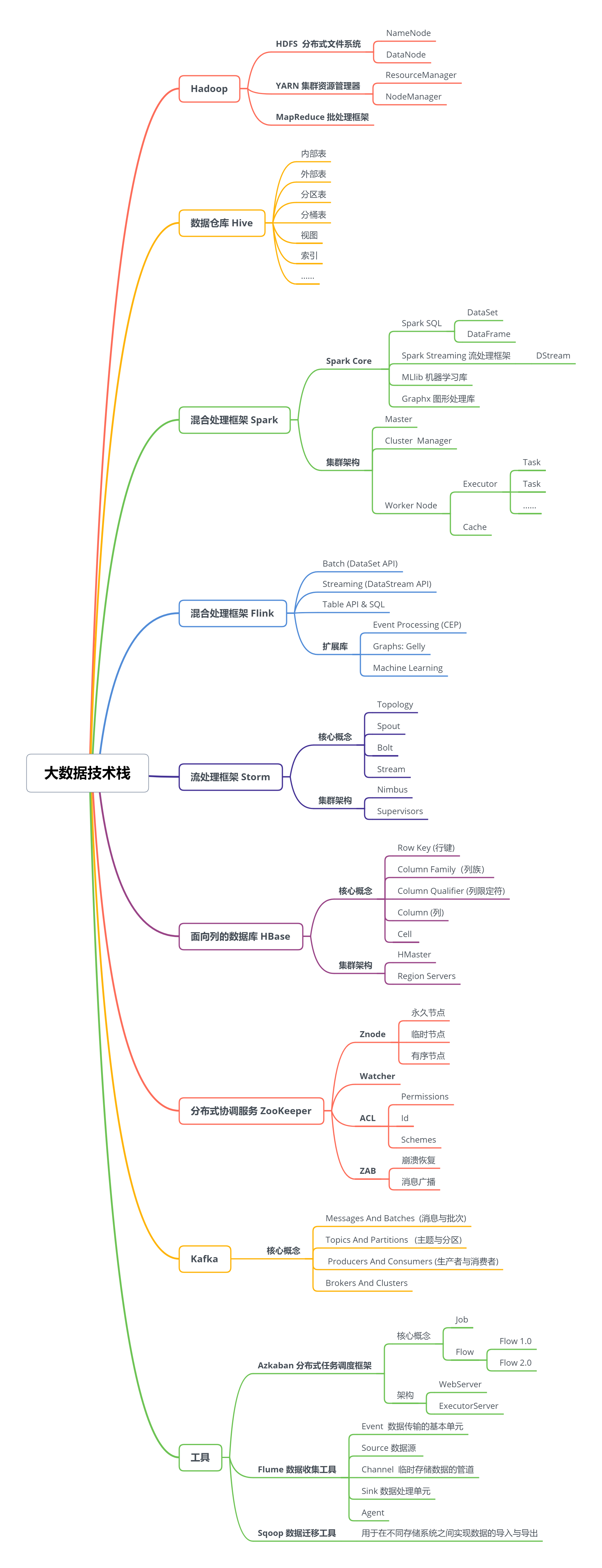

一、Hadoop

- 分布式文件存储系统——HDFS

- 分布式计算框架——MapReduce

- 集群资源管理器——YARN

- Hadoop单机伪集群环境搭建

- Hadoop集群环境搭建

- HDFS常用Shell命令

- HDFS Java API的使用

- 基于Zookeeper搭建Hadoop高可用集群

二、Hive

- Hive简介及核心概念

- Linux环境下Hive的安装部署

- Hive CLI和Beeline命令行的基本使用

- Hive 常用DDL操作

- Hive 分区表和分桶表

- Hive 视图和索引

- Hive常用DML操作

- Hive 数据查询详解

三、Spark

Spark Core :

Spark SQL :

Spark Streaming :

四、Storm

- Storm和流处理简介

- Storm核心概念详解

- Storm单机环境搭建

- Storm集群环境搭建

- Storm编程模型详解

- Storm项目三种打包方式对比分析

- Storm集成Redis详解

- Storm集成HDFS/HBase

- Storm集成Kafka

五、Flink

TODO

六、HBase

- Hbase 简介

- HBase系统架构及数据结构

- HBase基本环境搭建(Standalone /pseudo-distributed mode)

- HBase集群环境搭建

- HBase常用Shell命令

- HBase Java API

- Hbase 过滤器详解

- HBase 协处理器详解

- HBase 容灾与备份

- HBase的SQL中间层——Phoenix

- Spring/Spring Boot 整合 Mybatis + Phoenix

七、Kafka

八、Zookeeper

- Zookeeper 简介及核心概念

- Zookeeper单机环境和集群环境搭建

- Zookeeper常用Shell命令

- Zookeeper Java 客户端——Apache Curator

- Zookeeper ACL权限控制

九、Flume

十、Sqoop

十一、Azkaban

十二、Scala

- Scala简介及开发环境配置

- 基本数据类型和运算符

- 流程控制语句

- 数组——Array

- 集合类型综述

- 常用集合类型之——List & Set

- 常用集合类型之——Map & Tuple

- 类和对象

- 继承和特质

- 函数 & 闭包 & 柯里化

- 模式匹配

- 类型参数

- 隐式转换和隐式参数

十三、公共内容

后 记

转载于:https://blog.51cto.com/14183932/2410709

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?