二分分类

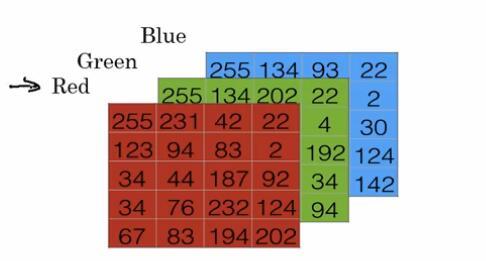

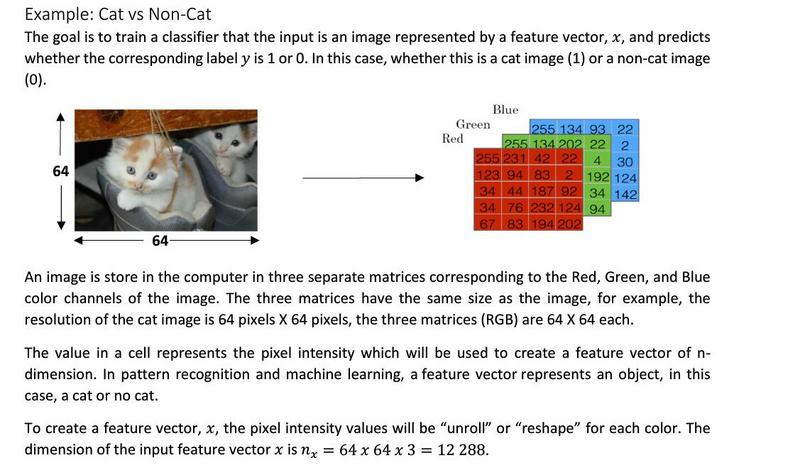

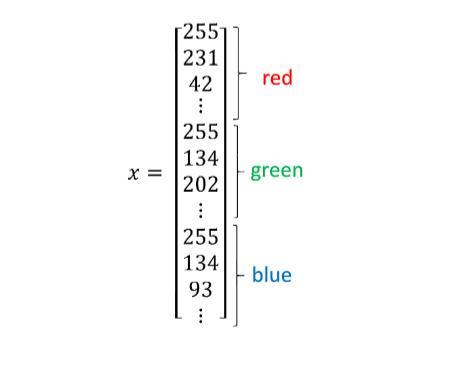

计算机要保存一张图片,实际需要保存三个矩阵。分别对应的是红绿蓝三个颜色通道。

在二分分类问题中,目标是训练出一个分类器。它以图片中的特征向量x作为输入,预测输出结果标签y是1(是一个猫)还是0(不是一个猫)

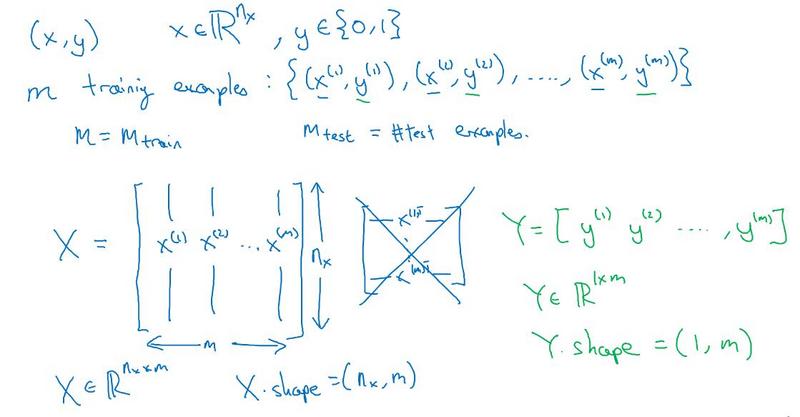

最后,为了方便表示,我们将x和y都写成矩阵形式,在python中

x.shape()这样的命令就是用来看矩阵的行数和列数。

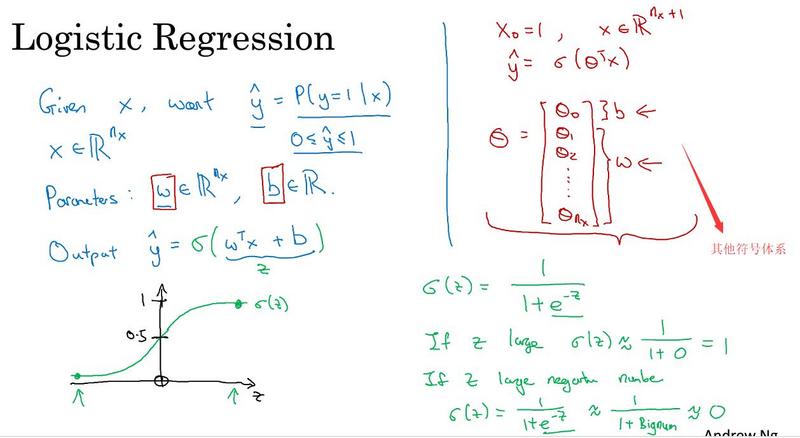

logistic回归

这是一个学习算法,在监督学习中处理二分问题。

如图所示

对于一个Logistic回归而言,通常学习的就是一个

$$ y = w^Tx+b $$

的过程,实际上,对于一维而言。我们可以理解成是y=ax+b的过程。然而这个数算出来可能很大,也可能很小。而我们希望算出来的是一个介于0到1之间的概率,因此我们要用sigma函数处理一下$\sigma$

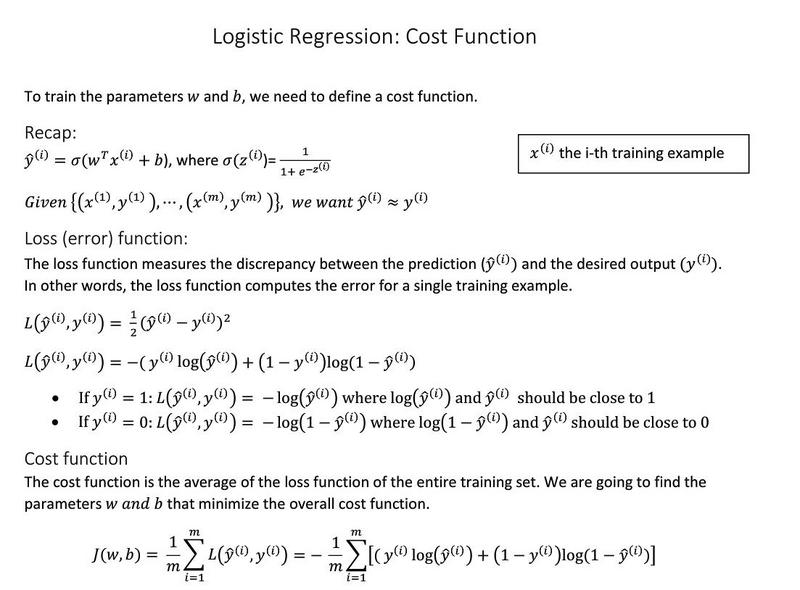

logistic回归损失函数

为了训练logistic函数的w和b需要定义一个成本函数。下面讲解一下利用logistic来训练成本函数。

最后,Loss function是在单个训练样本中定义的,它衡量了在单个训练样本上的表现。下面定义的成本函数(Cost function),是在总体样本中的表现。

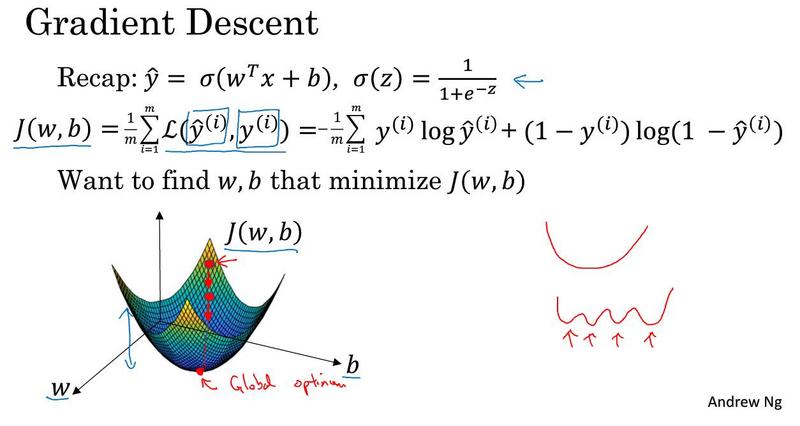

梯度下降法

这里介绍一下用梯度下降法来训练w和b

成本函数衡量了w和b在训练集上的效果,要学习得到合适的w和b,自然的就会想到成本函数J尽量小,由此来确定w和b。

我们使用梯度下降的方法,来期望得到全局最优解。这张三维图可以直观的帮助我们理解梯度下降法,我们假设w和b都是一维的。这里的J(w,b)实际上表示的就是这个像碗一样图形的高度。我们用梯度下降法来找到这个碗底,实际上就是找到这个全局最优解。

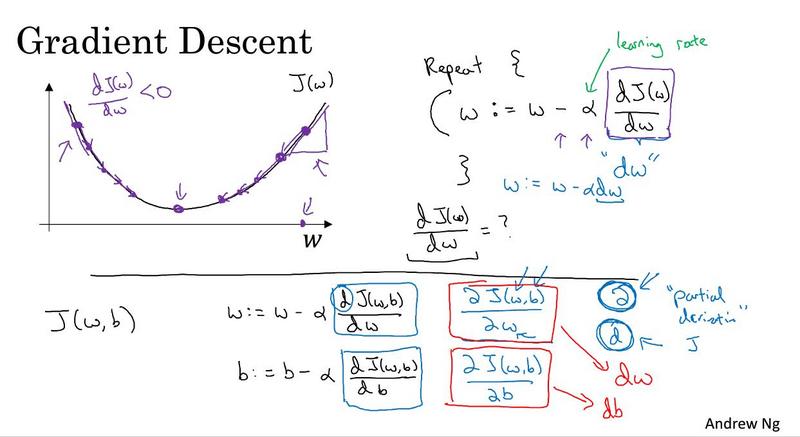

我们进一步直观的来理解梯度下降法

如图所示,我们忽略了b,只是从J和w的角度来考虑,实际上梯度下降的过程就是不断迭代

$$ w=w-\alpha\frac{dJ(w)}{dw} $$

b也是同样的道理,如果我们从三个变量角度出发,所不同的是求的是偏导数而不是导数而已。

2088

2088

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?