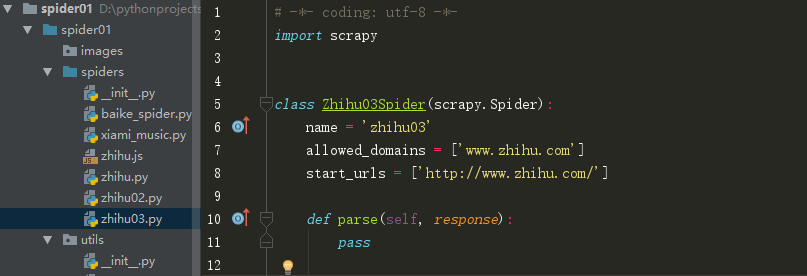

1.scrapy创建爬虫,cd进入爬虫的项目文件夹,输入:scrapy genspider zhihu03 www.zhihu.com

打开pycharm发现新增一个zhihu03.py

2.爬取网页时,当我们爬取(table)中的内容时,用xpath解析不到表格中td的值

原因:浏览器会在table标签下添加tbody(注:在chrome、火狐测试都有这个情况。出现这种原因是因为浏览器会对html文本进行一定的规范化 )

解决方法:解决方法:使用scrapy 时将分析出的xpath 中的 tbody 去掉即可。

参考自:https://blog.youkuaiyun.com/lishk314/article/details/44916827

3.scrapy模拟登录知乎时,输入验证码后出现“缺少验证码票据”,在settings.py将cookie设置为如下:

COOKIES_ENABLED = True

9291

9291

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?