一、Logstash简介

1、官网地址

https://www.elastic.co/products/logstash

2、软件介绍

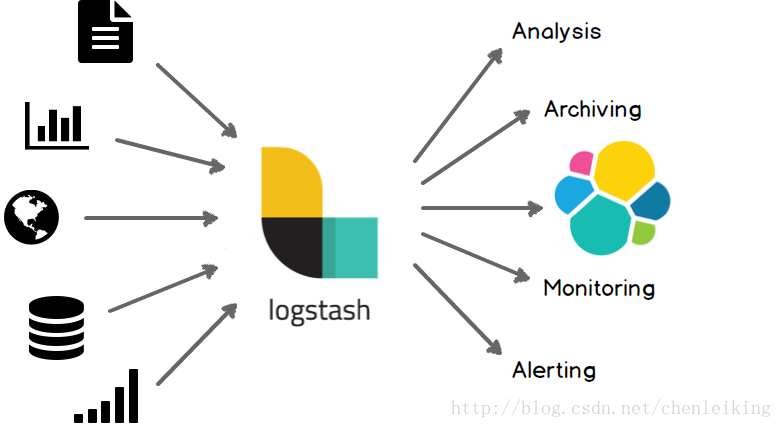

官方介绍:Logstash is an open source data collection engine with real-time pipelining capabilities。简单来说logstash就是一根具备实时数据传输能力的管道,负责将数据信息从管道的输入端传输到管道的输出端;与此同时这根管道还可以让你根据自己的需求在中间加上滤网,Logstash提供里很多功能强大的滤网以满足你的各种应用场景。

Logstash常用于日志关系系统中做日志采集的设备;

3、系统结构

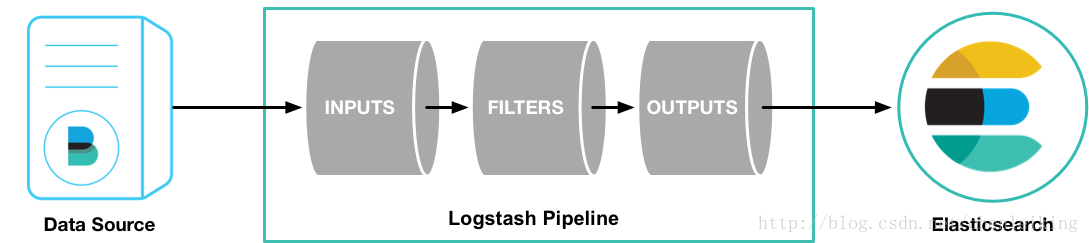

Logstash的事件(logstash将数据流中等每一条数据称之为一个event)处理流水线有三个主要角色完成:inputs –> filters –> outputs:

- inpust:必须,负责产生事件(Inputs generate events),常用:File、syslog、redis、beats(如:Filebeats)

- filters:可选,负责数据处理与转换(filters modify them),常用:grok、mutate、drop、clone、geoip

-

outpus:必须,负责数据输出(outputs ship them elsewhere),常用:elasticsearch、file、graphite、statsd

其中inputs和outputs支持codecs(coder&decoder)在1.3.0 版之前,logstash 只支持纯文本形式输入,然后以过滤器处理它。但现在,我们可以在输入 期处理不同类型的数据,所以完整的数据流程应该是:input | decode | filter | encode | output;codec 的引入,使得 logstash 可以更好更方便的与其他有自定义数据格式的运维产品共存,比如:graphite、fluent、netflow、collectd,以及使用 msgpack、json、edn 等通用数据格式的其他产品等

4、应用场景

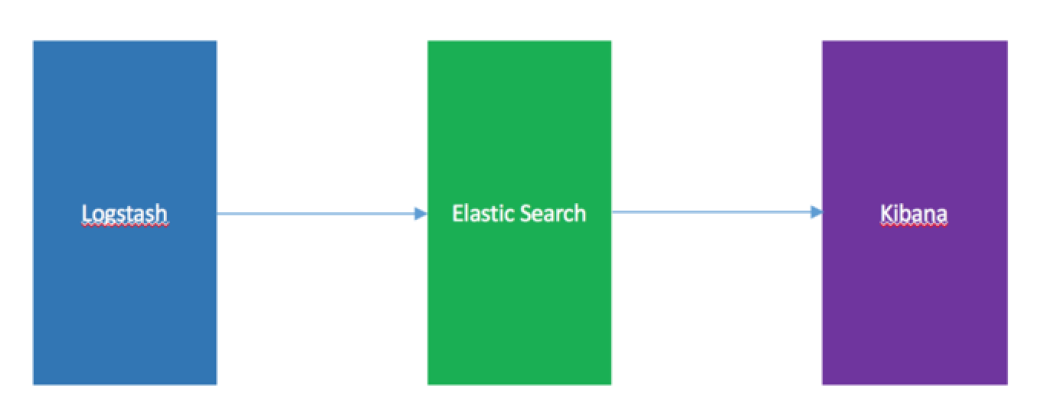

Logstash最常用于ELK(elasticsearch + logstash + kibane)中作为日志收集器使用

这三个并非该管理系统的全部组

成,而且还可以添加Redis,kafka,filebeat等软件

它们各自的功能大概可以这样概述:

- E:实时分析、实时检索、海量存储,建立索引,以便日后快速查看、搜索、分析

- L:数据流传输、日志结构化

- K:分析统计、酷炫图表

传统的日志架构存在的以下若干缺点:

- 开发人员无权登录,经过运维周转费时费力

- 日志数据分散在多个系统,难以查找

- 日志数据量大,查询速度慢

- 一个调用会涉及多个系统,难以在这些系统的日志中快速定位数据

- 数据不够实时

- 应用

Logstash是一款开源数据收集引擎,具备实时数据传输能力。本文介绍了Logstash的基本概念、系统结构及应用场景,尤其强调其在ELK(Elasticsearch+Logstash+Kibana)中的作用。

Logstash是一款开源数据收集引擎,具备实时数据传输能力。本文介绍了Logstash的基本概念、系统结构及应用场景,尤其强调其在ELK(Elasticsearch+Logstash+Kibana)中的作用。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?